RWKV: Reinventing RNNs for the Transformer Era

Bo Peng, Eric Alcaide, Quentin Anthony, Alon Albalak, Samuel Arcadinho, Huanqi Cao, Xin Cheng, Michael Chung, Matteo Grella, Kranthi Kiran GV, Xuzheng He, Haowen Hou, Przemyslaw Kazienko, Jan Kocon, Jiaming Kong, Bartlomiej Koptyra, Hayden Lau, Krishna Sri Ipsit Mantri, Ferdinand Mom, Atsushi Saito, Xiangru Tang, Bolun Wang, Johan S. Wind, Stansilaw Wozniak, Ruichong Zhang, Zhenyuan Zhang, Qihang Zhao, Peng Zhou, Jian Zhu, Rui-Jie Zhu

提出了一种新的模型架构RWKV,通过结合Transformer和RNN的优势,在处理序列数据时实现了高效的计算和模型性能。

-

动机:解决Transformer模型在序列长度上的记忆和计算复杂度问题,以及RNN模型在性能上的限制,通过提出一种新的模型架构,实现在训练和推理时的高效性能。

-

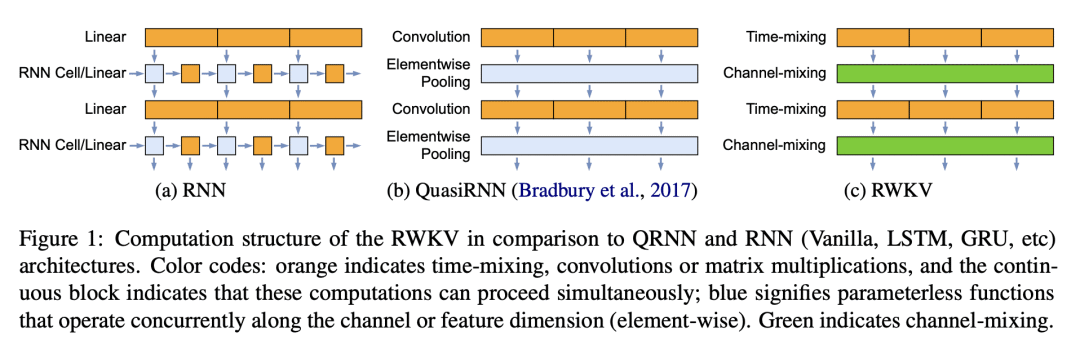

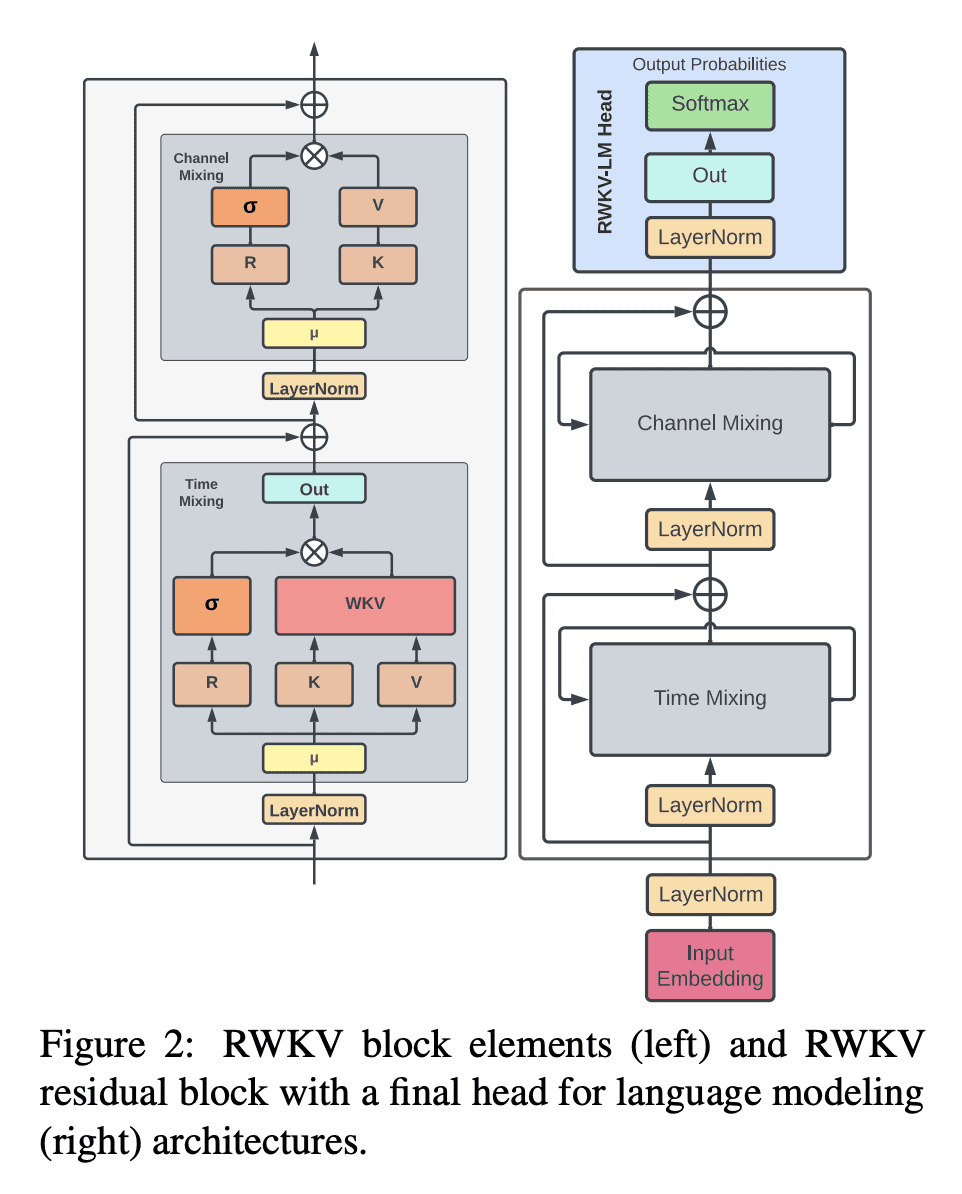

方法:提出一种名为Receptance Weighted Key Value(RWKV)的模型架构,通过结合Transformer的并行训练和RNN的高效推理,利用线性注意力机制实现了模型的并行计算和常数级的计算和记忆复杂度。

-

优势:提出一种创新的模型架构RWKV,在处理序列数据时兼具计算效率和模型性能,并能够扩展到数百亿参数的规模。实验结果表明,RWKV与同等规模的Transformer模型性能相当,为未来创建更高效模型提供了可能性。

https://arxiv.org/abs/2305.13048

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢