Getting ViT in Shape: Scaling Laws for Compute-Optimal Model Design

通过优化神经网络的形状,实现了在相同计算量下,规模较小的视觉Transformer模型能与规模较大的模型具有竞争力的性能。

I Alabdulmohsin, X Zhai, A Kolesnikov, L Beyer

[Google DeepMind]

塑造ViT:计算优化模型设计缩放率

要点:

-

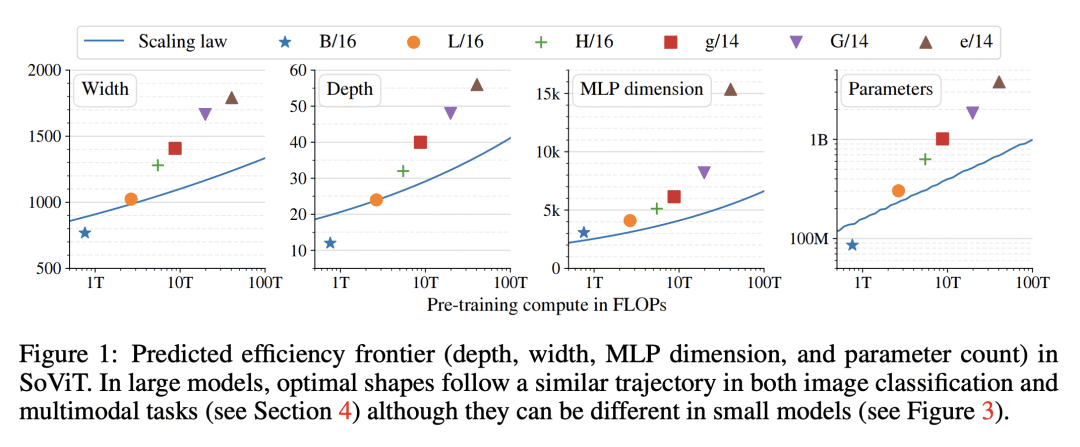

动机:推进并改进使用缩放定律来推导计算时长下最优模型大小的方法,进一步推断出计算时长下最优模型形状(如宽度和深度),并成功应用于视觉Transformer。 -

方法:使用一种新方法来优化神经网络形状,包括深度和宽度,并通过同时优化多个形状维度来改进之前的方法,同时需要更少的实验。 -

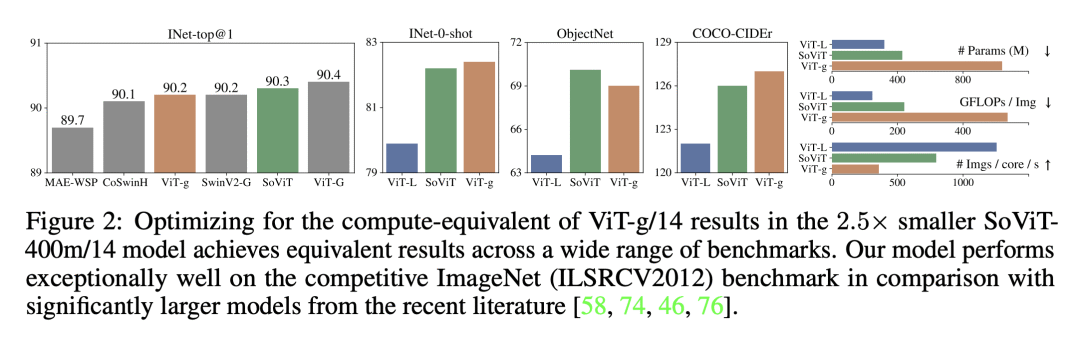

优势:通过优化模型形状,使得规模较小的模型在相同计算量下能与规模较大的模型媲美甚至超越其性能,同时具有更低的推理成本。

https://arxiv.org/abs/2305.13035

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢