Prompt-based methods may underestimate large language models' linguistic generalizations

Jennifer Hu, Roger Levy

[MIT]

基于提示的方法可能会低估大语言模型的语言泛化能力

要点:

-

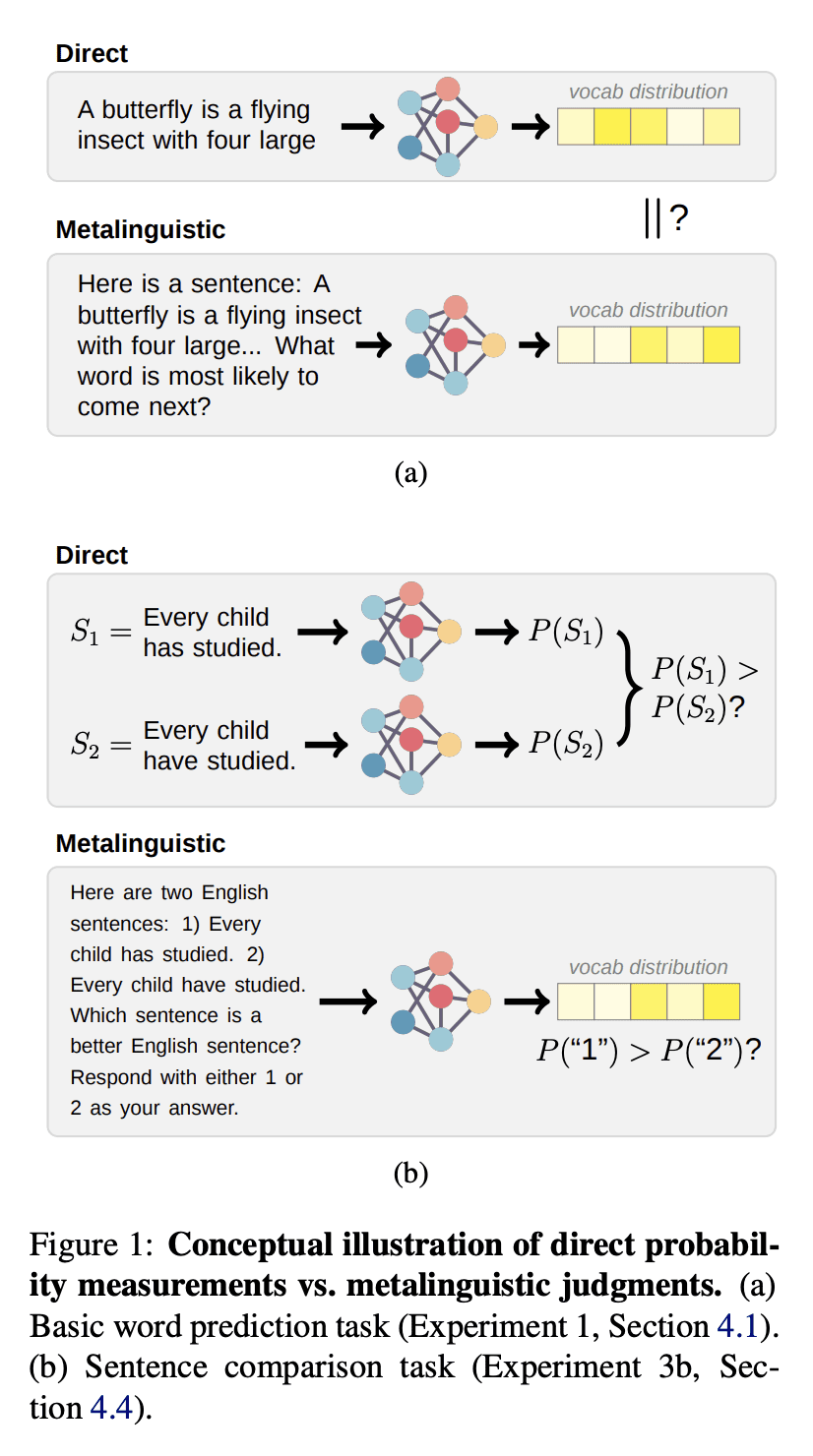

动机:比较使用metalinguistic prompting和直接概率测量两种方法来评估大型语言模型(LLM)对英语的语言知识,以探索它们的优劣和一致性。 -

方法:用metalinguistic prompting和直接概率测量两种方法来衡量LLM对英语的语言知识,比较它们的效果和一致性。 -

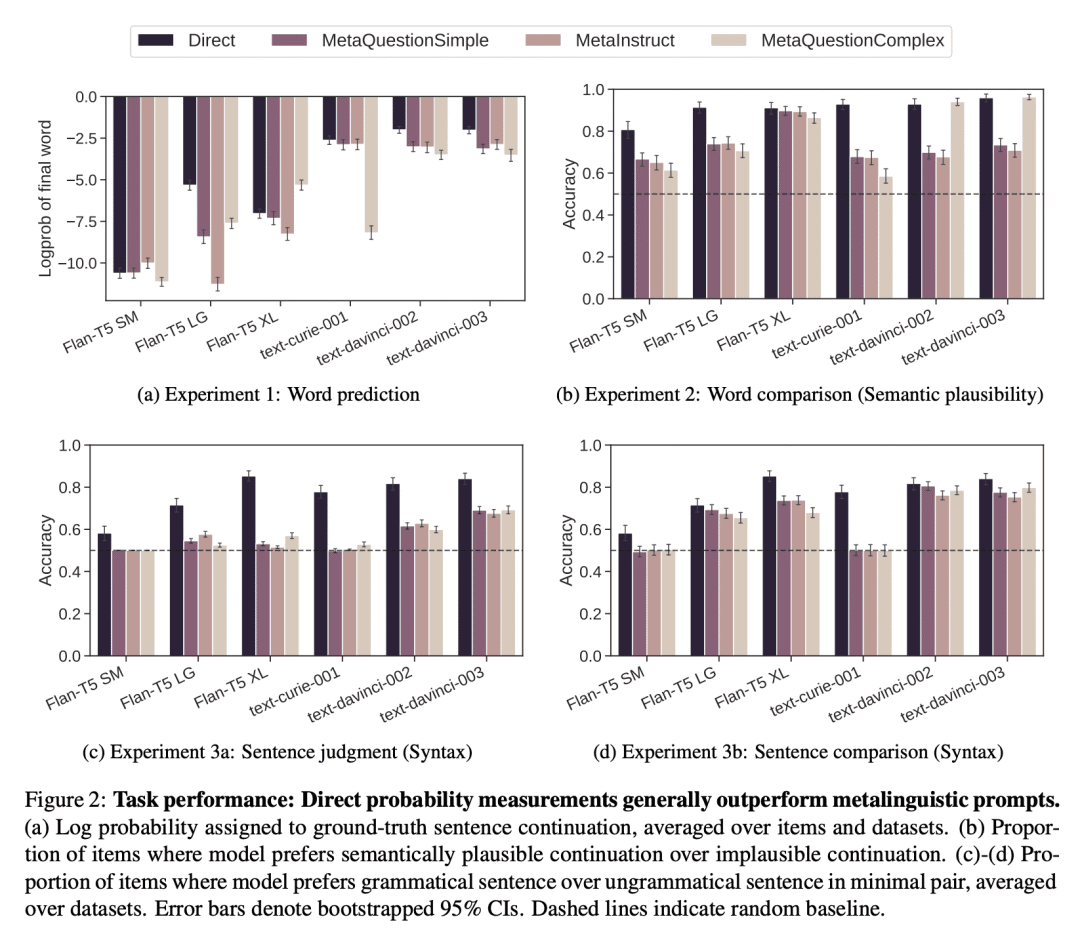

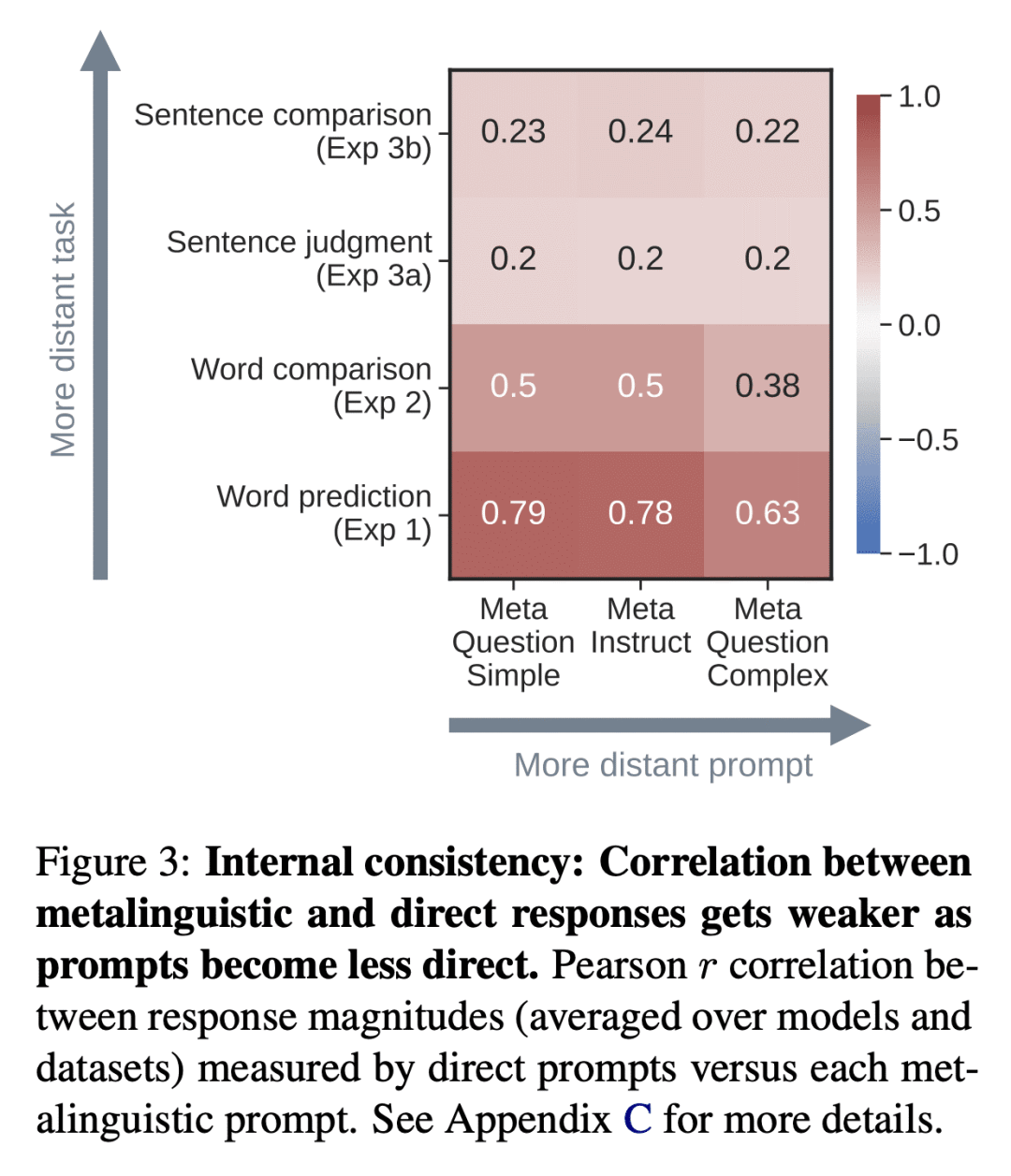

优势:结果发现,直接概率测量通常比metalinguistic prompting获得更好或类似的任务性能,而且随着prompt与直接概率测量的差异增大,一致性变差。这些发现表明,依赖metalinguistic prompting的负面结果不能作为LLM缺乏特定语言能力的确凿证据。研究结果还强调了封闭API的移动导致访问概率分布受限制,造成了信息丧失。

通过比较metalinguistic prompting和直接概率测量两种方法,研究了衡量大型语言模型对英语语言知识的效果和一致性,发现直接概率测量通常更优,而metalinguistic prompting的负面结果不能作为LLM缺乏特定语言能力的证据。

https://arxiv.org/abs/2305.13264

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢