Sophia: A Scalable Stochastic Second-order Optimizer for Language Model Pre-training

Hong Liu, Zhiyuan Li, David Hall, Percy Liang, Tengyu Ma

[Stanford University]

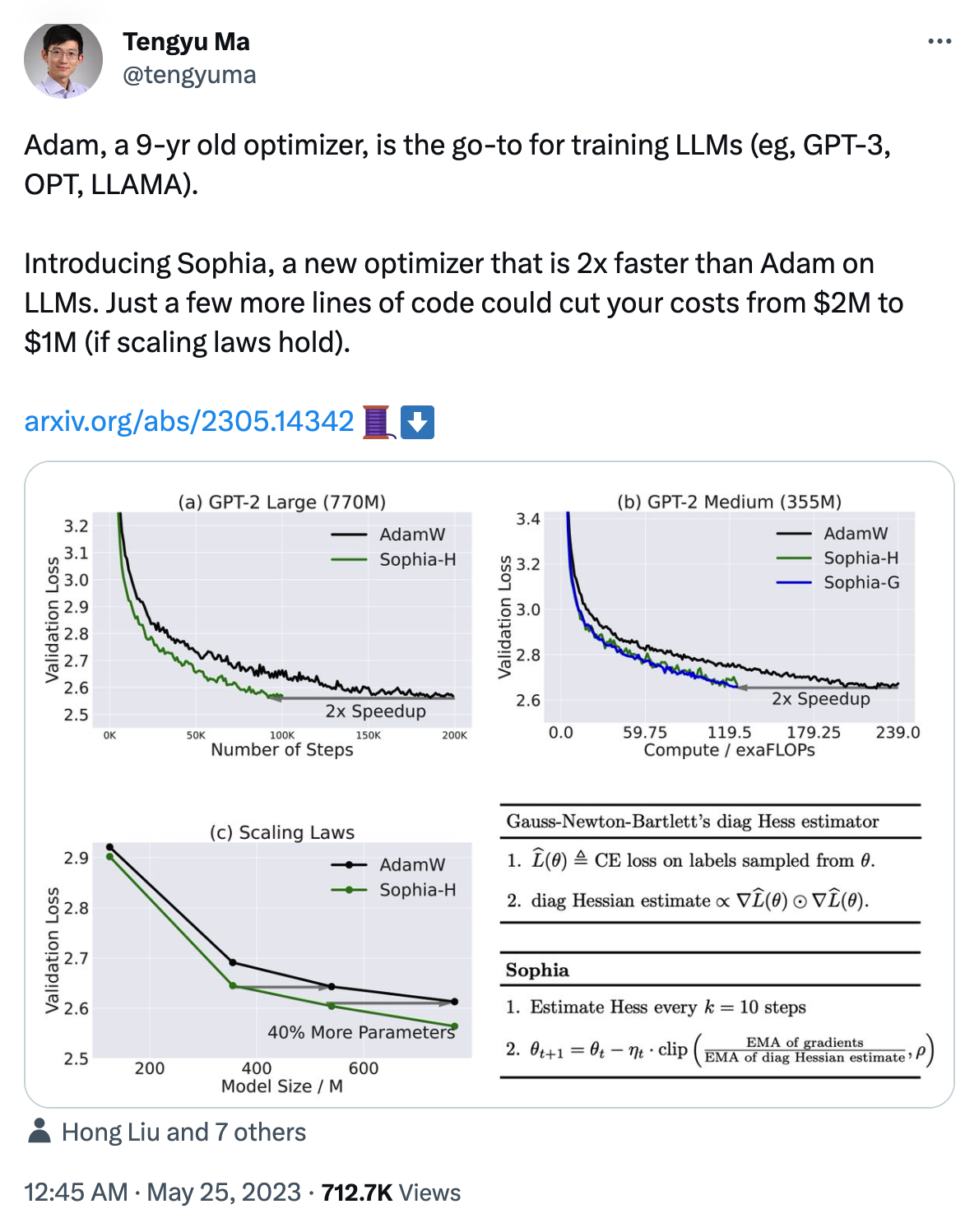

Sophia: 面向语言模型高效预训练的可扩展随机二阶优化器。Sophia是一种轻量的二阶优化器,可用于语言模型预训练,通过估计对角Hessian矩阵和剪切机制实现了更快(2倍)的训练速度。

Sophia优化器,仅仅多几行代码就可以把你的成本从200万美元减少到100万美元,还可实现2倍加速。

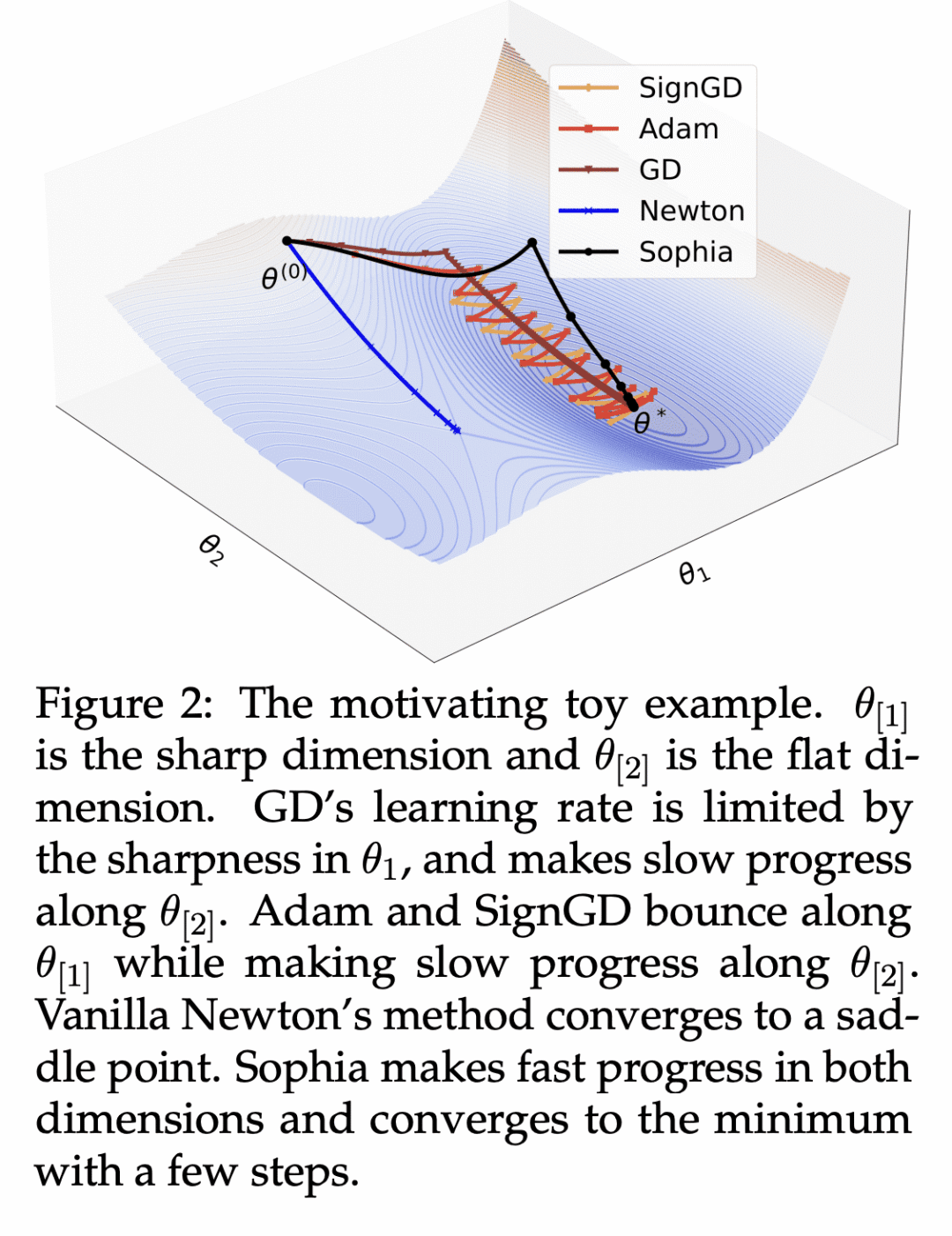

为减少语言模型预训练的时间和成本。本文提出一种名为Sophia的可扩展二阶优化器,使用轻量对角Hessian估计作为预条件器,并通过剪切机制控制最坏情况下的更新大小。

与Adam相比,在GPT-2等语言模型的预训练中,Sophia在步数、总计算量和挂钟(wall-clock)时间方面实现了2倍的加速。

论文地址:https://arxiv.org/abs/2305.14342

相关资讯:https://twitter.com/tengyuma/status/1661412995430219786

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢