Small Language Models Improve Giants by Rewriting Their Outputs

G Vernikos, A Bražinskas, J Adamek, J Mallinson, A Severyn, E Malmi

[Google Research & EPFL]

用小型语言模型重写输出来改进大型语言模型性能

-

动机:解决大型语言模型在复杂任务上表现不佳、参数过多、API限制访问以及对于提示工程的依赖等问题,提出一种不依赖于模型权重的方法来纠正大型语言模型的输出。

-

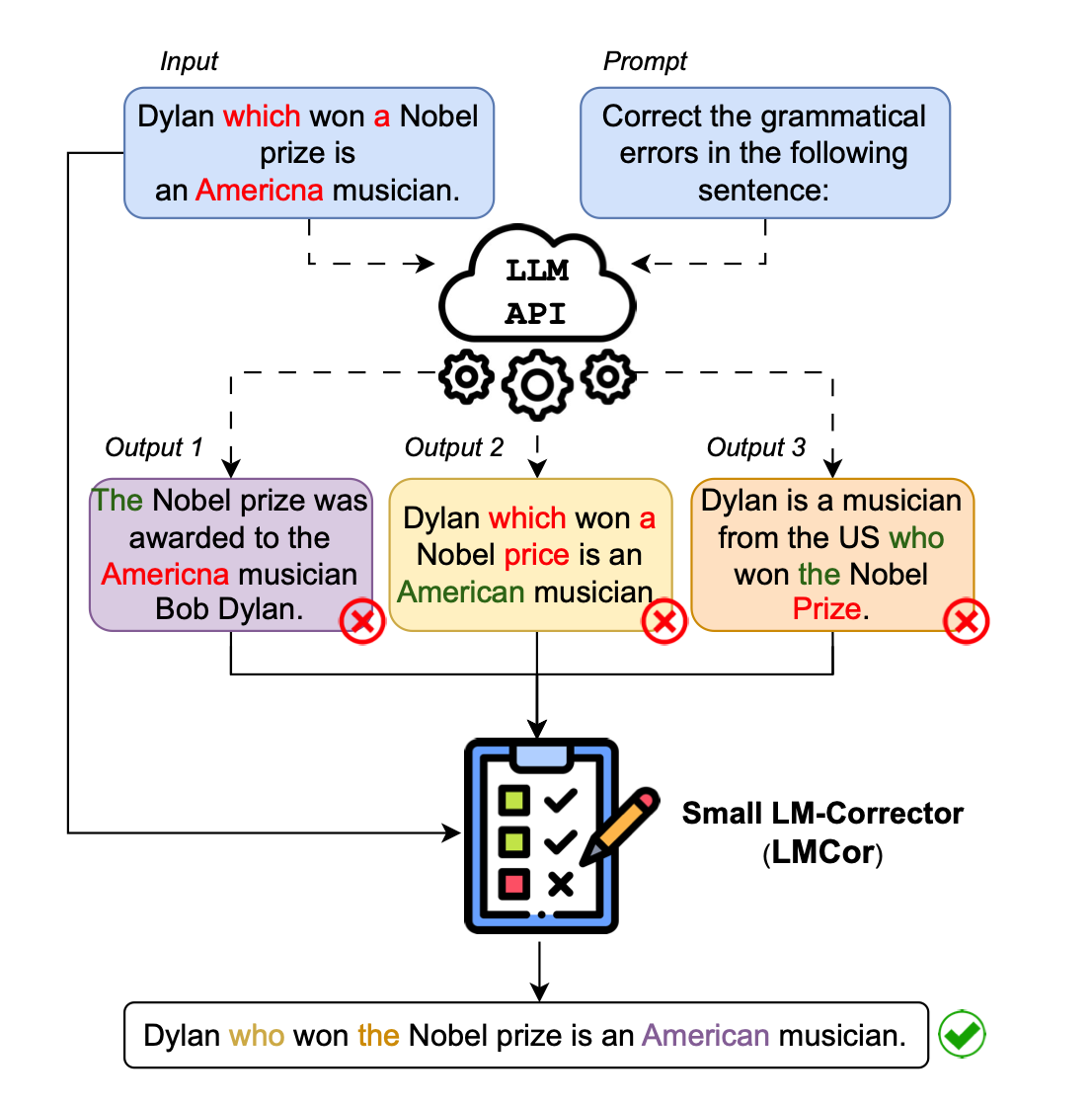

方法:通过少量训练参数的LM-corrector模型来改进大型语言模型的输出。首先,通过少量示例对大型语言模型进行few-shot提示,生成候选输出。然后,使用LM-corrector模型对候选输出进行重排、组合和重写,得到最终的目标输出。

-

优势:LM-corrector模型能显著改进大型语言模型在各种任务上的few-shot性能,且无需访问模型权重,通过API调用直接操作预测结果。LM-corrector还能够适应不同的提示,减少对提示工程的需求。此外,LM-corrector可以无缝集成到不同规模或架构的语言模型中,作为即插即用的模块来提高它们的性能。

通过LM-corrector模型纠正大型语言模型的输出,改善few-shot性能,减少对于模型权重和提示工程的依赖,提供了一种实用且资源高效的方式来提升语言模型性能。

https://arxiv.org/abs/2305.13514

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢