Transformer最近几年已然成为大模型的标配,而Meta团队开发的一款Megabyte模型声称能解决Transformer的硬伤,速度还要快四成。

自2017年在论文「Attention is All You Need」中提出之后,这个新的网络结构,刷爆了各大翻译任务,同时创造了多项新的记录。但Transformer在处理长字节序列时有个硬伤,就是算力损耗严重,而Meta的研究人员的最新成果则可以很好地解决这一缺陷。

他们推出了一种全新的模型架构,能跨多种格式生成超过100万个token,并超越GPT-4等模型背后的现有 Transformer架构的功能。

这个模型被称为「兆字节」(Megabyte),是一种多尺度解码器架构(Multi-scale Decoder Architecture),可以对超过一百万字节的序列进行端到端可微分建模。

论文链接:https://arxiv.org/abs/2305.07185

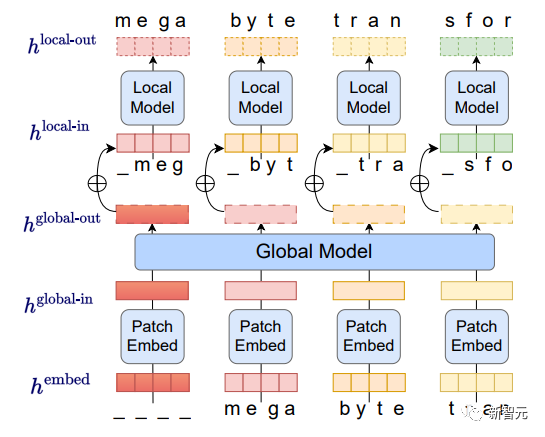

相比Transformer,Megabyte模型展示了一种独特的不同架构,将输入和输出序列划分为patch而不是单个token。如下图,在每个patch中,本地AI模型生成结果,而全局模型管理和协调所有patch的最终输出。

首先,字节序列被分割成固定大小的patch,大致类似于token,这个模型由三部分组成:

(1) patch嵌入器:通过无损地连接每个字节的嵌入来简单地编码patch

(2) 一个全局模型:一个输入和输出patch表示的大型自回归变换器

(3) 一个本地模型:一个预测patch中字节的小型自回归模型

研究人员观察到,对于多数任务而言字节预测都相对容易(如完成给定前几个字符的单词),这意味着每个字节的大型网络是不必要的,并且可以使用更小的模型进行内部预测。

这种方法解决了当今AI模型中普遍存在的可扩展性挑战,Megabyte 模型的patch系统允许单个前馈网络在包含多个token的patch上运行,从而有效解决了自注意力缩放问题。

其中,Megabyte架构对长序列建模的Transformer进行了三项主要改进:

- 二次自注意力(Sub-quadratic self-attention)

大多数关于长序列模型的工作都集中在减轻自注意力的二次成本上,而Megabyte将长序列分解为两个较短的序列,即使对于长序列也仍然易于处理。

- patch前馈层(Per-patch feedforward layers)

在GPT-3大小的模型中,超过98%的FLOPS用于计算位置前馈层,Megabyte每个patch使用大型前馈层,以相同的成本实现更大、性能更强的模型。在patch大小为P的情况下,基线转换器将使用具有m个参数的相同前馈层P次,兆字节可以以相同的成本使用具有mP个参数的层一次。

- 解码中的并行性(Parallelism in Decoding)

Transformers必须在生成期间串行执行所有计算,因为每个时间步的输入是前一个时间步的输出,通过并行生成patch的表示,Megabyte允许在生成过程中实现更大的并行性。

例如,具有1.5B参数的Megabyte模型生成序列的速度比标准的350MTransformer快40%,同时在使用相同的计算量进行训练时还能改善困惑度。

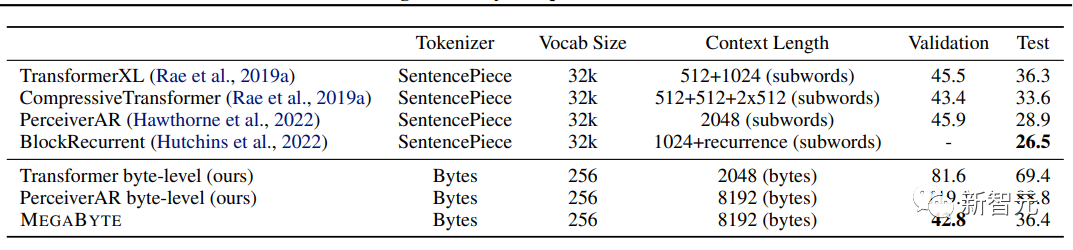

Megabyte远远优于其他模型,并提供与在子词上训练的 sota 模型竞争的结果。相比之下,OpenAI 的GPT-4有32,000个token的限制,而Anthropic的Claude有100,000个token的限制。

此外,在运算效率方面,在固定模型大小和序列长度范围内,Megabyte比同等大小的Transformers和Linear Transformers使用更少的token,允许以相同的计算成本使用更大的模型。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢