BiomedGPT: A Unified and Generalist Biomedical Generative Pre-trained Transformer for Vision, Language, and Multimodal Tasks

Kai Zhang, Jun Yu, Zhiling Yan, Yixin Liu, Eashan Adhikarla, Sunyang Fu, Xun Chen, Chen Chen, Yuyin Zhou, Xiang Li, Lifang He, Brian D. Davison, Quanzheng Li, Yong Chen, Hongfang Liu, Lichao Sun

[Lehigh University]

BiomedGPT: 统一通用的生物医学生成式预训练Transformer,适用于视觉、语言和多模态任务

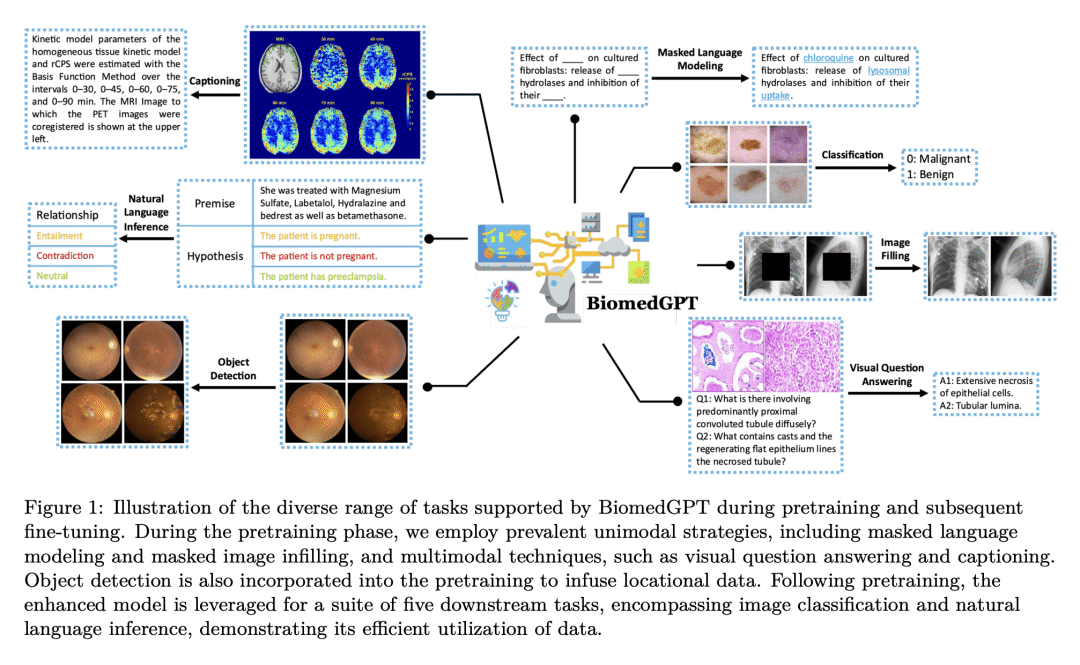

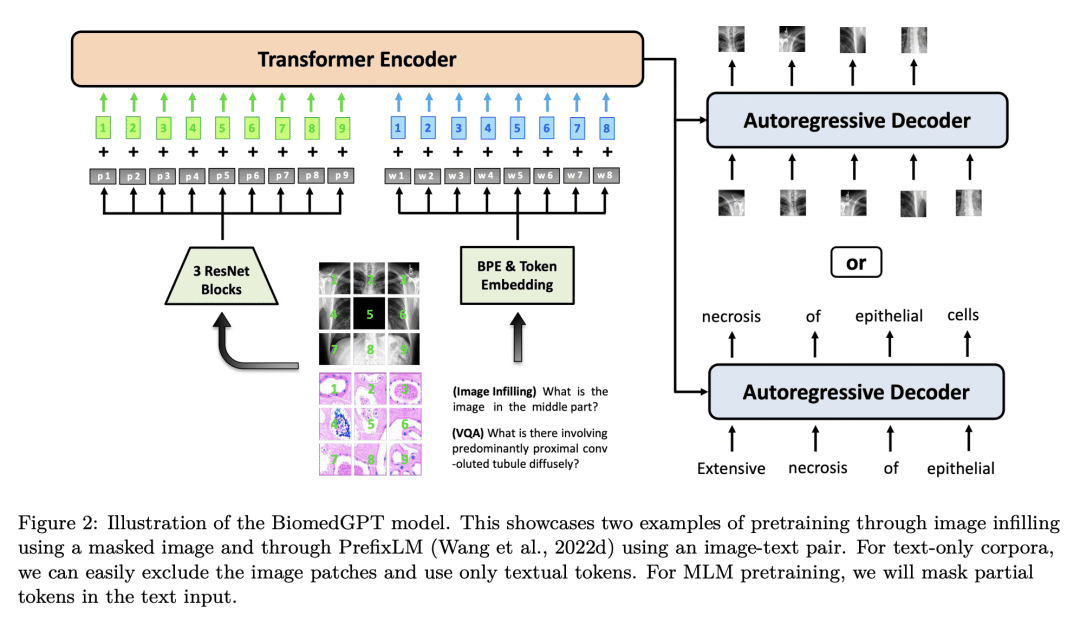

动机:引入一个统一和通用的生物医学生成式预训练Transformer模型(BiomedGPT),利用大规模和多样化的数据集进行自监督学习,接受多模态输入并执行一系列下游任务。

方法:使用自监督学习和多模态、多任务预训练方法来构建BiomedGPT模型,该模型可以处理生物医学数据的不同模态和多个任务。

优势:BiomedGPT模型在广泛的生物医学任务中表现出色,超越了之前大多数最先进的模型。该模型具有丰富和具有包容性的生物医学数据表示,对医疗保健结果的改善具有深远影响。

BiomedGPT是一个统一和通用的生物医学生成式预训练Transformer模型,通过自监督学习和多模态、多任务预训练方法,实现了对生物医学数据的全面表示和多任务处理的突破。

https://arxiv.org/abs/2305.17100

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢