记忆视角的Transformer机制分析

Alberto Bietti, Vivien Cabannes, Diane Bouchacourt, Herve Jegou, Leon Bottou

[Meta AI]

-

动机:旨在更好地理解基于Transformer的大型语言模型的内部机制,以提高它们的可靠性和可解释性。 -

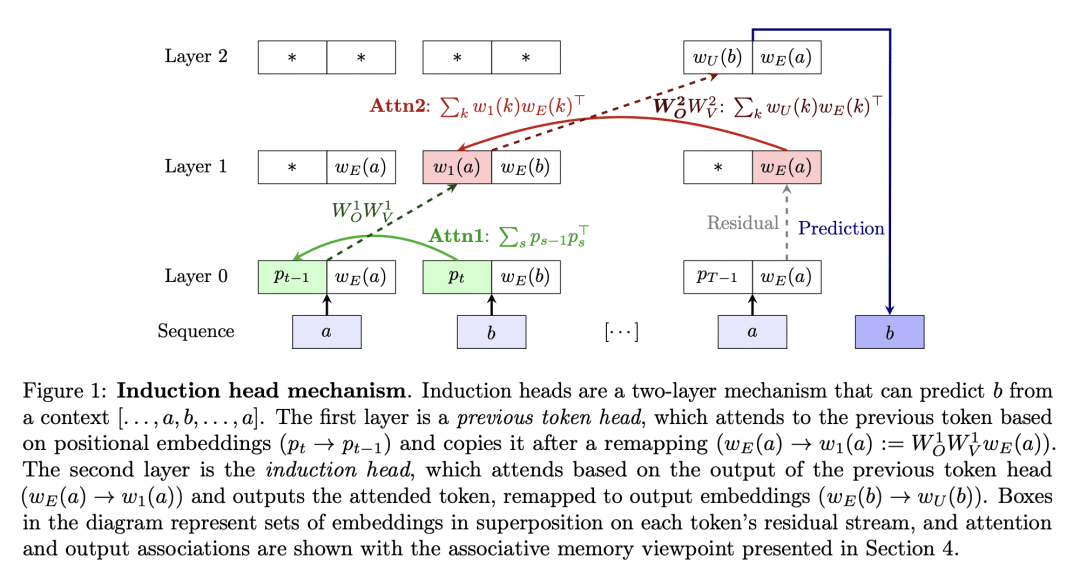

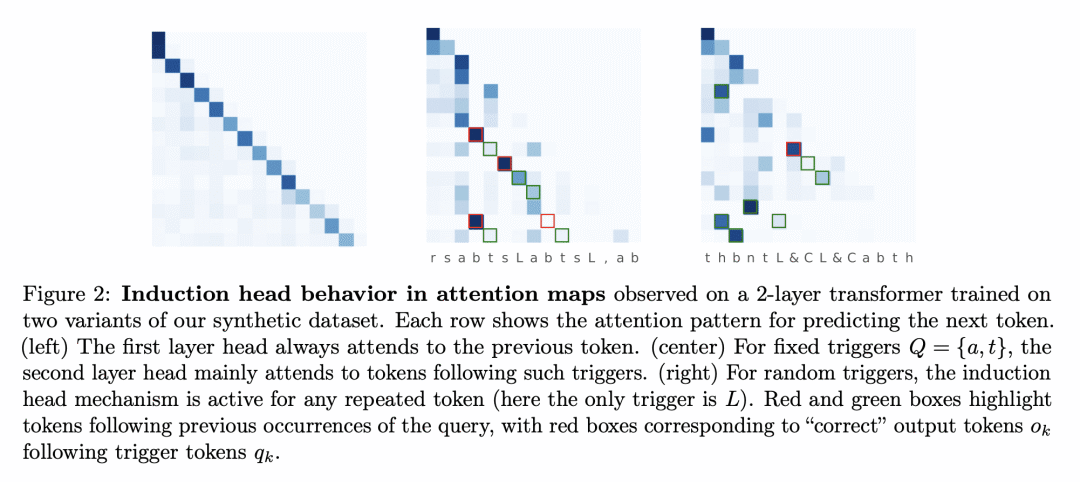

方法:通过在合成环境中使用大规模和上下文特定的二元分布生成Token序列,对简化的双层Transformer进行仔细的实证分析,研究其全局和上下文学习的过程。将Transformer的权重矩阵视为联想记忆,并提供理论洞察来解释其学习动力学。 -

优势:通过细致的实证分析和理论洞察,揭示了Transformer在全局和上下文学习方面的动态平衡,以及权重矩阵作为联想记忆的作用。为进一步理解和优化Transformer模型提供了重要的基础。

通过研究合成环境下Transformer的学习机制,揭示了其全局和上下文学习的平衡,并将权重矩阵解释为联想记忆,为理解和优化Transformer提供了基础。

https://arxiv.org/abs/2306.00802

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢