ReWOO:Decoupling Reasoning from Observations for Efficient Augmented Language Models

Binfeng Xu, Zhiyuan Peng, Bowen Lei, Subhabrata Mukherjee, Yuchen Liu, Dongkuan Xu

论文:https://arxiv.org/abs/2305.18323

Github:https://github.com/billxbf/ReWOO

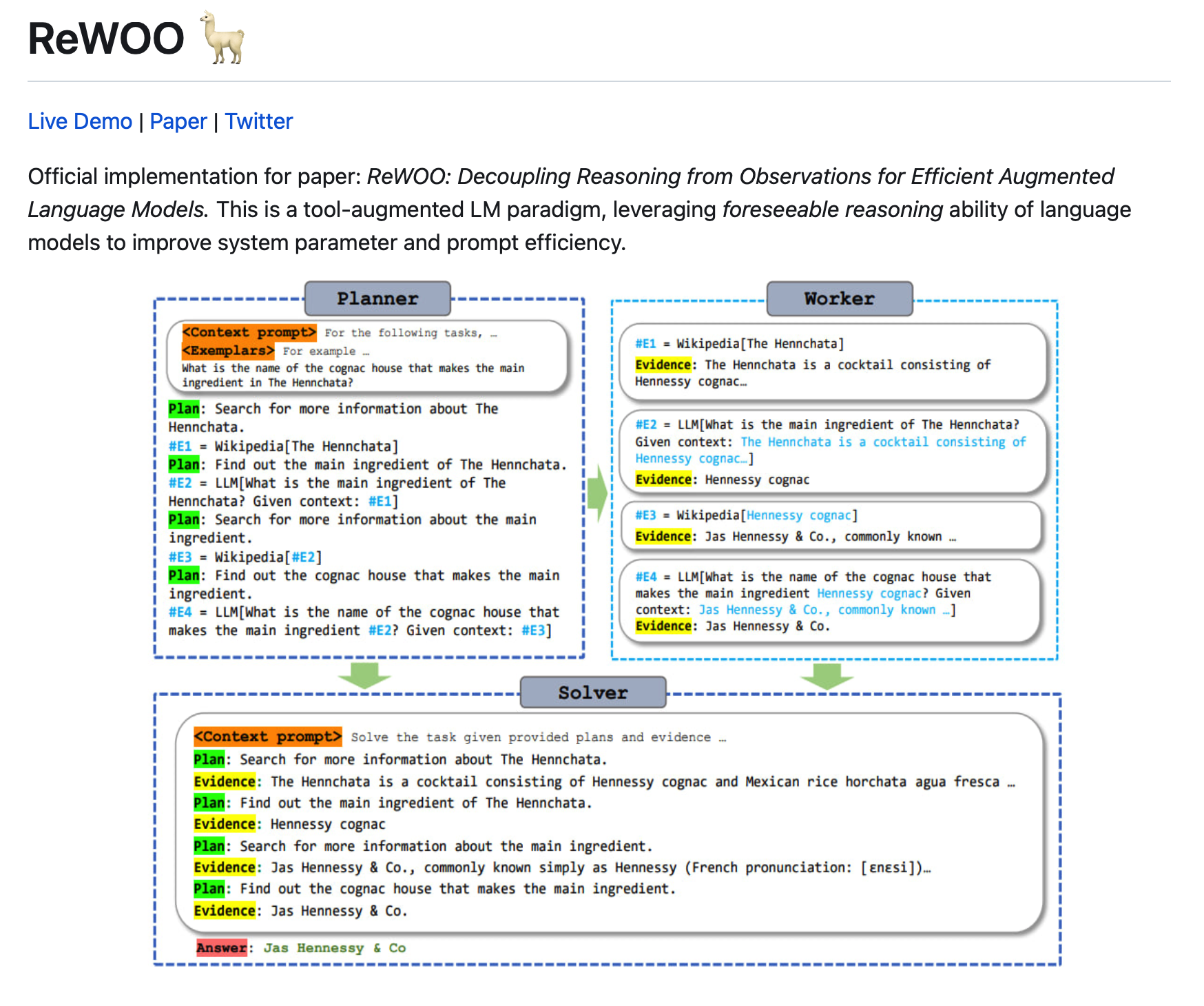

增强语言模型(ALM)将大型语言模型(LLM)的推理能力与允许知识检索和操作执行的工具相结合。现有的ALM系统触发了LLM思维过程,同时以交错的方式从这些工具中提取观察结果。具体来说,LLM的理由是调用外部工具,停止获取工具的响应,然后根据之前的所有响应令牌决定下一个操作。

这种范式虽然简单易用,但往往会因为冗余的提示和重复执行而导致巨大的计算复杂性。这项研究首次解决了这些挑战,提出了一个模块化范式ReWOO(Reasoning WithOut Observation),该范式将推理过程与外部观察分离,从而显著减少了令牌消耗。对六个公共NLP基准和精选数据集的全面评估揭示了我们提议的方法一致的性能增强。值得注意的是,ReWOO在多步推理基准HotpotQA上实现了5倍的令牌效率和4%的准确性改进。

此外,ReWOO在工具故障场景下展示了稳健性。除了快速效率外,将参数模块与非参数工具调用解耦,可以进行指令微调,将LLM卸载到较小的语言模型中,从而大大减少模型参数。

我们的说明性工作将推理能力从175B GPT3.5卸载到7B LLaMA,展示了真正高效和可扩展的ALM系统的巨大潜力。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢