TART: A plug-and-play Transformer module for task-agnostic reasoning

Kush Bhatia, Avanika Narayan, Christopher De Sa, Christopher Ré

[Stanford University & Cornell University]

TART:面向任务无关推理的即插即用式Transformer模块

要点:

-

动机:研究在上下文学习中,大型语言模型(LLM)在进行简单概率推理任务时的能力不足,导致性能低于特定任务的微调方法。研究旨在探索LLM是否能以任务无关的方式学习推理能力。 -

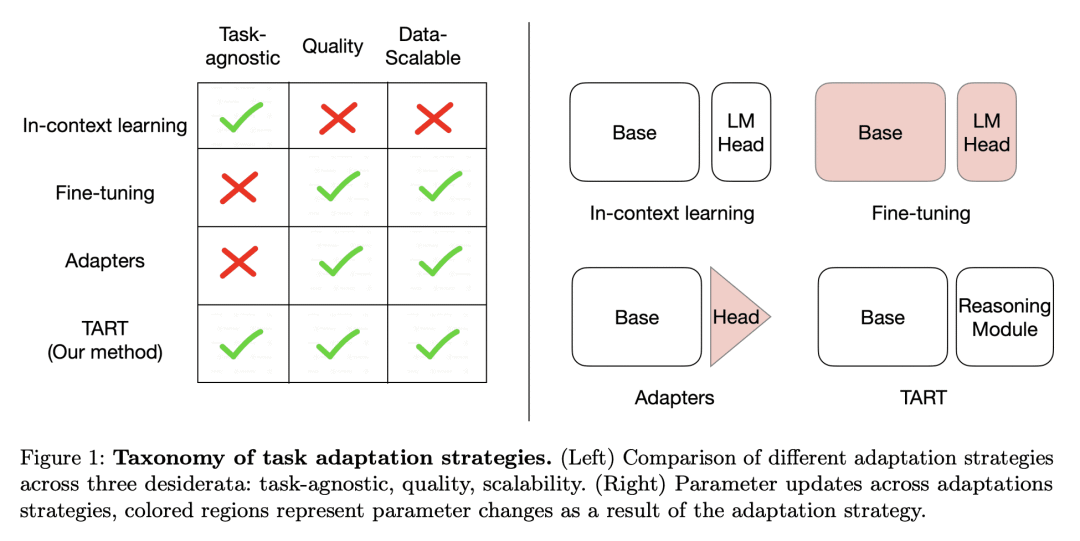

方法:引入一种名为Tart的任务无关方法,通过使用合成训练的基于Transformer的推理模块,来提升LLM的推理能力。Tart在只使用合成的逻辑回归任务对推理模块进行任务无关训练,并将其与任意预训练模型组合,无需额外训练。 优势:揭示了LLM在推理任务上的性能差距主要是由于其无法执行简单概率推理任务;引入了Tart方法,可以在不同的模型家族、模型规模、任务和多模态场景下提高LLMs的性能。

研究了大型语言模型在推理任务上的能力不足,引入一种任务无关方法Tart来提升推理能力,实验结果表明Tart在不同领域和任务上都取得了显著改进。

https://arxiv.org/abs/2306.07536

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢