Symbolic Chain-of-Thought Distillation: Small Models Can Also "Think" Step-by-Step

Liunian Harold Li, Jack Hessel, Youngjae Yu, Xiang Ren, Kai-Wei Chang, Yejin Choi

[University of California, Los Angeles & Allen Institute for Artificial Intelligence]

符号化思维链蒸馏:小模型也能一步一步“思考”

-

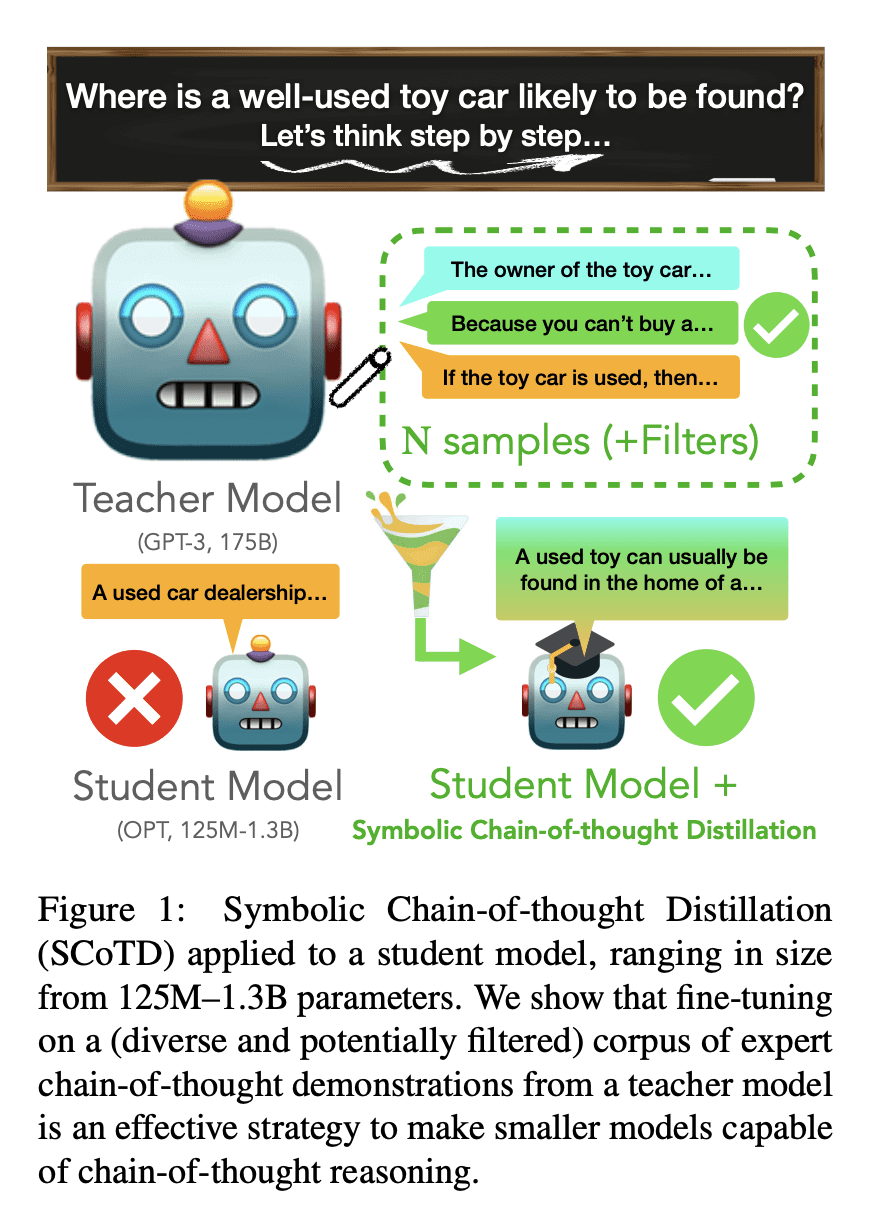

动机:当前的大型语言模型(LLM)在预测过程中可以通过“思维链”(CoT)提示来提高其表现,但这种方法只对足够大的模型(超过50B参数)有效。本文的目标是研究是否可以通过大型语言模型教导小型语言模型进行链式思考。

-

方法:提出一种名为“符号链式思考蒸馏”(SCoTD)的方法,首先从大型语言模型中采样出链式思考理由,然后训练小型语言模型来预测采样的理由和标签。这个过程遵循“符号知识蒸馏”的范式。

-

优势:通过SCoTD,小型语言模型学会了自我理解,并在3个常识QA任务上的表现显著优于没有理解的学习。这个结果在监督和少数样本设置中都得到了验证,并且在各种规模的学生模型(125M-1.3B参数)中都得到了体现。

提出一种新方法,通过从大型语言模型中采样出思维链理由,训练小型语言模型进行链式思考,从而显著提高了小型语言模型在常识QA任务上的表现。

https://arxiv.org/abs/2306.14050

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢