一个新的数据集可以帮助科学家开发自动系统,为在线图表生成更丰富、更具描述性的字幕。

解释复杂趋势和模式的图表标题对于提高读者理解和保留所呈现数据的能力非常重要。对于视力障碍者来说,标题中的信息通常提供了他们理解图表的唯一手段。但编写有效、详细的标题是一个劳动密集型的过程。虽然自动字幕技术可以减轻这种负担,但它们通常很难描述提供额外背景的认知特征。

为了帮助人们编写高质量的图表字幕,麻省理工学院的研究人员开发了一个数据集来改进自动字幕系统。使用此工具,研究人员可以教授机器学习模型,以根据用户的需求改变图表标题中包含的复杂程度和内容类型。

麻省理工学院的研究人员发现,经过自动字幕训练的机器学习模型及其数据集始终生成精确、语义丰富的字幕,并描述了数据趋势和复杂模式。定量和定性分析显示,他们的模型比其他自动字幕系统更有效地为图表添加字幕。

该团队的目标是提供名为VisText的数据集,作为研究人员在研究图表自动字幕的棘手问题时可以使用的工具。联合首席作者Angie Boggust说,这些自动系统可以帮助为无字幕的在线图表提供字幕,并改善视力障碍者的可访问性,他是麻省理工学院电气工程和计算机科学的研究生,也是计算机科学和人工智能实验室(CSAIL)可视化小组的成员。

她说:“我们试图将许多人类价值观嵌入到我们的数据集中,这样当我们和其他研究人员构建自动图表字幕系统时,我们最终不会得到不是人们想要或需要的模型。”

Boggust与联合首席作者兼研究生Benny J一起出现在论文中。Tang和高级作家Arvind Satyanarayan,麻省理工学院计算机科学副教授,领导CSAIL的可视化小组。该研究将在计算语言学协会的年会上发表。

以人为本的分析

研究人员受到启发,从可视化小组之前的工作中开发VisText,该小组探索了什么是好的图表标题。在这项研究中,研究人员发现,视力用户和盲人或弱视用户对标题中语义内容的复杂性有不同的偏好。

该小组希望将这种以人为本的分析纳入自动字幕研究。为此,他们开发了VisText,这是一个图表和相关字幕的数据集,可用于训练机器学习模型,以生成准确、语义丰富、可定制的字幕。

开发有效的自动字幕系统并非易事。现有的机器学习方法通常试图以图像的方式为图表添加标题,但人和模型对自然图像的解释与我们阅读图表的方式不同。其他技术完全跳过视觉内容,并使用其基础数据表为图表添加标题。然而,在图表发布后,此类数据表通常不可用。

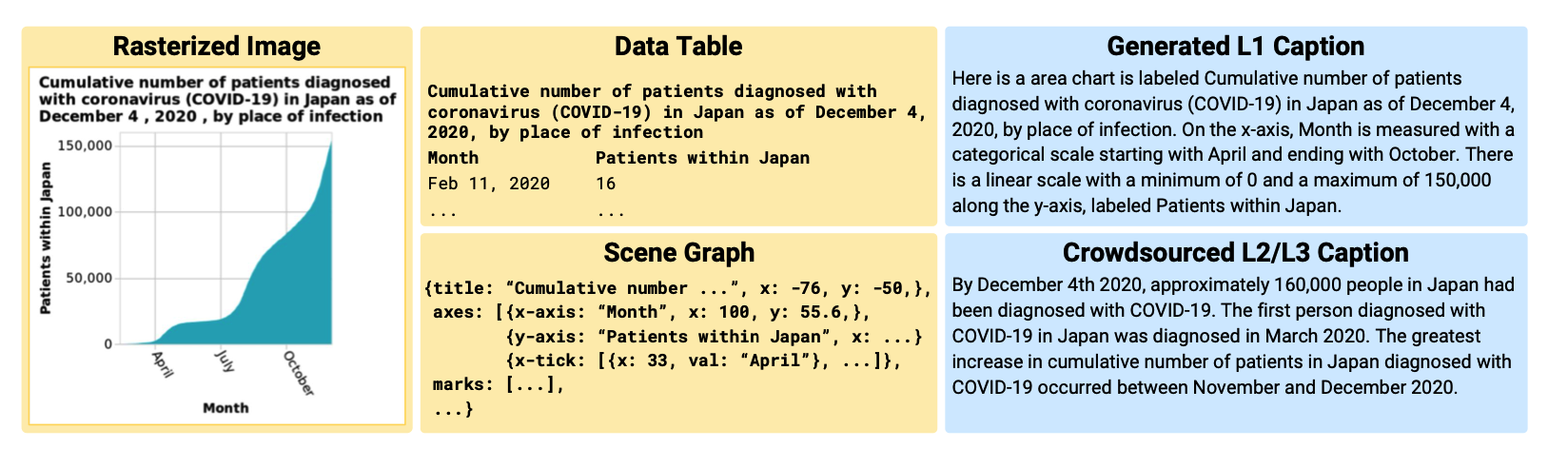

鉴于使用图像和数据表的不足,VisText还将图表表示为场景图。场景图可以从图表图像中提取,包含所有图表数据,但也包括额外的图像上下文。

“场景图就像两全其美——它几乎包含图像中存在的所有信息,同时比数据表更容易从图像中提取。由于它也是文本,我们可以利用现代大型语言模型的进步来添加字幕,”Tang解释道。

他们汇编了一个包含12,000多个图表的数据集——每个图表都表示为数据表、图像和场景图——以及相关的标题。每个图表都有两个单独的标题:一个描述图表结构的低级标题(如其轴范围),一个描述统计数据、数据关系和复杂趋势的更高级别的标题。

研究人员使用自动化系统生成低级字幕,并从人类工人那里众包高级字幕。

“我们的标题参考了之前研究的两项关键部分:关于视觉媒体可访问描述的现有指南和我们小组用于分类语义内容的概念模型。这确保了我们的字幕具有重要的低级图表元素,如轴、刻度和单元,为有视觉障碍的读者提供,同时在如何编写字幕方面保持了人为的可变性,”Tang说。

翻译图表

一旦他们收集了图表图像和标题,研究人员就使用VisText训练了五个自动字幕的机器学习模型。他们想看看每个表示方式——图像、数据表和场景图——以及表示的组合如何影响字幕的质量。

“你可以考虑一个图表字幕模型,就像语言翻译模型一样。但是,我们不是说把这本德语文本翻译成英语,而是说把这本“图表语言”翻译成英语,”Boggust说。

他们的结果表明,使用场景图训练的模型比使用数据表训练的模型表现一样好或更好。由于场景图更容易从现有图表中提取,研究人员认为它们可能是一个更有用的表示。

他们还分别训练了低级和高级字幕的模型。这种技术被称为语义前缀调整,使他们能够教模型改变字幕内容的复杂性。

此外,他们对表现最佳的方法产生的字幕进行了定性检查,并对六种常见错误进行了分类。例如,如果模型说趋势在实际增加时正在减少,就会发生方向错误。

这种细粒度、稳健的定性评估对于了解模型是如何出错的很重要。例如,使用定量方法,方向错误可能会产生与重复错误相同的惩罚,其中模型重复相同的单词或短语。但方向错误对用户来说可能比重复错误更具有误导性。Boggust说,定性分析帮助他们理解了这些类型的微妙之处。

她补充说,这类错误还暴露了当前模型的局限性,并提出了研究人员在开发自动字幕系统时必须考虑的道德考虑因素。

生成机器学习模型,例如那些为ChatGPT提供动力的模型,已被证明会产生幻觉或提供可能具有误导性的错误信息。虽然使用这些模型自动为现有图表添加标题有明显好处,但如果图表标题不正确,可能会导致错误信息的传播。

“也许这意味着我们不只是用人工智能为眼前的一切添加字幕。相反,也许我们提供这些自动字幕系统作为作者工具供人们编辑。在整个研究过程中考虑这些道德影响很重要,而不仅仅是在我们有模型要部署的最终,”她说。

Boggust、Tang和他们的同事希望继续优化模型,以减少一些常见的错误。他们还希望扩展VisText数据集,以包括更多图表和更复杂的图表,例如那些具有堆叠条形或多条的图表。他们还希望深入了解这些自动字幕模型实际上正在学习的关于图表数据的内容。

这项研究得到了谷歌研究学者奖、国家科学基金会、MLA@CSAIL倡议和美国空军研究实验室的部分支持。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢