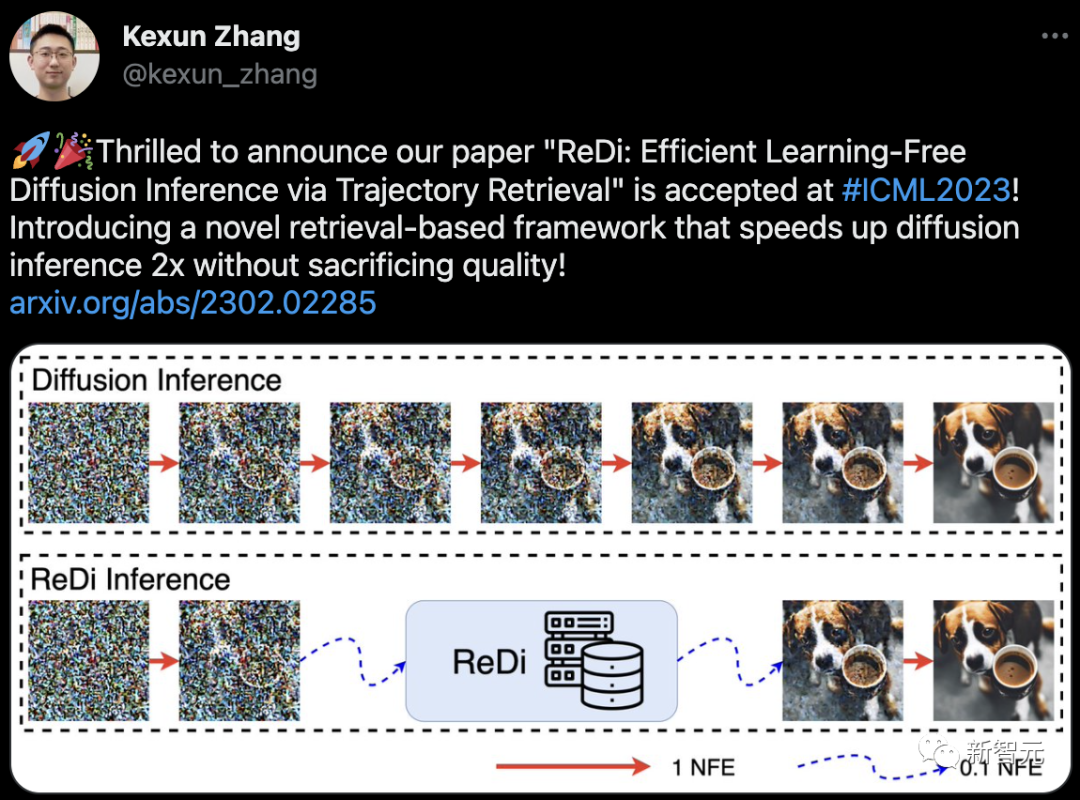

加州大学圣巴巴拉分校(UCSB)计算机系的Kexun Zhangt提出的扩散采样框架ReDi的论文被ICML接收。

论文的共同作者还有UCSB助理教授李磊。2021年,曾是字节跳动人工智能实验室总监的李磊,选择离职重返学术界时,引起了不小的反响。

这篇论文就当前扩散模型推理速度慢的问题提出了新的框架。尽管扩散模型生成质量高,但需要大量采样迭代,导致模型推理耗时。最新提出的ReDi是一个基于检索的扩散采样框架,能够将模型推理速度提升2倍。

论文地址:https://arxiv.org/abs/2302.02285

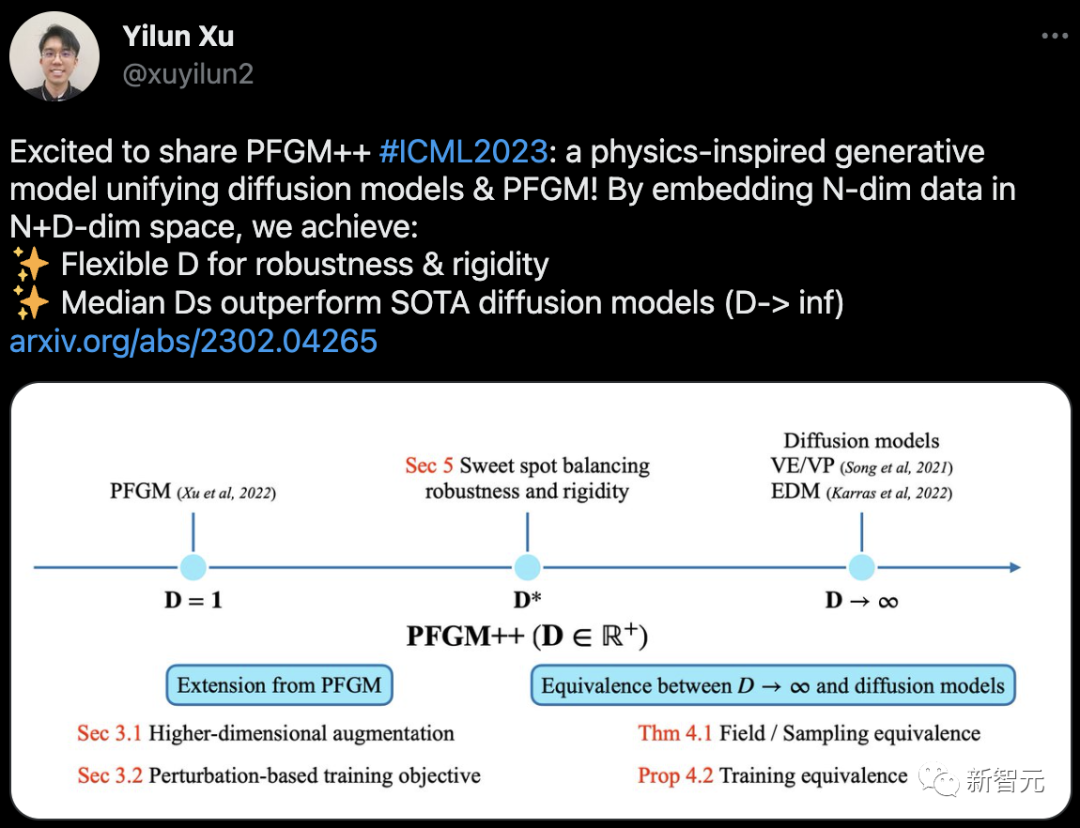

此外,曾获北大图灵班学士学位,现MIT博士二年级的学生Yilun Xu提出的PFGM++被ICML 2023接收。

这篇论文提出了一个受物理学启发的生成模型,也就是PFGM++。它统一了扩散模型和「泊松流」生成模型(PFGM)。通过将N-dim数据嵌入N+D-dim空间,实现了:灵活的D,具有鲁棒性和刚性;中位数D的表现优于SOTA扩散模型(D-> inf)。

论文地址:https://arxiv.org/abs/2302.04265

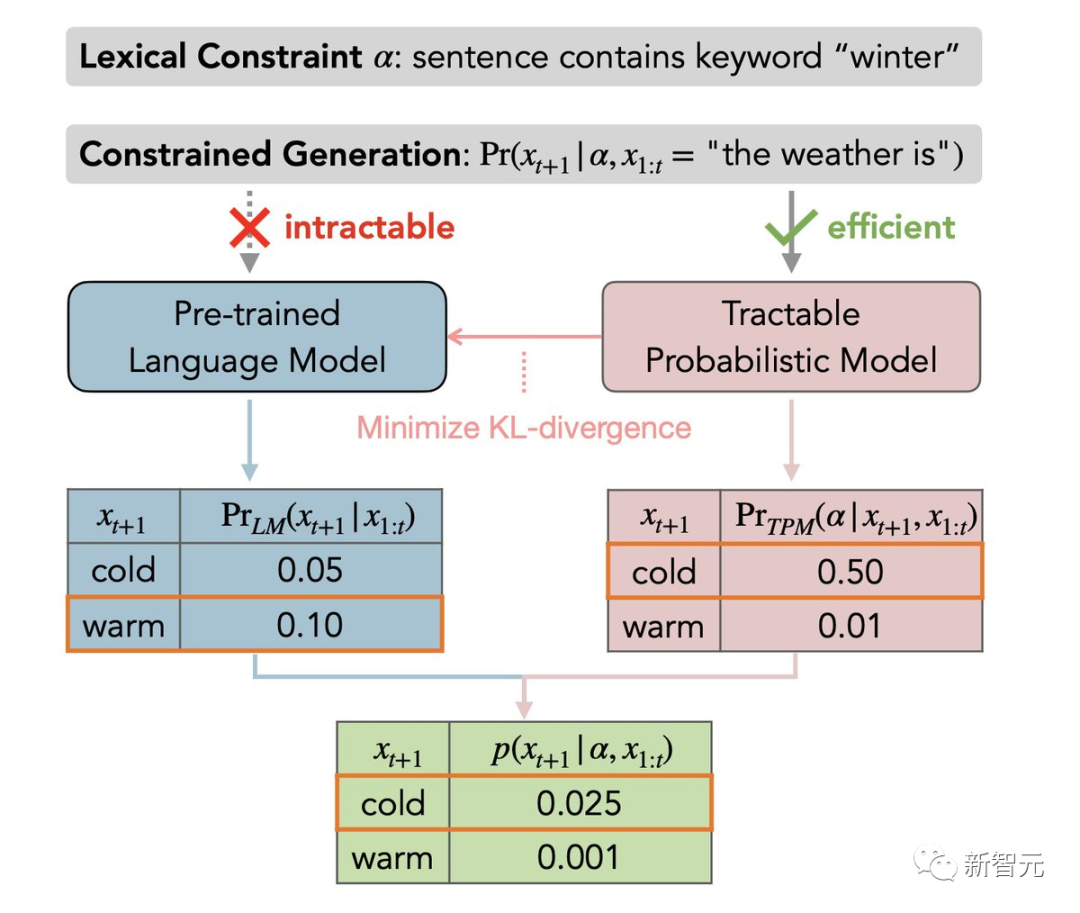

来自UCLA StarAI实验室的张宏华就大型语言模型的可靠控制问题,提出了GeLaTo(易处理约束的生成语言)。这是一个神经符号框架,允许LLMs以100%保证生成遵循逻辑/词汇约束的文本。

在GeLaTo中,作者首先在从LM采样的数据上训练一个可操作的概率模型(TPM),以近似其分布,然后用TPM计算 p (next-token | prefix, constraints),以指导LM自回归生成。

作者者在CommonGen基准上评估了GeLaTo,其目标是使用一些给定的关键词生成文本。GeLaTo不仅达到了SoTA的生成质量(如BLEU分数),而且还保证了所有的关键词都被使用,战胜了各种强大基线。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢