Open Problems and Fundamental Limitations of Reinforcement Learning from Human Feedback

论文说明了强化学习从人类反馈中存在的问题和基本限制。尽管这种技术在训练人工智能系统以符合人类目标方面被广泛应用,特别是在改进最先进的大型语言模型上,但对其缺陷的系统化工作相对较少。

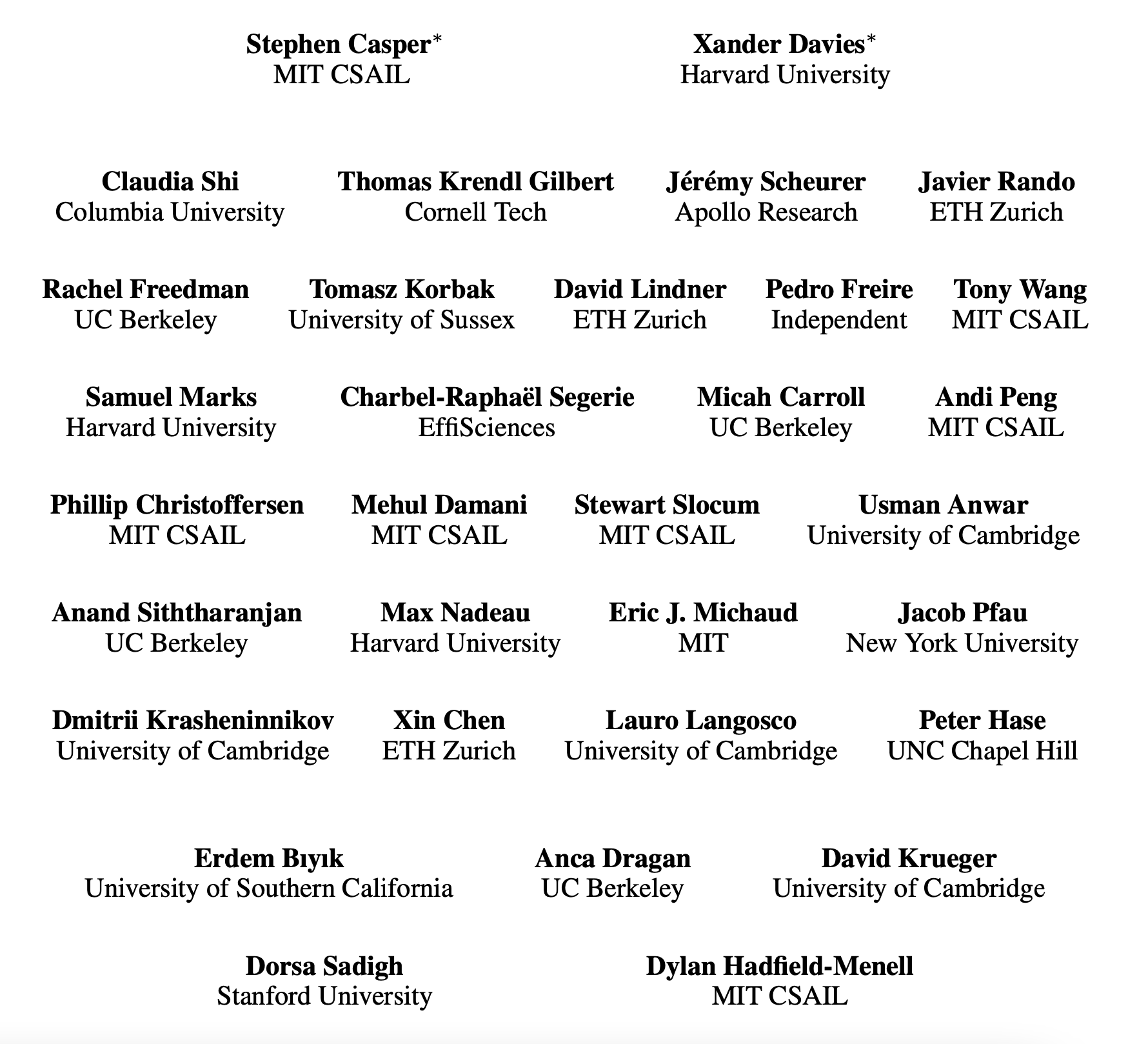

来自MIT哈佛等多个机构共32位研究人员,联合调研了超过250篇论文,全面分析了RLHF在大语言模型中的挑战。

32人作者阵容:Stephen Casper, Xander Davies, Claudia Shi等

论文中,团队主要研究了RLHF面临的三大问题:

人类反馈

奖励模型

策略

并且调查了将RLHF纳入更广泛的技术安全框架的方法,包括更好地理解、改进和补充。

最后,研究人员还探讨了,改进影响使用RLHF训练模型的行业规范和法规的挑战。具体来讲,一些使用RLHF的公司披露某些细节如何改善问责制和审计。

研究人员将这些面对的挑战区分成了两类:机制性的问题和可改进的问题,机制性的挑战需在更大的框架中寻求解决方案,可改进的挑战主要通过改进技术就能解决,研究人员观察到,RLHF提供模型新的能力,但依旧面临许多旧问题,并警告不要重复使用有缺陷的AI对齐方法。

该论文进行了以下方面的工作:(1)对强化学习从人类反馈中存在的问题和基本限制进行了调查;(2)概述了实践中理解、改进和补充强化学习从人类反馈的技术;(3)提出了审核和披露标准,以提高对强化学习从人类反馈系统的社会监督。该论文强调了强化学习从人类反馈中的限制,并强调了以多方面的方法发展更安全的人工智能系统的重要性。

论文地址:

https://arxiv.org/pdf/2307.15217.pdf

这项研究有三个贡献:

RLHF面临的具体挑战 将RLHF纳入更广泛的技术安全框架 治理和透明度

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢