1、Llama 2本地运行指南

如何在本地运行和调试Llama 2,不需要互联网连接,提供了三种开源工具在不同设备上运行Llama 2:Llama.cpp适用于Mac/Windows/Linux,Ollama适用于Mac,MLC LLM适用于iOS和Android】《A comprehensive guide to running Llama 2 locally - Replicate – Replicate》

https://replicate.com/blog/run-llama-locally

2、能创建、运行和共享自包含大模型的工具Ollama

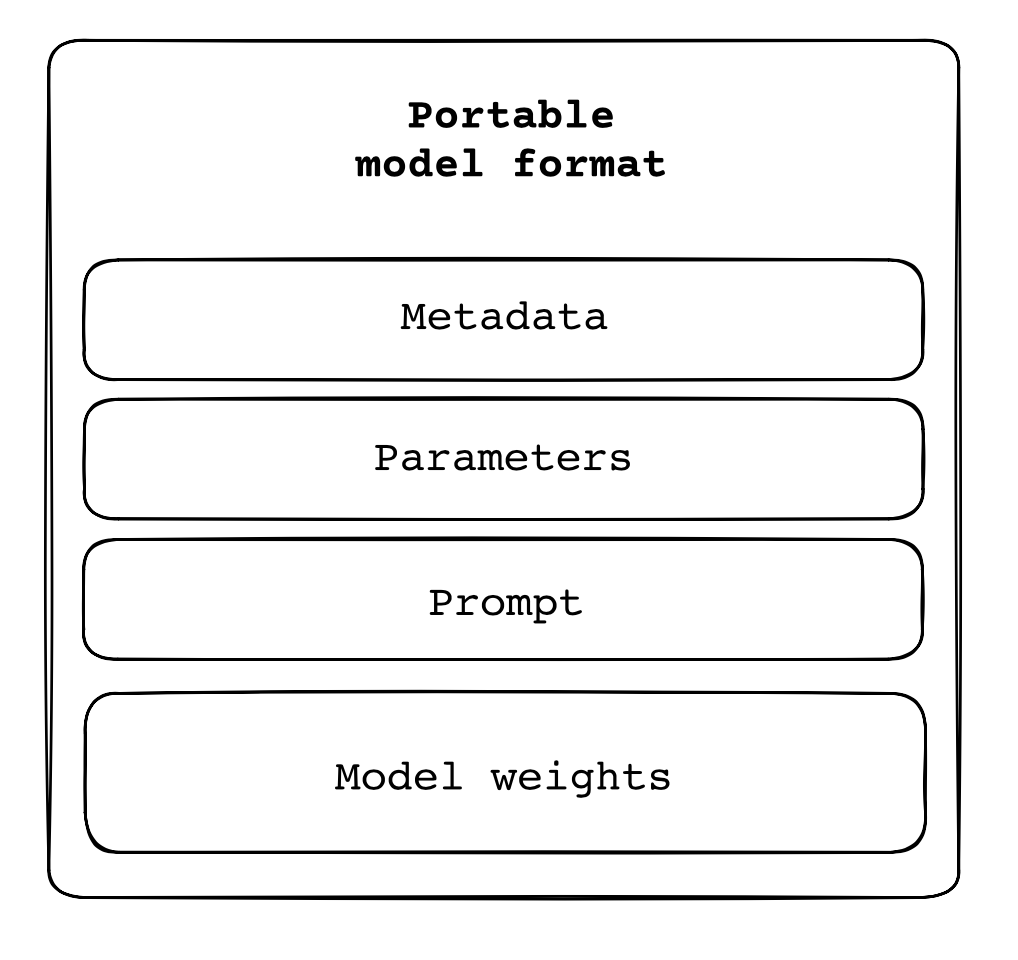

将模型的权重、配置、提示等打包成自包含的文件,可以在任何地方运行

Ollama - Run, customize, and share self-contained & portable large language models' Jeffrey Morgan GitHub: https://github.com/jmorganca/ollama

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢