Accelerating LLM Inference with Staged Speculative Decoding

Benjamin Spector, Chris Re

[Stanford University]

通过分阶段推测解码加速LLVM推理

-

提出"分级猜测解码"算法,语言模型本地小批量推理速度有显著提升。

-

传统解码算法需要一个模型依次解码每个token,计算效率低下,本文利用 Draft 模型和树状构建的 Batch,实现了将多次依次解码转换为一次并行解码,显著提高算力利用率。

-

利用了分级方式,不仅使用了一个 Draft 模型,还加入了第二个模型进行分级猜测解码。这与直接使用单一 Draft 模型有明显区别。

-

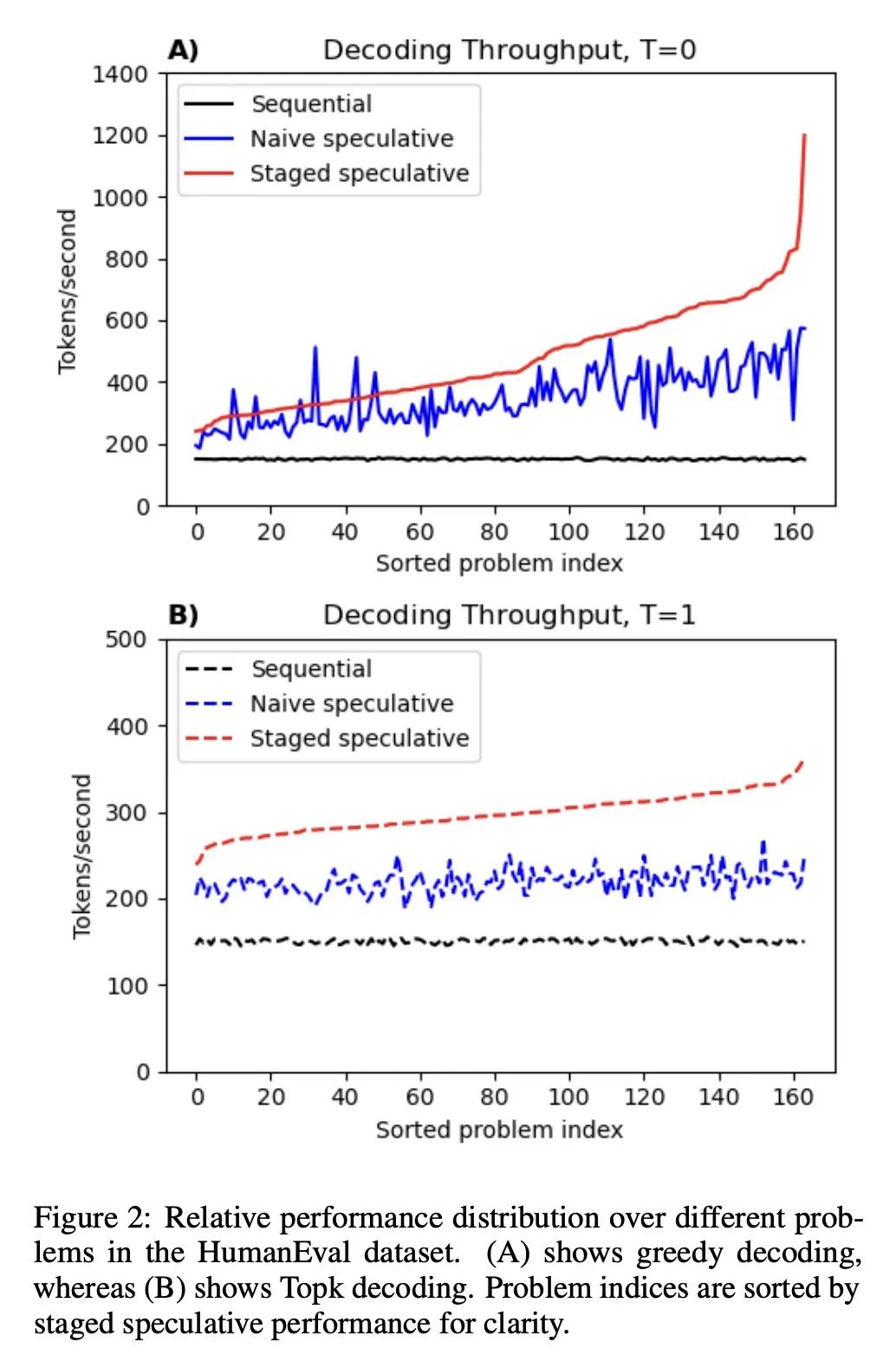

论文结果表明,对于一些简单内容如空格,算法可以获得超过 10 倍的速度提升;但对于难度大的内容,提升效果较小。

-

论文还指出,语言模型生成大部分文本的难度实际上低于其本身能力,这提示我们,模型在核心难点上的效率提升空间可能比较有限。

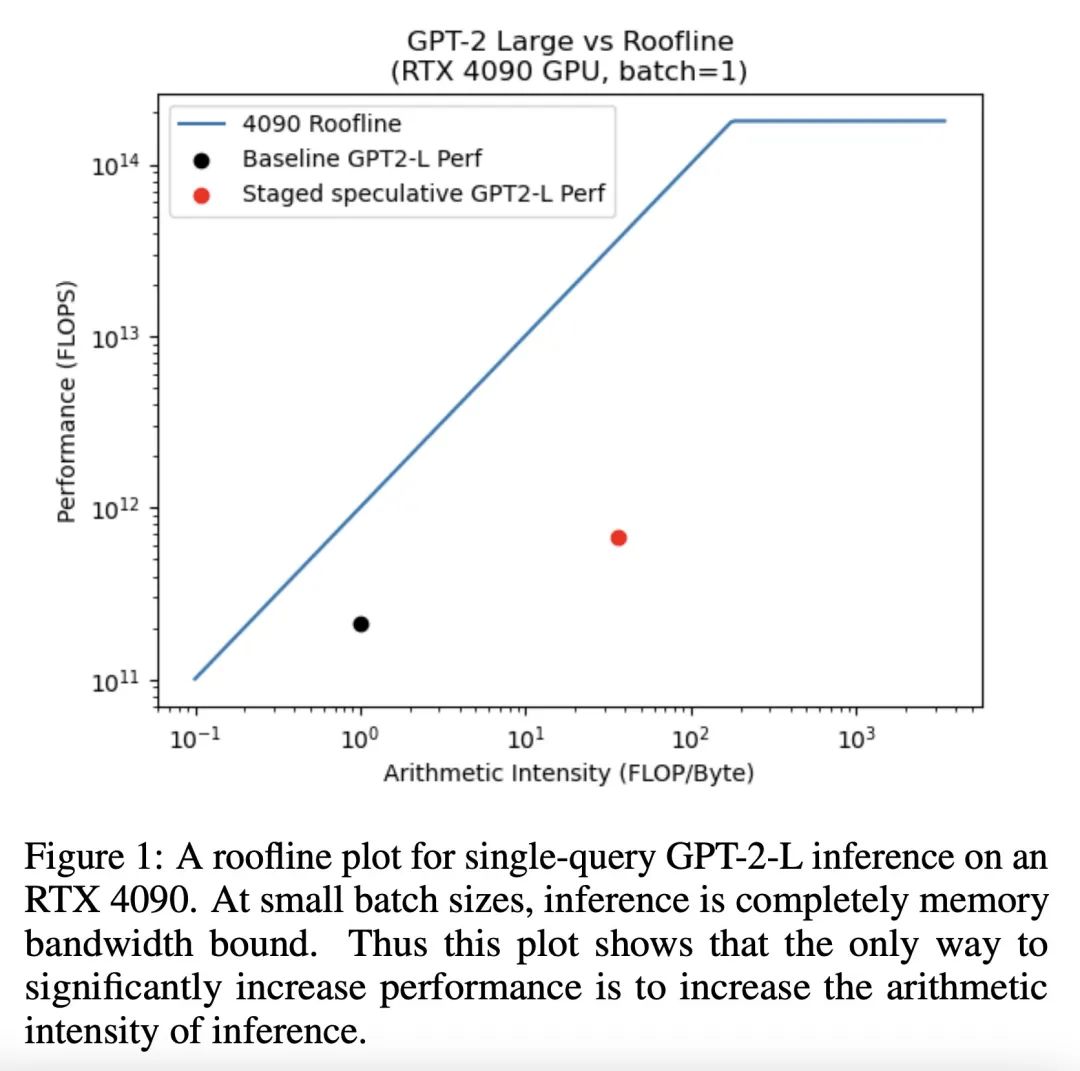

动机:加速小批量、设备端的LLM推理,以应对计算需求增加的挑战。

方法:提出一种新的算法,即分阶段推测解码,通过优化推测批次的结构和增加第二阶段的推测解码,来加速LLM推理。

优势:能显著减少单批次解码的延迟,并在保持输出质量完美的情况下,降低计算资源需求。

提出了一种分阶段推测解码算法,通过优化推测批次的结构和增加第二阶段的推测解码,以加速LLM推理,并降低计算资源需求。

https://arxiv.org/abs/2308.04623

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢