Composable Function-preserving Expansions for Transformer Architectures

Andrea Gesmundo, Kaitlin Maile

[Google DeepMind]

Transformer架构的可组合功能保持扩展

-

目前的Transformer模型通常需要从头开始训练,无法直接复用已训好的小模型的参数,然而,随着模型容量的增加,训练计算量会呈二次增长。 -

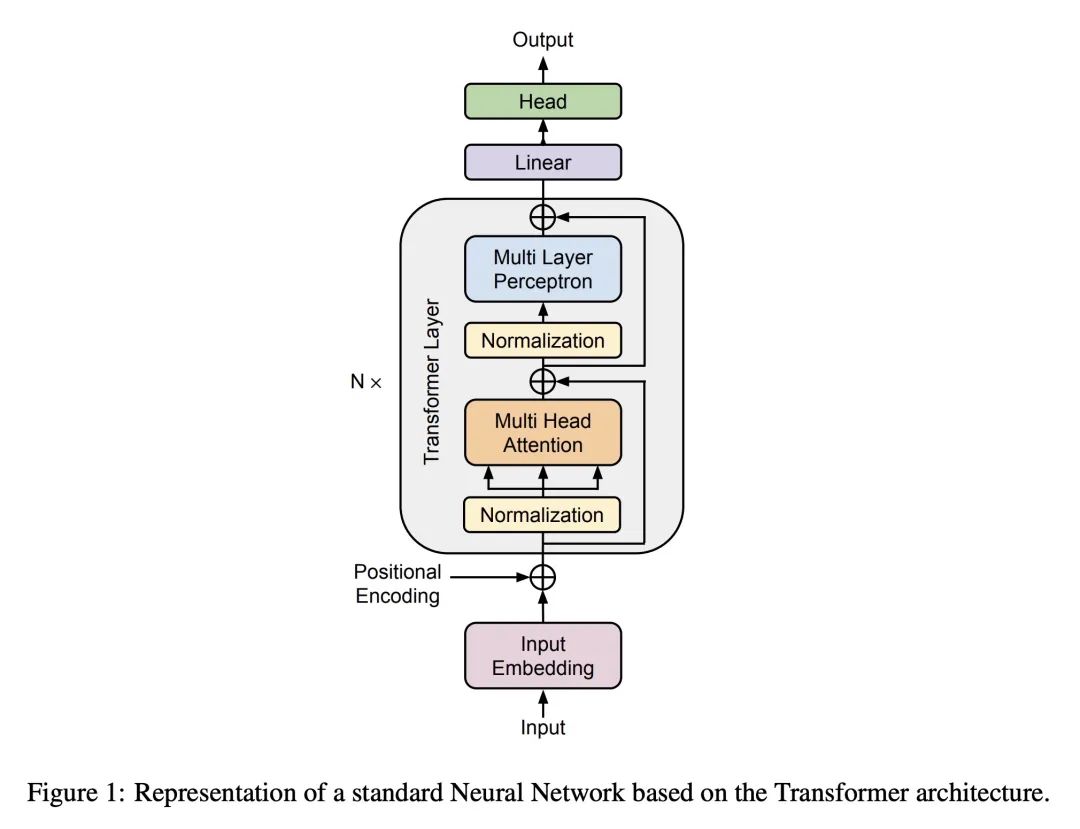

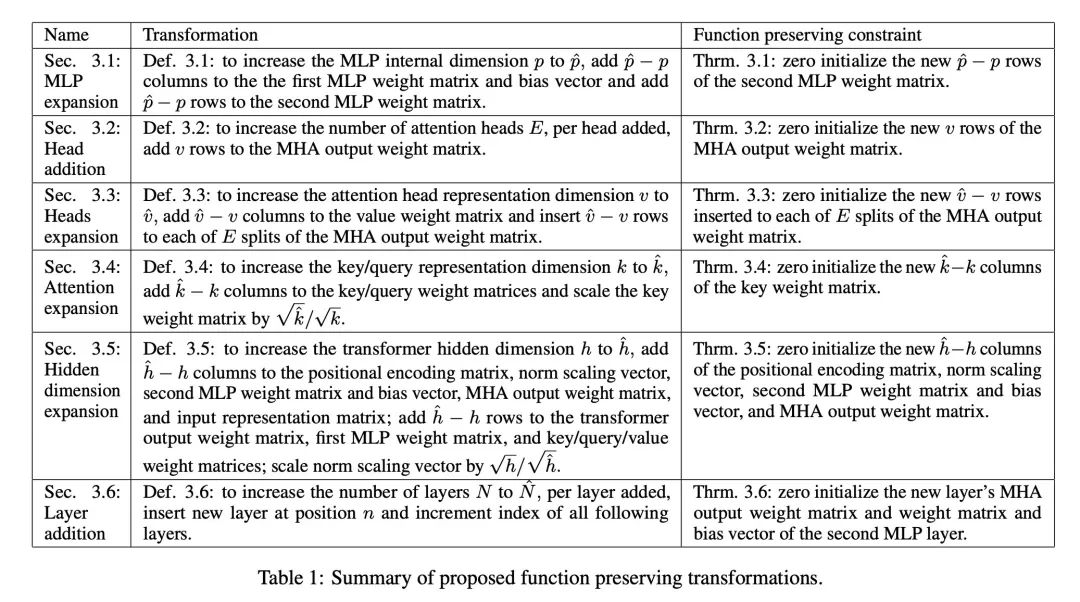

提出6种可组合的功能保留变换,可以按需增加Transformer模型的容量,同时保持模型功能不变,这允许渐进地扩展模型架构,节省训练成本。 -

这6种变换分别针对模型的以下超参数:MLP内部表示维度、注意力头数、注意力头输出表示维度、注意力输入表示维度、Transformer层输入/输出表示维度、层数。 -

对每种变换,作者都给出了最小的初始化约束条件,证明了只要满足这些约束,变换后模型的功能就可以完全保留,这为渐进式扩展模型提供了理论保证。 -

这些变换是可组合的,允许同时扩展模型的多个方面;也可以增量地、交替地应用这些变换的子集,这为模型容量的定制化增长提供了灵活性。 -

这些变换可能大大降低大规模模型训练的计算成本,可以初始化一个小模型,增量训练至期望大小;也可以生成同一任务的不同规模模型族,全部从最小模型的参数开始训练。 -

模型的参数和结构发生变化通常很难保留之前的训练进度,但本文通过证明提出的变换在特定初始化条件下可以完全保留模型功能,实现了渐进式扩展。

动机:训练最先进的神经网络需要大量的计算和时间。增加模型规模被认为是实现和改进最先进技术的关键因素。然而,目前增加模型规模通常需要从头开始重新初始化所有参数,这不利于从较小模型中传递知识。

方法:本文提出六种可组合的变换方法,可以逐步增加基于Transformer的神经网络的规模,同时保持功能性。每种变换方法都提供了确保精确功能保持的证明,并在最小的初始化约束下实现。

优势:提出的方法可以通过在训练过程中逐步扩展架构,为更大、更强的模型提供高效的训练流程。

提出一种能渐进式扩展Transformer架构的方法,以增加模型规模,同时保持功能性,为训练更大、更强的模型提供了有效的解决方案。

https://arxiv.org/abs/2308.06103

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢