《How is LLaMa.cpp possible?》

本文讨论了使用原生C++对LLaMa推理代码进行重写,并通过一些优化和权重量化,实现在多种硬件上本地运行LLM(Large Language Model)。探讨了GPU在深度学习中的作用,指出其在内存带宽和计算能力方面的优势。

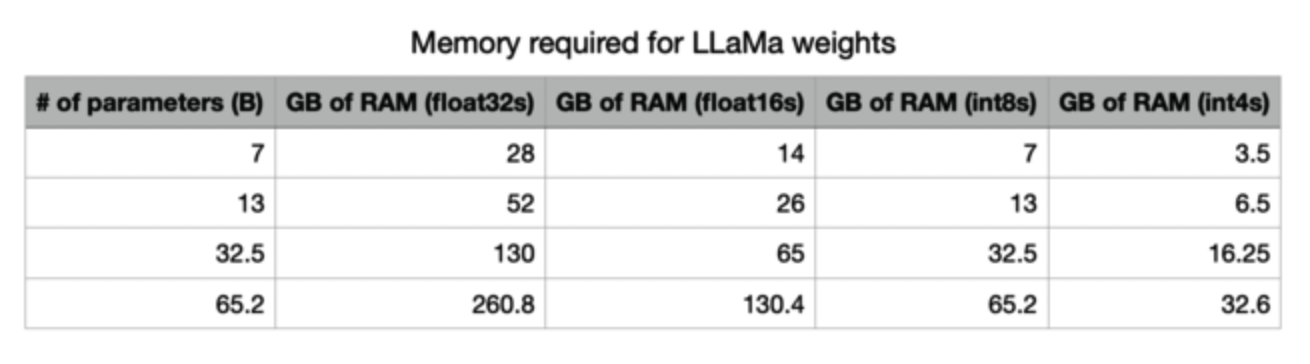

对于运行LLMa的推理性能,文中进行了一些粗略的计算,涉及模型参数、内存需求、矩阵乘法等,着重强调了内存带宽在Transformer模型的采样中是限制因素,而减少模型的内存需求(如量化)对于提高服务效率很重要。

介绍了在不同硬件上运行LLMa的预期性能,如A100、M1 MacBook Air和Raspberry Pi 4等。最后,强调了蒸馏和训练更小模型的重要性。

论文地址:https://finbarr.ca/how-is-llama-cpp-possible/

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢