论文题目:Graph of Thoughts: Solving Elaborate Problems with Large Language Models 作者:Maciej Besta等 机构:ETH Zurich, Cledar, Warsaw University of Technology 等 https://arxiv.org/pdf/2308.09687.pdf

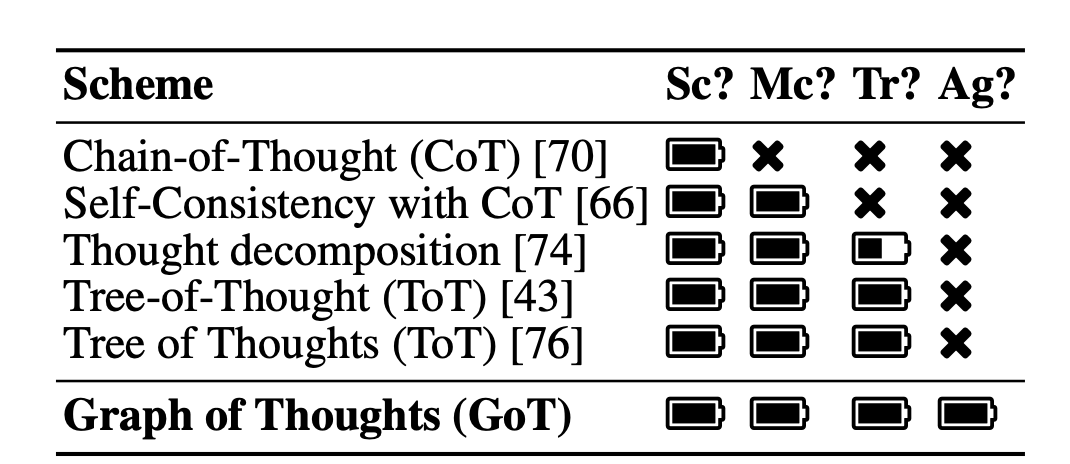

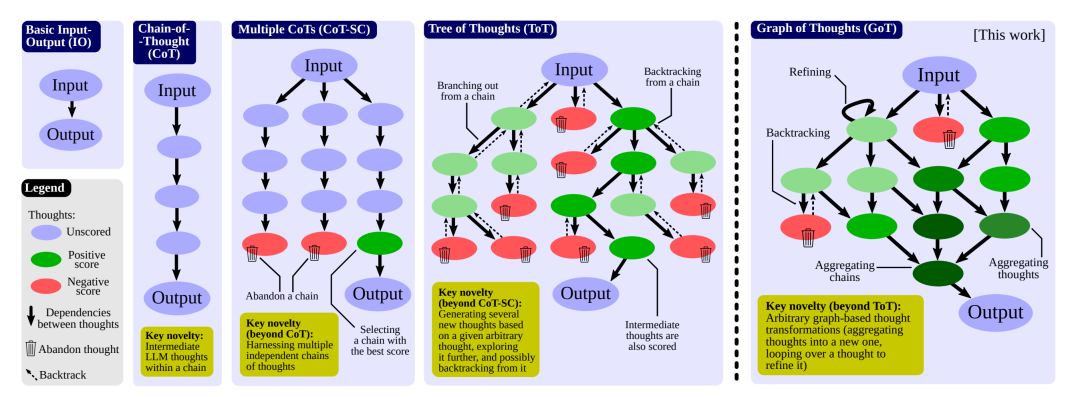

本文提出了Graph of Thoughts (GoT):一个能够在大型语言模型中实现比Chain-of-Thought 或 Tree of Thoughts (ToT)更复杂推理的框架。

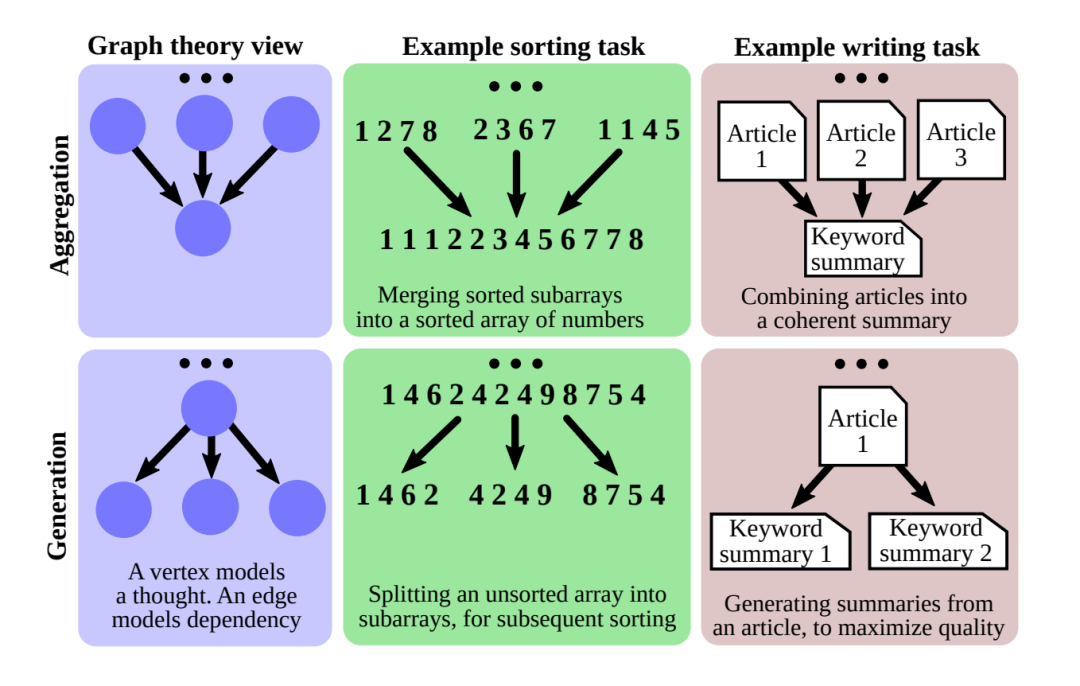

GoT的关键创新和主要优势在于,它可以将语言模型生成的信息建模为任意图,其中信息单元(“语言模型思维”)为节点,节点之间的边对应依赖关系。这种方法能够将任意语言模型思维组合成协同效果,提炼思维网络的本质,或使用反馈循环增强思维。

作者说明GoT在不同任务上优于最新技术,例如在排序任务中提高了62%的质量,同时降低了31%以上的成本。

作者确保GoT可扩展新的思维变换,因此可用于推进新的提示方案。本工作使语言模型推理更接近人类思维或大脑机制(如循环),两者均形成复杂网络。

近年来基于转换器解码器变体的大型语言模型取得了快速发展,例如GPT、PaLM和LLaMA。提示工程是大型语言模型研究的核心新领域之一。简而言之,提示工程将任务描述包含在输入中发送给语言模型。如果以适当的方式表述,语言模型就可以用其自动回归基于标记的文本生成机制来解决任务。 Chain-of-Thought (CoT) 是一种提示方法,在输入和输出之间引入中间思维步骤(中间“思维”)。CoT比基本的输入输出提示baseline提高了许多语言模型任务的性能,如数学难题或一般数学推理。 本文认为,如果允许语言模型思维形成任意图结构,可以实现更强大的提示。这是由人类推理、大脑结构或算法执行等多种现象启发的。 本文的主要贡献包括:1) 提出Graph of Thoughts (GoT),一种通过建模网络化推理来增强语言模型能力的方法;2) 设计模块化架构以实现GoT;3) 说明GoT的几个用例;4) 评估GoT,展示其优于最新技术。

GoT将语言模型的推理过程建模为图,其中节点表示思维,有向边表示思维之间的依赖关系。 GoT实现了新的基于图的思维变换,例如聚合。设为对当前图应用变换得到的新图,为使用的语言模型。则,其中, 。 分别是新增的节点和边, 是移除的节点和边。

GoT的系统架构包含多个交互模块:Prompter (准备发送给语言模型的提示)、Parser (从语言模型回复中提取信息)、Scoring (验证和评分语言模型回复)、Controller (协调整个推理过程)。 Controller 包含两个重要元素:Graph of Operations (GoO) 和 Graph Reasoning State (GRS)。GoO 预先定义推理图的结构。GRS 动态维护当前推理过程的状态。

实验表明GoT在排序、集合操作、关键词计数和文档合并等任务上优于最新技术。

在排序任务中,相比ToT,GoT提高了约62%的排序质量,同时降低了>31%的成本。 在集合交运算中,GoT的错误元素数显著少于其他方法。 在文档合并任务中,GoT的得分也高于其他基线方法。 随着问题规模的增加,GoT相比其他方法的质量提升更明显。这说明GoT更适合可以自然分解为子任务的复杂问题。

提示工程是大型语言模型研究的核心新领域之一。高效的提示设计非常具有挑战性。 本文提出了Graph of Thoughts (GoT),这是一种新的提示范例,使语言模型可以有效地解决不同的任务,而无需任何模型更新。 GoT的关键创新是将语言模型的推理建模为任意图,其中思维为节点,思维之间的依赖关系为边。这使得如聚合等新型的思维变换成为可能。 GoT在排序、集合操作、关键词计数和文档合并等任务上优于最新技术。例如,在排序任务中,GoT分别比CoT和IO提高了约70%和83%。 作者还提出了一个新的提示策略评估指标:思维体积。这个指标旨在更好地理解不同提示方案之间的差异。 总之,图抽象在过去几十年中推动了计算和AI中的几个成功设计。作者的工作将其应用到提示工程领域。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢