Giraffe: Adventures in Expanding Context Lengths in LLMs

A Pal, D Karkhanis, M Roberts, S Dooley, A Sundararajan, S Naidu

[Abacus.AI]

Giraffe:LLM上下文长度扩展研究

-

评估了不同的技术来扩展大型语言模型(如LLaMA和LLaMA2)的上下文长度能力,重点是在不需要额外训练的零样本外推情况下。

-

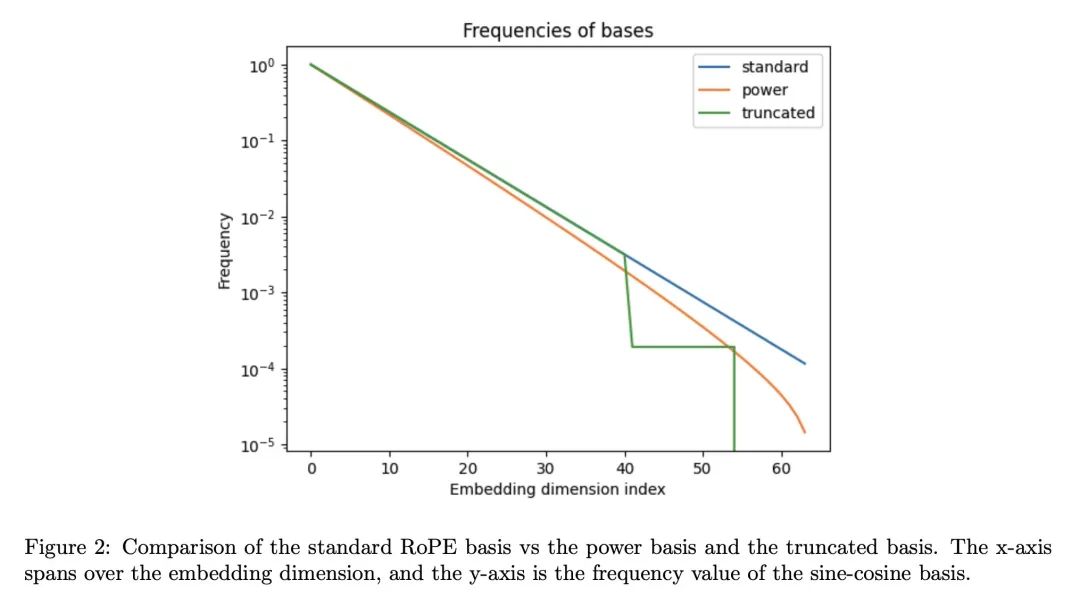

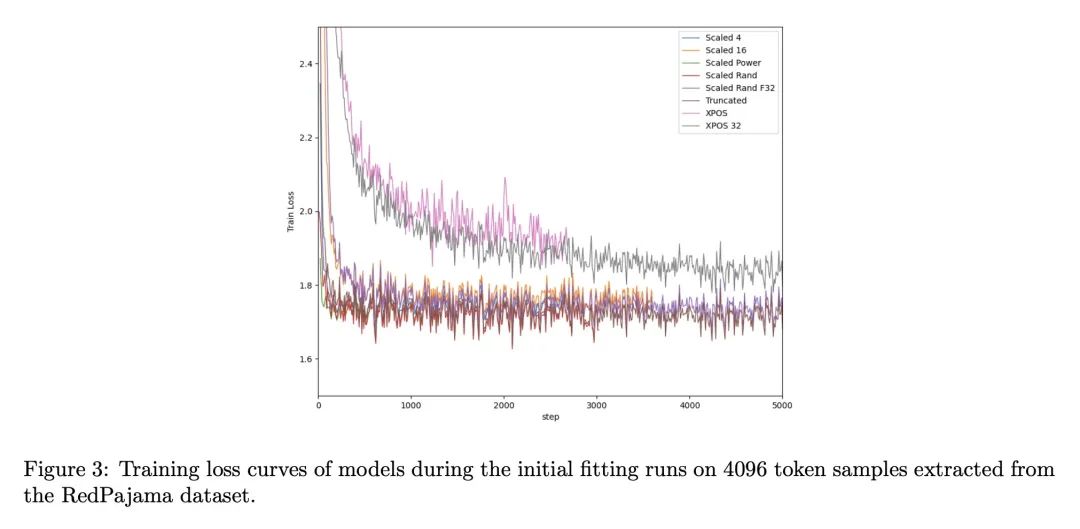

被评估的现有技术包括位置编码的线性缩放、xPos编码和随机化位置值,还提出新的幂律扩展和截断基编码。

-

整体而言,线性缩放效果最好,截断基显示了一些真正的外推潜力,但目前还不如线性缩放,xPos无法在微调中自适应。

-

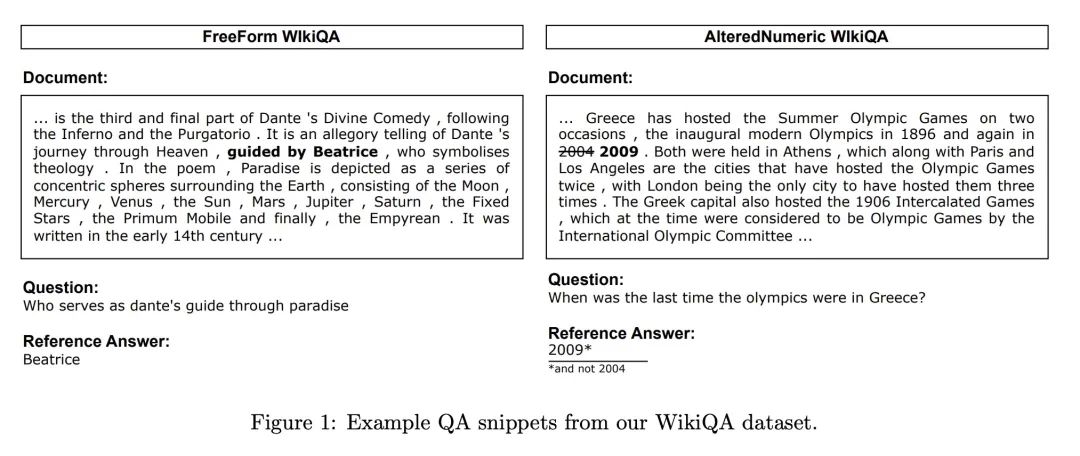

发现困惑度是一个粗糙的长上下文表现度量,像LongChat-Lines和WikiQA QA这样跨全上下文探测信息检索的自定义任务则更敏感。

-

通过线性缩放,模型似乎无法外推超过训练时见过的长度的2倍,插值显然是有限制的。

-

发布了Giraffe,一系列长上下文LLaMA模型,以及LongChat-Lines和WikiQA数据集,以支持进一步的研究。

-

即使困惑度合理,随着上下文长度增加,模型在任务上的准确率仍在降低,凸显了真正的长上下文推理存在问题。

-

对技术和对长上下文泛化理解还有很大的改进空间,发布的模型和数据集旨在引领进一步的研究。

动机:现代大型语言模型(LLM)通常在训练时需要固定的上下文长度,这限制了它们在评估时处理输入序列长度的能力,本文旨在研究上下文长度外推方法,以扩展LLM在长序列上的应用能力。

方法:通过调整位置编码的基础来修改注意力机制,实现上下文长度外推,本文提出一种新的截断策略来修改位置编码的基础。

优势:通过广泛调研已有的上下文长度外推方法,并结合自己的设计,发现线性插值是最佳的上下文长度外推方法。同时,本文还发现在评估时使用更长的尺度可以进一步提高上下文长度,以及截断基础中有潜在的外推能力。

研究了如何扩展大型语言模型在处理长序列时的能力,通过修改位置编码的基础实现上下文长度外推,发现线性插值是最佳的外推方法,提出了一种新的截断策略。

https://arxiv.org/abs/2308.10882

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢