TaskLAMA: Probing the Complex Task Understanding of Language Models

Q Yuan, M Kazemi, X Xu, I Noble, V Imbrasaite, D Ramachandran

[Google Research]

TaskLAMA:语言模型复杂任务理解探究

要点:

-

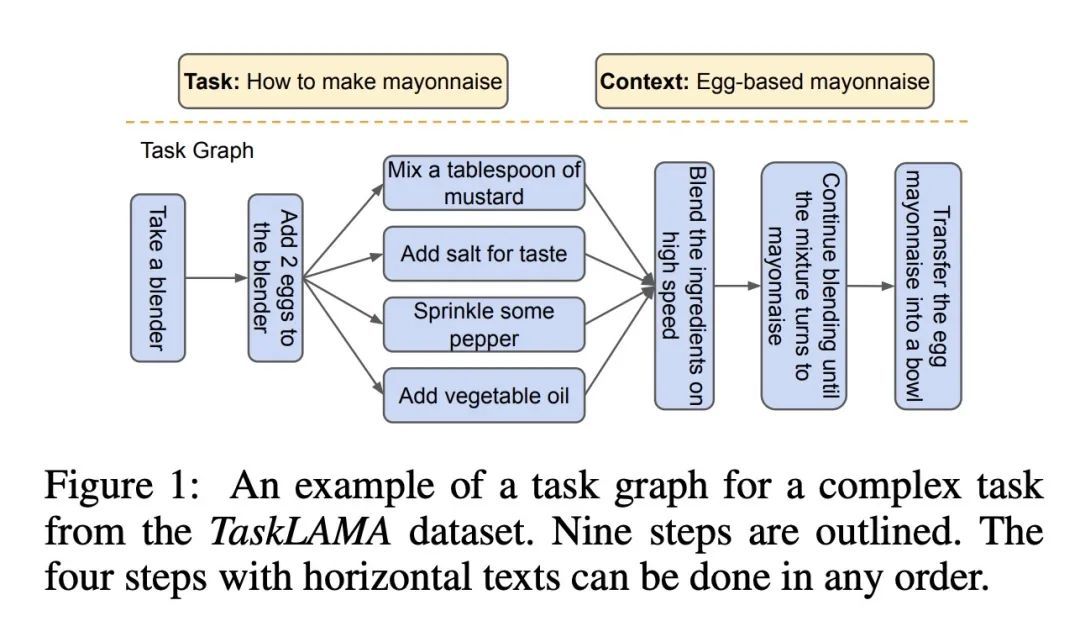

研究了结构化复杂任务分解(SCTD)问题,即将复杂真实世界任务(如策划婚礼)分解成个别步骤及其时间依赖关系。 -

创建了一个新的数据集TaskLAMA,包含1600多个由人工标注的复杂任务、对应的步骤和时间依赖关系。 -

提出评估生成步骤和时间依赖关系质量的新指标。 -

实验表明,与非大型语言模型(LLM)基准相比,LLM生成的步骤质量更好,相对提升15-280%。 -

但是,LLM在预测步骤之间的时间依赖关系上表现较差。经软提示训练可以提高,但仍不够满意。 -

提出一些技术(如结合多个LLM序列,采样和过滤,软提示训练等)可以进一步改进单次LLM调用的步骤生成。 -

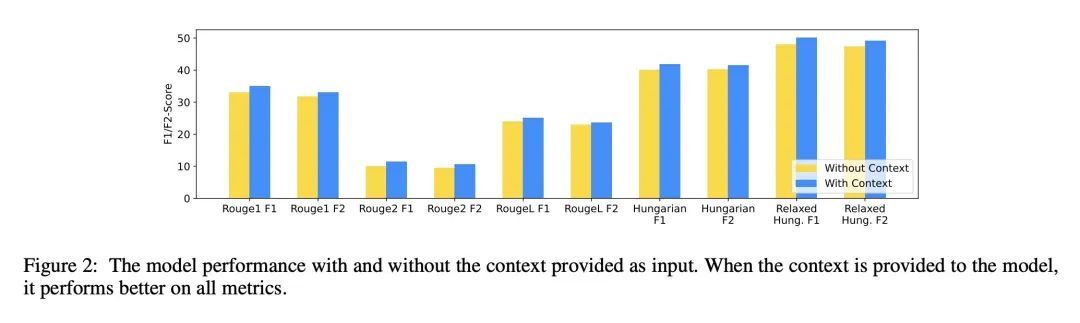

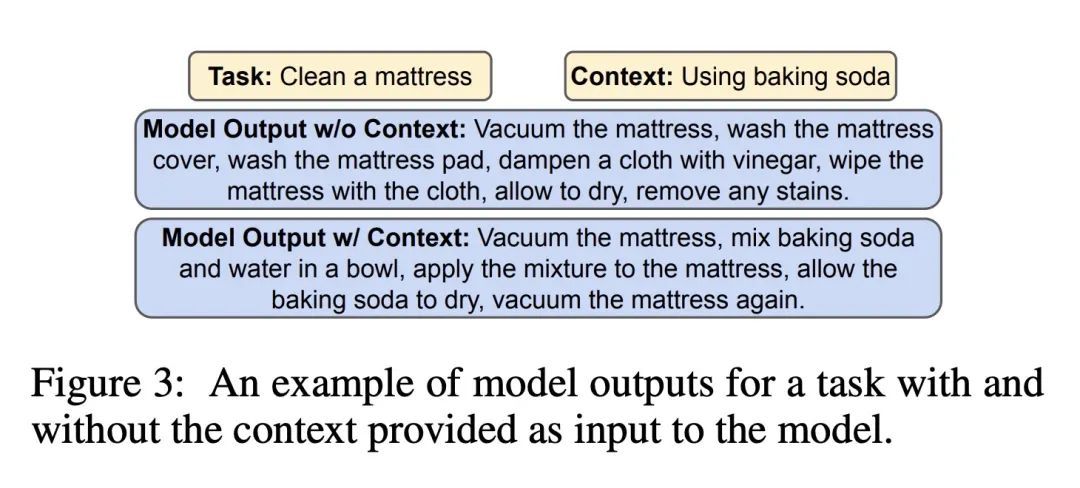

提供执行任务的上下文可以帮助LLM生成更好的针对上下文的步骤。 -

LLM可以生成正确的步骤序列,但对步骤时间依赖关系的理解仍需提高。

动机:研究如何用大型语言模型(LLM)来解决复杂任务理解的问题,特别是结构化复杂任务分解(SCTD)的问题。SCTD是将复杂的现实世界任务(如策划婚礼)分解为有向无环图,图中的每个步骤都有助于完成任务,并且边表示它们之间的时间依赖关系。研究LLM在SCTD问题上的性能,可以帮助我们了解LLM对复杂任务的理解能力。

方法:创建了一个高质量的人工标注数据集(TaskLAMA)来解决SCTD问题。收集了1612个任务,并要求人工标注者提供任务的上下文、所需步骤以及步骤之间的时间依赖关系。通过比较LLM与基准模型的性能,研究者评估了LLM在SCTD问题上的表现,并提出一些改进LLM性能的方法。

优势:实验结果表明,LLM能有效地将复杂任务分解为单个步骤,相对于基准模型有15%至280%的相对改进。还提出一些方法来进一步提高LLM的性能,相对于基准模型有7%至37%的相对改进。然而,研究者发现LLM在预测步骤之间的时间依赖关系方面仍存在困难,揭示了它们对复杂任务理解的不足之处。

一句话总结: 研究了使用大型语言模型解决复杂任务理解的问题,尤其是在结构化复杂任务分解方面的应用,结果显示LLM在分解任务步骤方面表现良好,但对时间依赖关系的理解仍有待改进。

https://arxiv.org/abs/2308.15299

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢