点击下方卡片,关注「集智书童」公众号

尽管与视觉Transformer和卷积神经网络相比,视觉MLP在架构设计上较为简单,但最近的研究表明,它们在性能和数据效率方面表现出色。然而,现有的研究,如CycleMLP和Vision Permutator通常模拟等大小的空间区域中的空间信息,并未考虑跨尺度的空间交互。此外,它们的Token Mixer 仅模拟1轴或2轴的相关性,避免了由于计算需求较高而未考虑3轴的空间-通道混合。

因此,作者提出了CS-Mixer,这是一个分层的视觉MLP,通过跨尺度的局部和全局聚合学习空间-通道混合的动态低秩变换。

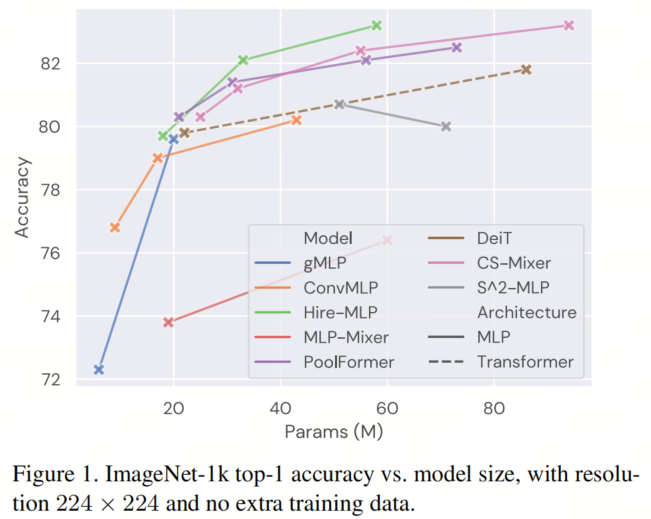

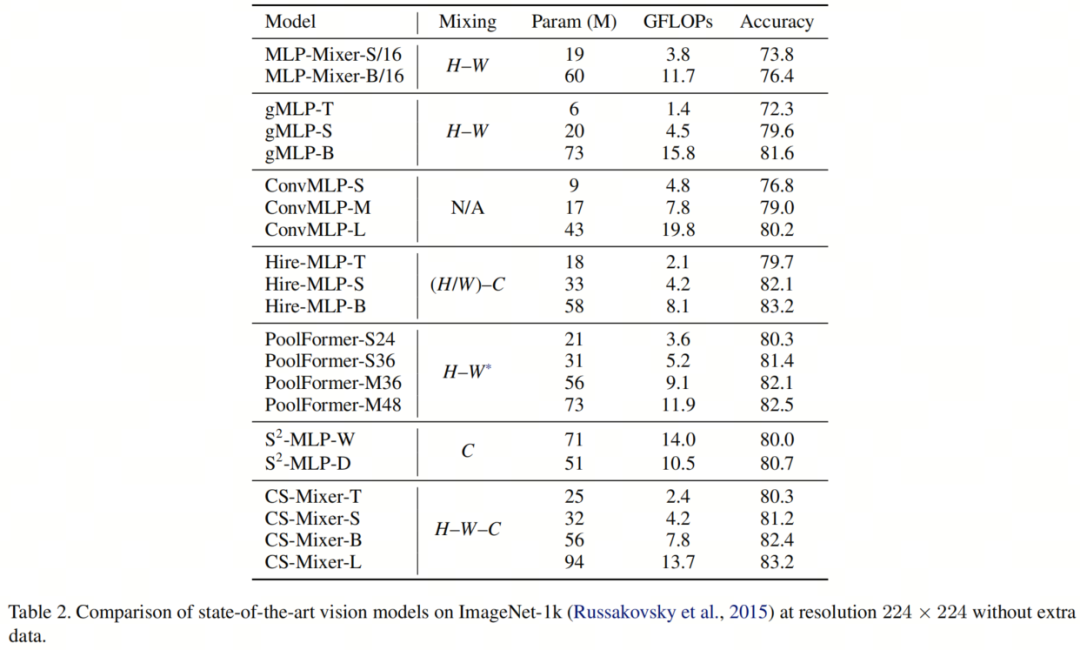

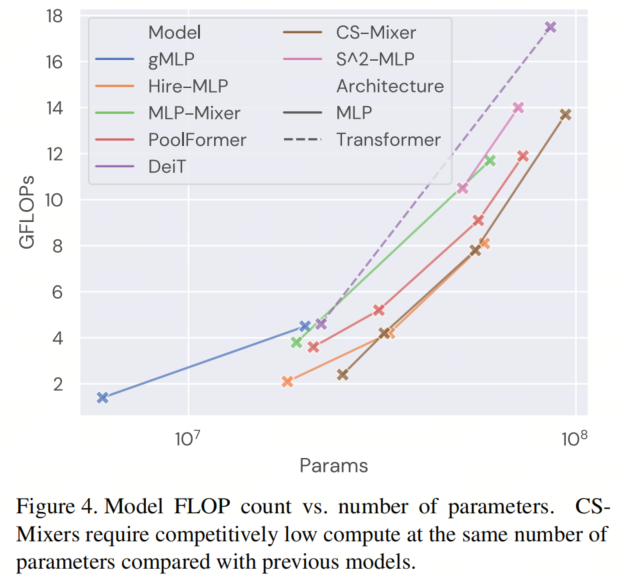

所提出的CS-Mixer方法在流行的图像识别基准测试中取得了有竞争力的结果,而不会增加大量计算负担。作者最大的模型CS-Mixer-L,在ImageNet-1k上达到了83.2%的Top-1准确度,拥有13.7 GFLOPs和94百万参数。

计算机视觉领域旨在建立模拟人类感知和解释视觉信号的机制。为此,研究人员通常设计模型,通常是神经网络,从伴随标签、注释等的大型图像数据集中学习,并在各种基准测试上衡量其性能。

长期以来,神经网络(卷积神经网络,CNNs),它们使用离散卷积和池化操作来参数化具有空间归纳偏差的网络,自从AlexNet推广以来,已经在各个领域得到广泛应用。引入这种空间局部性和平移不变性的模型在早期深度学习文献中取得了巨大的成功,许多CNNs,例如EfficientNets,NFNets和ConvNeXts,在计算机视觉领域仍然至关重要。

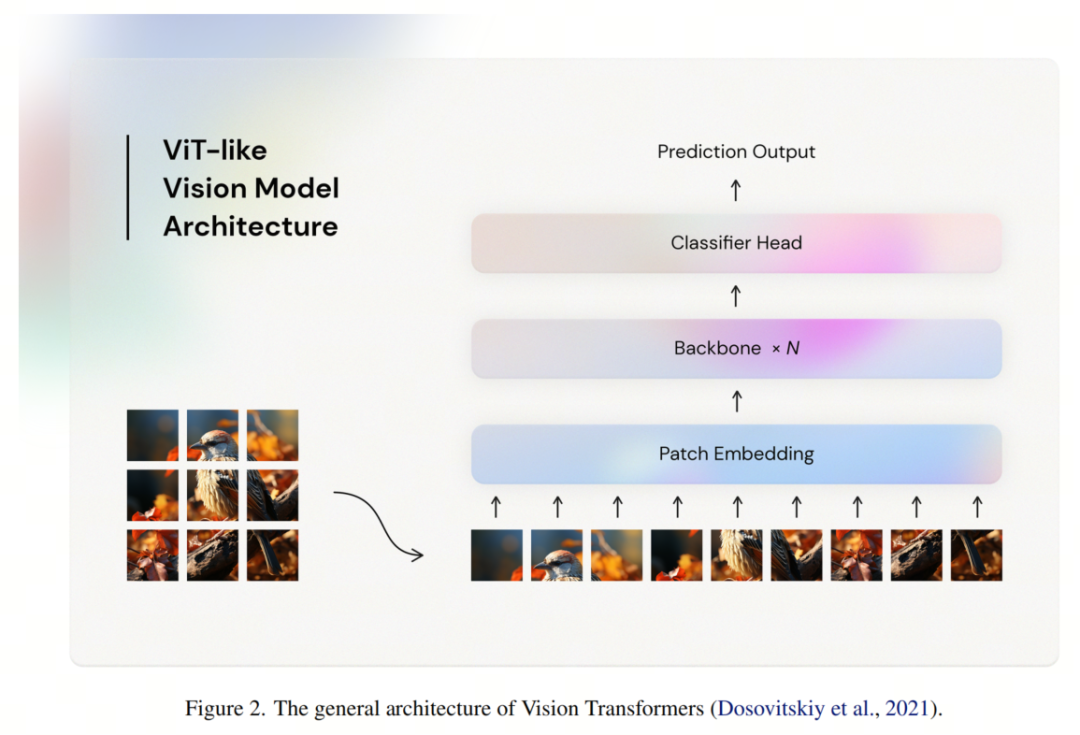

然而,在2020年初,Dosovitskiy等人(2021)通过视觉Transformer(ViTs)彻底改变了这一领域,直接借用了自然语言处理(NLP)范例来构建神经网络。具体而言,将输入图像视为一系列较小(例如7×7)不重叠的Patch,其中每个Patch被视为一个Token。因此,生成的表示是Token序列,这是NLP模型操作的空间。然后,Token通过一个变换编码器传递,并最终发送到与任务相关的头部,用于下游应用。

正如ViTs所展示的,视觉神经网络无需依赖手工制作的空间等价性即可实现稳健的性能;相反,具有足够表达力的空间操作,如自注意力,可以替代卷积和池化的作用而不会降低性能。

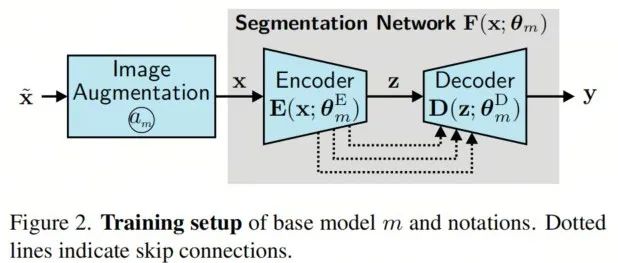

具有这些优势,ViTs为视觉模型设定了一个新的范例,其结构如下(图2):一个Patch嵌入层,后跟多个Backbone层,每个Backbone层包括一个Token Mixer 和一个通道 Mixer ,最后是一个任务相关的头部,例如分类。许多其他视觉Transformer架构,如SwinTransformer和MaxViT,都遵循了这一工作线并在各种视觉基准测试中取得了更强的性能。

另一方面,由MLP-Mixers领导的一系列工作探讨了类似的视觉架构,只使用多层感知器(MLPs)。MLPs是所有神经网络架构的起源,并且在所有神经网络架构中都无处不在,特别是它们用作ViTs的通道 Mixer 。认识到视觉模型不需要类似卷积的结构,MLP-Mixers建议替换ViTs中的Self-Attention,从而得到一个完全由MLP构建的架构。具体而言,MLP-Mixers使用MLPs进行Token混合,这些MLPs以与处理通道信息相同的方式对待空间转换。然而,简单的Token混合设计不能捕获任何高阶交互,这在建模复杂的跨Token信息方面表现出不足。

随后的大量工作主要集中在设计MLP Token Mixer ,以整合空间先验信息以提高性能。这些基于MLP的模型主要关注于在固定大小的静态区域内混合Token,以逐渐学习更丰富的信息。尽管与最先进的Transformer架构具有竞争力的性能,但固定大小的空间混合机制无法关注不同大小的对象,而它们的通用架构也不能模拟明确的跨层信息以获得跨尺度的图像表示。

此外,现代视觉MLP模型通常仅在3轴图像表示的一个或两个轴上学习Token混合变换:仅通道,高度和宽度或通道轴和任一空间轴的组合。这主要是由于计算预算有限,因为同时混合高度、宽度和通道会导致至少个参数的全连接层(N = 分辨率,D = 嵌入维度)。

尽管一些最新的架构是例外,但它们仍然无法有效地模拟大规模的跨尺度信息。因此,作者提出一个问题:是否可以进一步扩展基于MLP的视觉神经网络,以模拟3轴的空间-通道相互作用,而不降低网络性能或增加额外的计算成本?

为此,作者引入了一种新的基于MLP的视觉架构,命名为CS-Mixer,它利用多尺度的空间信息,并直接参数化了沿着所有3个轴的表达力非线性变换,以模拟空间Token混合。具体来说,通过通过局部和全局聚合来整合跨尺度信息,CS-Mixer成功地学习了在有限计算资源下同时在高度、宽度和通道上执行表达力强的转换。

如图1所示,所得到的模型与最先进的基于Transformer和MLP的模型具有竞争力,而不需要更多的参数或计算FLOPs。作者期望这项工作能为未来的研究设立一个基准,并指导进一步探讨3轴Token混合策略的努力。

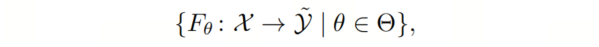

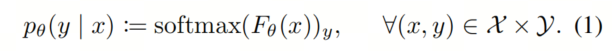

图像分类的任务可以如下定义。假设作者有一个有限的、Token为 K 类的训练数据集 ,其中 表示输入图像空间, 表示输出空间。神经网络架构是一组参数化的映射

其中 表示对数空间, 是由神经网络定义的参数空间。通过应用 操作,作者得到了数据集可能类别的概率分布 :

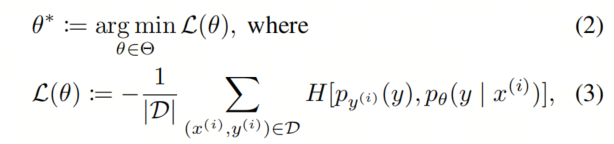

然后,作者通过 AdamW 一阶优化器在训练数据集上最小化交叉熵损失函数:

其中 表示交叉熵, 是以 为中心的 分布。

为了衡量经过训练的神经网络 的性能,作者使用一个测试数据集 ,并报告准确性:

其中 是 Iverson 括号。

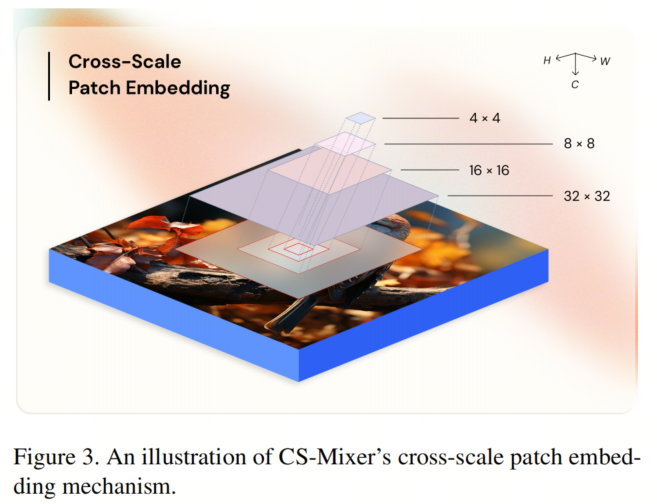

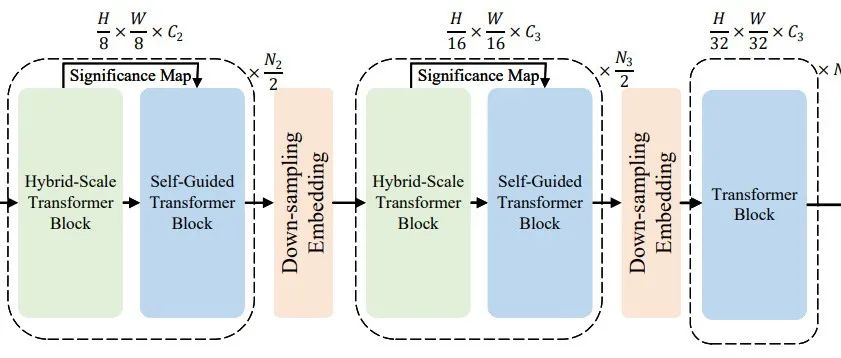

作者采用了一种常见的分层视觉MLP结构,如图2所示,但做了一些修改。为了利用跨尺度的空间信息,作者遵循了Wang等人(2022)的方法,将输入图像的大小为 4、8、16、32 的Patch大小应用于交叉尺度嵌入层,生成大小为 H/4 × W/4 的图像嵌入。

这些Token被视为表示图像的 h×w×c 张量,然后通过4个Backbone阶段,交错使用跨尺度Patch合并层来进行空间降采样的聚合和通信。一个Backbone阶段包括多个堆叠的CS-Mixer层,每个层包括一个Token Mixer 和一个通道 Mixer 。作者使用提出的CS-Mixer操作进行Token混合,并将通道 Mixer 设置为一个具有MLP比率4的3层MLP,按照ViTs的惯例进行设置。

作者采用类似于跨尺度嵌入层,Patch大小为4、8、16和32,如图3所示。具体来说,对于大小为 H × W × C 的输入图像,作者应用4个卷积层,Stride 为4,卷积核大小分别为4、8、16和32,其中应用填充以使输出共享空间维度(H/4)×(W/4)。

对于嵌入维度 c,作者将输出通道数分别设置为 c/2、c/4、c/8 和 c/8,然后沿通道轴进行串联,以产生大小为(H/4)×(W/4)×c 的嵌入。

请注意,串联的顺序无关紧要,因为后续层可以轻松地吸收任何排列。

CS-Mixer的Backbone具有像Liu等人(2021b)采用的分层金字塔结构。第 i 个Backbone阶段(i ∈ [4])是 个相同但分别参数化的CS-Mixer层的组合,其中每个层都是一个包含Token Mixer 和带有残差连接的通道 Mixer 的堆叠层。

请注意,Backbone阶段不会修改输入嵌入的形状。

作者使用具有大小为2和4的Patch的跨尺度嵌入层来进行Patch合并,其中Stride 设置为最小的Patch大小,即2。形状为 h × w × c 的输入嵌入具有输出形状 (h/2) × (w/2) × (2c),从而将每个空间维度减小了2倍,并将下一个阶段的通道数加倍。

作者采用标准的分类器头,执行全局平均化,然后进行线性投影到 ,以产生K类 logits。

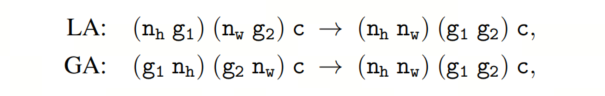

给定一个能够整除 h 和 w 的分组大小 g,CS-Mixer 运算符接受输入嵌入 并将其重新排列为 组 序列嵌入( ),通过聚合局部或全局Token。这个重新排列可以用 einops 符号来描述如下:

其中 LA 和 GA 分别指的是局部和全局Token聚合。

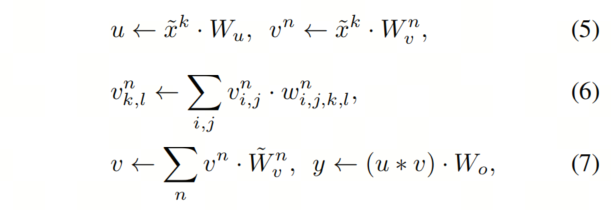

然后,使用 m 个 Head 并行混合了这些聚合Token的组。对于每个Token序列 ,作者计算:

其中 ,,,和 是参数化 CS-Mixer 运算符的权重矩阵。

元素乘法实现的混合受到了 gMLPs 的启发。然而,一个关键的区别是,作者在 的低维子空间中执行了 的空间-通道混合。

注意,在方程 6 中,,其中子空间 是通过 的映射获得的。如果在混合过程中包括所有轴,将导致比仅通道混合策略多五到六个数量级的参数。

因此,为了减少参数数量,同时保持表达能力,作者首先将 投影到较低维度空间 ,其中 控制变换的秩。作者的实验证明,维度低至 d = 2 或 d = 4 就足以捕捉图像识别任务中出现的复杂性。

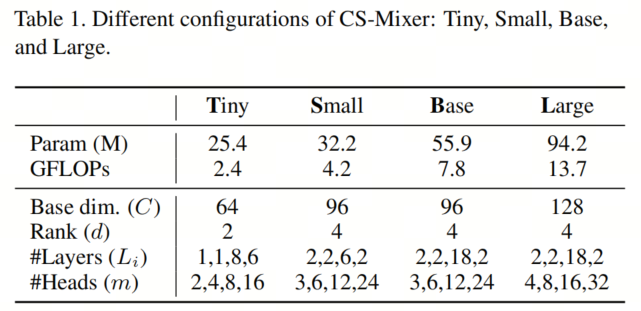

作者设计了4种不同大小的CS-Mixer架构模型,如表1所示:Tiny、Small、Base和Large。这些模型在PyTorch中实现,并在分辨率为224×224的ImageNet-1k数据集上进行训练,没有使用额外的数据。作者采用了标准的训练过程,进行了300个epoch的训练,并采用了RandAugment、Mixup、CutMix、Random Erasing和Stochastic Depth来进行数据增强和正则化。

需要注意的是,Mixup和CutMix会改变损失函数中的项(方程3)。作者采用了L2正则化,正则化率为,采用了20个预热周期,学习率为,以及10个冷却周期,学习率为。作者使用余弦学习率调度器,每个epoch调整一次,全局批量大小为1024,基本学习率为,最小学习率为。作者还使用指数移动平均权重进行验证,衰减率。作者在预处理图像时采用90%的中心裁剪,并在验证集上报告准确性(方程4),验证集包含50,000张图像。

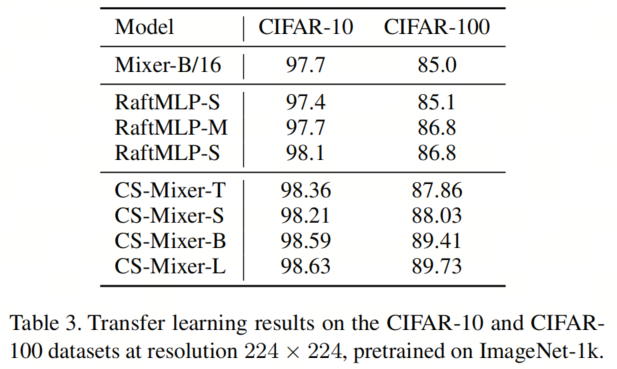

作者还在CIFAR-10和CIFAR-100数据集上应用了迁移学习。作者重新定义了模型的分类器头部,具有正确数量的类别,该头部被随机初始化。然后,模型使用与第4.1小节相同的方法进行训练,只是以下超参数进行了替换:全局批量大小为256,学习率为,权重衰减为,裁剪百分比为100%。特别地,作者在训练和评估过程中将所有图像调整为224×224,不进行裁剪。作者还在迁移学习实验中禁用了指数移动平均,并与Tatsunami&Taki(2022)报告的结果进行比较,后者采用了类似的设置。

正如表2所示,与最先进的视觉模型相比,不同尺寸的CS-Mixer在ImageNet-1k上取得了稳健的性能。尽管3轴混合需要更多的参数,但作者的模型通过在低秩子空间中建模空间-通道混合(方程6)来保持可比的FLOP计数,与要小得多的模型具有可比的FLOP计数。例如,CS-Mixer-L的参数比S 2 -MLP-W多2000多万个,同时需要的FLOP数稍微低于(图4)。随着作者继续这项工作,作者期望进一步研究秩对网络性能的影响以及它的理论影响。

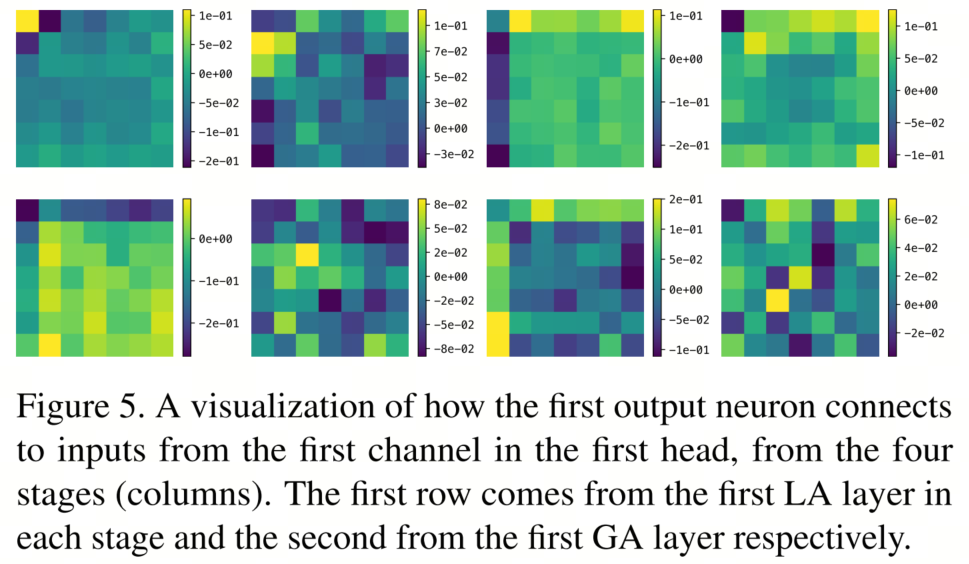

作者还在图5中可视化了由作者的Token Mixer 学习到的空间权重 ,这是没有损失一般性的。这些权重在空间轴上的局部和全局尺度上展示了非平凡的模式,这证实了局部和全局聚合对于Token混合的有效性。

[1].CS-Mixer: A Cross-Scale Vision MLP Model with Spatial–Channel Mixing.

新加坡国立大学提出SG-Former | ViT中的好学生,超越SWin和CSWin Transformer!

ReVT | ViT重参化+超强数据增强实现完美的域泛化

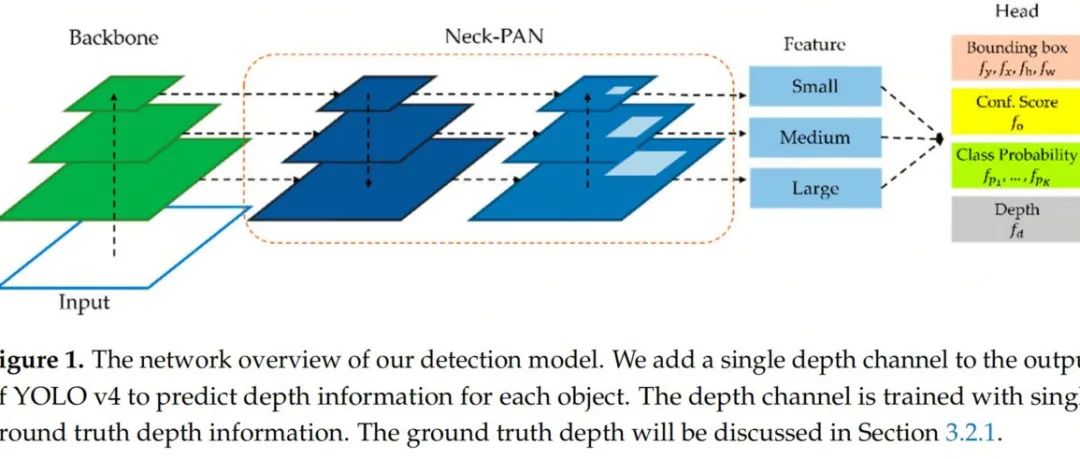

YOLO-MDE多任务框架 | 目标检测+深度估计都可以实现SOTA

扫码加入👉「集智书童」交流群

(备注:方向+学校/公司+昵称)

前沿AI视觉感知全栈知识👉「分类、检测、分割、关键点、车道线检测、3D视觉(分割、检测)、多模态、目标跟踪、NerF」

欢迎扫描上方二维码,加入「集智书童-知识星球」,日常分享论文、学习笔记、问题解决方案、部署方案以及全栈式答疑,期待交流!

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢