一位自称「民科」的业余研究爱好者,却以一作身份,合作领域大牛Joel Weisberg,在天文学顶刊MNRAS上发表论文,这段不同寻常的经历被网友挖掘出来,并冲上知乎提问热搜→如何看待某「业余科学家」在天文学顶刊 MNRAS 以一作身份发表重量级论文?- 知乎

针对这个问题,当事人 @liangzx 也亲自给出了回答:

对于这段经历,不少网友都对其科研精神表示佩服,更有人表示:他的研究身份已经不属于民科,而是独立科学家。

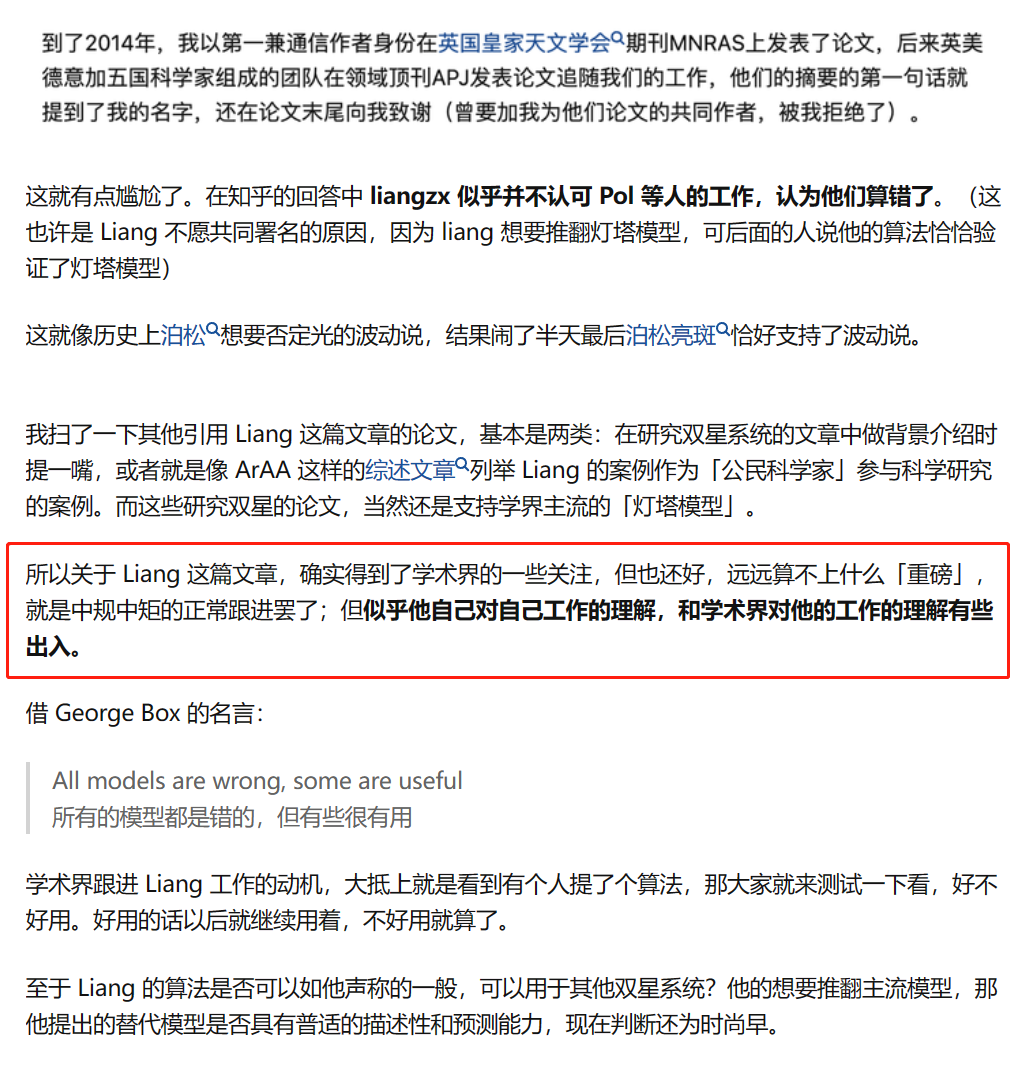

但网友@Luyao Zou认为其争议不在于@liangzx是否民科出身,而是:他对自己工作的理解和对学术界对他的工作理解有出入。

而网友@不会弹钢琴的9号 也表示,MNRAS作为天文顶刊,却不收取发表费用,让所有人都可以平等地发表自己的成果:

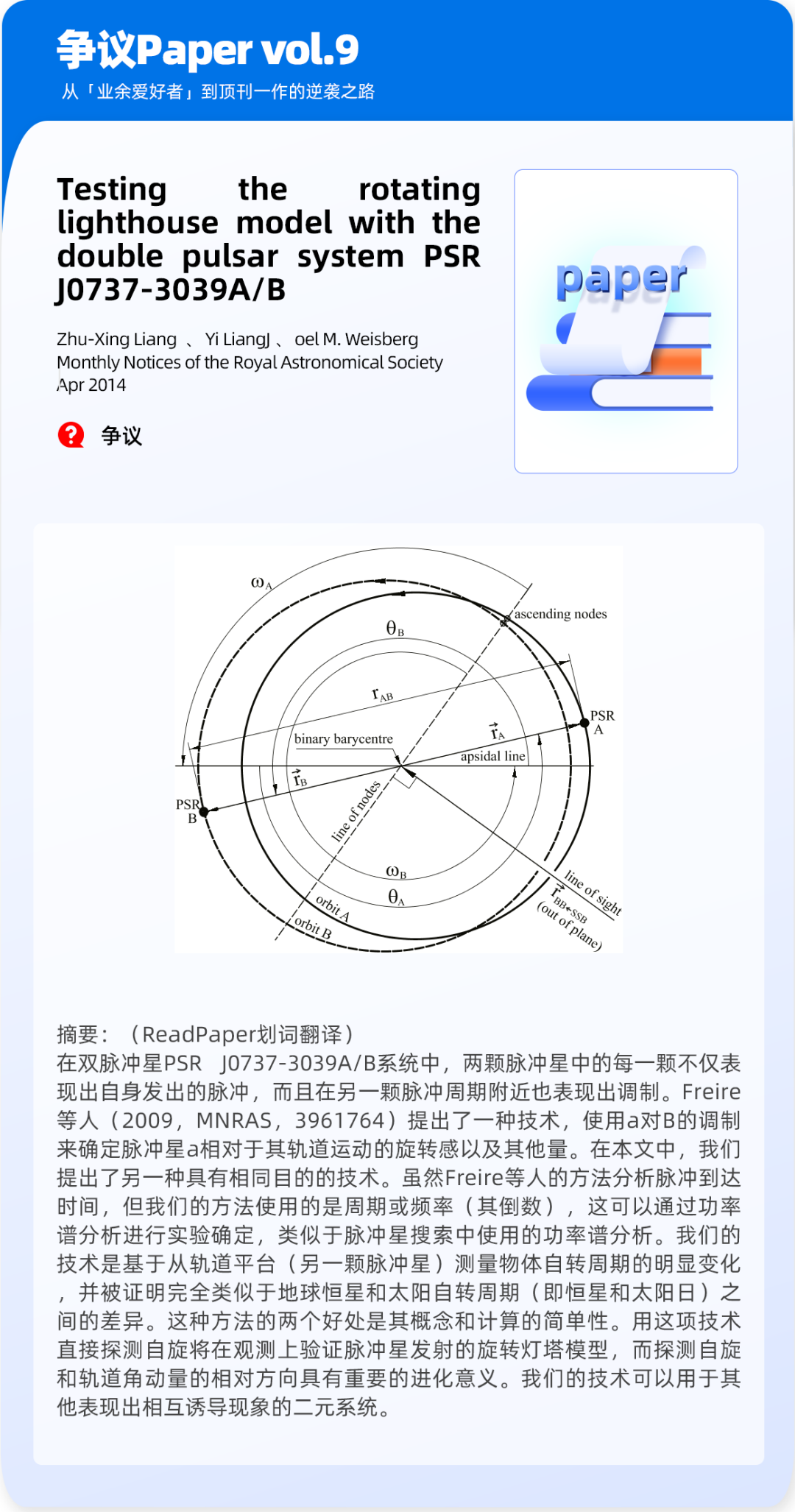

对于@liangzx发表的论文Testing the rotating lighthouse model with the double pulsar system PSR J0737-3039A/B及其科研经历,你又有哪些看法呢?

#2023 vol.9

有争议Paper

Testing the rotating lighthouse model with the double pulsar system PSR J0737-3039A/B

Zhu-Xing Liang / Yi Liang / Joel M. Weisberg

READ PAPER

而本期Best Paper则花落Meta开源之光 — Llama 2: Open Foundation and Fine-Tuned Chat Models.

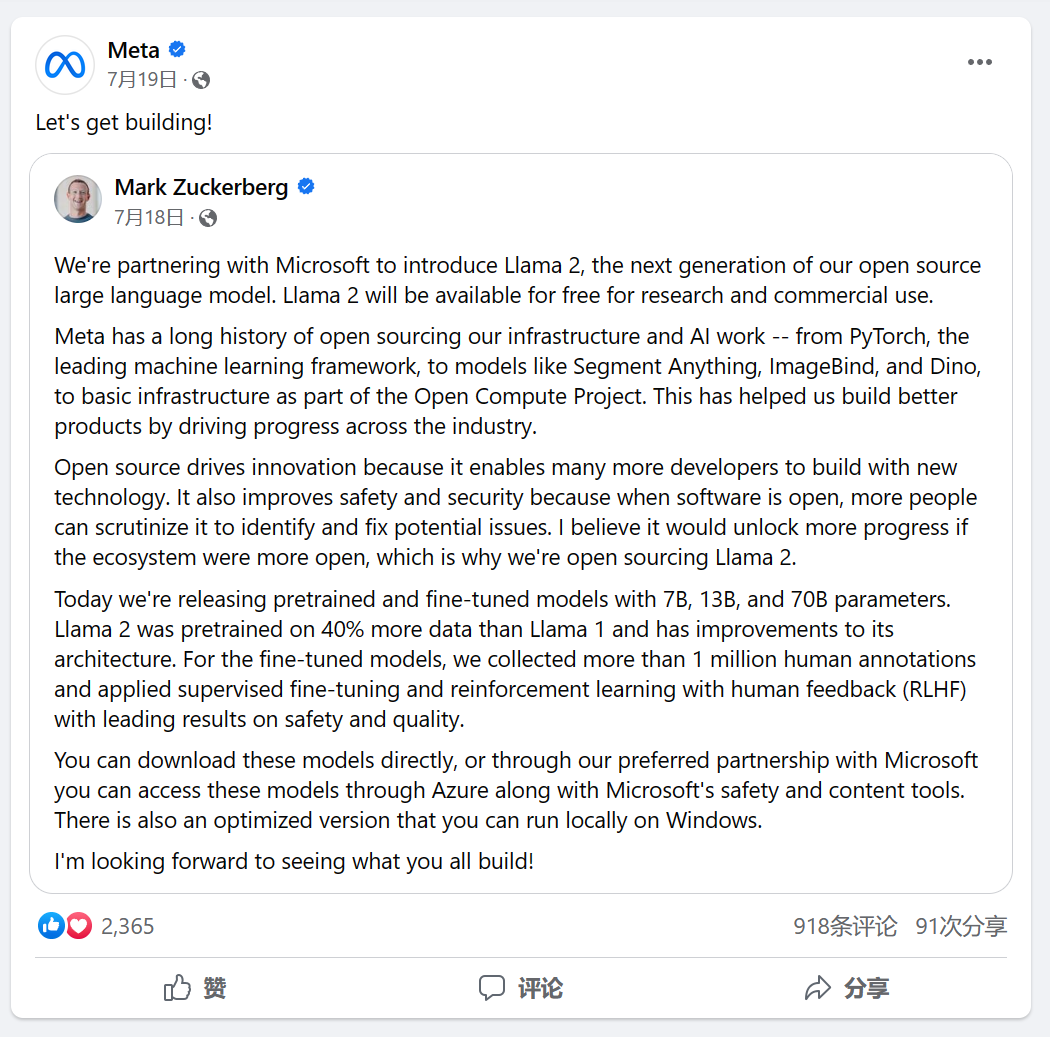

七月份Meta发布了免费可商用版本Llama 2:

扎克伯格在Facebook上发布的关于Llama 2的“宣言”

出处:facebook.com/Meta/posts/292330510122833/?paipv=0&eav=AfbtH-kmrhtprPvKxw8MMDfAkf0rUX57EDyRMGOekDEXxm6K1HXE27XTXB3hcRloxg4&_rdr

Llama 2 作为Llama大模型的延续,可免费用于研究和商业用途,该开源模型包括预训练和微调 Llama 语言模型(Llama Chat、Code Llama)的模型权重和起始代码 - 参数范围从 7B 到 70B。

根据Llama的官网介绍:

Llama 2 预训练模型接受了 2 万亿个标记的训练,上下文长度是 Llama 1 的两倍。其微调模型已经接受了超过 100 万个人类注释的训练。

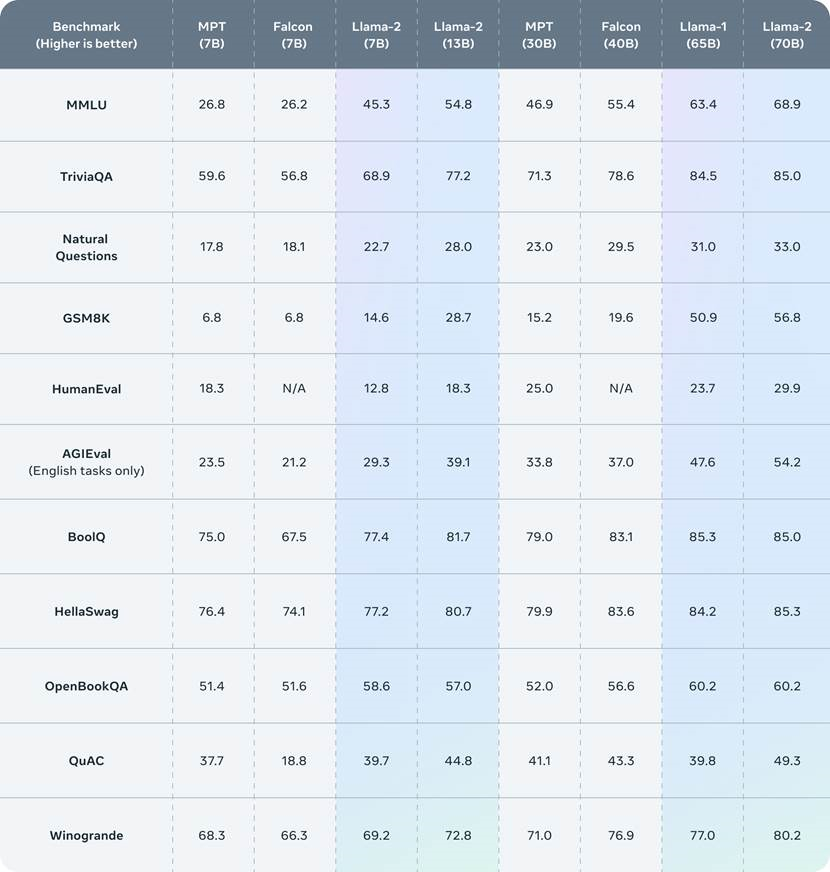

Llama 2 在许多外部基准测试中都优于其他开源语言模型,包括推理、编码、熟练程度和知识测试。

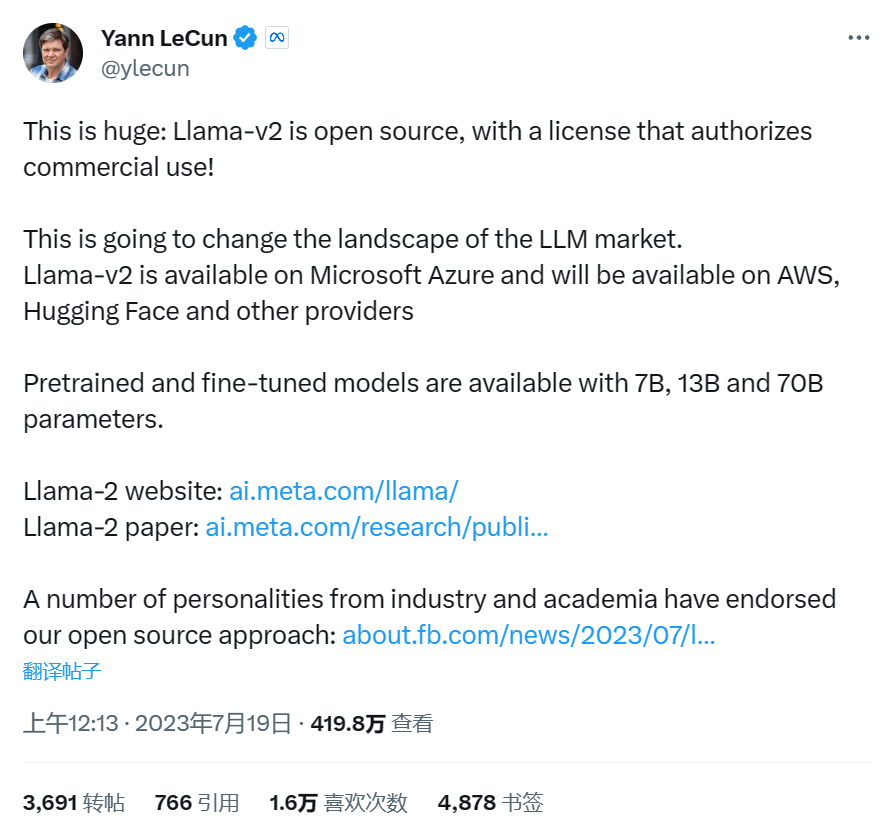

而对Llama 2的发布,深度学习三巨头之一Yann LeCun表示这将改变大模型的市场格局。

出处:twitter.com/ylecun/status/1681336284453781505

#2023 vol.9

Best Paper

Llama 2: Open Foundation and Fine-Tuned Chat Models

Hugo Touvron / Louis Martin / Kevin Stone / Peter Albert / Amjad Almahairi等

点击论文卡片即可一键直达小程序查看,感兴趣的论文可以收藏起来深度阅读;9月热门Paper推荐榜单都已为你准备好,点击标题即可跳转阅读;如果有你在读的paper上榜,别忘了留下宝贵评价~

#2023 vol.9

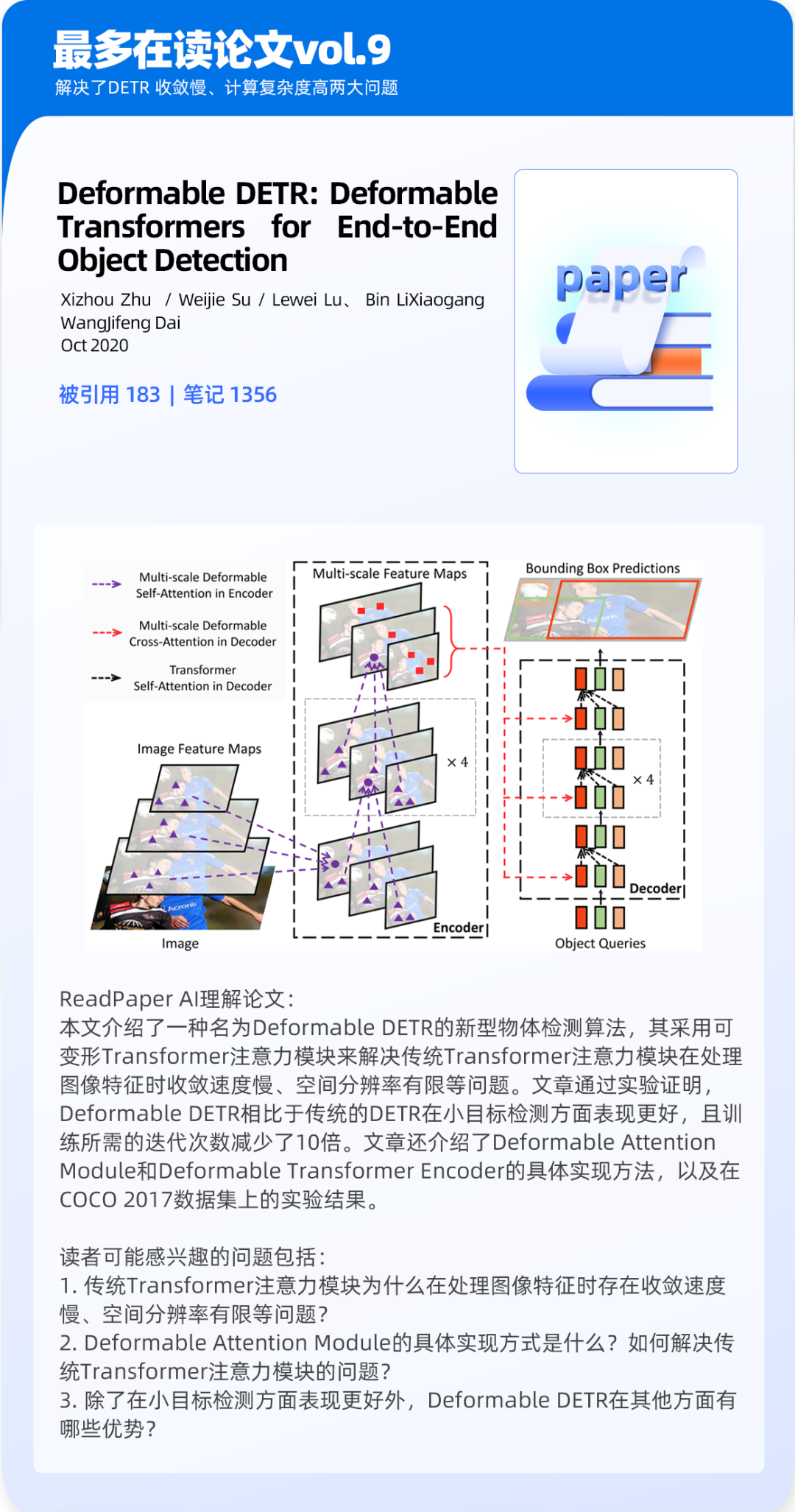

最多在读论文

Deformable DETR: Deformable Transformers for End-to-End Object Detection

Xizhou Zhu / Weijie Su / Lewei Lu / Bin LiXiaogang WangJifeng Dai

#2023 vol.9

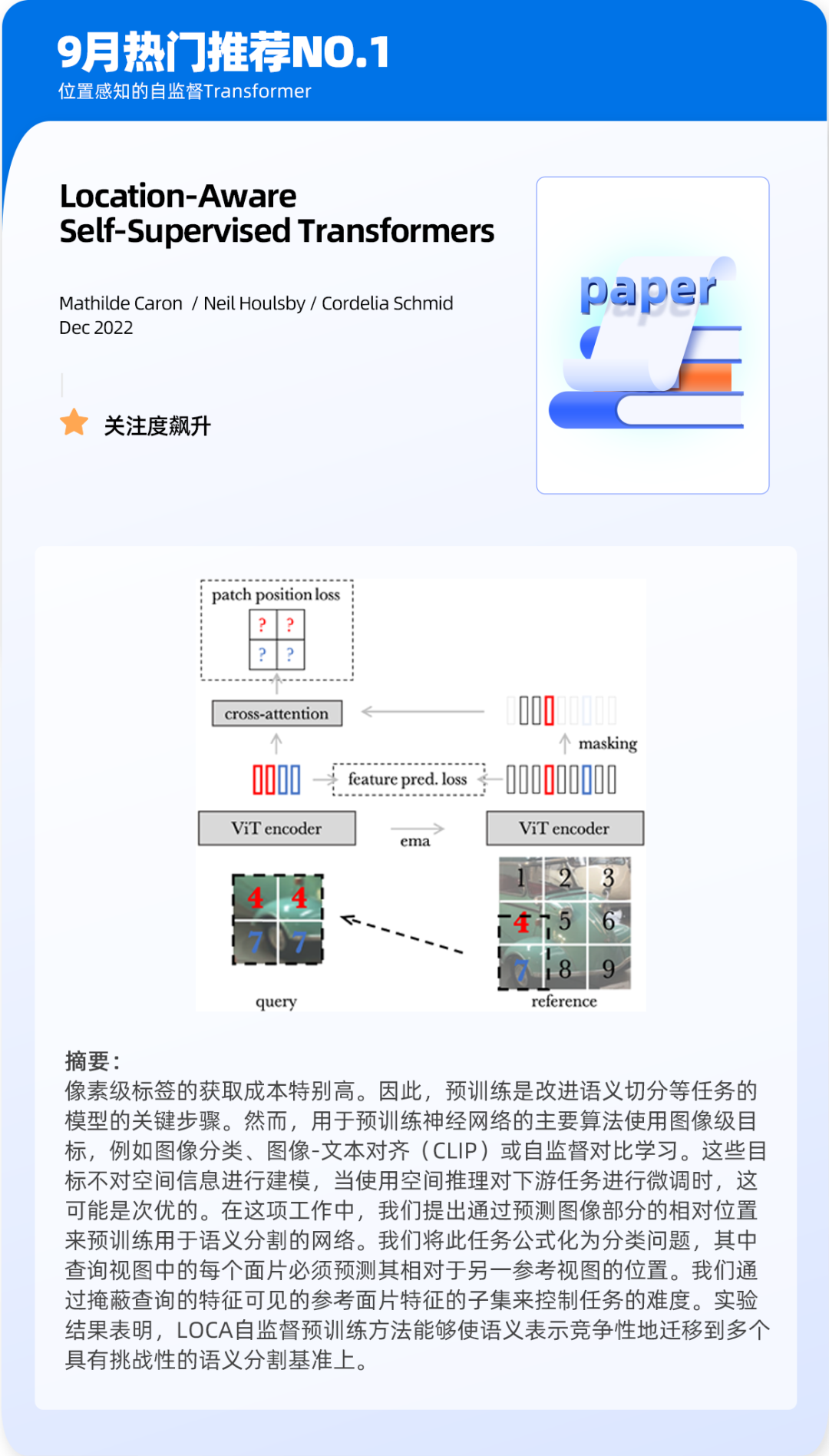

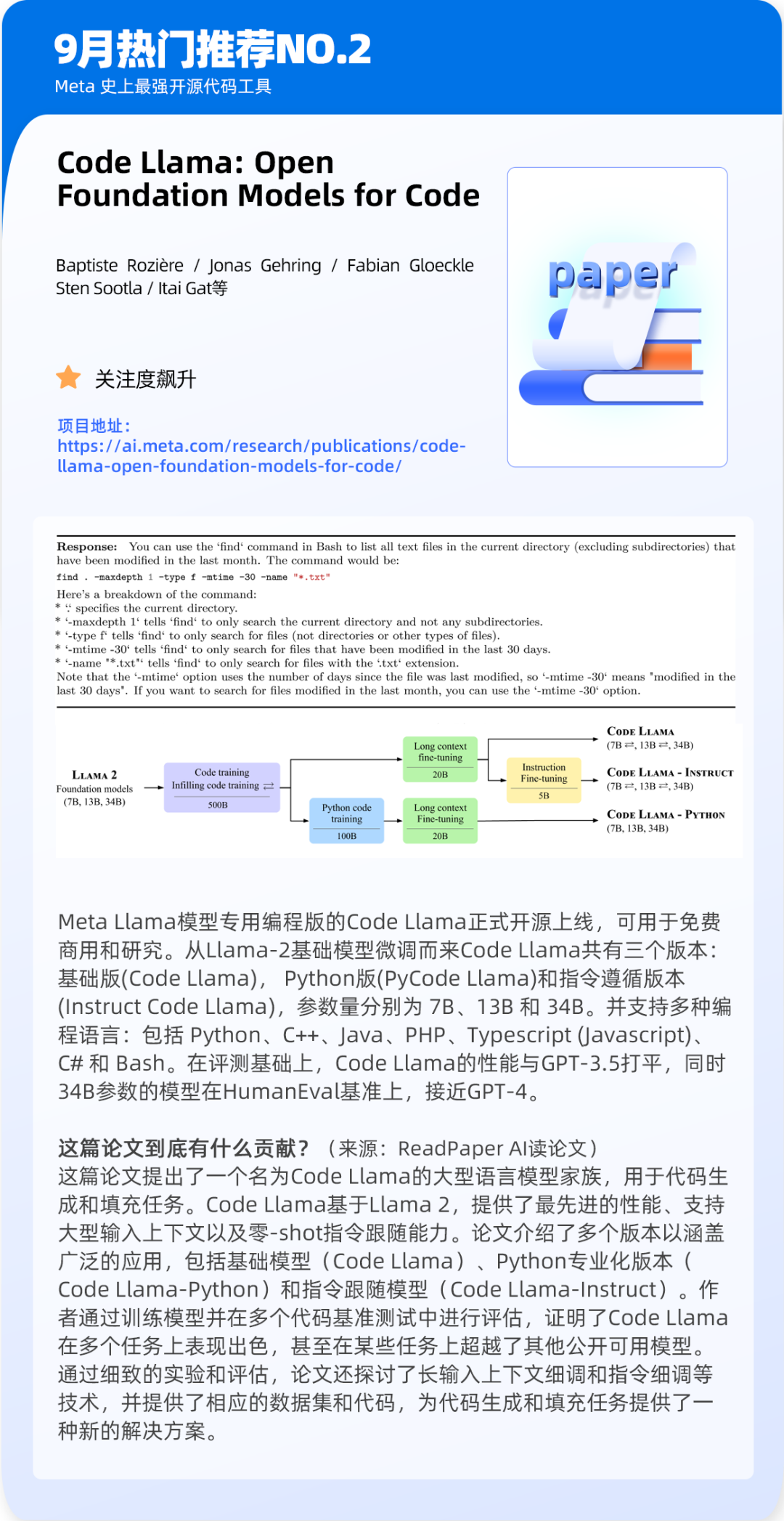

热门推荐 TOP5

Location-Aware Self-Supervised Transformers

Mathilde Caron / Neil Houlsby / Cordelia Schmid

Code Llama: Open Foundation Models for Code

Baptiste Rozière / Jonas Gehring / Fabian Gloeckle Sten Sootla / Itai Gat等

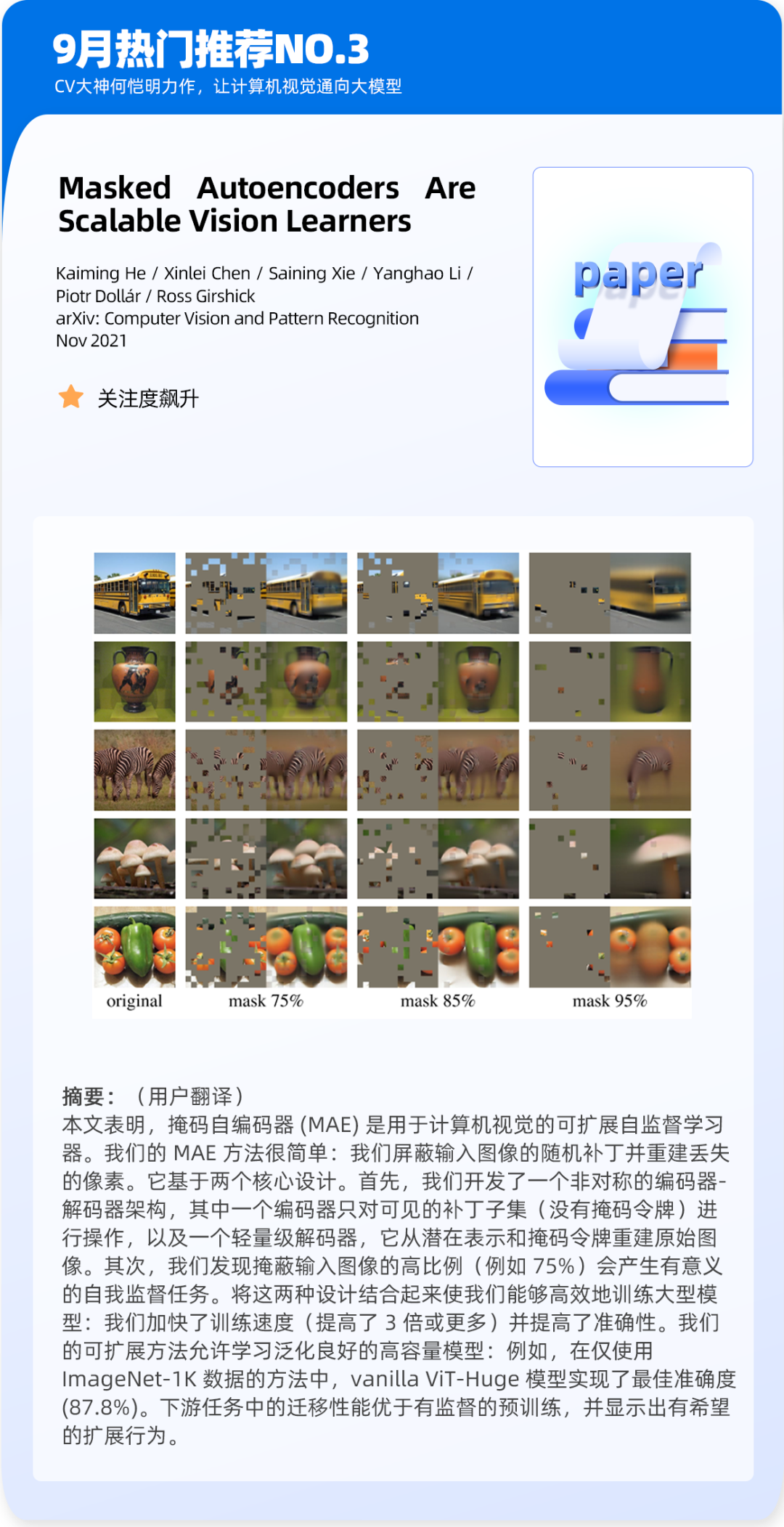

Masked Autoencoders Are Scalable Vision Learners

Kaiming He / Xinlei Chen / Saining Xie / Yanghao Li / Piotr Dollár / Ross Girshick

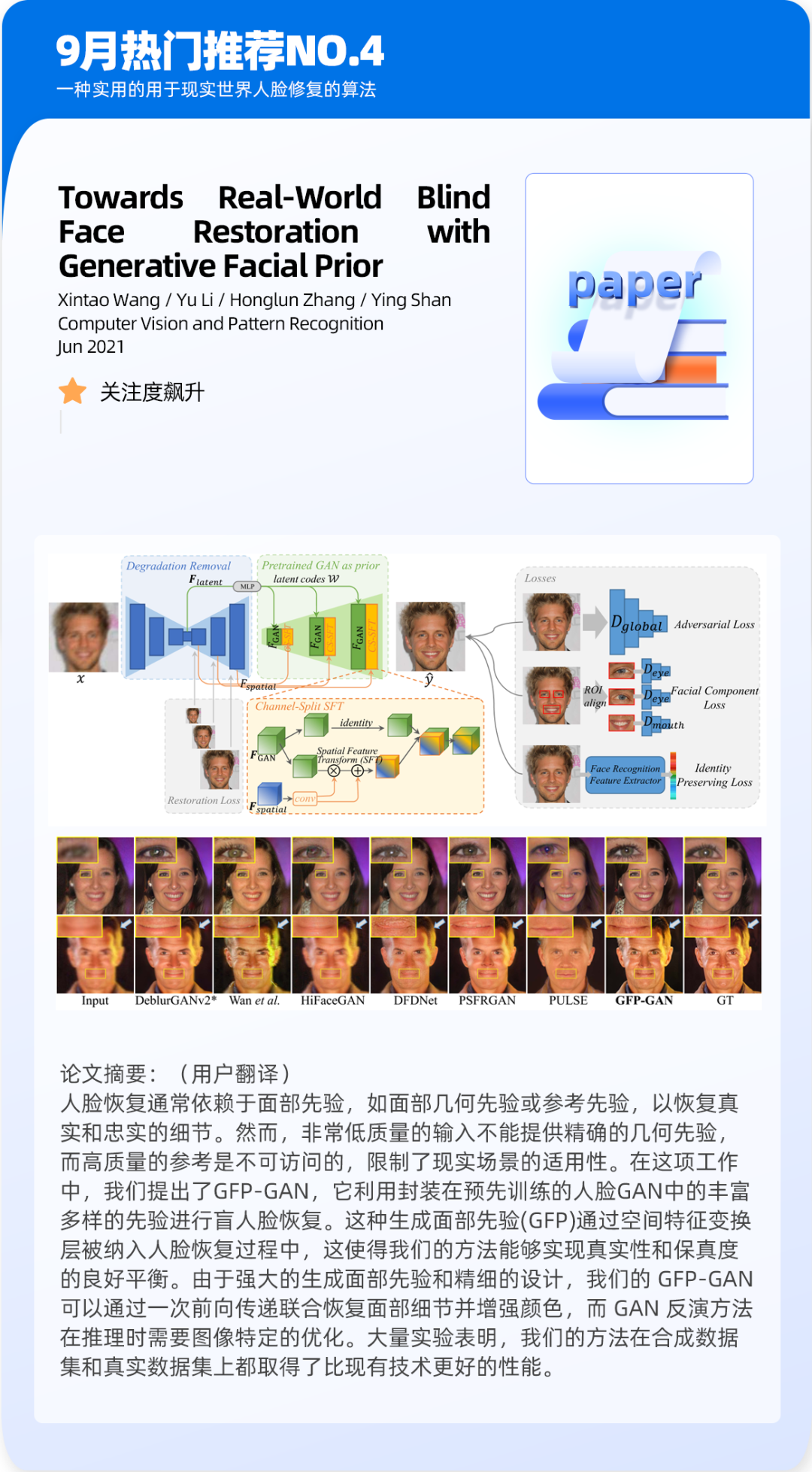

Towards Real-World Blind Face Restoration with Generative Facial Prior

Xintao Wang / Yu Li / Honglun Zhang / Ying Shan

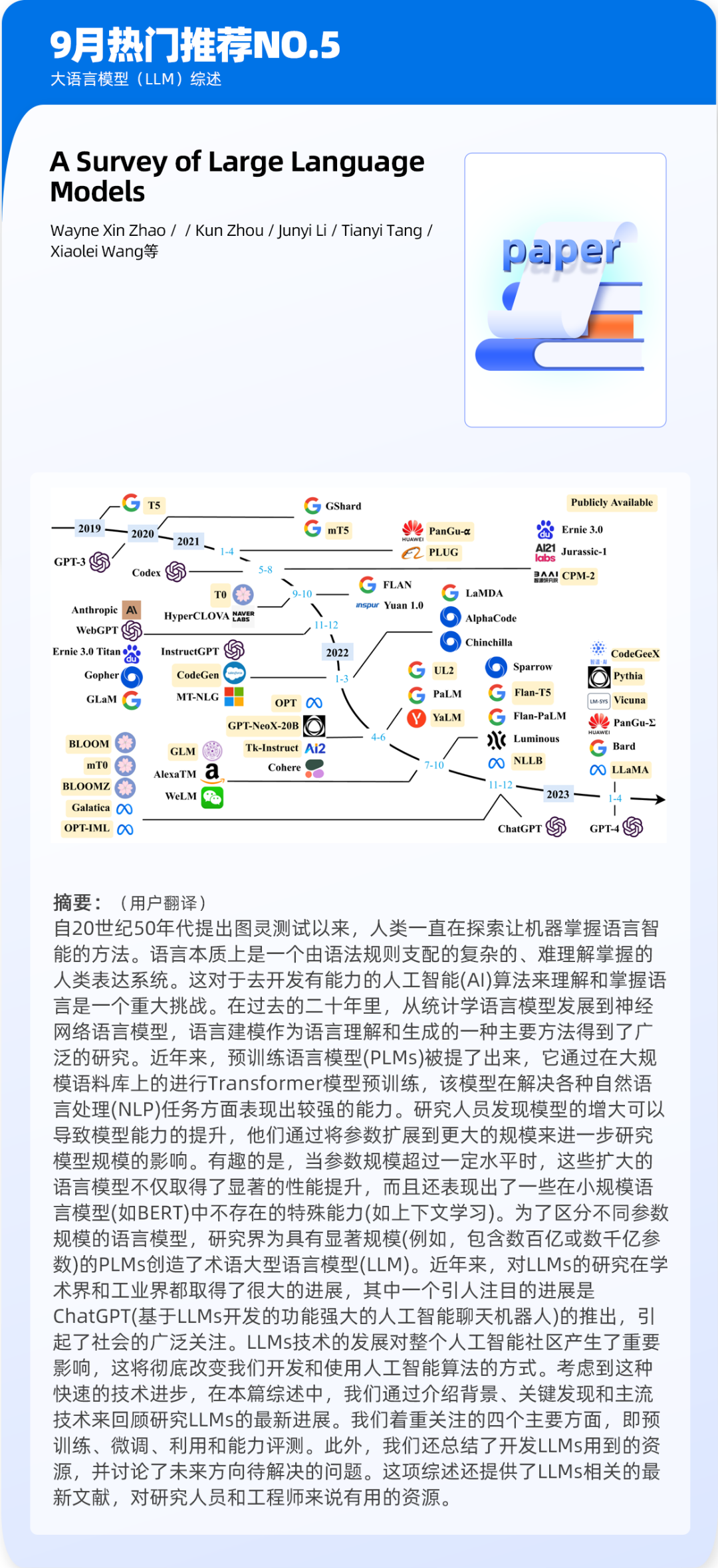

A Survey of Large Language Models

Wayne Xin Zhao / / Kun Zhou / Junyi Li / Tianyi Tang / Xiaolei Wang等

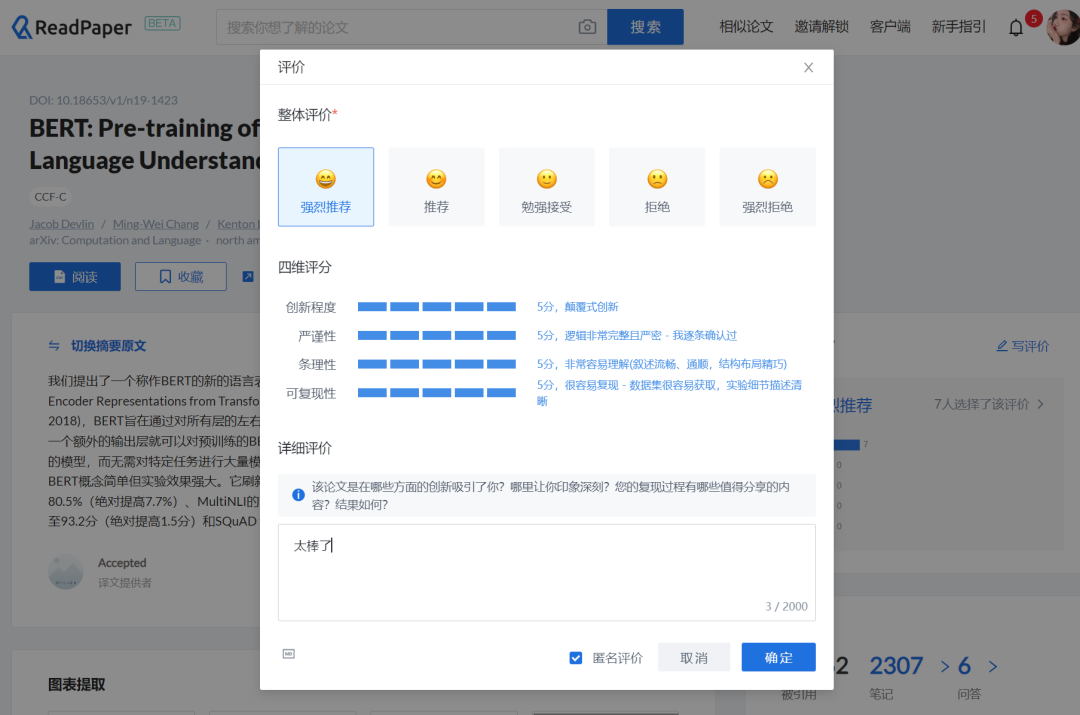

论文评审指南

1/ 打开你最近在读的论文,点击界面右侧“同行评审”👇

2/ 点击“写评价”,写下你对论文最真实的感受。点击提交即可!

ps:论文评选活动将在每个自然月月底统计评审信息,奖项将在次月月初公布。欢迎同学们参与评审!

如果你有想要推荐or强烈拔草的Paper,欢迎到ReadPaper官网留下你的评审!点击文末左下角“阅读原文”一键跳转,留下你的辛辣评论~

关于论文评审活动有疑问的同学,可添加小管家客服微信(ID:readpaper666)咨询,欢迎踊跃参与评审交流!

READ PAPER

专 业 的 学 术 讨 论 社 区

请扫描二维码添加小管家微信

(WeChat ID:readpaper666)

了 解 更 多 请 咨 询 小 管 家

平台官方账号,欢迎关注

微信小程序

抖音官方

bilibili 官方

知乎:ReadPaper论文阅读

小红书:ReadPaper论文阅读

↙点击 阅读原文 ,论文一键直达

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢