每一周,我们的同事都会向社区的成员们发布一些关于 Hugging Face 相关的更新,包括我们的产品和平台更新、社区活动、学习资源和内容更新、开源库和模型更新等,我们将其称之为「Hugging News」。本期 Hugging News 有哪些有趣的消息,快来看看吧!🎉

InferenceClient 现已全面支持各种推理任务,包括对象检测、文本分类、令牌分类等。此外,该版本还提供了两个新的辅助函数:list_deployed_models 和 get_model_status,用于获取 Inference API 服务上已部署模型的信息。

cli 功能也得到了显著的提升。用户现在可以使用 huggingface-cli download 和 huggingface-cli upload 命令方便地下载和上传文件。与 git 相比,这一新特性虽然功能较少,但在处理大型仓库时更为灵活。

Space API 也新增了几项功能,包括为 Space 请求持久存储、设置描述等。

查看详情或分享本资讯:huggingface_hub v0.17 现已发布。

我们已通过缓存恢复实现了高达 4 倍的构建速度提升,例如 6GB 的 Docker 缓存从先前的约 70 秒降低到 17 秒,目前仍有 3 倍的速度提升空间,我们会进一步优化。

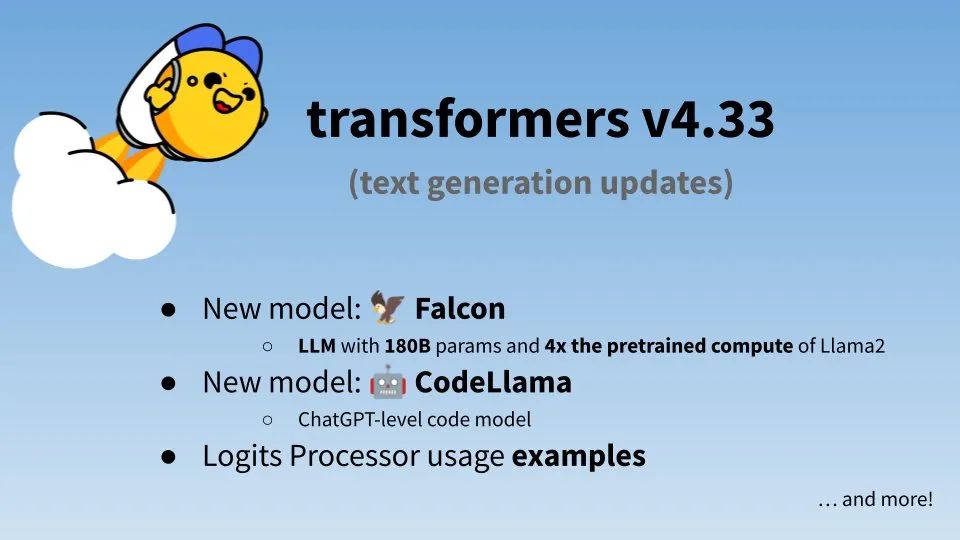

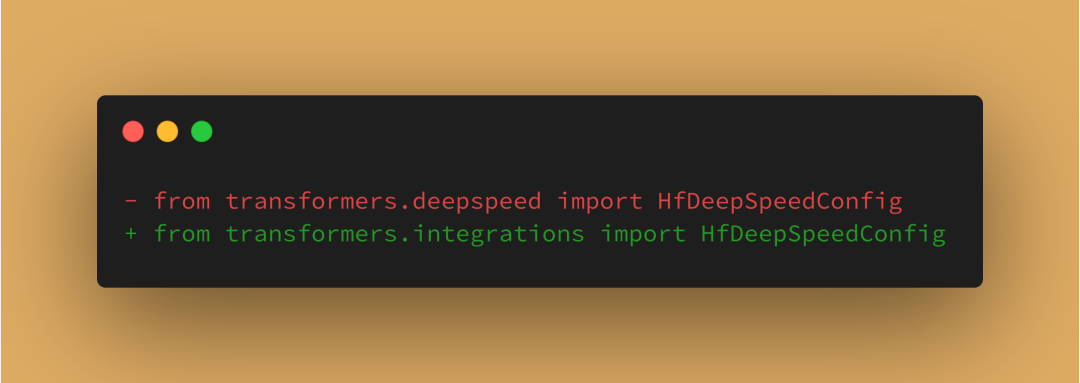

加入了 Falcon、Code Llama、ViTDet、DINO v2、VITS 等新模型的支持,有一个破坏性变更需要大家注意:所有与非 Hugging Face 生态系统相关的实用工具文件,现已移动至 integrations/ 文件夹,代码上需要做这样的改动:

最新的 v4.33.2 版本修复了一些 bug,提升了性能。

这个版本我们新增了 14 个模型架构:BLOOM、MPT、BeiT、CamemBERT、CodeLlama、GPT NeoX、GPT-J、HerBERT、mBART、mBART-50、OPT、ResNet、WavLM 和 XLM,使得支持的架构总数达到了 46 个。发布了超过 150 个新的优化过的模型,覆盖各种新架构。模型尺寸大幅度减小,最高可减小 40%,例如 Whisper-tiny 解码器从 50MB 减少到 30MB。

查看详情或分享本资讯:Transformers.js v2.6 现已发布。

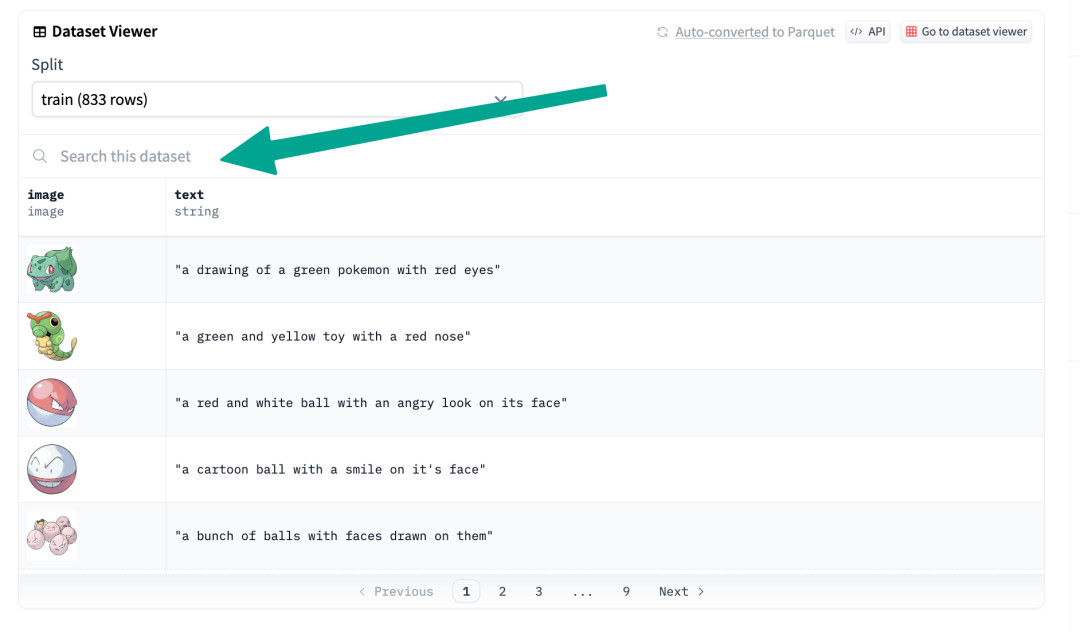

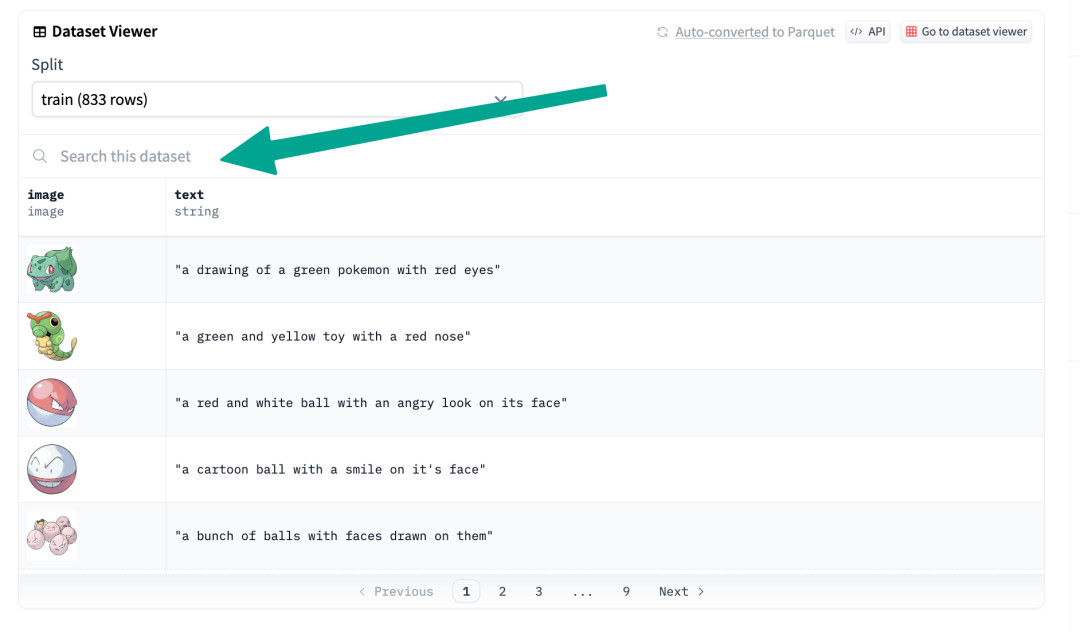

告别无尽的滚动,迎接全文搜索功能 🔎Hub 上的数据集现已经支持搜索功能,你可以在数据集里搜索你想要的特定内容,你可以在任意数据集最上方找到搜索框输入搜索内容:

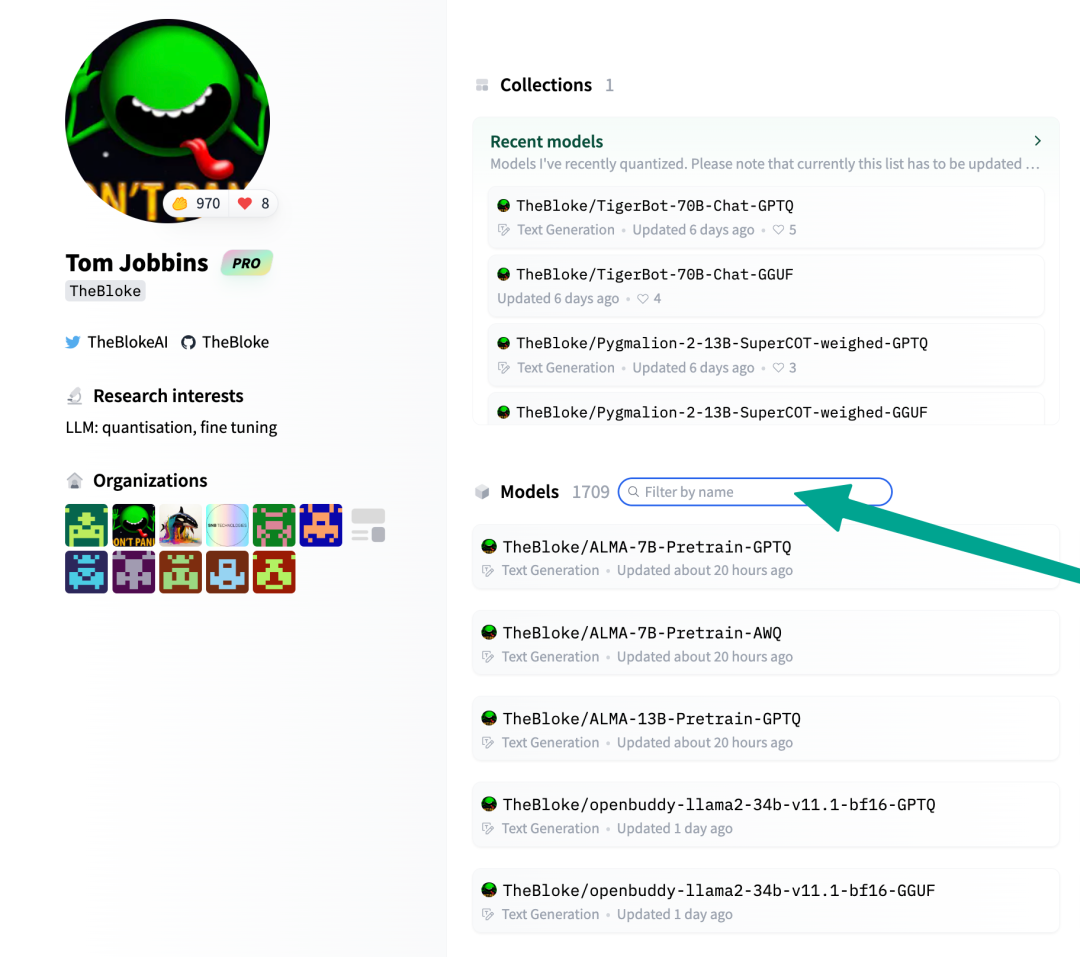

我们在 Hub 的个人资料页面上线了一个小的搜索按钮,现在你可以在用户个人资料页面通过 🔍 通过名字过滤 Ta 的模型:

以上就是本期的 Hugging News,还有几天就能放长假啦!😍

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢