导语

概述

概述

近期AI领域最热门的方向,AI for science中,有许多研究工作,都用到了图神经网络。本文简要介绍图神经网络的概念与分类,最后介绍一个图神经网络的在AI for science中典型应用。

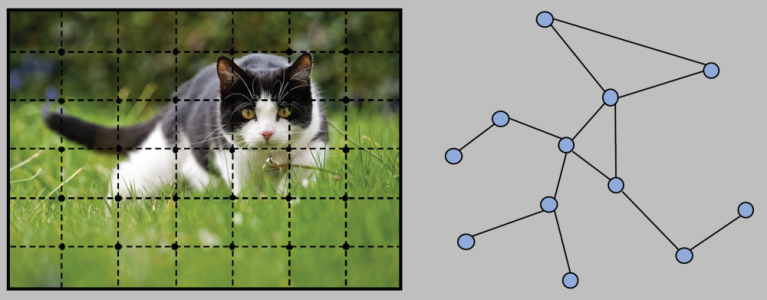

深度神经网络在计算机视觉和自然语言处理领域取得了巨大的成功。常用的深度神经网络,如卷积神经网络,在处理欧式结构的数据方面表现出色。然而,对于图结构的数据,如社交网络中的人际关系、化学中的分子相互作用、三维点云数据以及数据中各个单元之间的结构,情况就变得复杂了。这些数据不再按照欧式空间中的有序排列,而是呈现出无序的分布。在这种情况下,传统的神经网络算子不再适用。

近年来,研究人员借鉴了卷积神经网络、循环神经网络和深度自编码器的思路,设计了专门用于处理图结构数据的神经网络,称之为图神经网络(Graph Neural Network,简称GNN)。这一创新使得神经网络这一强大工具能够有效地应用于处理各种图结构的数据。

图数据是由节点(nodes)和边(edges)组成的数据结构,通常用于表示各种关系和网络,如社交网络、知识图谱、分子结构、交通网络等。GNNs的目标是从这些图数据中学习有关节点和边的信息,以便进行各种任务,例如节点分类、图分类、链接预测等。

图神经网络分类

图神经网络分类

图神经网络可以大致分为一下几类:

1.Recurrent graph neural networks (RecGNNs) 递归图神经网络

RecGNNs旨在使用递归神经结构学习节点表示。它们假设图中的一个节点不断与其邻居进行信息/消息交换,直到达到稳定的平衡状态。RecGNNs在概念上非常重要,对后续对卷积图神经网络的研究有一定的启发作用。后来的卷积图神经网络继承了其中的消息传递的理念。

2.Convolutional graph neural networks (ConvGNNs) 图卷积神经网络

图卷积神经网络将卷积的概念从欧式结构的数据扩展到图结构的数据。图卷积的基本思路是聚合一个节点周围节点的特征,用以生成该节点自身的特征。图卷积网络堆叠了多个“图卷积层”,用来提取各个节点的高层次信息。图卷积神经网络具体分为谱方法(Spectral methods)和空间方法(Spatial methods)。谱方法的卷积操作依赖于图的拉普拉斯矩阵的特征值和特征向量。空间方法的卷积则直接在图的邻域上进行。

3.Graph autoencoders (GAEs) 图自编码器

图自编码器是一种无监督的学习方式。它将图编码成一个隐式向量,通过编码信息来重建图中的数据。图自编码器用于学习网络中的嵌入,以及生成图的生成式分布。图自编码器被广泛应用于社交网络分析、生物信息学和推荐系统中。通过学习有效的图表示,图自编码器有助于对复杂关系数据的理解和应用。

4.Spatial-temporal graph neural networks (STGNNs) 时空图神经网络

时空图神经网络用于从时空图中,学习隐藏的模式。时空数据通常是指具有时间和空间维度的数据,例如移动物体的轨迹、气象数据、交通流量等。这些数据通常以图的形式表示,其中节点代表地点或实体,边代表时空关系。时空图可以是有向的或无向的,具体取决于应用场景。ST-GNN的关键任务是建模时空数据中的动态关系。它可以通过不同的方式来处理时空数据,例如通过对每个时刻的快照建立图,或者通过在图上引入时间信息来捕捉动态性。这使得ST-GNN能够在时间上进行推理和预测。ST-GNN学习每个节点的表示,使得这些表示包含了节点的属性信息以及与其他节点的时空关系。这有助于对节点进行时空上的预测或分类。ST-GNN在许多应用领域都有广泛的应用,包括交通管理(交通流量预测、路径规划)、气象预测、地理信息系统(GIS)、社交网络分析等。在这些领域中,ST-GNN可以帮助理解时空数据中的模式、趋势和异常。

关键概念与工作原理

关键概念与工作原理

图神经网络中一些关键概念和工作原理如下:

节点表示(Node Embeddings):GNN的主要任务之一是学习每个节点的表示(或称嵌入)。这些表示通常是一个固定维度的向量,用于捕捉节点的特征。GNN通过聚合节点的邻居节点信息来更新节点表示。这个过程在每个图卷积层中迭代进行。

图卷积(Graph Convolution):图卷积是GNN中的核心操作。在每一层,它会考虑节点的邻居信息,并使用权重来聚合这些信息以更新节点的表示。这使得节点能够捕捉到周围节点的信息,从而改善对节点的分类或预测任务。

聚合函数(Aggregation Function):在图卷积中,节点邻居的信息被聚合成一个新的节点表示。常见的聚合函数包括求和、平均值、最大值等。不同的聚合函数可以用于不同的任务和图结构。

图池化(Graph Pooling):类似于卷积神经网络中的池化操作,图池化用于减小图的规模和复杂性。它可以通过合并节点或边来减小图的大小,以便在后续层中处理更抽象的信息。

任务层(Task Layer):GNN通常最后会连接一个任务层,用于执行具体的任务,如节点分类、图分类、链接预测等。任务层的结构取决于所解决的任务类型。

反向传播(Backpropagation):与其他深度学习模型一样,GNN使用反向传播算法来更新模型参数,以最小化损失函数。这使得模型能够从训练数据中学习,并提高其性能。

应用:建模粒子相互作用

应用:建模粒子相互作用

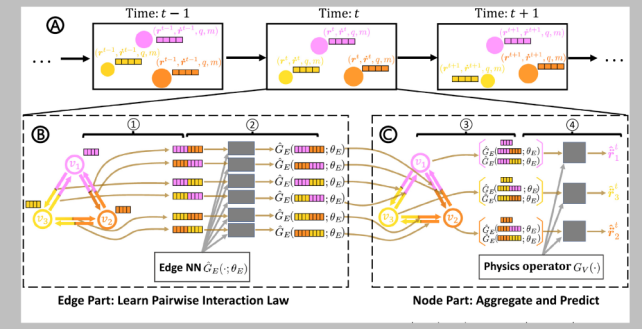

图神经网络的一个重要应用是对物理世界进行建模。将物理世界中,个体与个体之间的关系表示为图,可以通过图神经网络,对现实世界中复杂系统的行为,进行推断。

下面,我们以2022年发表在 PNAS上的一篇论文 Learning physics-consistent particle interactions [4]为例, 来说明图神经网络,是如何建模物理世界的。

该文用图神经网络框架,模拟物理世界中,粒子之间的相互作用。现实世界中粒子的相互作用具有高度复杂性,难以通过人为设计精确建模,借助图神经网络,利用数据驱动的思路,可以对复杂的物理世界进行准确建模。

图 神经网络建模粒子运动[4]

该文的工作,成功将图神经网络,应用到物理世界的建模推断中,即利用了数据驱动的方法,又满足了物理规律的约束,值得借鉴学习。

图神经网络与组合优化读书会进行中

推荐阅读

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢