新智元报道

新智元报道

【新智元导读】就在刚刚,美国再次收紧对我国出口尖端AI芯片,英伟达A100、A800、H100、H800等无一幸免。

30天内,立即生效!

根据美国商务部下发的文件,禁令将在30天内生效。 同时,雷蒙多还表示,以后法规可能会至少每年更新一次。

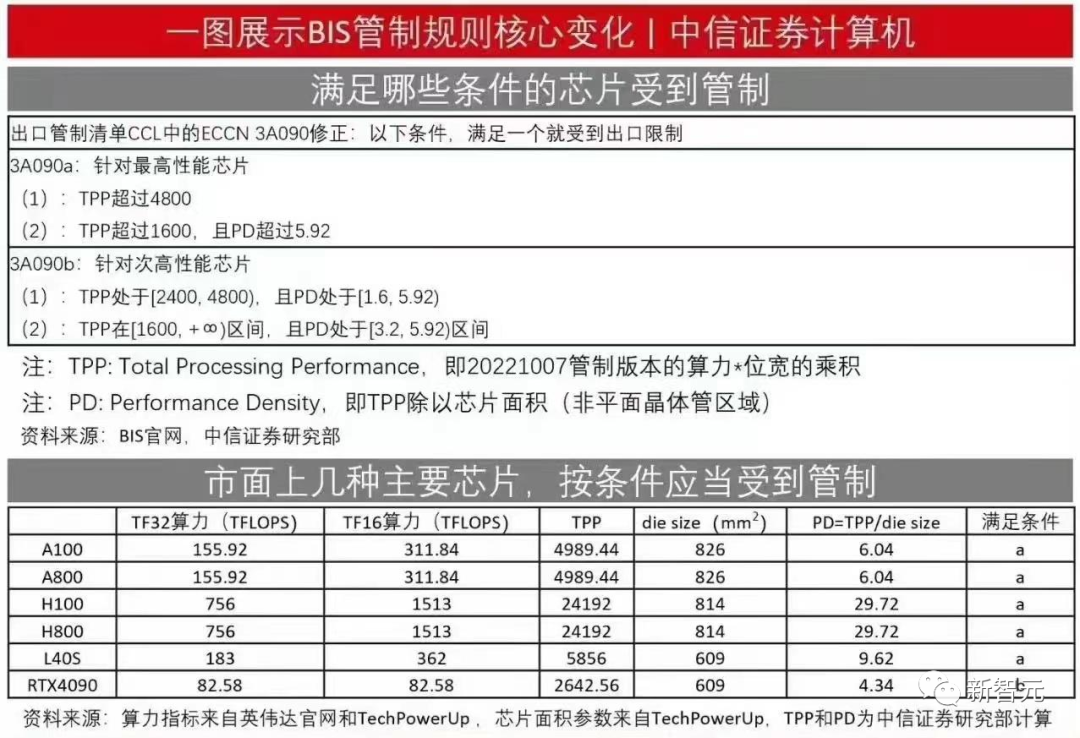

总算力低于300 TFLOPS,且每平方毫米370 GFLOPS以下

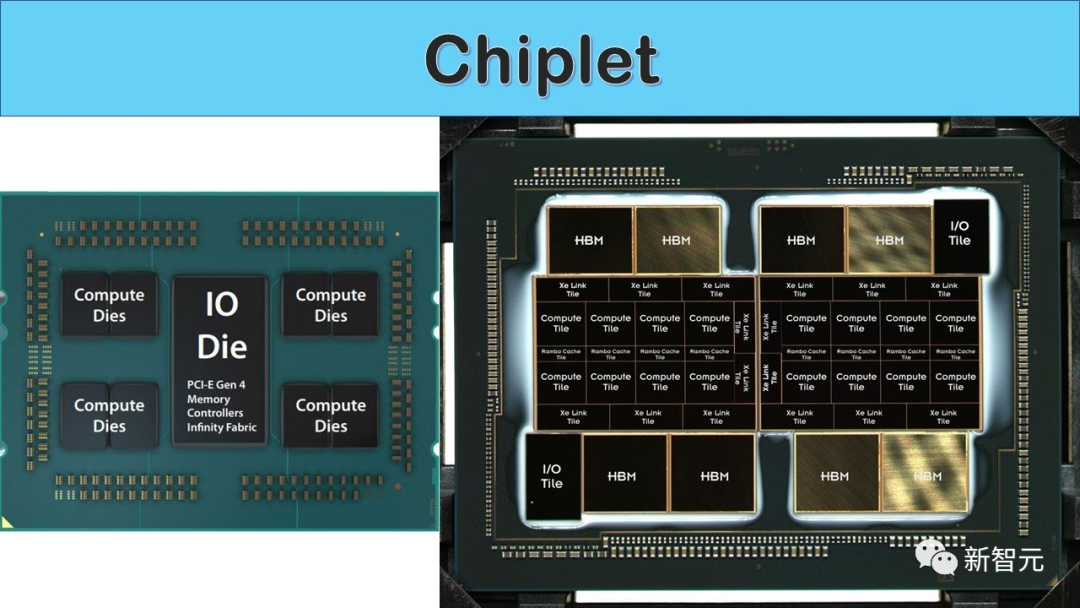

堵住Chiplet漏洞

中国GPU企业,通通列入黑名单

芯片工厂的危险信号

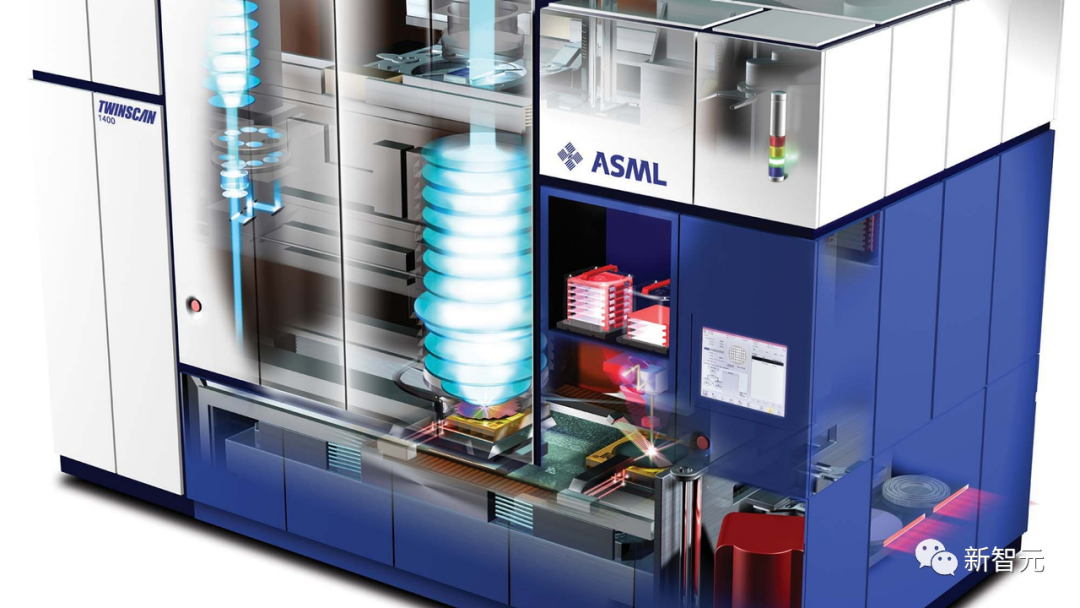

DUV光刻机也受限

美国还将先进芯片的出口许可证要求增加到22个国家。 管制范围也扩大到最终母公司总部设在上述国家的任何公司,以防止境外子公司购买违禁芯片。 美国还对其余21个国家提出了芯片制造工具的许可要求,担心这些设备可能被转移到中国。 荷兰的DUV光刻系统也受到了限制,以防止ASML向中国的芯片工厂运输一些较旧的DUV型号和配件。 DUV设备比不上最先进的EUV设备,但它可以以更高的成本制造芯片。而EUV早已全面被禁。

大厂囤货:10万块A800,今年交付

大厂囤货:10万块A800,今年交付

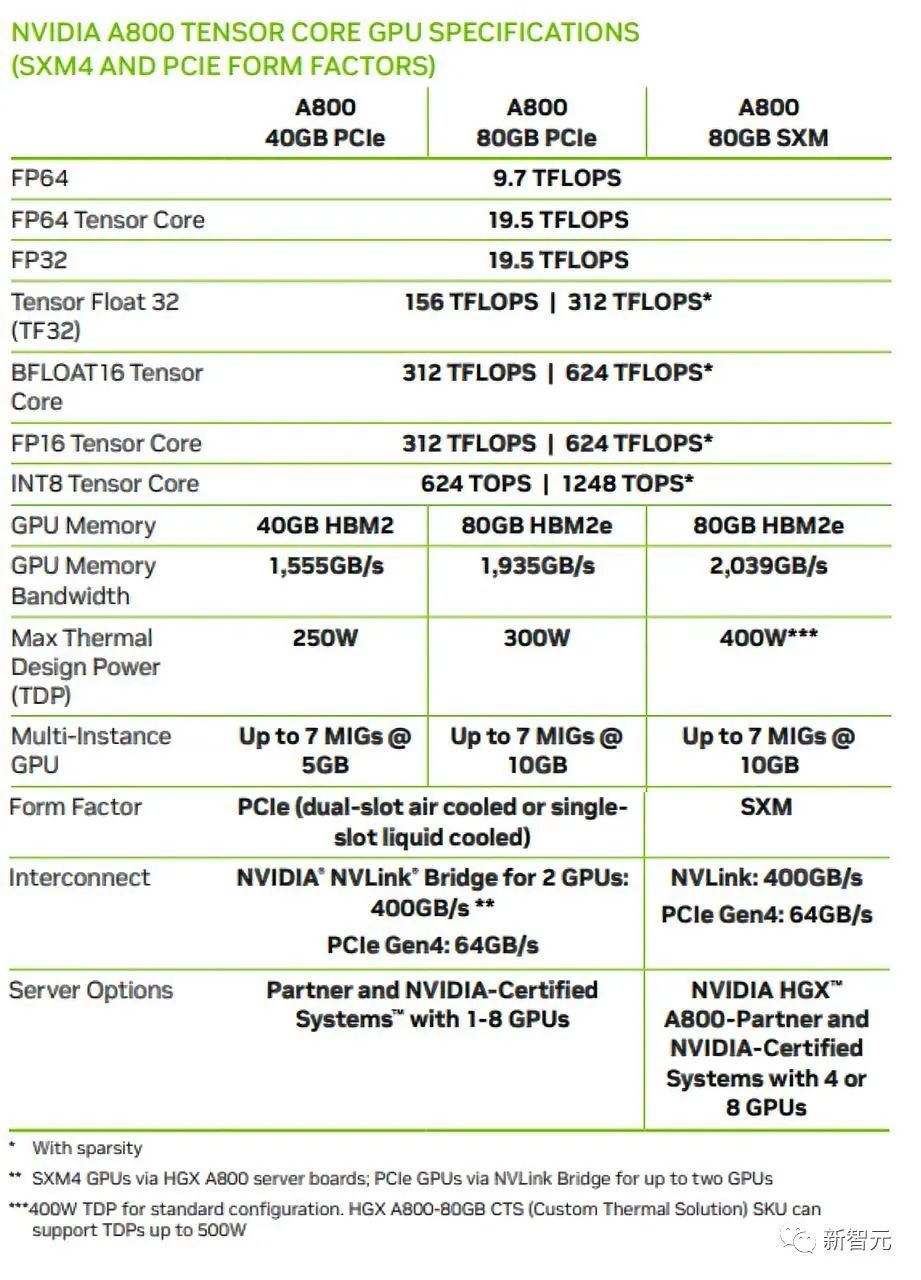

对于国内互联网巨头来说,现在手里还有多少存货? 目前,这一具体数额未知。不过,国内大厂刚刚发声:我们囤得够了。 前段时间,外媒FT曾报道称,国内互联网大厂竞相订购了价值约50亿美元的英伟达芯片。 据介绍,百度、字节、腾讯、阿里已经向英伟达下单A800,价值10亿美元,共10万块芯片,将于今年交付。 另外,还有40亿美元GPU订单,也将于2024年交付。

两位内部人士透露,字节已经储备了至少1万个英伟达GPU来支持各种生成式人工智能产品。 他们补充道,该公司还订购了近7万个A800芯片,将于明年交付,价值约7亿美元。 英伟达在一份声明中表示,「消费者互联网公司和云提供商,每年在数据中心组件上投资数十亿美元,而且往往提前数月下单。」 今年早些时候,随着全球生成式AI的不断推进,据国内科技公司的内部人表示,大多数中国互联网巨头可用于训练大型语言模型的芯片库存不到几千个。 自那以来,随着需求的增长,这些芯片的成本也在增长。一位英伟达分销商表示,「分销商手中的A800价格上涨了50%以上」。

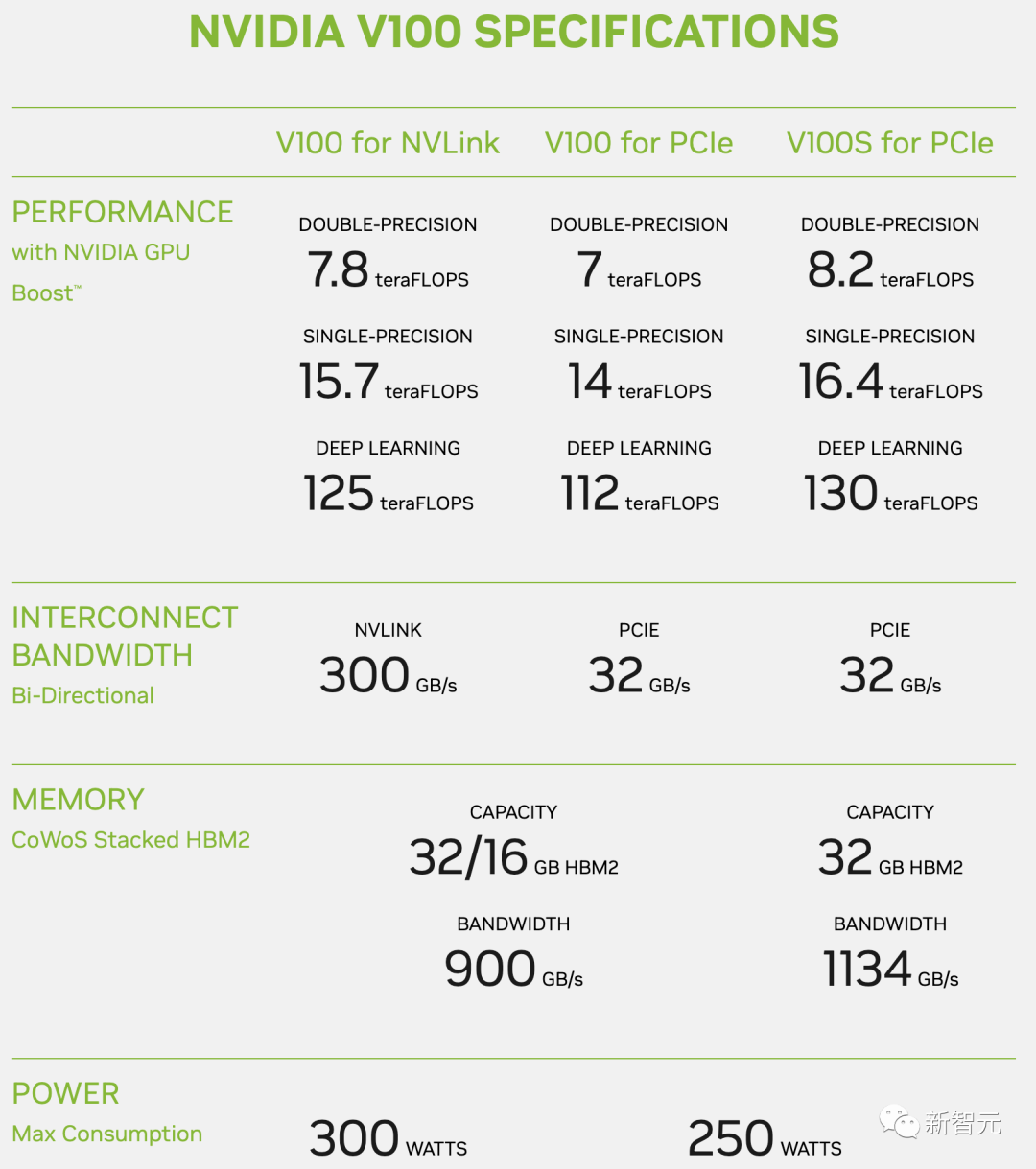

训练大模型,用什么芯片?

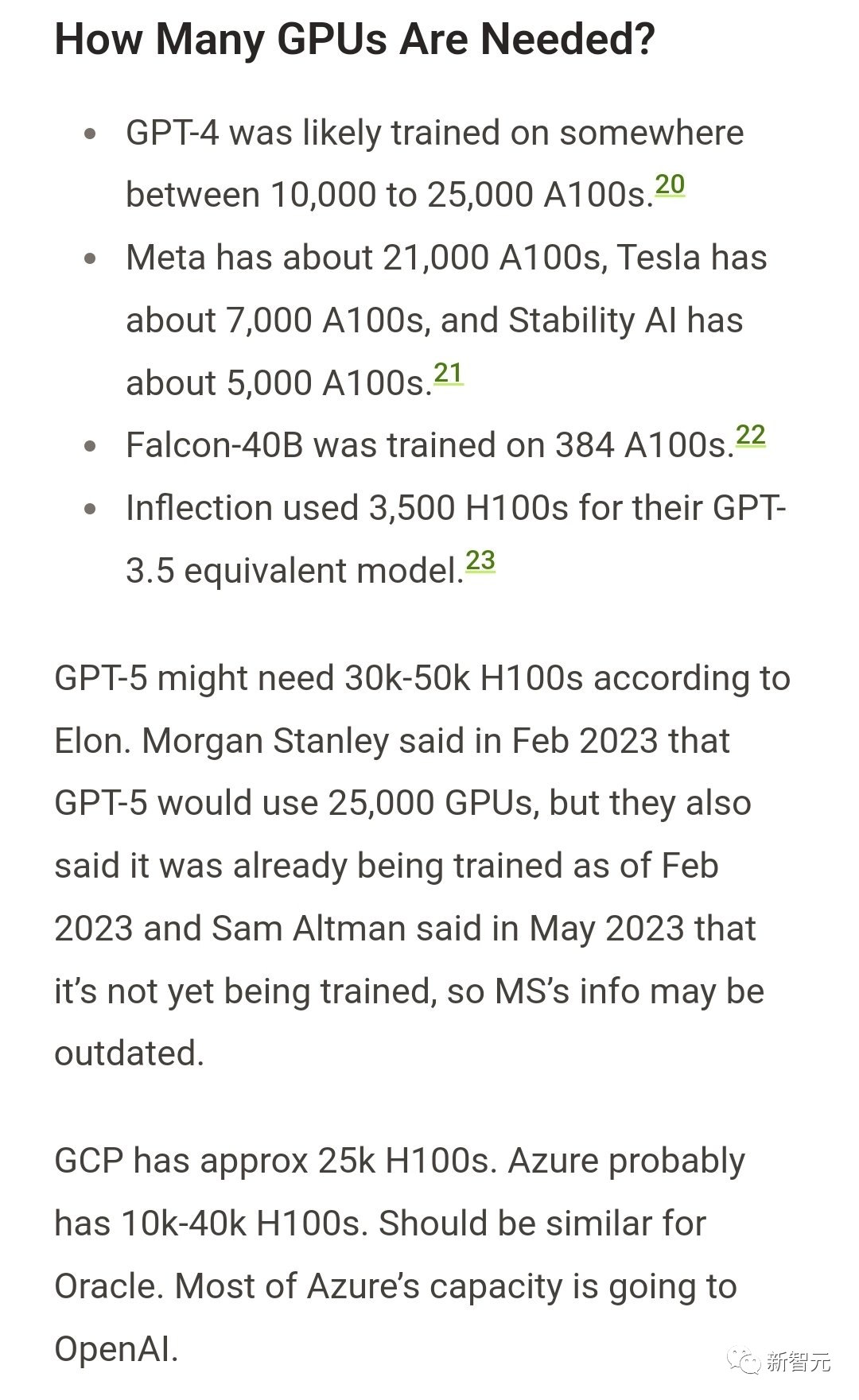

从年初至今,业界纷纷发展自家的大模型,通常对标的是「地表最强」GPT-4模型。 此前爆料称,GPT-4采用的是MoE架构,由8个220B模型组成,参数量达1.76万亿。 这一参数量已经让许多人望尘莫及,对算力的消耗已经是最大极限。 具体来说,OpenAI训练GPT-4的FLOPS约为2.15e25,在大约25000个A100上训练了90到100天,利用率在32%到36%之间。

那么,对于下一代模型,人们口中的「GPT-5」,对算力又将有多大的需求? 此前,摩根士丹利曾表示,GPT-5将使用25000个GPU,自2月以来已经开始训练,不过Sam Altman之后澄清了GPT-5尚未进行训。 另根据马斯克的说法,GPT-5可能需要30000-50000块H100。

这意味着,如果科技大厂想要进一步推进大模型的迭代升级,还需要极大的算力支持。 对此,英伟达首席科学家Bill Dally曾表示:「随着训练需求每6到12个月翻一番,这一差距将随着时间的推移而迅速扩大。」 参考资料: https://www.ft.com/content/be680102-5543-4867-9996-6fc071cb9212 https://www.reuters.com/technology/how-us-will-cut-off-china-more-ai-chips-2023-10-17/

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢