Context-Aware Meta-Learning

C Fifty, D Duan, R G. Junkins, E Amid, J Leskovec, C Ré, S Thrun

[Stanford University]

上下文感知元学习

要点:

-

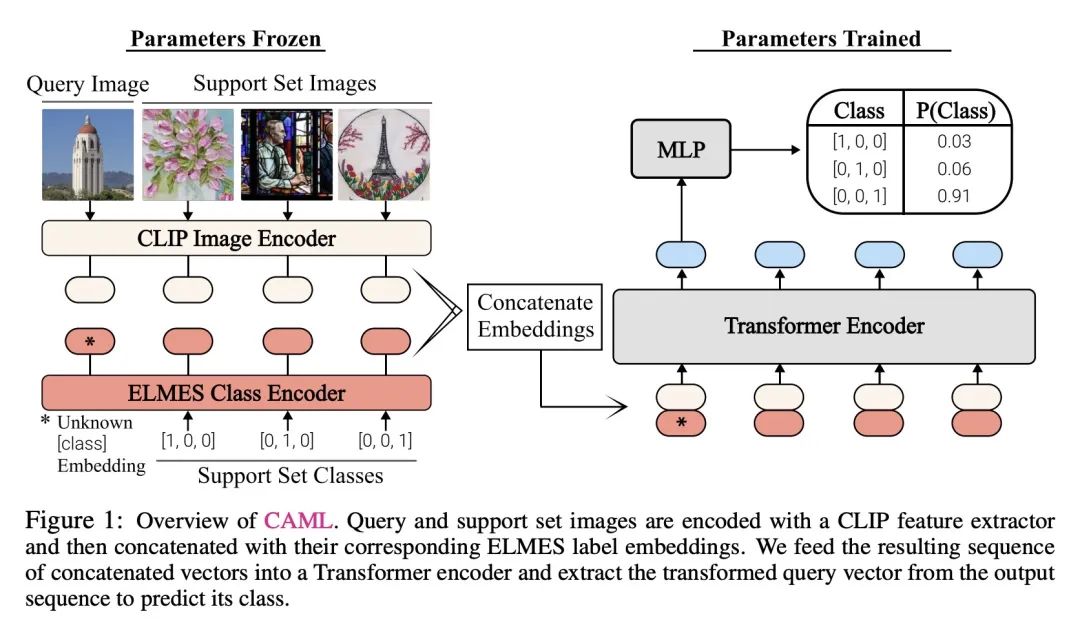

提出一种称为Context-Aware Meta-Learning (CAML)的元学习算法,可以在推理时学习新的视觉概念,而不需要像以前的元学习算法那样进行微调。 -

CAML将元学习任务建模为一个序列建模问题,其中输入序列由支持集图像和标签以及查询图像组成。Transformer编码器被训练来从这种上下文中预测查询标签。 -

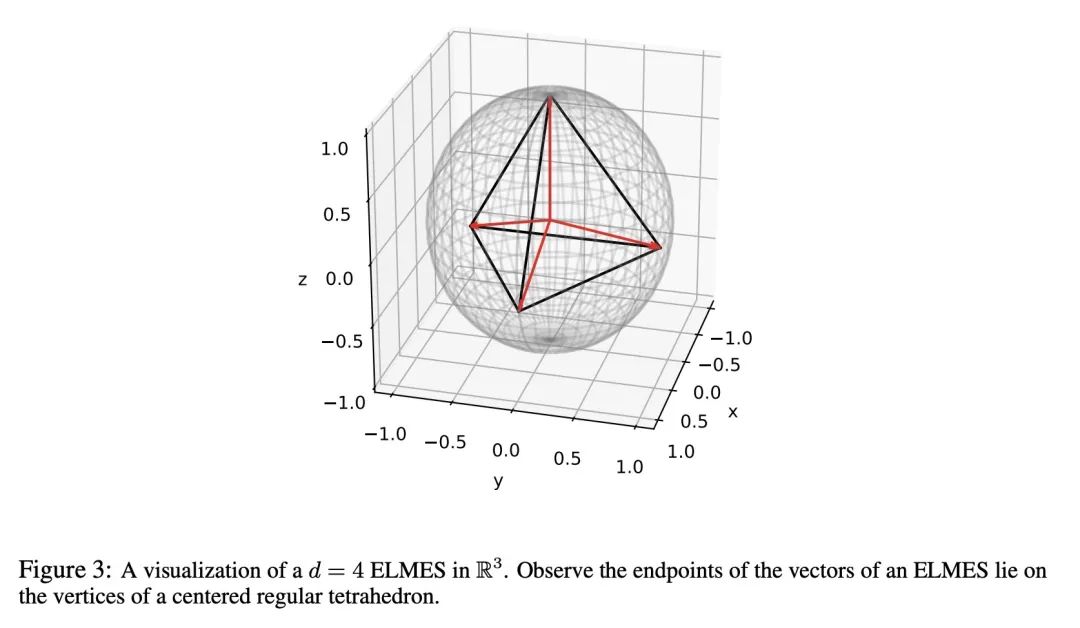

支持集标签使用等长最大角度集(ELMES)编码进行编码,证明了这种编码方式可以最小化检测支持集内类的熵。 -

CAML利用预训练的CLIP模型作为固定的特征提取器,仅训练Transformer编码器的参数。在ImageNet、COCO等数据集上进行大规模预训练,而不在少样本基准测试集上进行元训练。 -

从经验上来看,在不进行任何元训练或微调的情况下,CAML在11个基准测试集中的8个上匹配或超过了最先进的元学习方法。它展示了从上下文中学习新视觉概念的能力。 -

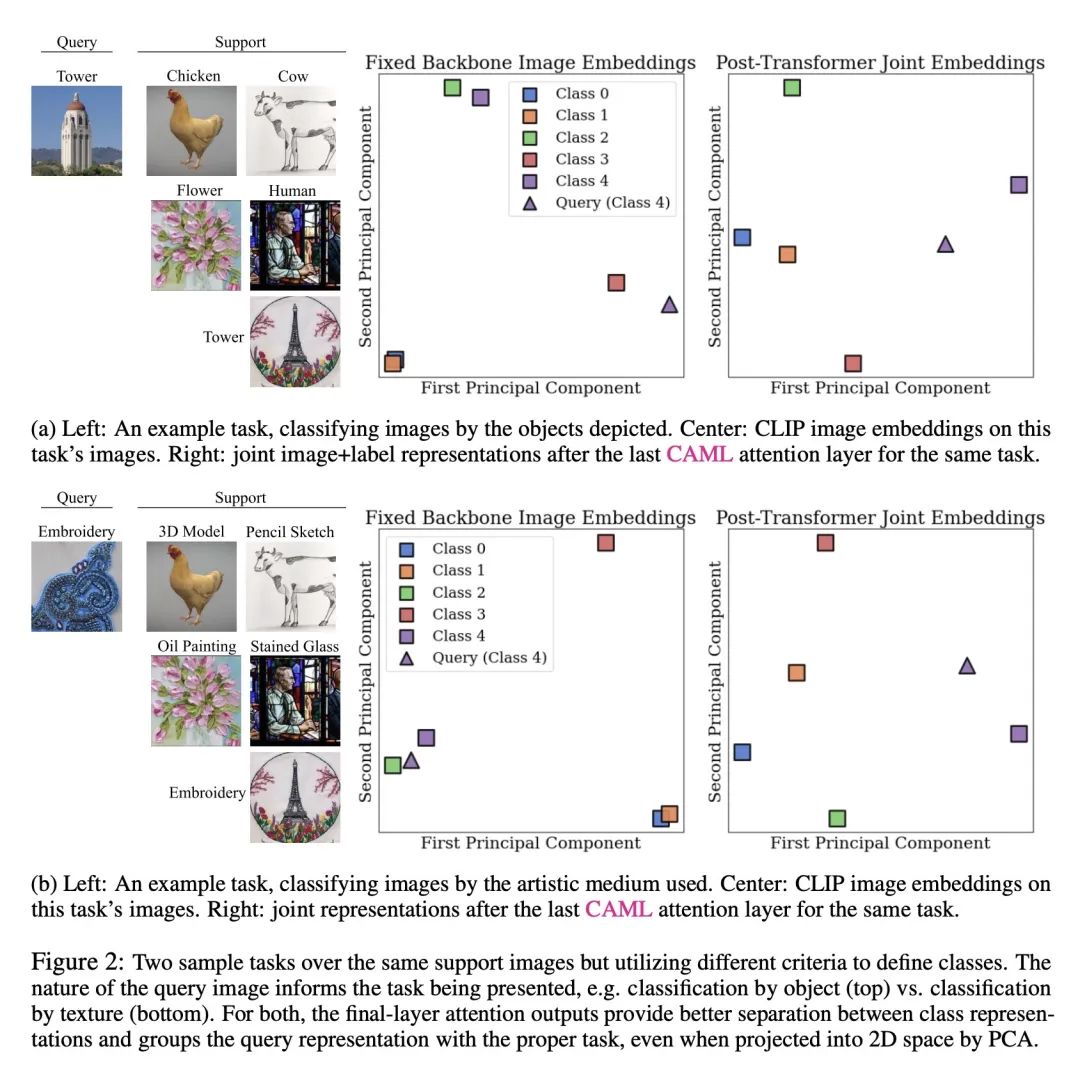

分析表明,CAML的表示会根据查询图像而改变,这使其能针对每个任务适当地选择支持集。经验结果也表明,ELMES编码是最优的。

动机:大型语言模型(如ChatGPT)展示了在推理过程中学习新概念的出色能力,而在推理过程中训练的视觉模型则无法复制这种能力,要么表现不佳,要么需要在类似对象上进行元训练或微调。本文旨在提出一种元学习算法,模拟大型语言模型的行为,通过在推理过程中学习新的视觉概念而无需微调。

方法:利用冻结的预训练特征提取器,并将元学习重新构建为对具有已知标签的数据点和具有未知标签的测试数据点进行序列建模,类似于上下文学习。论文使用了一个基于Transformer编码器的序列模型来进行预训练,以实现在推理过程中学习新的视觉概念而无需微调。

优势:在11个元学习基准测试中,论文的方法在8个测试中超过或与现有的元学习算法P>M>F表现相当,而这些算法都是在这些基准测试中进行了元训练的。

提出一种无需微调的元学习算法,通过在推理过程中学习新的视觉概念,模拟了大型语言模型的行为,并在多个基准测试中取得了与现有算法相当的性能。

https://arxiv.org/abs/2310.10971

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢