导语

分享内容简介

分享内容简介

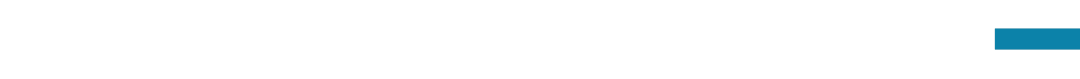

本次分享将会讨论深度学习对抗训练以及小波分析之间的一些应用启示。我们将会回顾小波分析与深度学习对抗样本研究发展的科学史。对抗样本是对深度学习安全的一个重大的挑战。研究者们提出通过基于min-max优化的对抗训练去防御对抗攻击。同时,由于对抗脆弱性可被视为一种高频现象,因此,我们可以在频域中约束对抗性训练的神经网络模型以捕捉低频和高频特征,同时充分利用卷积神经网络感受野提取的局部细节特征。我们将介绍一种结合小波正则化与对抗训练的框架。这种正则化方法满足稳定性理论中的Lipschitz约束。最后将通过一些经验实验的结果讨论这一方法及其局限性。

分享内容大纲

分享内容大纲

深度学习对抗样本研究科学史回顾

小波分析及其在计算机视觉中应用科学史回顾

解决的科学问题和研究动机

研究贡献

理论框架

方法和实验

开放问题的讨论

主要涉及到的知识概念

主要涉及到的知识概念

神经网络 视觉对抗样本 小波分析 主讲人介绍

主讲人介绍

主讲人介绍

主要涉及到的参考文献

主要涉及到的参考文献

关于神经网络对抗训练的经典文献:

Tianyu Pang et al. Bag of tricks for adversarial training. In ICLR, 2021.

Alex Madry et al. Towards deep learning models resistant to adversarial attacks. In ICLR, 2018.

关于过参数模型鲁棒性的经典文献:

Sebastien Bubeck et al. A universal law of robustness via isoperimetry. In NeurIPS, 2021.

关于深度学习频率原则的经典文献:

Zhi-Qin John Xu et al. Overview frequency principle/spectral bias in deep learning. arXiv preprint arXiv:2201.07395.

Dong Yin et al. A fourier perspective on model robustness in computer vision. In NeurIPS, 2019.

关于小波分析的经典文献:

本次分享与读书会主题之间的关系

本次分享与读书会主题之间的关系

• 与复杂系统之间的关系:

这部分的理论启发为过参数化模型有助于深度神经网络的对抗鲁棒性,这种过参数化与鲁棒性之间的联系,正是目前人工智能社区在解释大模型时候用到的"Scaling Law"的某种理论基石。

直播信息

直播信息

2023年11月10日(本周五)晚上20:00-22:00

人工智能与数学读书会启动

人工智能与数学读书会主要围绕AI for math,math for AI两个方面深入探讨人工智能与数学的密切联系。首先,我们将概述人工智能在数学的应用,并深入探讨大模型与数学推理,定理自动证明, AI发现数学规律,符号计算等方向的研究工作。随后,我们将转向大模型与神经网络的数学基础。最后,我们将深入探讨几何与拓扑在机器学习的应用。人工智能与数学读书会自2023年9月15日开始,每周五晚上20:00-22:00举办,持续时间预计 8 周。欢迎对本话题感兴趣的朋友报名参加!

详情请见:

人工智能与数学读书会启动:AI for Math,Math for AI

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢