新智元报道

新智元报道

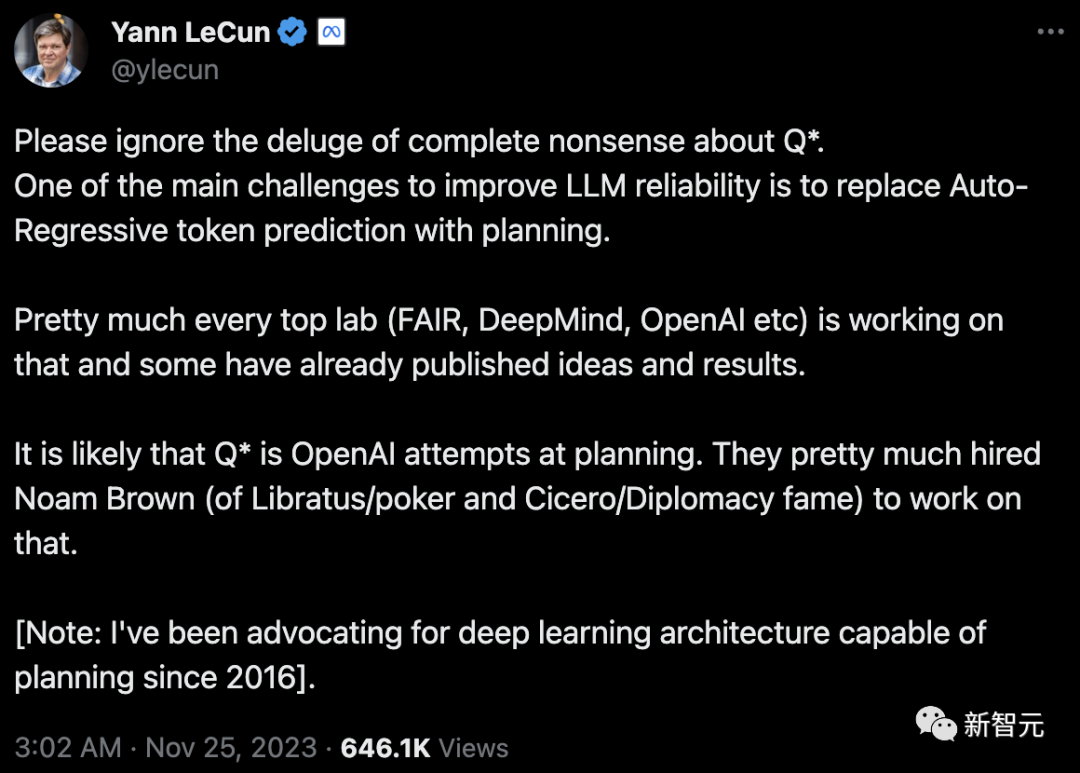

【新智元导读】传闻中OpenAI的Q*,已经引得AI大佬轮番下场。AI2研究科学家Nathan Lambert和英伟达高级科学家Jim Fan都激动的写下长文,猜测Q*和思维树、过程奖励模型、AlphaGo有关。人类离AGI,已是临门一脚了?

Q-Learning忽然大火

AI大佬千字长文分析

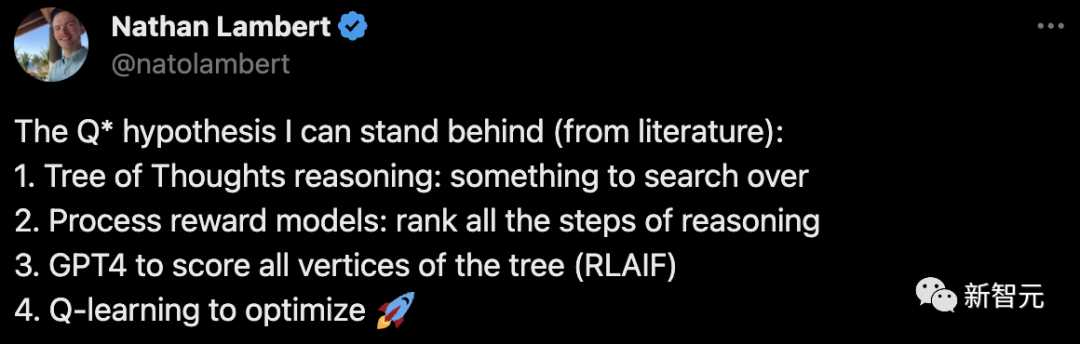

对于引得众人好奇无比的Q*假说,AI2研究科学家Nathan Lambert写了如下一篇长文分析——《Q* 假说:思维树推理、过程奖励模型和增强合成数据》。

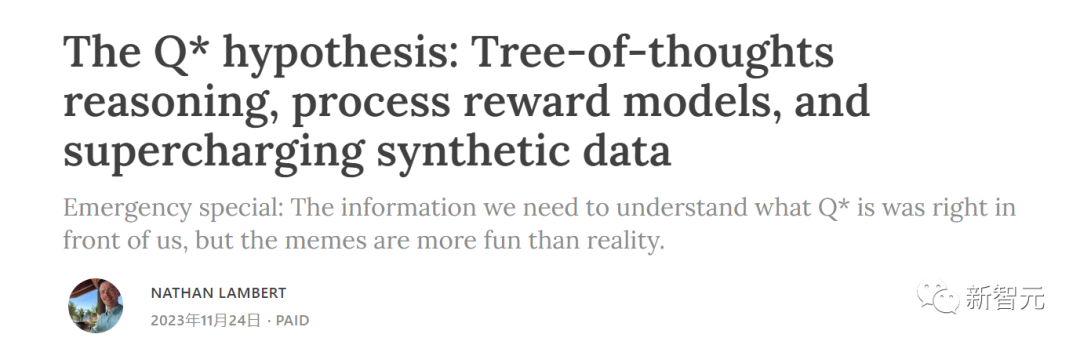

1. 我们如何构建一个我们自己可以搜索的语言表示? 2. 在分隔和有意义的语言块(而不是整个语言块)上,我们怎样才能构建一个价值概念?

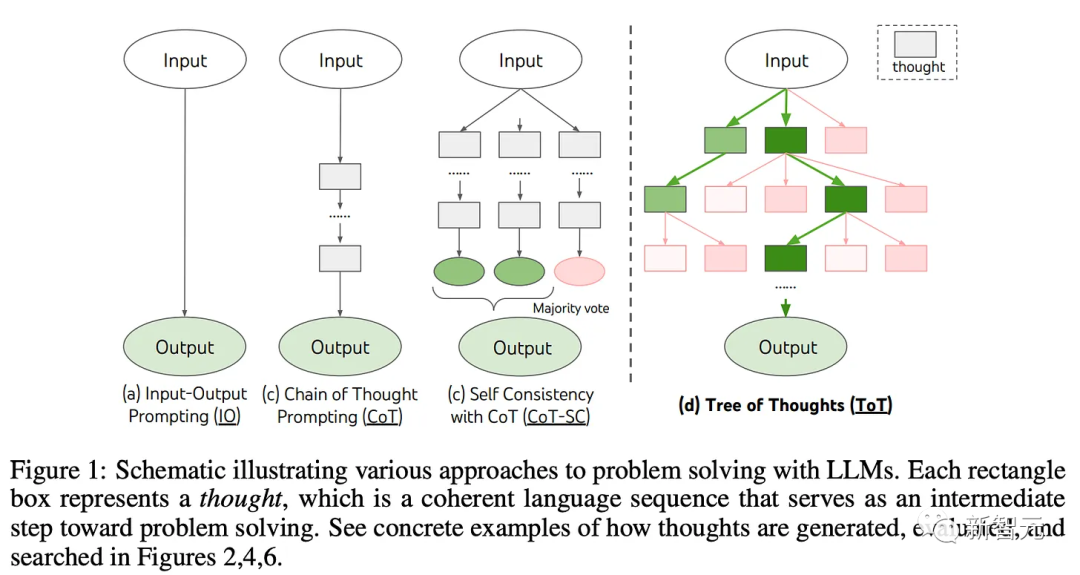

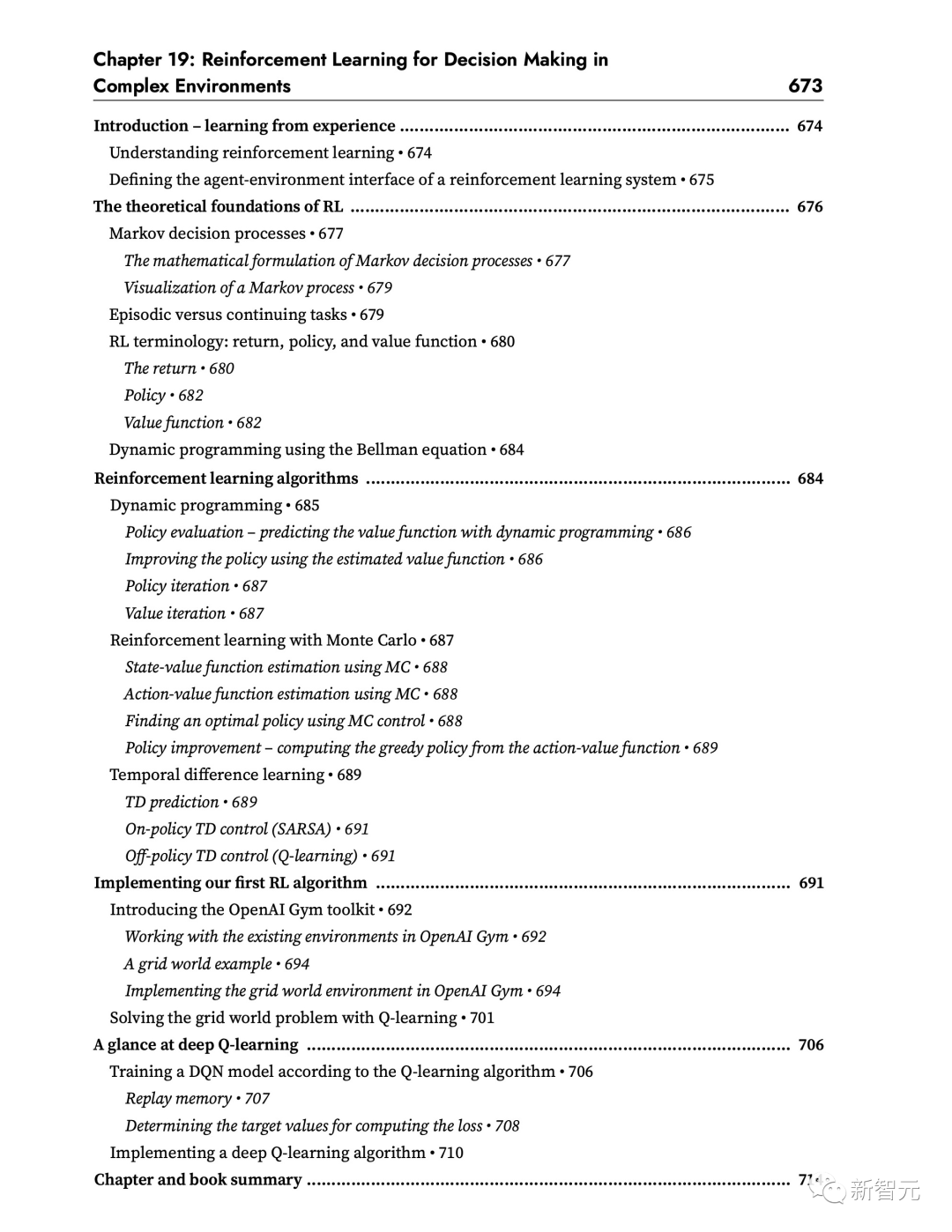

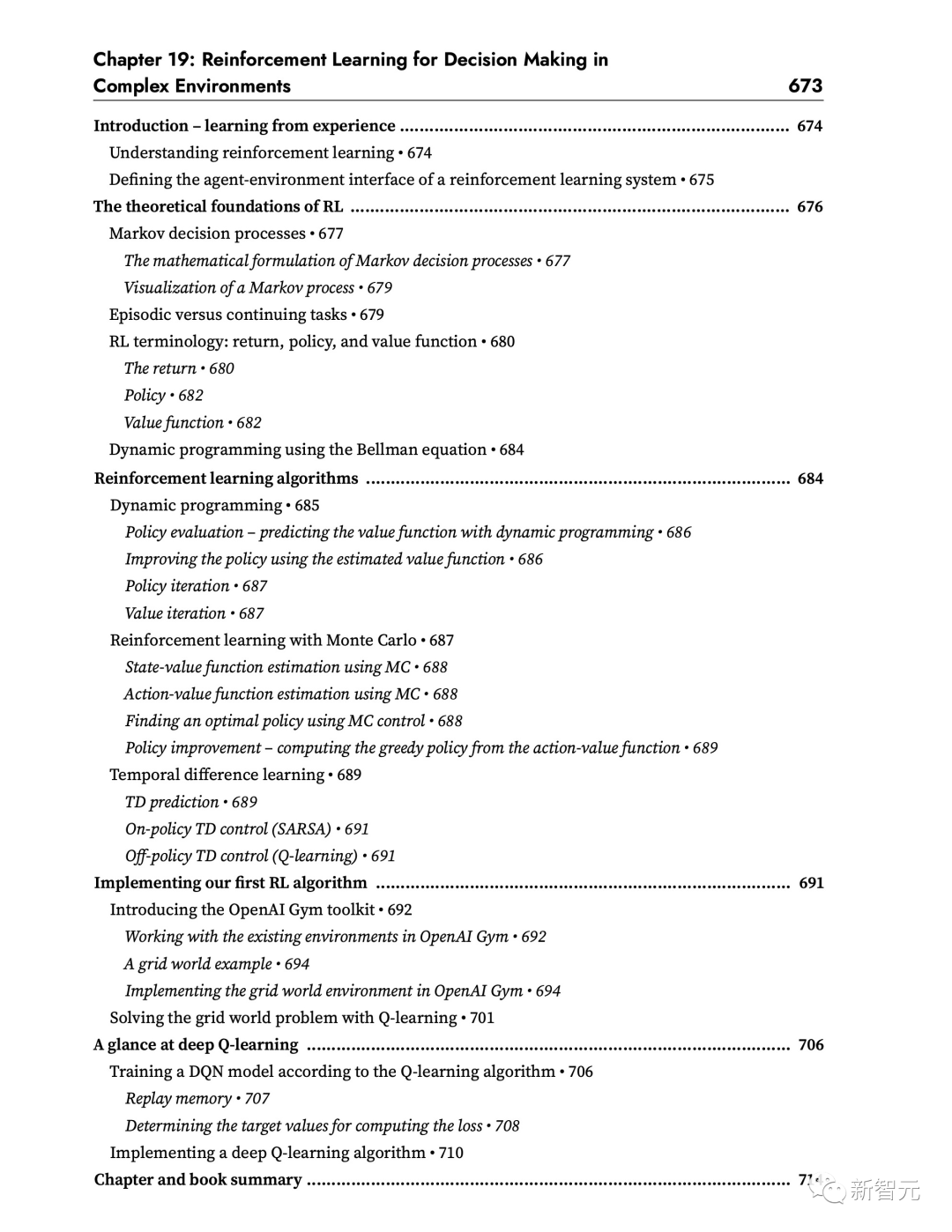

使用LLM进行模块化推理:思维树(ToT)提示

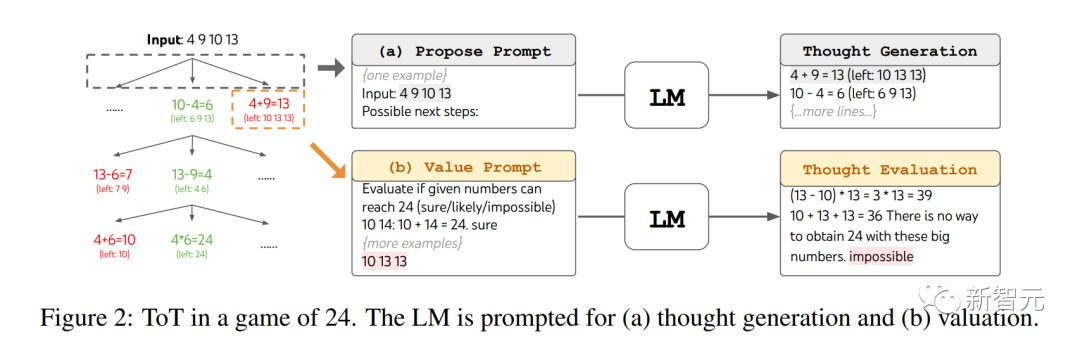

用思维树玩24点游戏

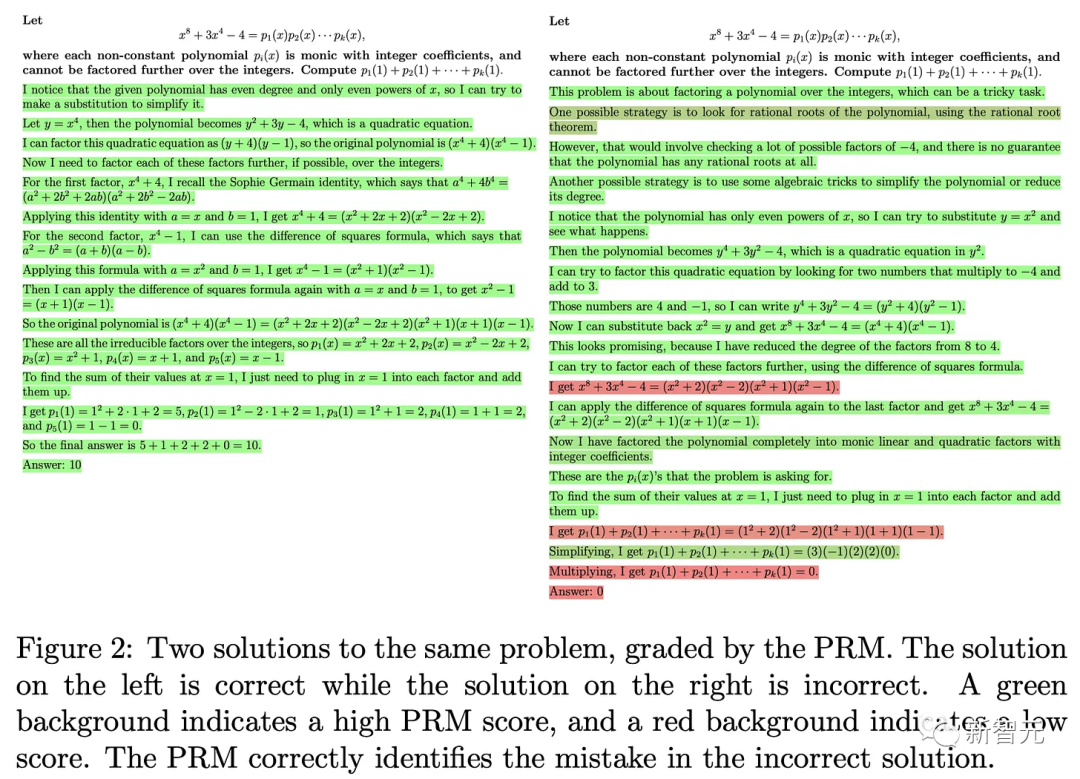

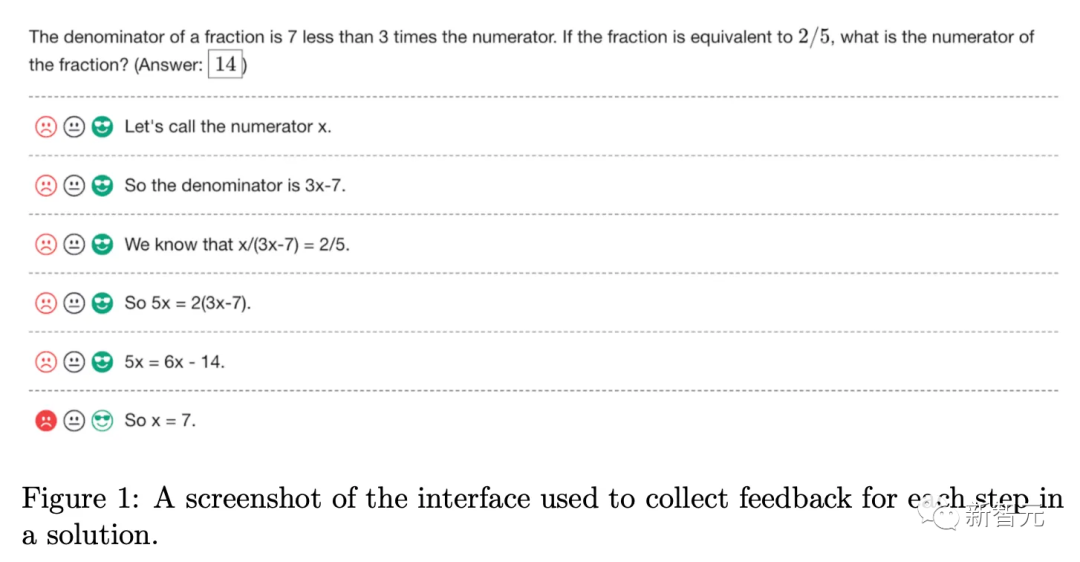

生成中的细粒度奖励标签:过程奖励模型(PRM)

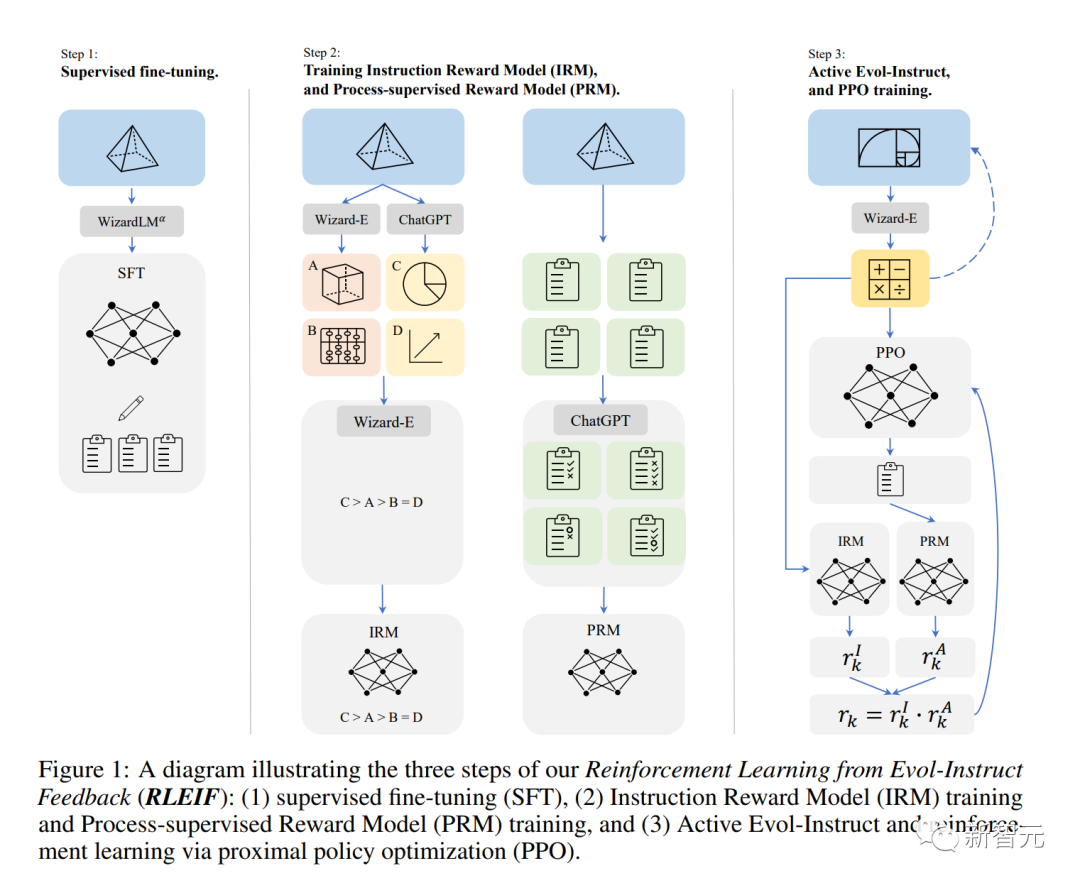

人气极高的数学模型Wizard-LM-Math,就是使用PRM进行训练的:https://arxiv.org/abs/2308.09583

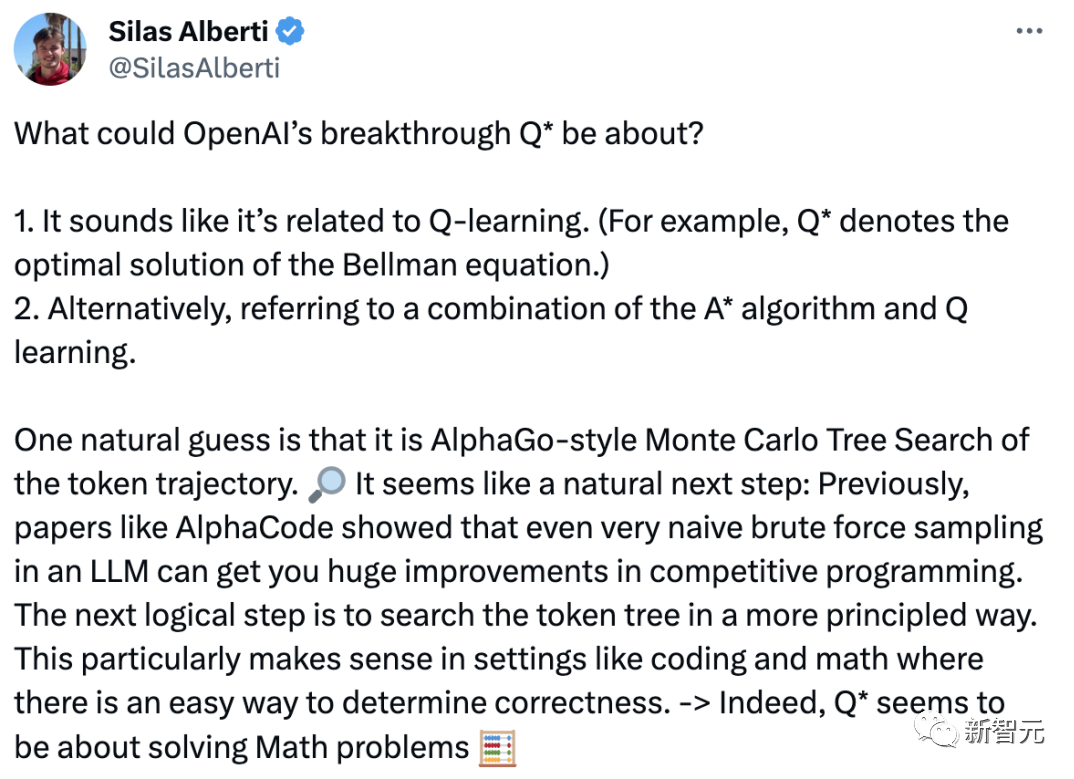

所以,Q*可能是什么?

什么是最有价值的推理token?

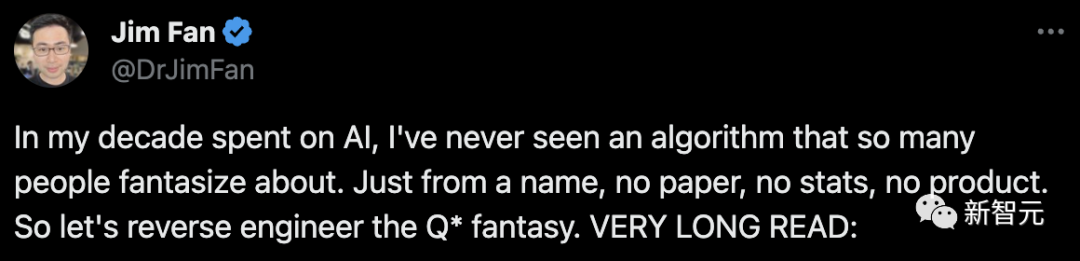

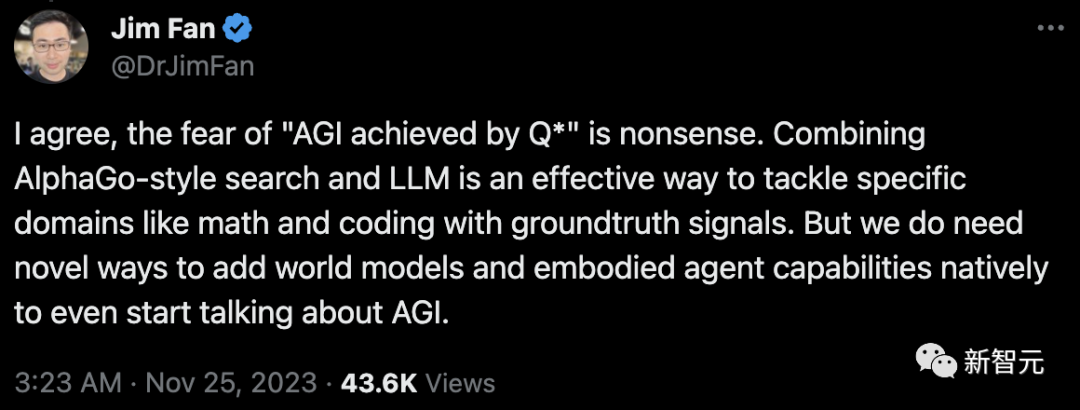

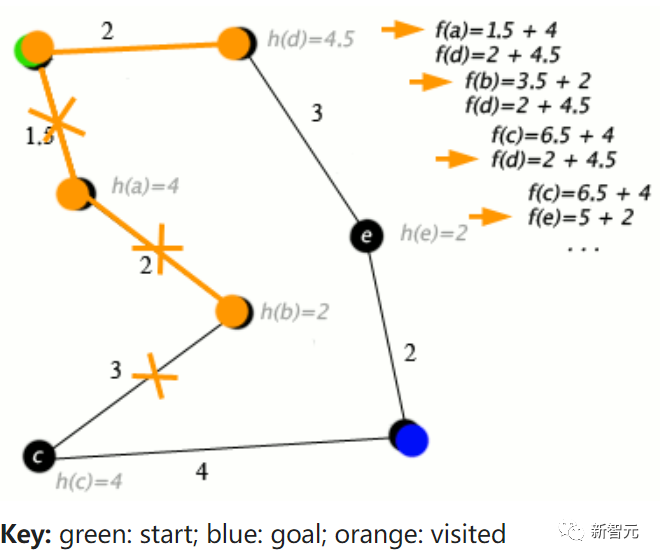

Jim Fan:Q*可能的四大核心要素

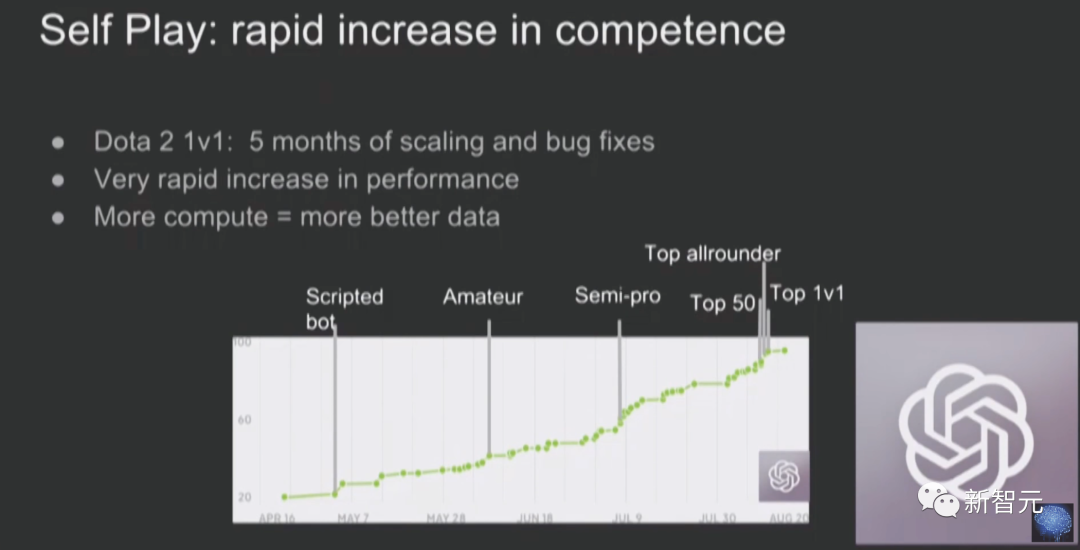

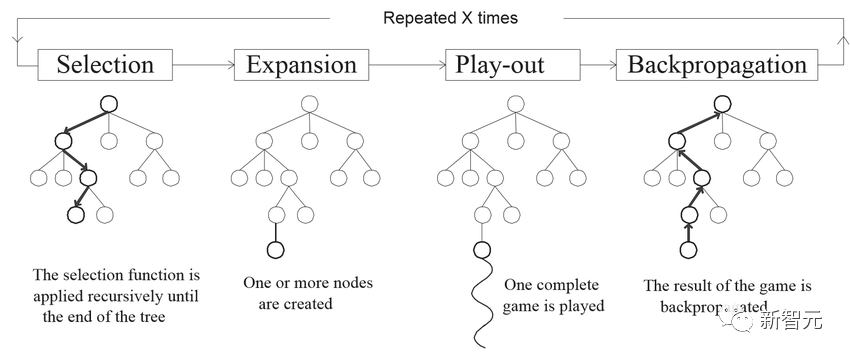

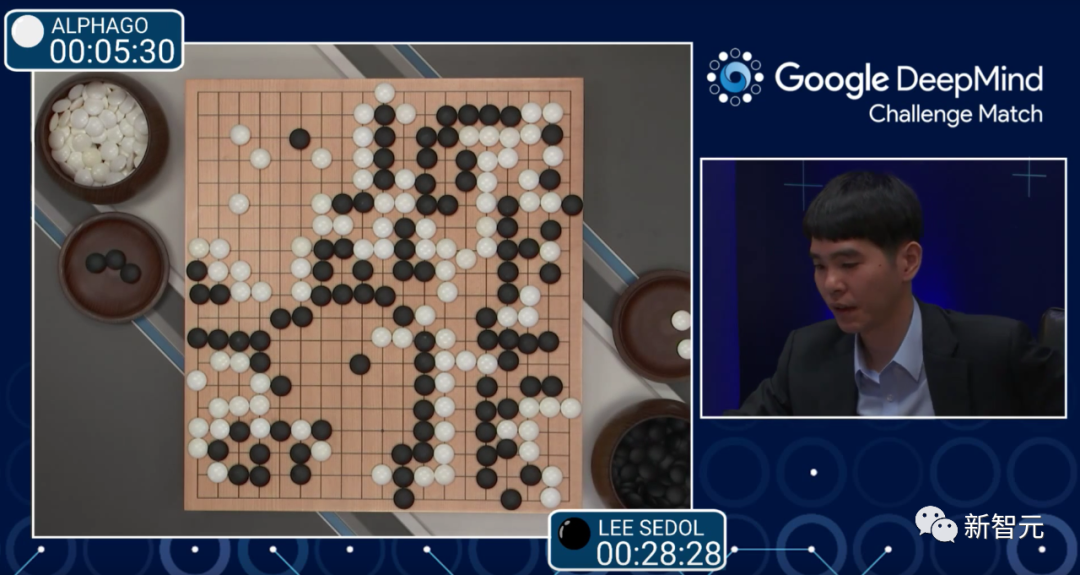

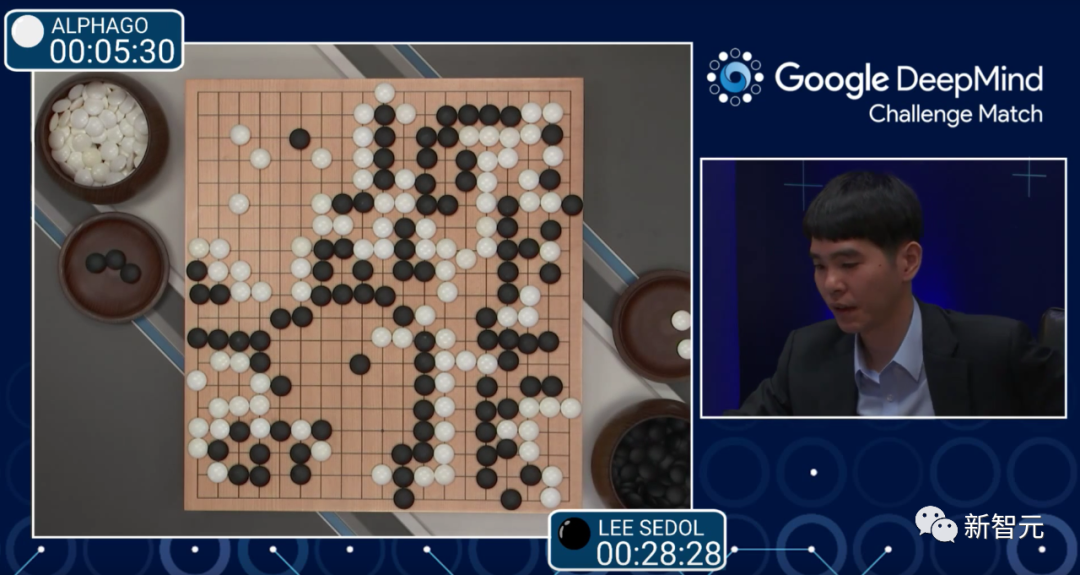

Nathan在我之前几个小时发布了一篇博客,并讨论了非常相似的想法:思想树+过程奖励模型。他的博客列出了更多的参考文献,而我更倾向于与AlphaGo的类比。 Jim Fan表示,要理解搜索和学习结合的强大威力,我们需要先回到2016年,这个人工智能历史上的辉煌时刻。 在重新审视AlphaGo时,可以看到它包含了四个关键要素: 1. 策略神经网络(Policy NN,学习部分):评估每种走法获胜的可能性,并挑选好的走法。 2. 价值神经网络(Value NN,学习部分):用于评估棋局,从任意合理的布局中预测胜负。 3. 蒙特卡罗树搜索(MCTS,搜索部分):利用策略神经网络模拟从当前位置出发的多种可能的走法,然后汇总这些模拟的结果来决定最有希望的走法。这是一个「慢思考」环节,与大语言模型(LLM)中的快速token采样形成鲜明对比。 4. 推动整个系统的真实信号:在围棋中,这个信号就像「谁获胜」这种二元标签一样简单,由一套固定的游戏规则所决定。你可以把它想象成一种能量源,持续地推动着学习的进程。 那么,这些组件是如何相互作用的呢? AlphaGo通过自我博弈(即与自己之前的版本对弈)来学习。 随着自我博弈的持续,策略神经网络和价值神经网络都在不断迭代中得到改善:随着策略在选择走法上变得更精准,价值神经网络也能获得更高质量的数据进行学习,进而为策略提供更有效的反馈。更强大的策略也有助于MCTS探索出更佳的策略。 这些最终构成了一个巧妙的「永动机」。通过这种方式,AlphaGo能自我提升,最终在2016年以4-1的成绩击败了人类世界冠军李世石。仅仅通过模仿人类的数据,人工智能是无法达到超越人类的水平的。

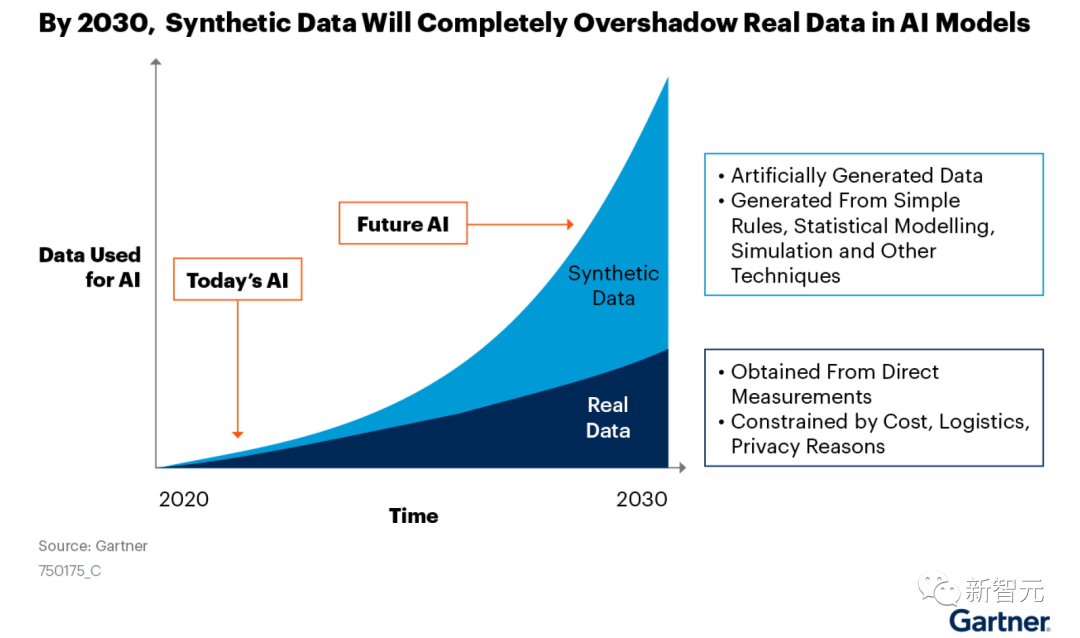

对于Q*来说,又会包含哪四个核心组件呢? 1. 策略神经网络(Policy NN):这将是OpenAI内部最强大的GPT,负责实现解决数学问题的思维过程。 2. 价值神经网络(Value NN):这是另一个GPT,用来评估每一个中间推理步骤的正确性。 OpenAI在2023年5月发布了一篇名为「Let's Verify Step by Step」的论文,作者包括Ilya Sutskever、John Schulman和Jan Leike等知名大佬。虽然它不像DALL-E或Whisper那样知名,但却为我们提供了不少线索。 在论文中,作者提出了「过程监督奖励模型」(Process-supervised Reward Models,PRM),它为思维链中的每一步提供反馈。相对的是「结果监督奖励模型」(Outcome-supervised Reward Models,ORM),它只对最终的整体输出进行评估。 ORM是RLHF的原始奖励模型,但它的粒度太粗,不适合对长响应中的各个部分进行适当的评估。换句话说,ORM在功劳分配方面表现不佳。在强化学习文献中,我们将ORM称为「稀疏奖励」(仅在最后给予一次),而PRM则是「密集奖励」,能够更平滑地引导LLM朝我们期望的行为发展。 3. 搜索:不同于AlphaGo的离散状态和动作,LLM运行在一个复杂得多的空间中(所有合理字符串)。因此,我们需要开发新的搜索方法。 在思维链(CoT)的基础上,研究界已经开发出了一些非线性变体: - 思维树(Tree of Thought):就是将思维链和树搜索结合在一起 - 思维图(Graph of Thought):将思维链和图结合,就可以得到一个更为复杂的搜索运算符 4. 真实信号:(几种可能) (a)每个数学问题都有一个已知答案,OpenAI可能已经从现有的数学考试或竞赛中收集了大量的数据。 (b)ORM本身可以作为一种真实信号,但这样可能会被利用,从而「失去维持学习所需的能量」。 (c)形式化验证系统,如Lean定理证明器,可以把数学问题转化为编程问题,并提供编译器反馈。 就像AlphaGo那样,策略LLM和价值LLM可以通过迭代相互促进进步,并在可能的情况下从人类专家的标注中学习。更优秀的策略LLM将帮助思维树搜索发现更好的策略,这反过来又能为下一轮迭代收集更优质的数据。 Demis Hassabis之前提到过,DeepMind的Gemini将采用「AlphaGo式算法」来增强推理能力。即使Q*不是我们所想象的那样,谷歌也一定会用自己的算法迎头赶上。 Jim Fan表示,以上只是关于推理的部分。目前并没有迹象表明Q*在写诗、讲笑话或角色扮演方面会更具创造性。本质上,提高创造力是人的事情,因此自然数据仍将胜过合成数据。 是时候解决最后一章了

是时候解决最后一章了

而深度学习专家Sebastian Raschka对此表示—— 如果你出于任何原因,不得不在这个周末学习Q-learning,并且碰巧在你的书架上有一本「Machine Learning with PyTorch and Scikit-Learn」,那么,现在是时候解决最后一章了。

参考资料: https://www.interconnects.ai/p/q-star https://twitter.com/DrJimFan/status/1728100123862004105

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢