MoE(Mixture-of-Experts),混合专家架构,已是 GPT4 公开的秘密...

自研全新 MoE 架构,多尺度(2B->16B->145B)模型效果均领先:

多重发布

图2:DeepSeekMoE 16B模型已开放下载

图2:DeepSeekMoE 16B模型已开放下载

无需申请即可商用

图3:DeepSeekMoE 技术报告

图3:DeepSeekMoE 技术报告自研全新MoE框架

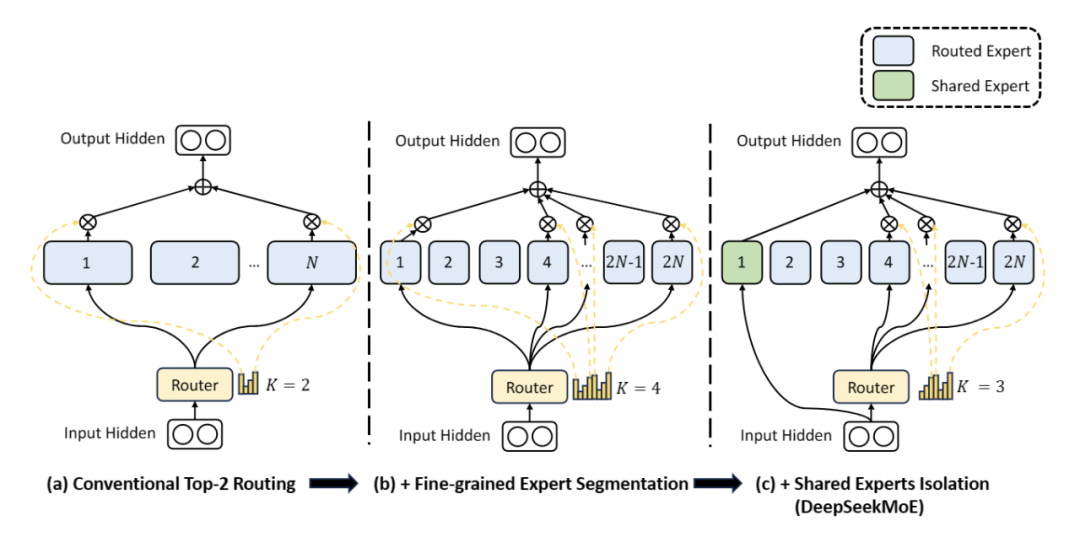

DeepSeekMoE在框架上做了两大创新:

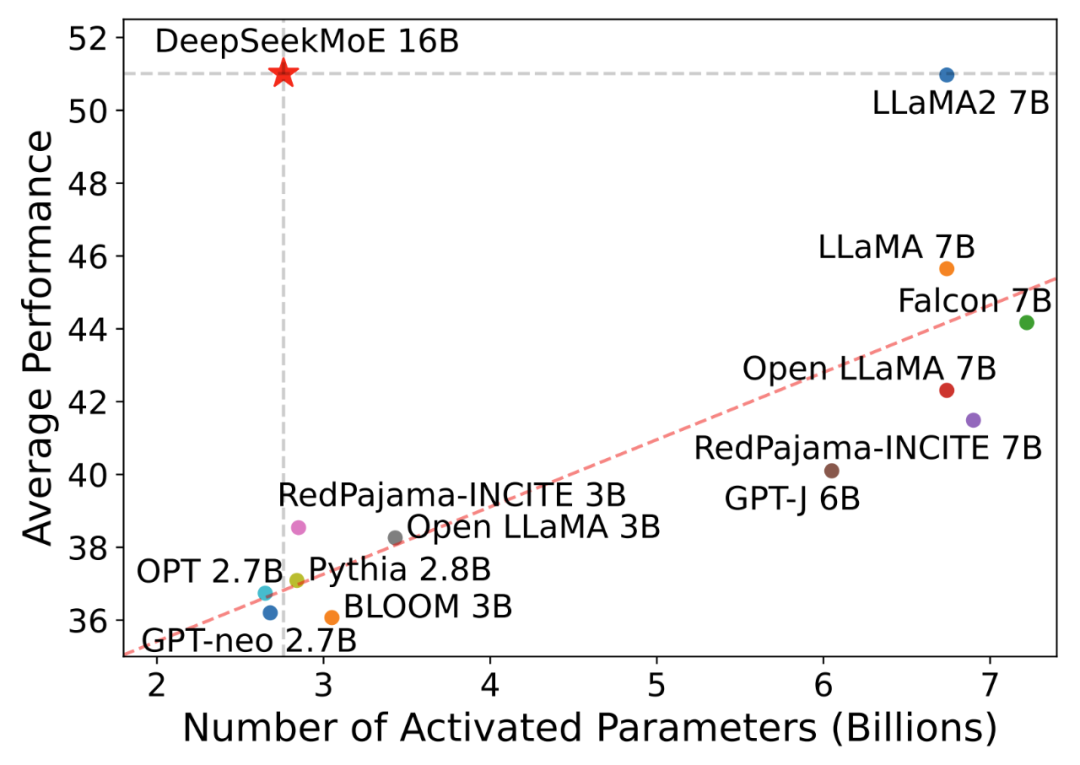

开源MoE模型表现

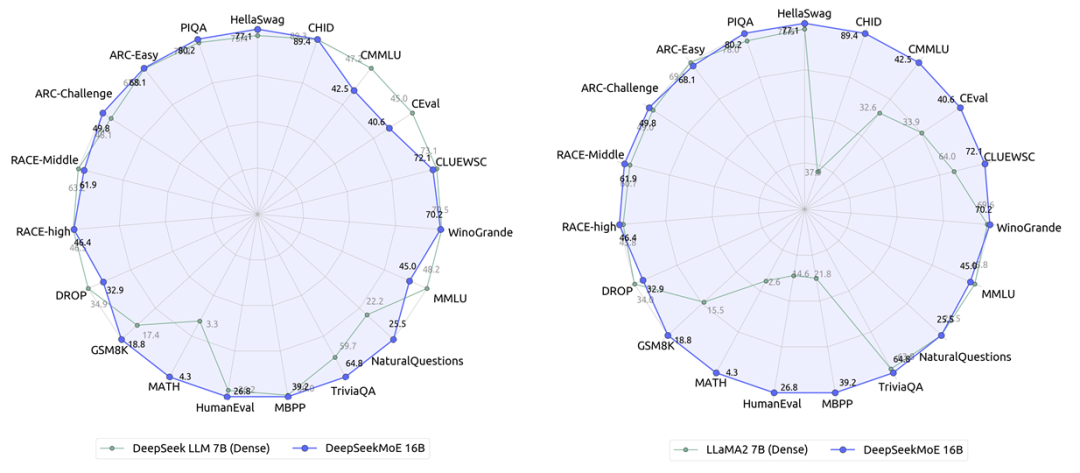

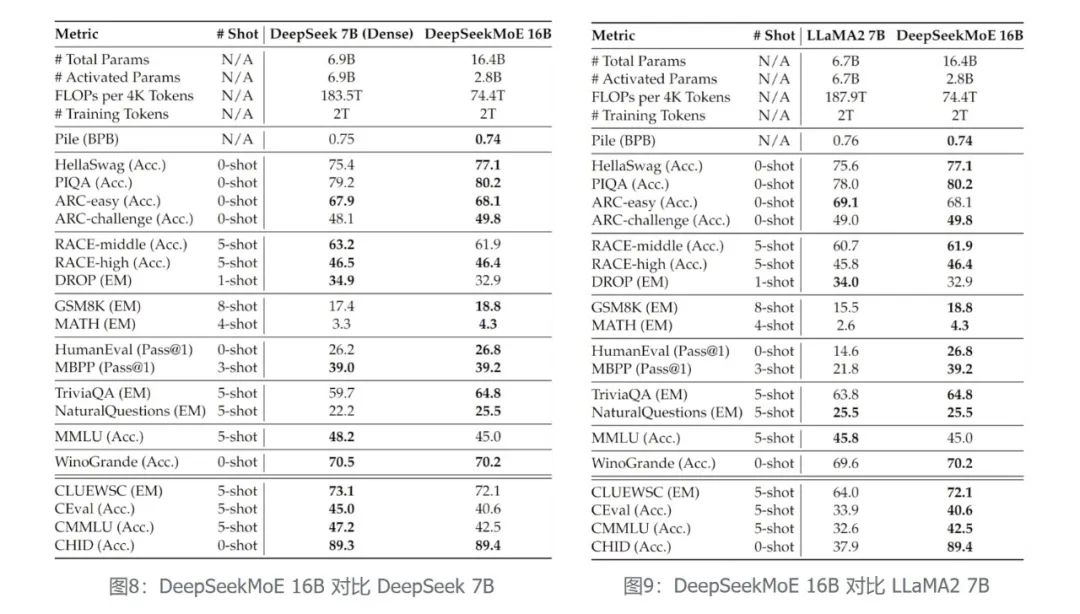

在相同语料下训练了2万亿token,DeepSeekMoE 16B 模型(实际激活参数量为2.8B)性能匹敌DeepSeek 7B Dense 模型(左下图),而同时节省了60%的计算量。

多尺度模型进阶

DeepSeekMoE包含三个模型规模:2B->16B->145B。

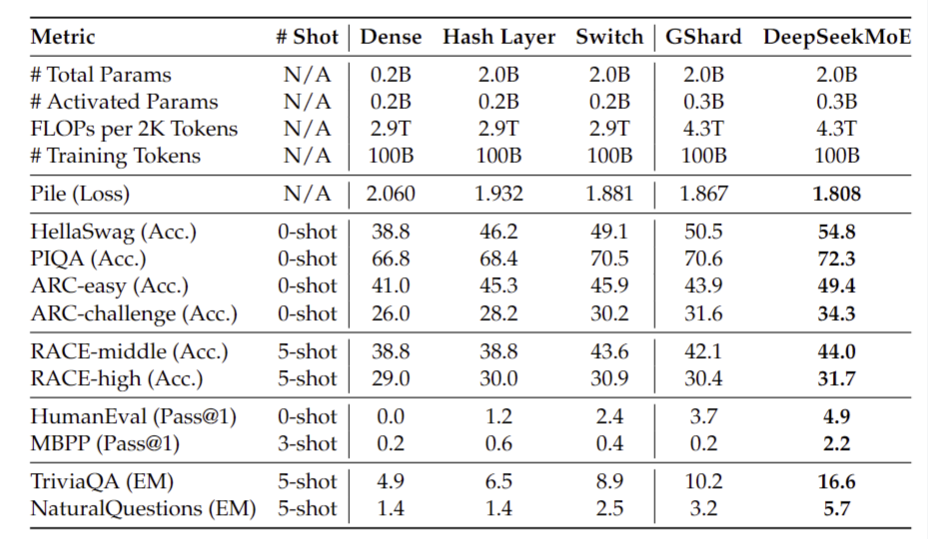

DeepSeekMoE 2B (性能验证)

图5:DeepSeekMoE 2B 对比相同参数MoE模型

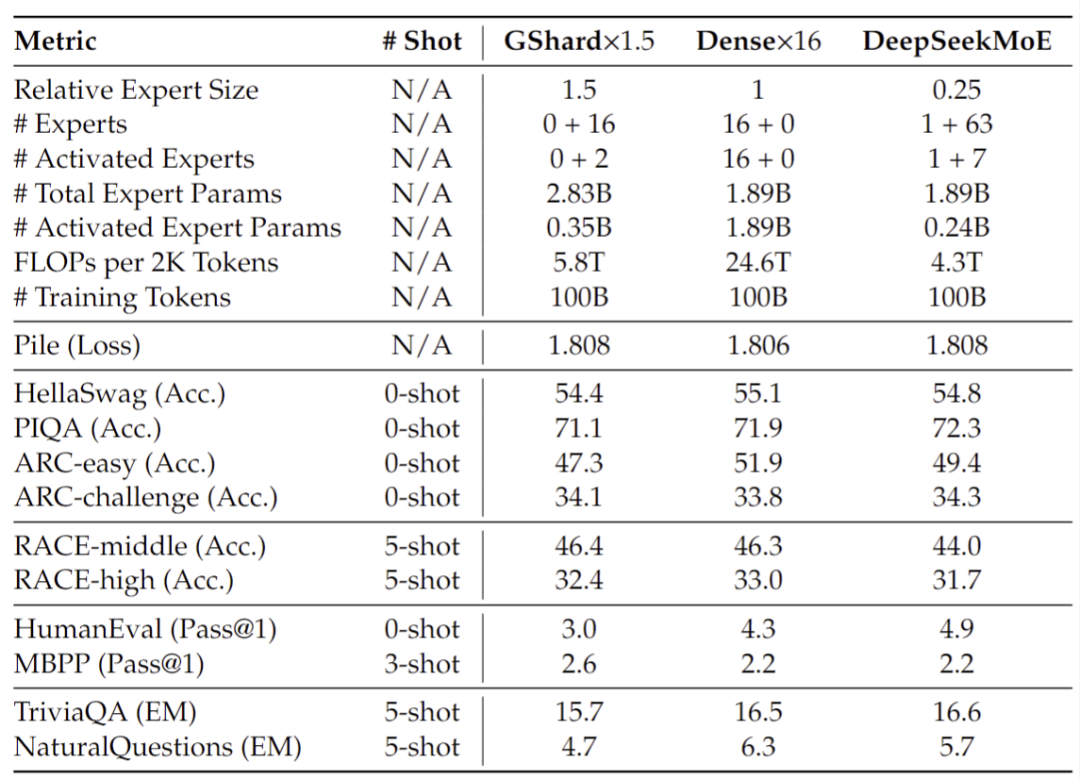

图5:DeepSeekMoE 2B 对比相同参数MoE模型· 与更大规模(总参数量或者计算量)的模型相比,DeepSeekMoE 2B 能匹配 GShard 2.8B (1.5 倍专家参数量和专家计算量)的性能,同时能非常接近MoE模型的理论性能上限,即相同Attention/FFN总参数量下 2B Dense 模型的性能

图6:DeepSeekMoE 2B 模型性能上限分析

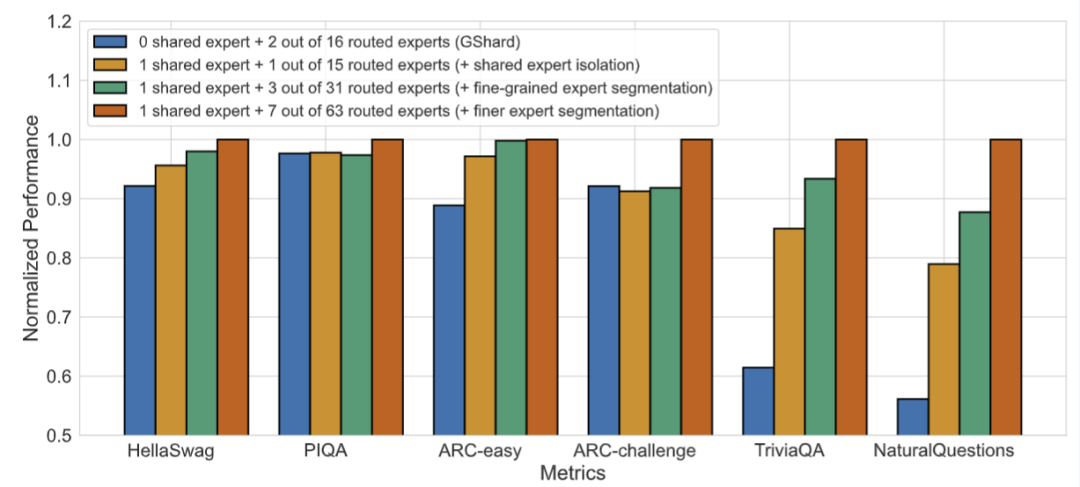

图6:DeepSeekMoE 2B 模型性能上限分析 图7:DeepSeekMoE两大创新的消融实验

图7:DeepSeekMoE两大创新的消融实验此外,我们还验证了 DeepSeekMoE 相比于 GShard,有更好的专家化程度,体现在更少的专家知识冗余和更精准的专家知识命中上,具体请参见技术报告的第4.5节。

基于在 2B 规模上建立的对模型架构的认知,我们训练了总参数量为16.4B的 DeepSeekMoE 16B 模型,并将其开源以促进研究社区的发展。

开源模型效果如下:

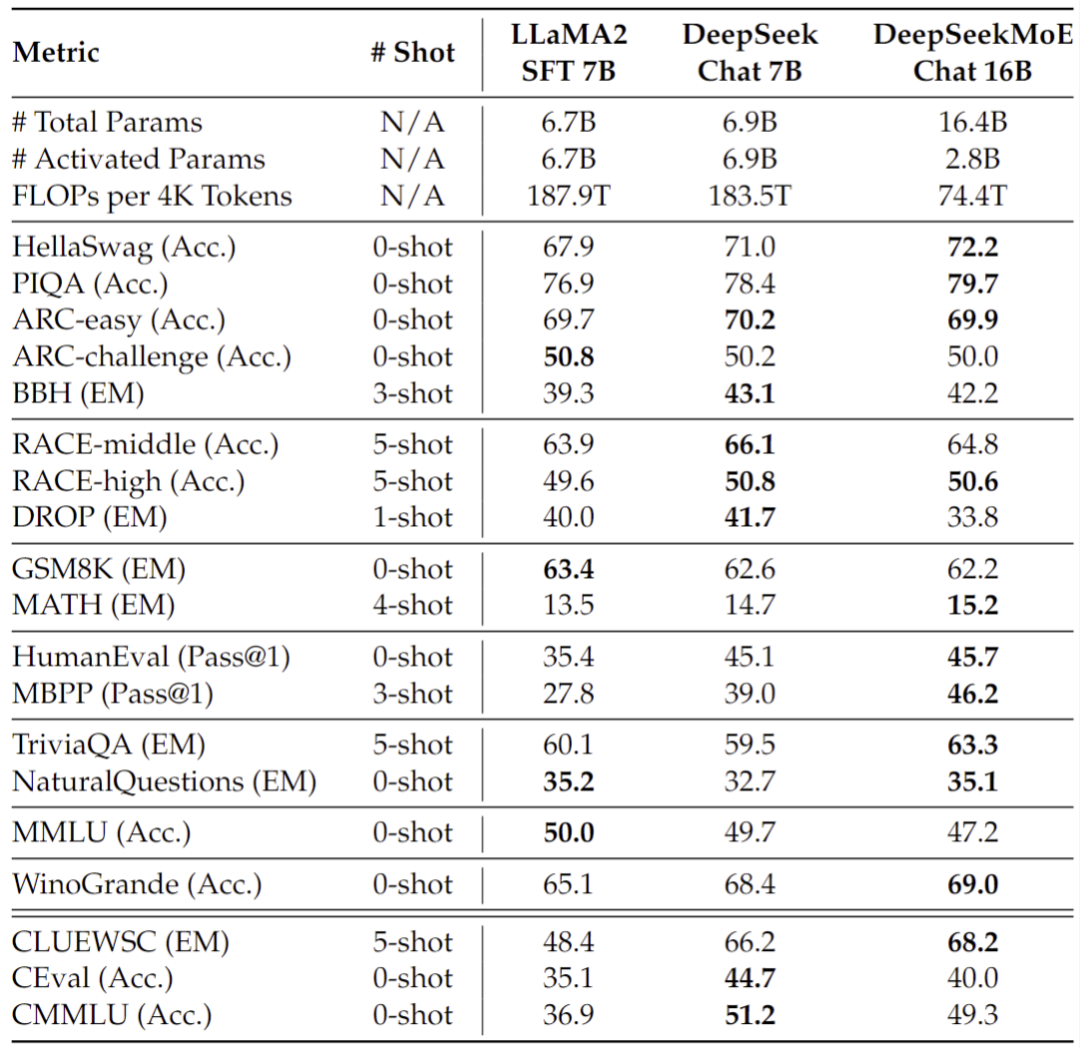

· 我们同时还对 DeepSeekMoE 16B 进行了 SFT 以构建一个对话模型,评测显示,其同样能够与基于 DeepSeek 7B 和 LLaMA2 7B 构建的对话模型性能相匹配

图10:DeepSeekMoE 16B SFT后模型效果对比

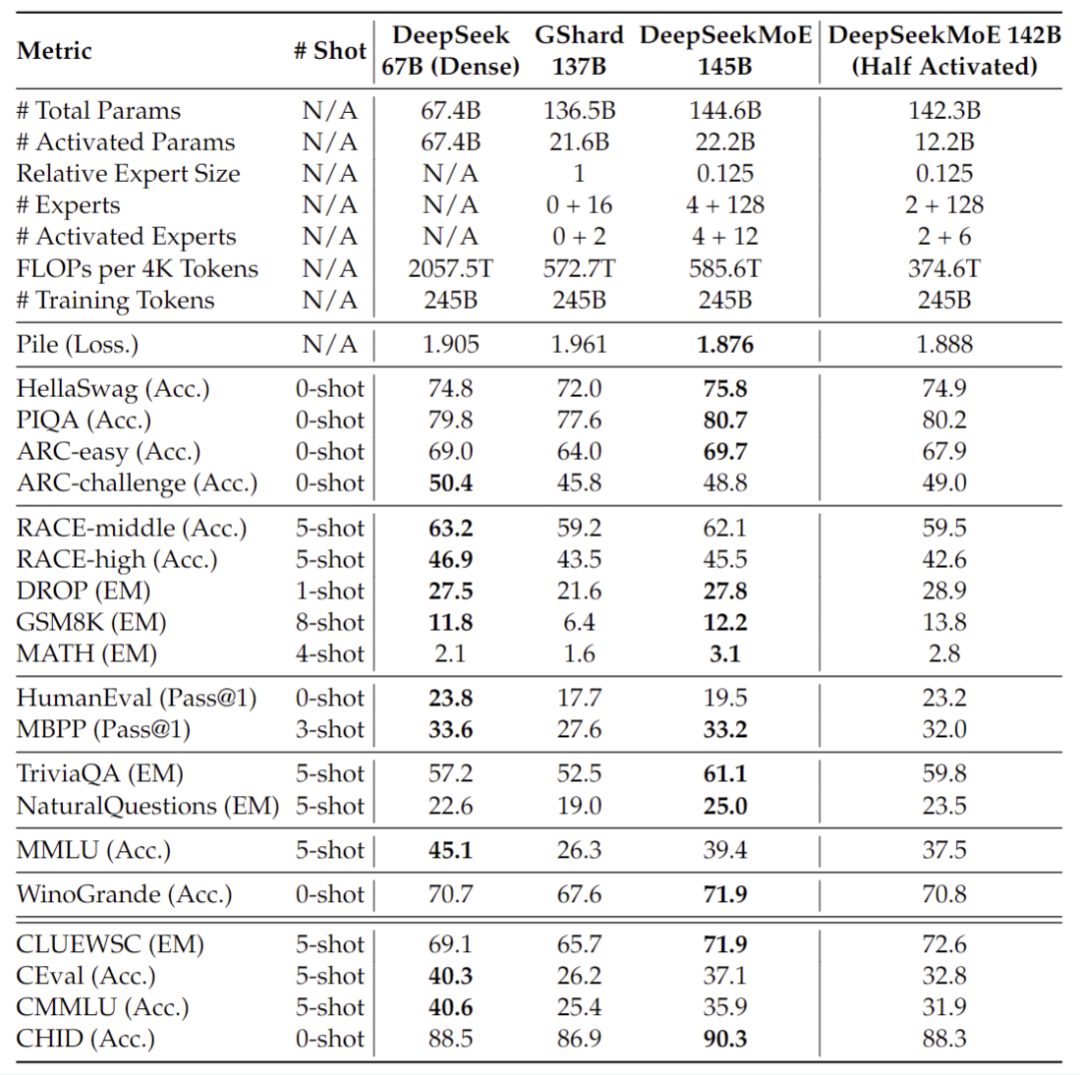

图10:DeepSeekMoE 16B SFT后模型效果对比DeepSeekMoE 145B (持续研究)

图11:DeepSeekMoE 145B 早期实验结果

图11:DeepSeekMoE 145B 早期实验结果NOTE:DeepSeekMoE 145B 正在持续开发中,在未来,我们同样会将其开源给研究社区。

如果你有与开源 AI、Hugging Face 相关的技术和实践分享内容,以及最新的开源 AI 项目发布,希望通过我们分享给更多 AI 从业者和开发者们,请通过下面的链接投稿与我们取得联系:

https://hf.link/tougao

https://hf.link/tougao

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢