导语

分享内容简介

分享内容简介

分享内容大纲

分享内容大纲

背景:回顾AGI风险和安全的历史沿革

风险研判:AGI的滥用风险(Misuse)和失控风险(Rogue AI)

大模型的谄媚行为(Sharma et al., 2023)

工具趋同的理论结果(Turner et al., 2023)

滥用风险:恶意或鲁莽使用AI造成伤害。

失控风险:AI自主追求未对齐的目标。

AGI安全研究领域:

(1) 监督(Oversight):明确系统应如何行动以满足设计者设定的目标。

意图对齐(Intent Alignment)(Christiano, 2018)

价值理解(Value Comprehension)

辅助博弈(Assitance Games)(Hadfield-Menell et al., 2016)

(2) 鲁棒性(Robustness):确保系统在一系列设置中能够可靠地满足设计规范。

对抗策略击败顶级围棋AI(Wang et al., 2023)

(3) 可解释性(Interpretability):使用人类可理解的方法探究系统的能力和局限性。

使用LLM去解释神经网络 (Bills et al,2023)

自动化发现神经网络通路 (circuit, Conmy et al, 2023)

未来展望:AI竞争发展会忽略安全的发展,社会各界应重视AI安全。

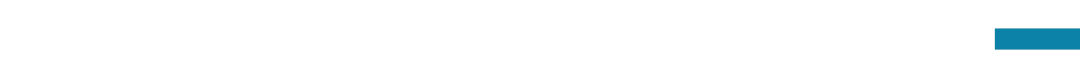

分享形式和议程

分享形式和议程

主题分享:Adam Gleave《AGI Safety: Risks and Research Directions》

圆桌讨论 :

当前大模型安全和对齐方法有何局限?

大模型对齐技术如何迁移到超级对齐?

缺乏算力的情况下如何贡献这个领域?

主要涉及到的前置知识

主要涉及到的前置知识

对齐 (Alignment)

通用人工智能 (Artificial General Intelligence,AGI)

线路 (circuit,Towards Automated Circuit Discovery for Mechanistic Interpretability)

对抗鲁棒性(adversarial robustness)

AI对齐

主讲人介绍

主讲人介绍

圆桌嘉宾介绍

圆桌嘉宾介绍

主要涉及到的参考文献

主要涉及到的参考文献

SHARKEY L, GHUIDHIR C N, BRAUN D, et al. A Causal Framework for AI Regulation and Auditing[C/OL]. https://api.semanticscholar.org/CorpusID:265309979.

Sharma M, Tong M, Korbak T, et al. Towards understanding sycophancy in language models[J]. arXiv preprint arXiv:2310.13548, 2023.

Turner A M, Smith L, Shah R, et al. Optimal policies tend to seek power[J]. arXiv preprint arXiv:1912.01683, 2019.

Hadfield-Menell D, Russell S J, Abbeel P, et al. Cooperative inverse reinforcement learning[J]. Advances in neural information processing systems, 2016, 29.

Wang T T, Gleave A, Tseng T, et al. Adversarial policies beat superhuman go AIs[C]//International Conference on Machine Learning. PMLR, 2023: 35655-35739.

Bills S, Cammarata N, Mossing D, et al. Language models can explain neurons in language models[J]. URL https://openaipublic. blob. core. windows. net/neuron-explainer/paper/index. html.(Date accessed: 14.05. 2023), 2023. Conmy A, Mavor-Parker A N, Lynch A, et al. Towards automated circuit discovery for mechanistic interpretability[J]. arXiv preprint arXiv:2304.14997, 2023. IDAIS: https://humancompatible.ai/news/2023/10/31/prominent-ai-scientists-from-china-and-the-west-propose-joint-strategy-to-mitigate-risks-from-ai/

直播信息

直播信息

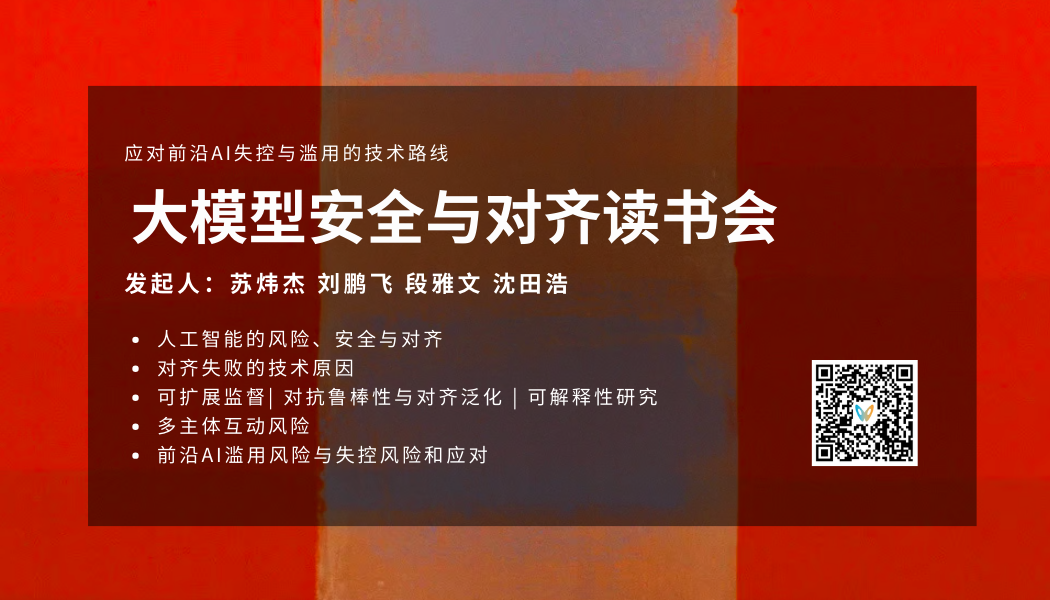

大模型安全与对齐读书会

大模型的狂飙突进唤醒了人们对AI技术的热情和憧憬,也引发了对AI技术本身存在的社会伦理风险及其对人类生存构成的潜在威胁的普遍担忧。在此背景下,AI安全与对齐得到广泛关注,这是一个致力于让AI造福人类,避免AI模型失控或被滥用而导致灾难性后果的研究方向。集智俱乐部和安远AI联合举办「大模型安全与对齐」读书会,由多位海内外一线研究者联合发起,旨在深入探讨大模型安全与对齐所涉及的核心技术、理论架构、解决路径以及安全治理等交叉课题。

点击“阅读原文”,报名读书会

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢