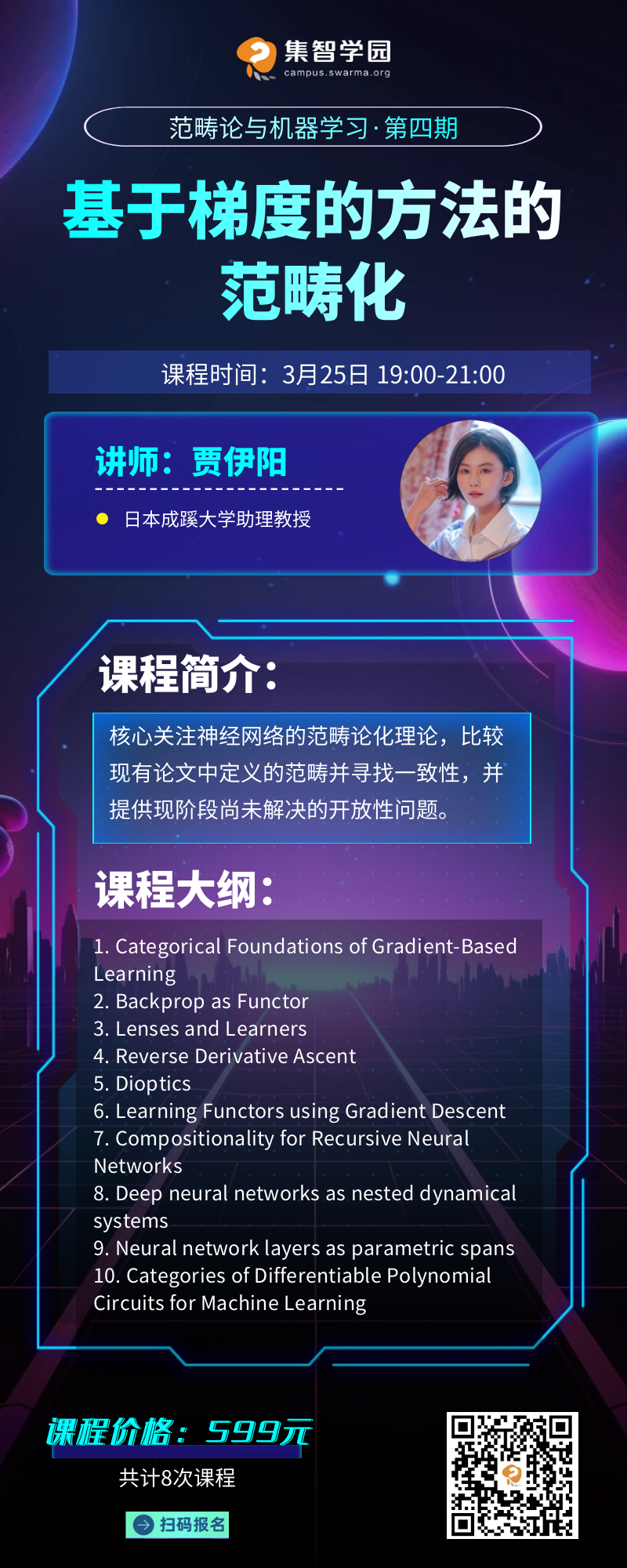

第四课“基于梯度的方法的范畴化”简介

第四课“基于梯度的方法的范畴化”简介

a.这部分提出使用范畴论的基本概念来理解基于梯度学习的数学基础。这意味着在更抽象的层面上理解深度学习中的计算和结构,以及它们是如何相互作用的。

a.在范畴论中,函子(Functor)是两个范畴之间的映射,它保持了结构的性质。这里将反向传播算法视为一种函子,表明它可以在不同的数学结构间传递梯度信息,同时保持这些结构的某些基本特性。

a. “透镜”(Lenses)是范畴论中的一个概念,用于描述如何集中视角来观察和修改数据结构。在这个框架中,它被用来理解学习模型如何从数据中提取信息并更新其参数。

a.这部分可能关注于如何通过范畴论的视角理解和改进基于梯度上升(或下降)的优化过程,特别是在求解反向导数时的应用。

a.这是一个可能结合了范畴论中的“双函子”(Difunctors)和光学(如透镜理论)的概念,用于描述复杂学习系统中的信息流动和转换过程。

a.这表明可以通过梯度下降这类优化方法来学习和优化函子,即在不同结构间映射的参数化方法,以此来改进学习算法。

a.讨论了如何将组合的概念应用于递归神经网络中,以便于构建更复杂、功能更强大的模型。

a.深度神经网络可以被视为嵌套的动态系统,每一层网络都可以被看作是一个动态系统的组成部分,整个网络是这些部分的组合。

a.这可能涉及到将神经网络的每一层视为参数化跨度,通过这种方式可以在不同的数学结构中移动和调整这些层。

a.讨论了如何构建和使用可微分的多项式电路的范畴,以促进机器学习模型的设计和优化。

Categorical Foundations of Gradient-Based Learning https://arxiv.org/abs/2103.01931

Categorical Deep Learning: An Algebraic Theory of Architectures https://arxiv.org/abs/2402.15332

Backprop as Functor https://arxiv.org/abs/1711.10455

Lenses and Learners https://arxiv.org/abs/1903.03671

Reverse Derivative Ascent https://arxiv.org/abs/2101.10488

Dioptics http://events.cs.bham.ac.uk/syco/strings3-syco5/papers/dalrymple.pdf

Learning Functors using Gradient Descent http://www.cs.ox.ac.uk/ACT2019/preproceedings/Bruno%20Gavranovic.pdf

Compositionality for Recursive Neural Networks https://arxiv.org/abs/1901.10723

Deep neural networks as nested dynamical systems https://arxiv.org/abs/2111.01297

Neural network layers as parametric spans https://arxiv.org/abs/2208.00809

Categories of Differentiable Polynomial Circuits for Machine Learning https://arxiv.org/abs/2203.06430

Category-Theoretic Datastructures and Algorithms for Learning Polynomial Circuits https://eprints.soton.ac.uk/483757/1/paul_wilson_thesis_acrobat_fixup.pdf

主讲老师

主讲老师

分享信息

分享信息

分享方式:

1. 腾讯会议(报名付费课程可见)

2. 集智学园视频号直播

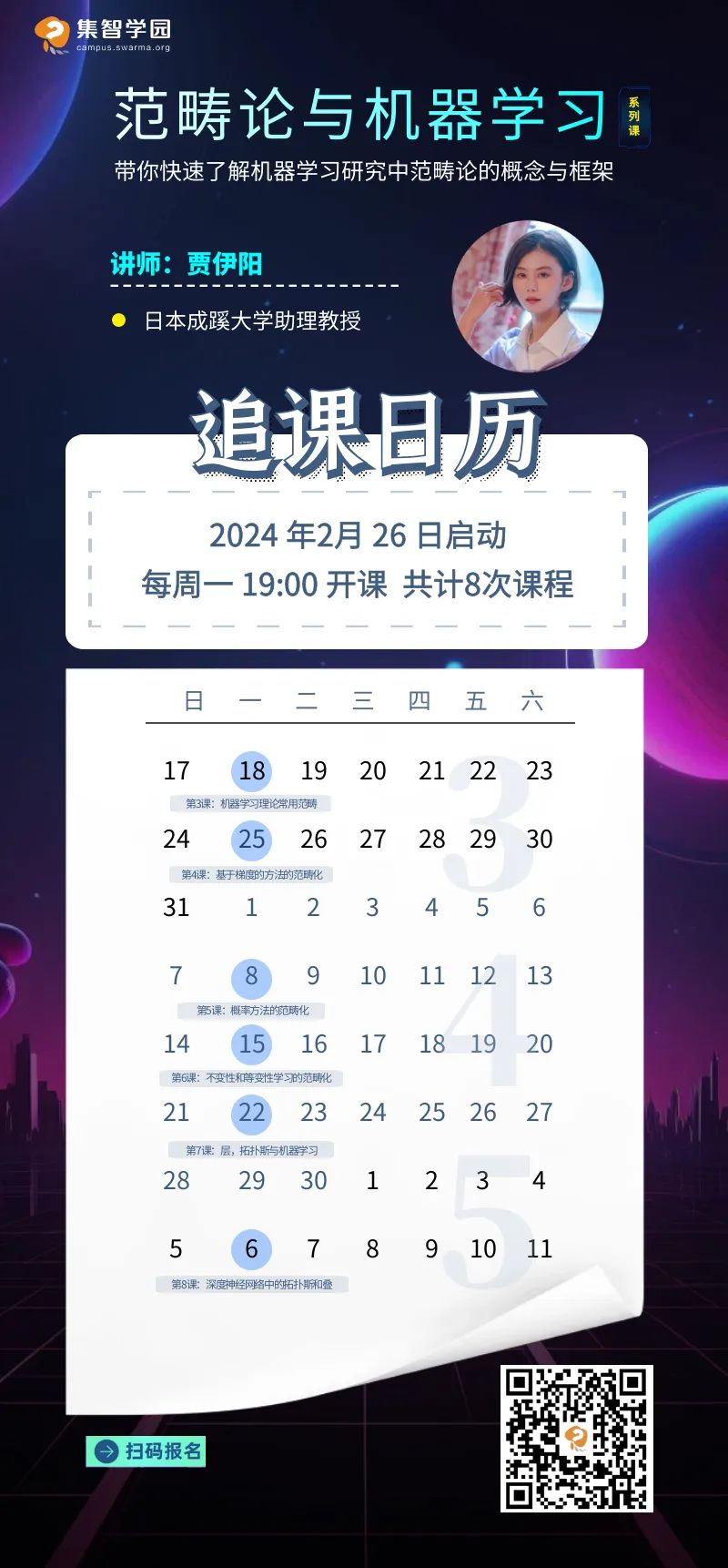

「范畴论与机器学习」系列课程

等你加入

推荐阅读:

点击“阅读原文”,报名课程

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢