今天为大家介绍的是来自Xiang Wang团队的一篇论文。分子关系学习(MRL),旨在理解分子对之间的相互作用,对推进生化研究发挥着关键作用。近期,采用大型语言模型(LLMs)作为一种高效有效的MRL方法显得尤为有前途,这些模型以其庞大的知识库和高级的逻辑推理能力而闻名。尽管这些方法充满潜力,但它们主要依赖于文本数据,因此并未完全利用分子图中固有的丰富结构信息。此外,缺乏统一框架加剧了数据利用不足的问题,因为它阻碍了在不同数据集之间学到的相互作用机制的共享。为了应对这些挑战,作者提出了一种基于LLM的多模态框架,用于分子交互建模,遵循思维链(CoT)理论,称为MolTC,该框架有效地整合了成对两分子的图信息。为了实现统一的训练范式,MolTC创新性地开发了一种动态参数共享策略,用于跨数据集信息交换。

分子关系学习(MRL)旨在理解分子对之间的相互作用,由于其广泛的应用范围已经获得了广泛的关注。例如,药物-药物相互作用(DDIs)在药理学和药物开发中至关重要,而溶质-溶剂相互作用(SSIs)是溶液化学和化学过程设计的基础。然而,这些相互作用的详尽实验验证是出了名的耗时且成本高昂。大型语言模型(LLMs)以其庞大的知识库和高级逻辑推理能力而闻名,已成为MRL的一种高效且有效的替代方案。

图 1

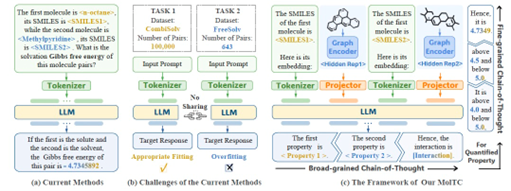

尽管这些方法充满前景,但当前基于LLM的范式的主要问题是数据利用不足。具体来说,它们主要依赖于文本数据,如SMILES和性质描述,因此没有充分利用分子图中固有的丰富结构信息,如图1(a)所示。当前的研究表明,仅基于文本数据,LLMs很难完全理解复杂的图形,因此,鉴于这些结构在MRL中的重要性,明确建模这些结构至关重要。更加重要的是,基于LLM的MRL缺乏统一框架。具体而言,这种缺失阻碍了在各种数据集之间学习到的相互作用机制的共享和整合,导致了集体洞见的碎片化。特别是,对于标记对数量有限的任务来说,这是一个灾难性的挑战,由于过度拟合的高风险,LLMs通常在这些任务上表现不佳,如图1(b)所示。更糟糕的是,这种有限的数据集在MRL中很常见,因为实验获取通常受到高成本的约束。为了克服这些限制,作者在这项工作中提出了MolTC,一个统一的多模态框架,用于遵循思维链理论的分子交互建模。如图1(c)所示,MolTC采用了图神经网络(GNNs),以其在图建模方面的有效而闻名,明确收集分子对的图形信息,并通过两个精心设计的投影器将它们整合到LLMs的输入空间中。针对实证发现LLMs可能会混淆成对输入分子的问题,MolTC加入了分子的SMILES信息,以加强分子顺序的概念。更重要的是,为了实现统一的学习范式,MolTC开发了一种动态参数共享策略,以加强跨数据集信息交换,这可以同时提高效率和有效性。

方法部分

MolTC框架引入了四个关键组成部分:图编码器、图表示投影器、SMILES注入器和骨干LLM。

提取相互作用的第一步是精确地编码分子图。基于这一点,作者用两个基于GNN的编码器来捕获给定分子对的嵌入,利用GNN在聚合结构信息方面的强大能力。获得分子对表示Ha和Hb后,下一步是使用投影器fpro1和fpro2将它们映射到骨干LLM的隐藏空间。这些投影器作为关键的连接器,将Ha和Hb翻译成LLM能理解的编码Ma和Mb。借鉴最先进的视觉-语言模型,作者通过查询转换器(Q-Formers)实例化fpro1和fpro2。具体来说作者采用的投影器基于BERT架构,增加了一个位于自注意力和前馈模块之间的额外交叉注意力模块。这种实例化提供了两个关键好处。首先,它支持与传统的基于BERT的文本编码器的无缝整合,允许fpro1和fpro2与大量分子图-文本对进行预训练。其次,它保持了与各种输入维度d的兼容性,并允许调整可学习查询token的大小以与LLM的token嵌入大小对齐。这些优势为两分子在LLM推理过程中的交互奠定了坚实的基础。

当直接使用LLMs分析表示Ma和Mb时,作者的实验表明LLMs可能在区分一对分子的属性时产生混淆。这一观察自然地激发了作者将分子的文本信息整合进来,以加强它们顺序性的概念。在这里,MolTC采用了SMILES,因为它的普遍性和特异性。此外,SMILES作为一个通道,将任务特定的提示与LLM内存储的相应生化知识连接起来。因此,作者直接将两个分子的SMILES输入到骨干LLM中,利用固有的编码器获取它们的标记Sa和Sb。最后MolTC利用Galactica作为其骨干LLM,Galactica是一个仅限解码器的变换器,建立在OPT框架上。经过对大量科学文献的预训练,Galactica在生物化学知识方面展现出了非凡的效果。这种专长,特别是在解析分子序列(如SMILES和SELFIES字符串)方面,使得Galactica能够巧妙地捕捉对分子相互作用至关重要的属性。具体来说,MolTC的目标是利用Galactica的高级推理技能来解释两个分子标记集合{Ma, Sa}和{Mb, Sb}之间的上下文相互作用。

训练部分

图 3

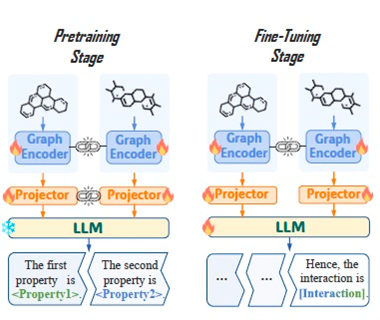

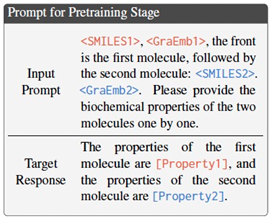

MolTC的训练范式,包括预训练和微调过程,这一过程是由多层次思维链(CoT)原则指导的,如图2所示。鉴于直接理解一对输入分子之间复杂相互作用的挑战,宽粒度CoT指导MolTC最初识别各个分子的属性。通过彻底理解每个分子的特性,MolTC为准确预测它们的相互作用建立了坚实的基础。具体来说,在预训练阶段,提示被统一设计如下:

这种提示设计使MolTC能够顺序地描绘出两个分子的关键属性。基于此,MolTC利用骨干LLM的生成损失来训练图编码器,以及表示投影器。值得注意的是,在这一阶段,骨干LLM保持冻结。为了确保骨干LLM能够理解每个分子的个体特性,准备一个包含分子对及其相应生化属性的全面数据集至关重要。为此,(1)作者首先对各种权威生化数据库如PubChem和Drugbank进行了广泛的调查,并收集了大量的分子-文本属性对;(2)然后,考虑到这个数据集内注解质量的可变性,作者对那些注解不够详尽的分子描述进行了增补;(3)随后,为了模拟多样的分子相互作用通过从上述数据库中随机组合两个不同的分子生成分子对。这种随机配对促进了广泛的分子组合范围,使预训练阶段暴露于多样的交互场景中,从而自然增强了MolTC的泛化能力。

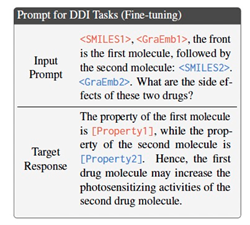

在微调阶段,MolTC被训练以使骨干LLM能够基于它最初识别的各个分子的属性来生成相互作用属性。为此,微调阶段的提示应为特定下游任务量身定制。例如,在DDI任务中,作者构造以下提示:

尽管这种提示设计的有效性,LLMs在定量分析方面面临显著挑战,特别是在复杂的分子相互作用上下文中,如SSI和色素-溶剂相互作用(CSI)。为了解决这个问题,引入了细粒度CoT概念来完善训练范式。具体来说,指导骨干LLM最初提出目标数值的范围,然后逐步细化为一个精确值。以一个为SSI任务精心设计的提示为例:

这一步骤式细化过程促进了对数值密集挑战的更准确和可靠解决。基于这些提示,在微调阶段,通过LoRA策略更新骨干LLM中的参数,该策略以其在根据下游任务的要求定制LLM以及在存储梯度时最小的内存需求而闻名。同时,为了确保其他模块被最优地调整以适应下游任务的具体情况,图编码器以及表示投影器遵循骨干LLM的生成损失进行训练。为了有效实施上述训练范式,作者引入了一种新颖的参数共享策略,该策略受到关键生化洞察的启发:1。角色的重要性:分子在相互作用中的角色至关重要地影响了结果。例如,在SSI场景中,如水-乙醇对,分别使用水和乙醇作为溶剂会产生不同的能量释放。有时,角色的颠倒甚至可能导致相互作用的缺失。2. 输入顺序的重要性:在某些分子对中,分子引入的顺序显著影响了相互作用。例如,药物引入的顺序可以导致不同的治疗效果。3.角色和顺序特定特征提取的重要性:分子的角色和输入顺序决定了它们结构特征的相关性。例如,溶质-溶剂对中的一个化学基团在作为溶质时可能对吉布斯自由能的释放至关重要,但在溶剂中则不那么重要。这些洞察激励MolTC适应性地优先考虑不同的关键信息,根据其角色和顺序为同一分子创建独特的标记。为了实现这种细致的学习,同时也利用分子学习的共享方面,作者引入了以下参数共享策略,如图2所示:1.基于GNN的编码器专注于提取分子图结构,在预训练和微调阶段共享参数,以提高学习效率。2.基于Qformer的投影器fpro1和fpro2,负责将分子结构与语义信息对齐,在预训练阶段共享参数,以促进泛化和鲁棒性。在微调阶段停止共享,以允许根据不同的角色和顺序进行定制化的语义映射。

实验部分

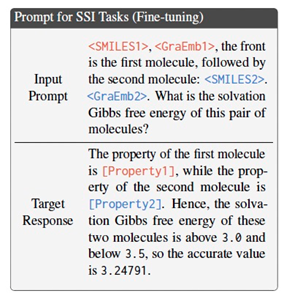

表 1

表1展示了在定性交互任务中的表现。从表1中可以得出以下结果:1.MolTC在定性相互作用预测中始终优于其对手。虽然基于GNN的方法表现值得称赞,在众多数据集上保持超过90%的准确率,但MolTC在每个评估场景中都超越了这些方法。例如,它在drugback数据集上的准确率提高了显著的1.05%,这一成就归功于LLMs的推理能力与GNNs在图建模方面的熟练性之间的协同作用。2与其他模型相比,MolTC结果的变异性,如标准偏差所示,始终较小。平均而言,MolTC的标准偏差比基于GNN的模型低35.41%,比基于LLM的模型低46.86%。MolTC性能的精确度主要归因于通过多层次CoT增强的训练范式,确保了一种细致和准确的推理过程。

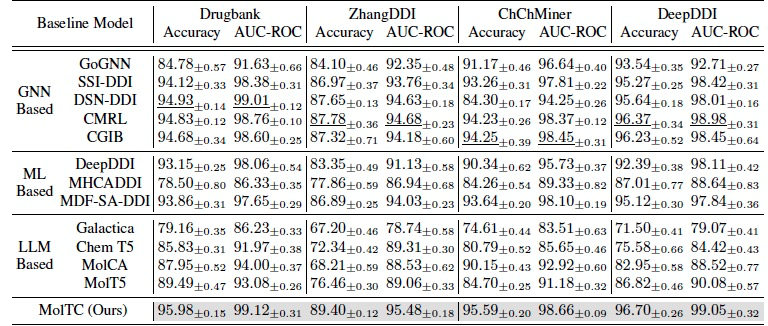

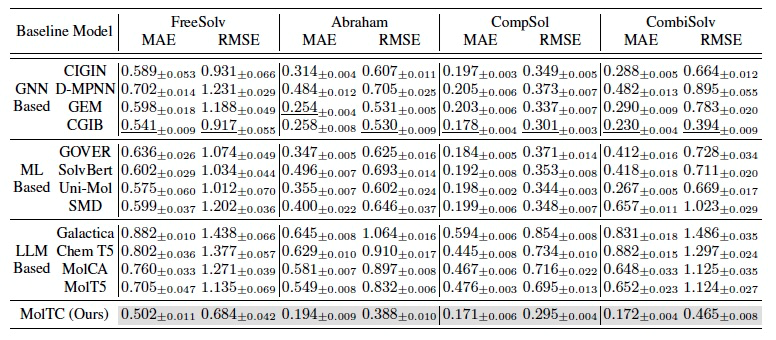

表 2

表2显示了在一部分定量任务中的表现。数据集提供了四维分子信息,包括原子类型、手性标签、键类型和键方向。表2的结果包括:1.MolTC在定量分析任务中继续领先,这是LLMs通常难以应对的领域。尽管CGIB设定了一个强大的基线,特点是跨数据集的低MAE和RMSE,MolTC在每个指标上都超过了它。例如,相对于CGIB,它在CombiSolv数据集上的RMSE降低了23.98%。这强调了利用SMILE表示和分子图结构之间相互作用的优势。4.总的来说,基于LLM的模型在定量任务中的表现不如传统的基于深度学习(DL)的模型,这归因于它们在跨数据集共享和转移学习到的分子相互作用见解方面的不足,以及缺乏CoT引导的推理。

编译 | 曾全晨

审稿 | 王建民

参考资料

Fang, J., Zhang, S., Wu, C., Liu, Z., Li, S., Wang, K., ... & He, X. (2024). Moltc: Towards molecular relational modeling in language models. arXiv preprint arXiv:2402.03781.

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢