我们想向大家宣布: 部署到 Cloudflare Workers AI 服务 正式上线,这是 Hugging Face Hub 平台上的一项新服务,它使得通过 Cloudflare 边缘数据中心部署的先进 GPU、轻松使用开放模型作为无服务器 API 成为可能。

我们将把 Hugging Face 上一些最受欢迎的开放模型整合到 Cloudflare Workers AI 中,这一切都得益于我们的生产环境部署的解决方案,例如

文本生成推理 (TGI) https://github.com/huggingface/text-generation-inference/

通过 部署到 Cloudflare Workers AI 服务,开发者可以在无需管理 GPU 基础架构和服务器的情况下,以极低的运营成本构建强大的生成式 AI (Generative AI) 应用,你只需 为实际计算消耗付费,无需为闲置资源支付费用。

这项新服务基于我们去年与 Cloudfalre 共同宣布的

战略合作伙伴关系 https://blog.cloudflare.com/zh-cn/partnering-with-hugging-face-deploying-ai-easier-affordable-zh-cn/

Cloudflare Workers AI 上的部署提供了一个简便、低成本的解决方案,通过

按请求计费模式 https://developers.cloudflare.com/workers-ai/platform/pricing

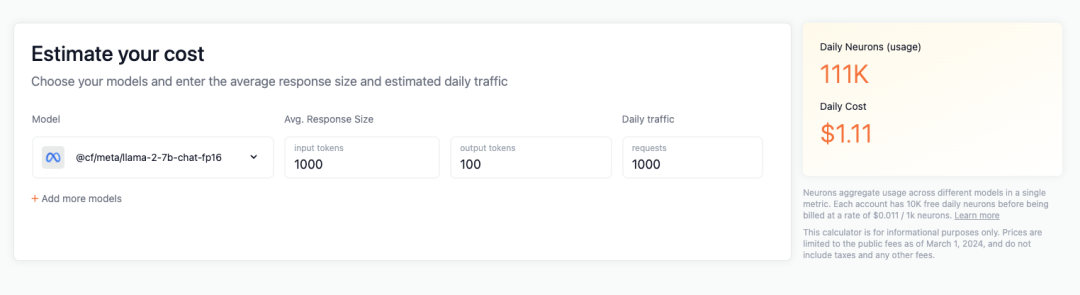

举个具体例子,假设你开发了一个 RAG 应用,每天大约处理 1000 个请求,每个请求包含 1000 个 Token 输入和 100 个 Token 输出,使用的是 Meta Llama 2 7B 模型。这样的 LLM 推理生产成本约为每天 1 美元。

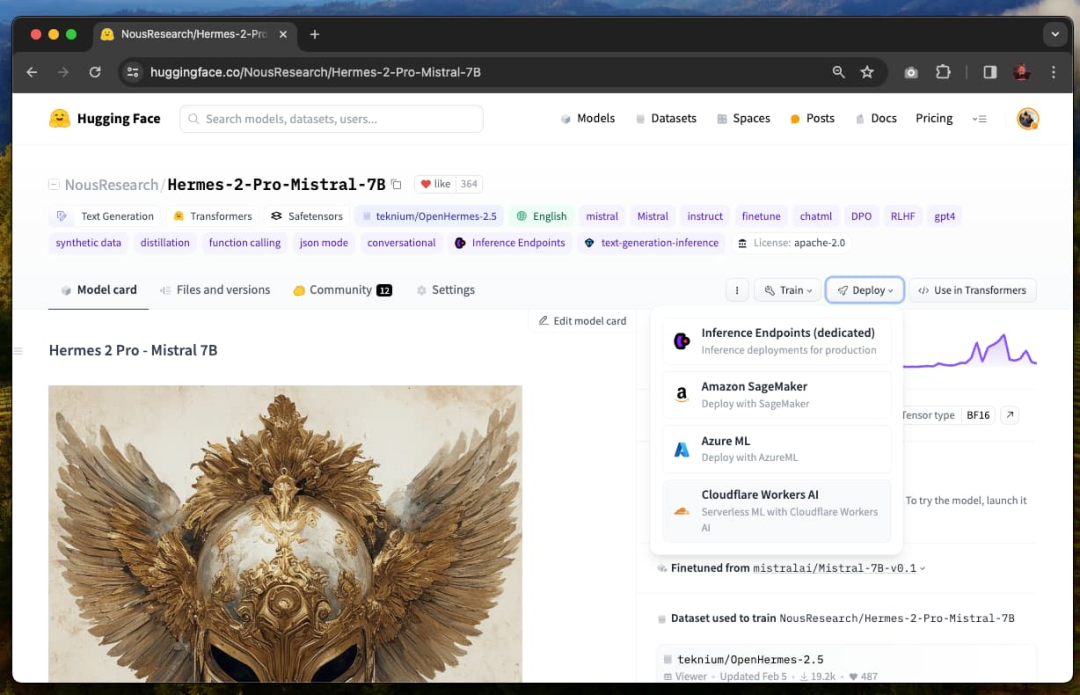

在 Cloudflare Workers AI 上使用 Hugging Face 模型非常简单。下面是一个如何在 Nous Research 最新模型 Mistral 7B 上使用 Hermes 2 Pro 的逐步指南。

你可以在

Cloudflare Collection https://hf.co/collections/Cloudflare/hf-curated-models-available-on-workers-ai-66036e7ad5064318b3e45db6

Cloudflare 账户 https://developers.cloudflare.com/fundamentals/setup/find-account-and-zone-ids/ API 令牌 https://dash.cloudflare.com/profile/api-tokens

你可以在所有支持的模型页面上找到“部署到 Cloudflare”的选项,包括如 Llama、Gemma 或 Mistral 等模型。

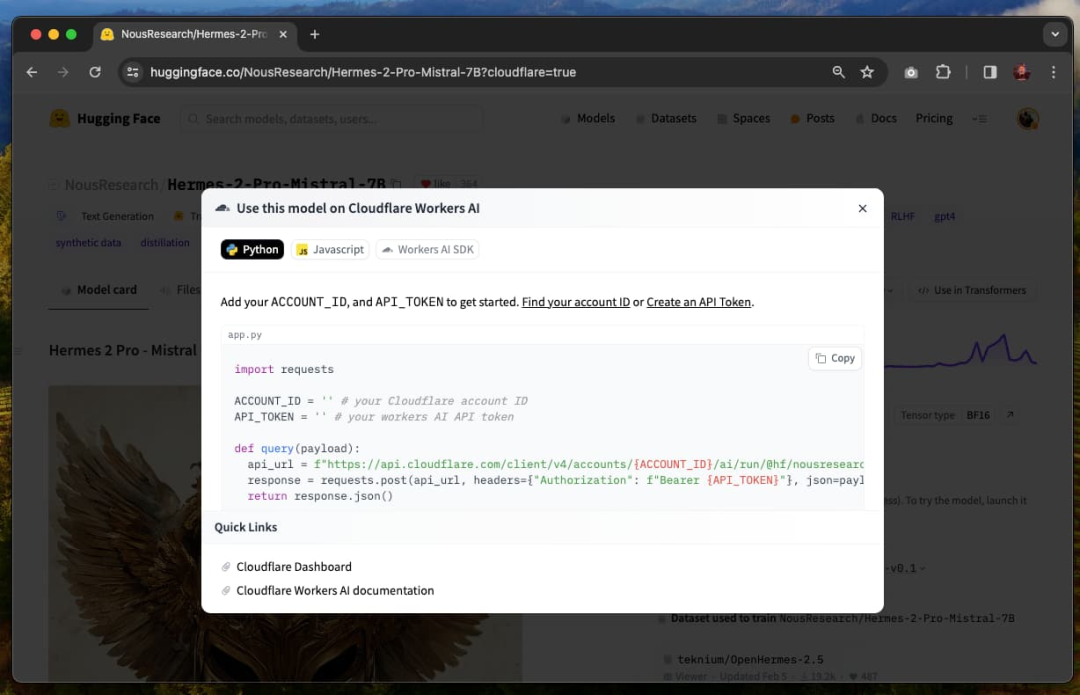

打开“部署”菜单,选择“Cloudflare Workers AI”,这将打开一个包含如何使用此模型和发送请求指南的界面。

当前有两种方式可以使用此集成: 通过

Workers AI REST API https://developers.cloudflare.com/workers-ai/get-started/rest-api/ Cloudflare AI SDK https://developers.cloudflare.com/workers-ai/get-started/workers-wrangler/#1-create-a-worker-project ACCOUNTID https://developers.cloudflare.com/fundamentals/setup/find-account-and-zone-ids/ APITOKEN https://dash.cloudflare.com/profile/api-tokens

就这样!现在你可以开始向托管在 Cloudflare Workers AI 上的 Hugging Face 模型发送请求。请确保使用模型所期望的正确提示与模板。

我们很高兴能与 Cloudflare 合作,让 AI 技术更加易于开发者访问。我们将与 Cloudflare 团队合作,为你带来更多模型和更棒的体验!

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢