新智元报道

新智元报道

【新智元导读】这几天的维也纳,上演了一场AI圈的狂欢。在ICLR 2024上,图灵巨头LeCun、Bengio纷纷现身,直接让现场挤爆,变成追星现场。

这几天,AI届的盛会——ICLR在维也纳举办。

OpenAI、Meta、谷歌、智谱AI等世界前沿AI科技企业齐聚一堂。

现场名流云集,星光耀眼,走几步就能偶遇一位发过颠覆性paper的大咖。

毫无意外地,ICLR 2024展厅也变成了追星现场。热闹的气氛,快把屋顶掀翻了。

现场追星图灵巨头

图灵三巨头中的著名「e人」LeCun,提前就在X上大方公布出自己的行程,满怀期待地等着和粉丝们相见了。

在评论区,不仅有粉丝激动打卡,甚至还有准备现场递简历的。

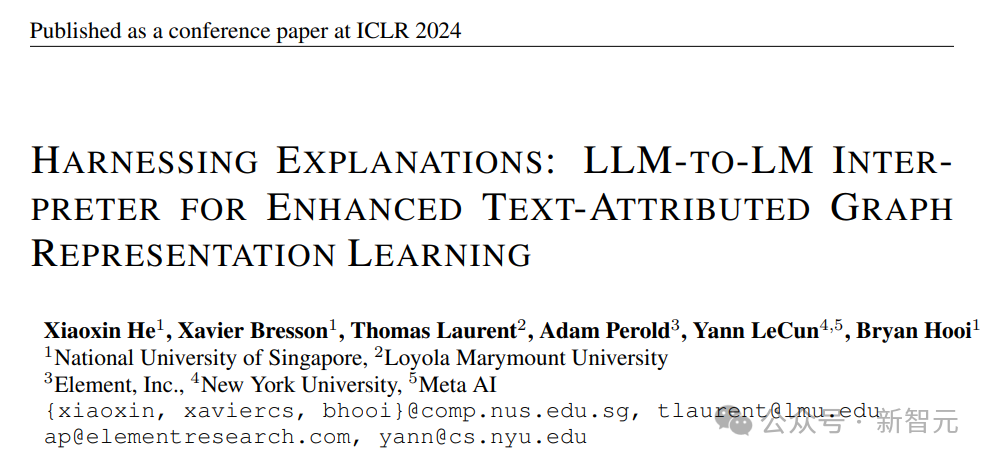

粉丝们果然不虚此行,在现场,LeCun口若悬河地讲解,热情的观众们在周围形成密实的包围圈。

论文地址:https://arxiv.org/abs/2305.19523

论文地址:https://arxiv.org/abs/2311.12983

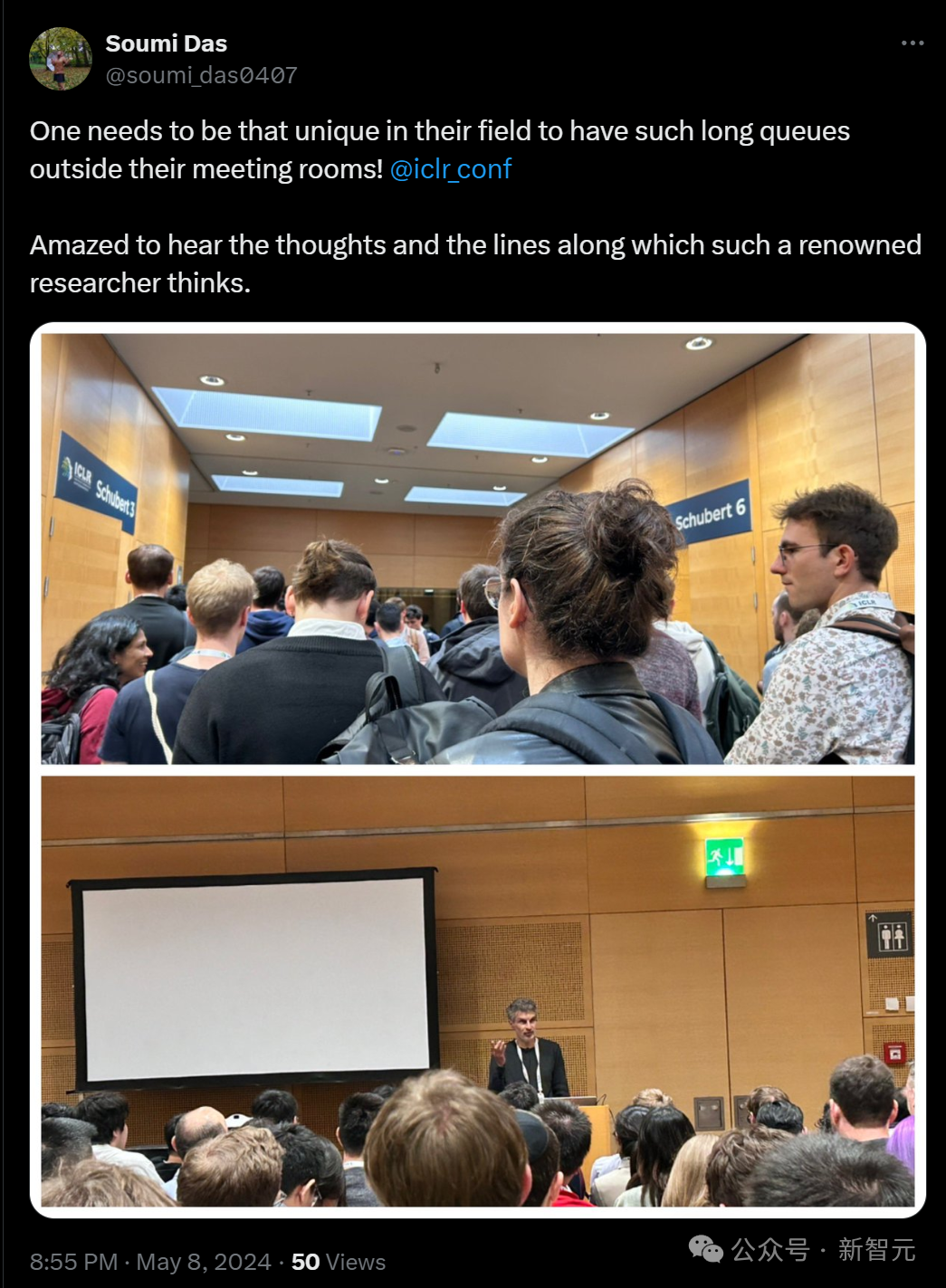

另一位图灵巨头Yoshua Bengio,也显示了自己的超高人气。

现场观众总结道:「一个人真的需要在他的领域中做到独一无二,才能让他的会议室外排起如此长的队伍!」

此前LeCun和Hinton都对此发表过言辞激烈的意见,Bengio的态度似乎一直比较模糊,迫不及待想知道他对于AGI是什么看法了。在即将到来的5月11日,他就会在一场关于AGI的Workshop中发表演讲。

值得一提的是,Bengio团队也在今年的ICLR上获得了杰出论文荣誉提名。

论文地址:https://openreview.net/pdf?id=Ouj6p4ca60

谷歌Meta隔壁,智谱AI也在

现场,谷歌开源模型Gema、机器人智能体背后框架Robotics Transformers,以及其他开创性的研究一并呈现。

紧挨着Meta和谷歌,展厅中间有一家非常亮眼的公司——智谱AI。

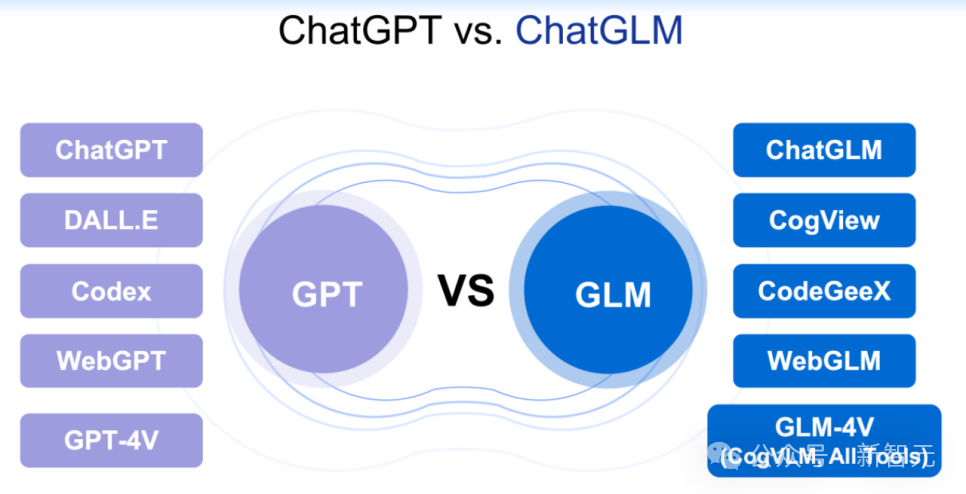

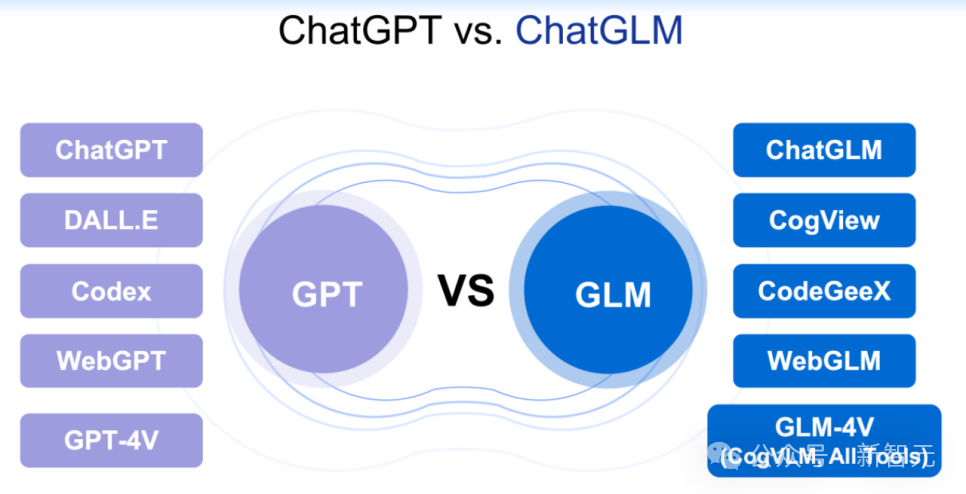

现场的童鞋正为大家介绍GLM-4、ChatGLM等一系列研究成果。

特邀演讲

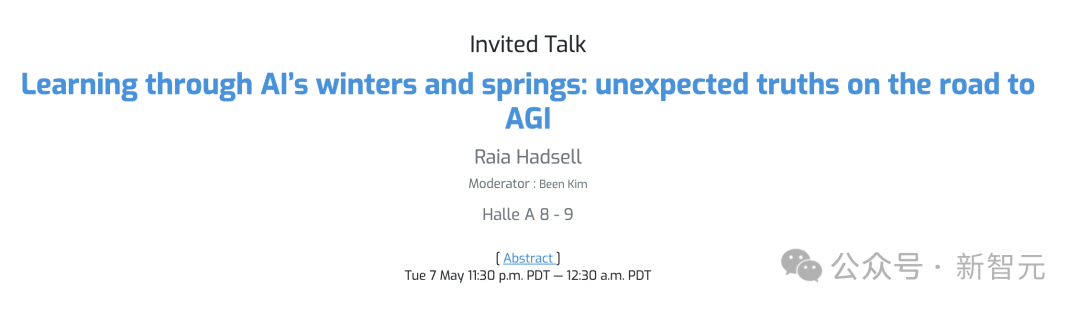

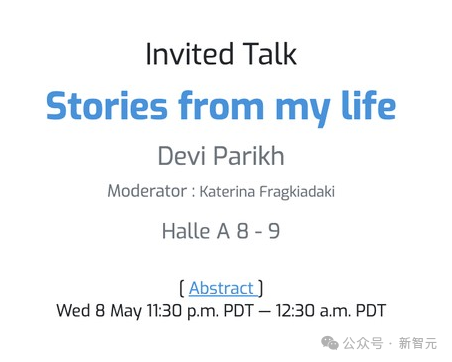

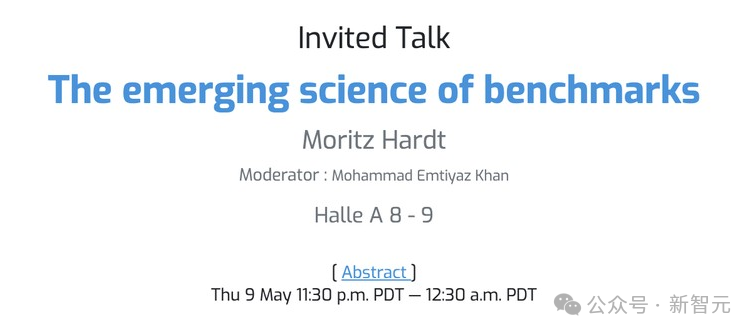

展厅精彩演示之外,今年的ICLR,共邀请了七位特邀演讲嘉宾,分享他们对AI的见解。 有来自谷歌DeepMind的研究科学家Raia Hadsell,佐治亚理工学院副教授&FAIR首席科学家Devi Parik,有来自马克斯·普朗克计算机科学研究所(MPI-SWS)的主任Moritz Hardt,唯一一家中国团队是智谱AI 的GLM 大模型技术团队。

Raia Hadsell

Devi Parikh

Moritz Hardt

GLM Team

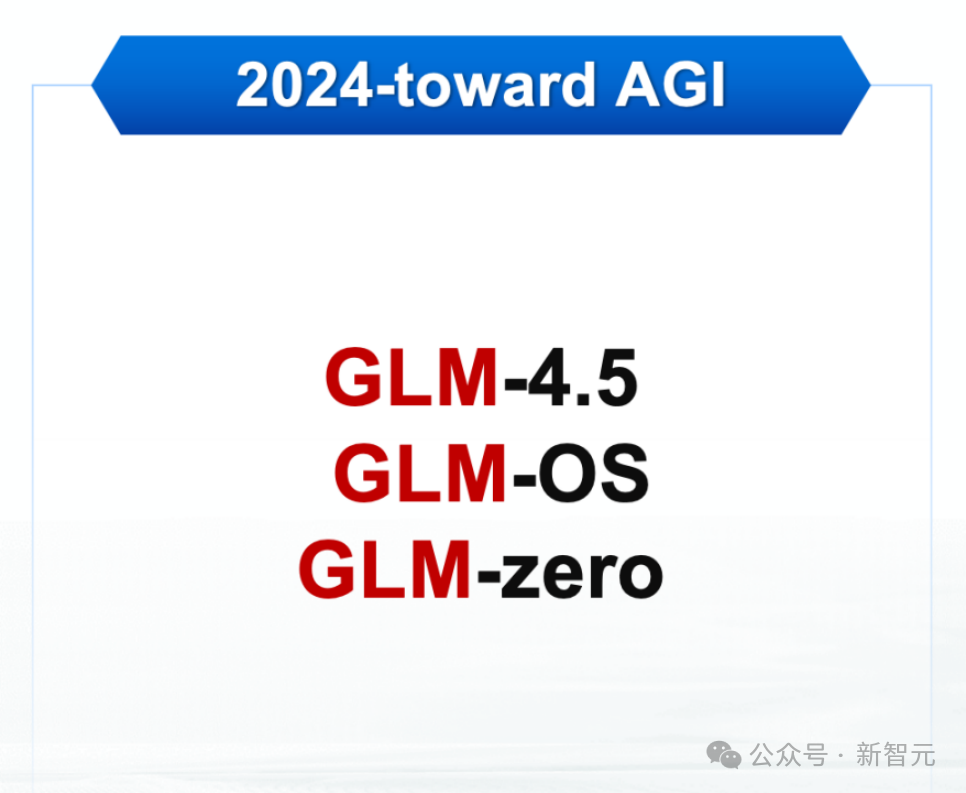

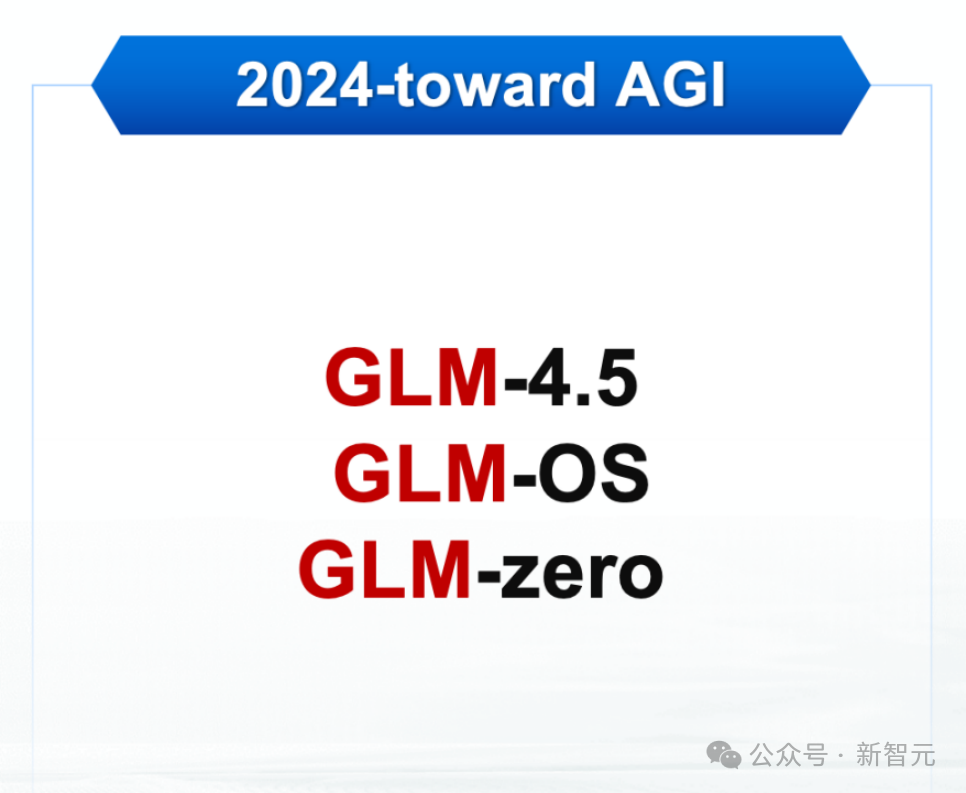

在ICLR上,GLM大模型团队介绍了面向AGI的GLM三大技术趋势。 通往AGI的必经之路在哪里? 业界对此意见不一。有人认为是智能体,有人认为是多模态,有人说,Scaling Law是通往AGI的必要非充分条件。 而LeCun坚持认为,LLM是通往AGI的一条歧路,靠LLM带不来AGI。 对此,团队也提出了自己的独特观点。

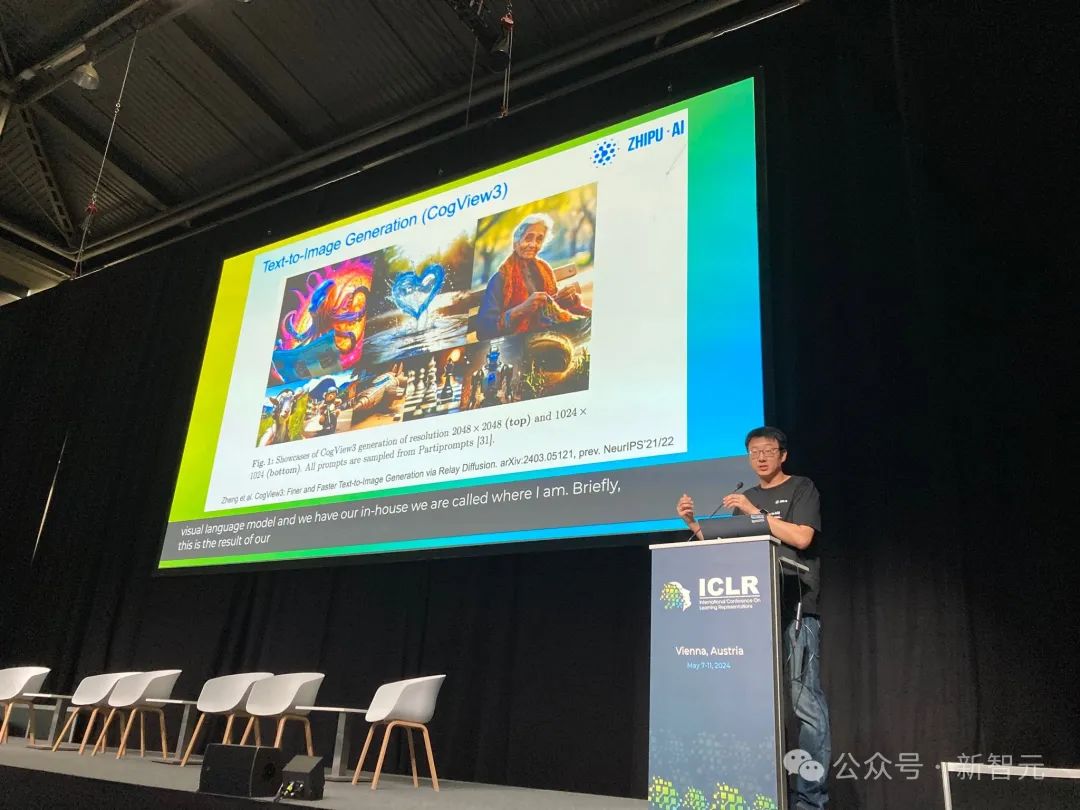

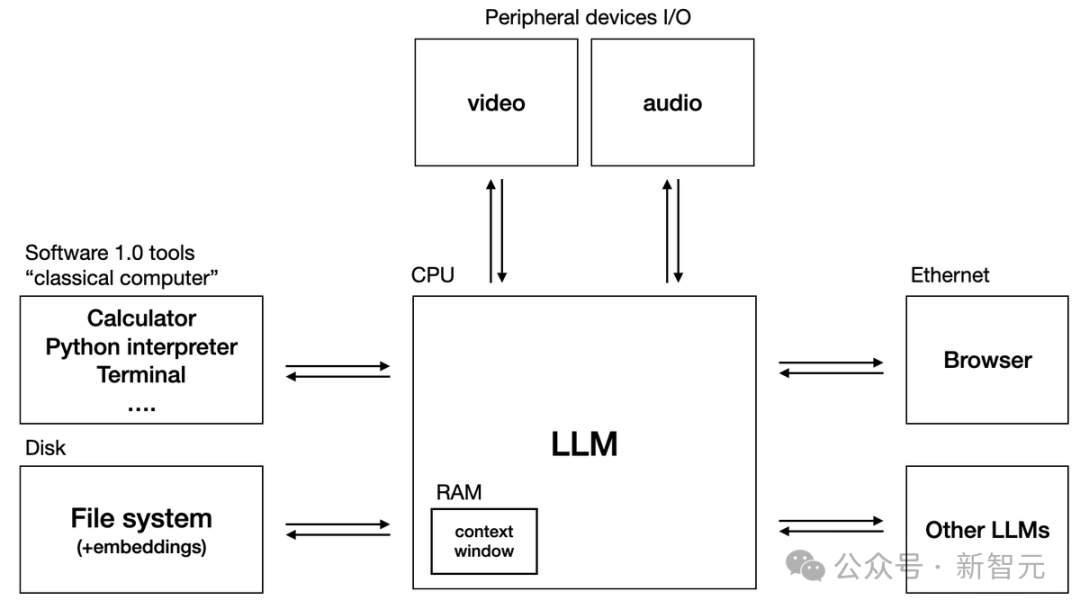

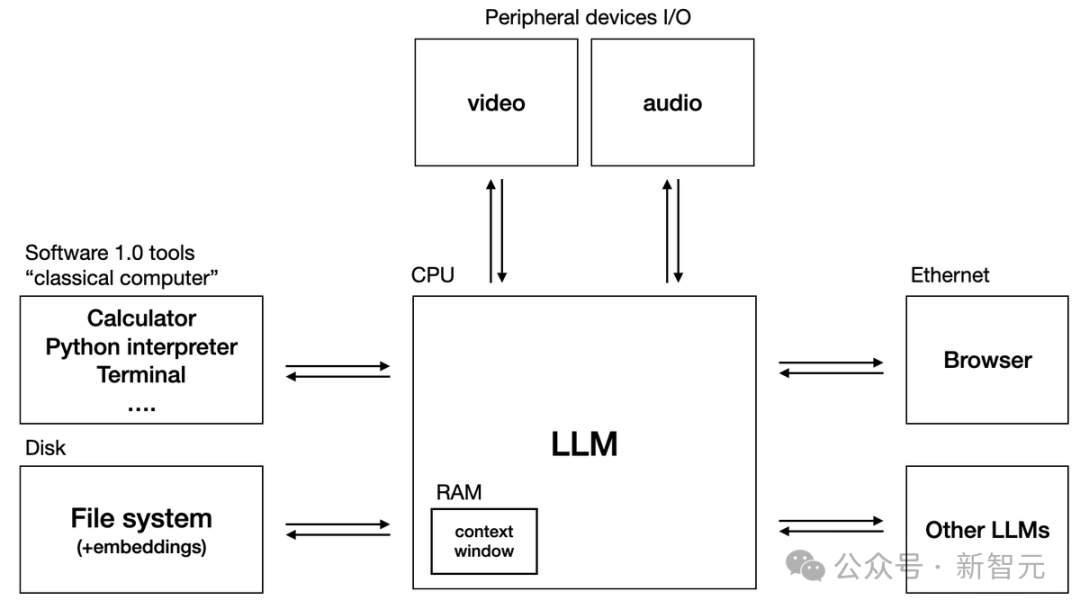

首先,他们讲到了GLM-4的后续升级版本,即GLM-4.5及其升级模型。 GLM-4的后续升级版,将基于超级认知(SuperIntelligence)和超级对齐(SuperAlignment)技术,同时在原生多模态领域和AI安全领域有长足进步。 GLM大模型团队认为,在通往AGI的路上,文本是最关键的基础。 而下一步,则应该把文本、图像、视频、音频等多种模态混合在一起训练,变成一个真正的「原生多模态模型」。 同时,为了解决更加复杂的问题,他们还引入了GLM-OS概念,即以大模型为中心的通用计算系统。 这一观点,与Karpathy此前提出的大模型操作系统的观点,不谋而合。

在ICLR现场,GLM大模型团队详细介绍了GLM-OS的实现方式: 基于已有的All-Tools能力,再加上内存记忆(memory)和自我反馈(self-reflection)能力,GLM-OS有望成功模仿人类的PDCA机制,即Plan-Do-Check-Act循环。

具体来说就是,首先做出计划,然后试一试形成反馈,调整规划然后再行动以期达到更好的效果。 依靠PDCA循环机制,LLM便可以自我反馈和自主进化——恰如人类自己所做的一样。 此外,GLM大模型团队还透露,自2019年以来,团队就一直在研究名为GLM-zero的技术,旨在研究人类的「无意识」学习机制。 「当人在睡觉的时候,大脑依然在无意识地学习。」

GLM大模型团队表示,「无意识」学习机制是人类认知能力的重要组成部分,包括自我学习、自我反思和自我批评。 人脑中存在着「反馈」和「决策」两个系统,分别对应着LLM大模型和内存记忆两部分。 因此,GLM-zero的相关研究将进一步拓展人类对意识、知识、学习行为的理解。 尽管还处于非常早期的研究阶段,但GLM-zero可以视为通向AGI的必经之路。 而这,也是GLM大模型团队首次向外界公开这一技术趋势。 国内顶流技术团队

国内顶流技术团队

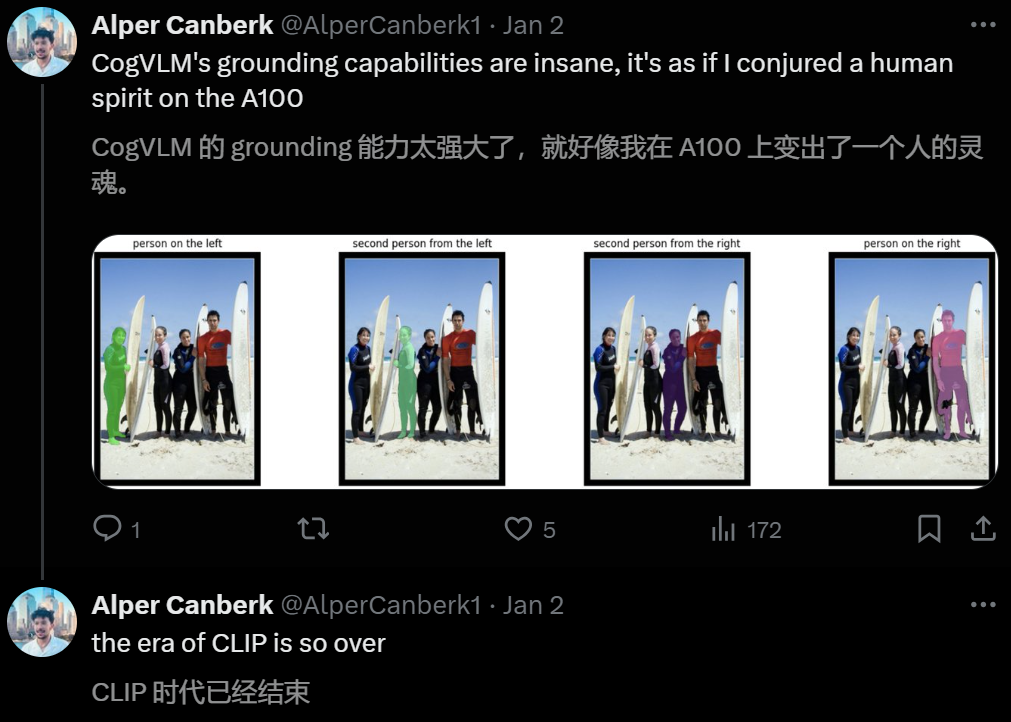

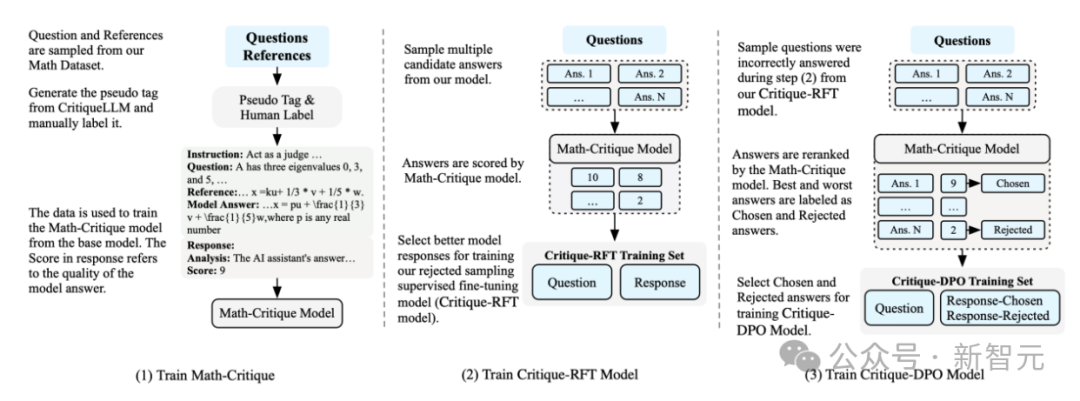

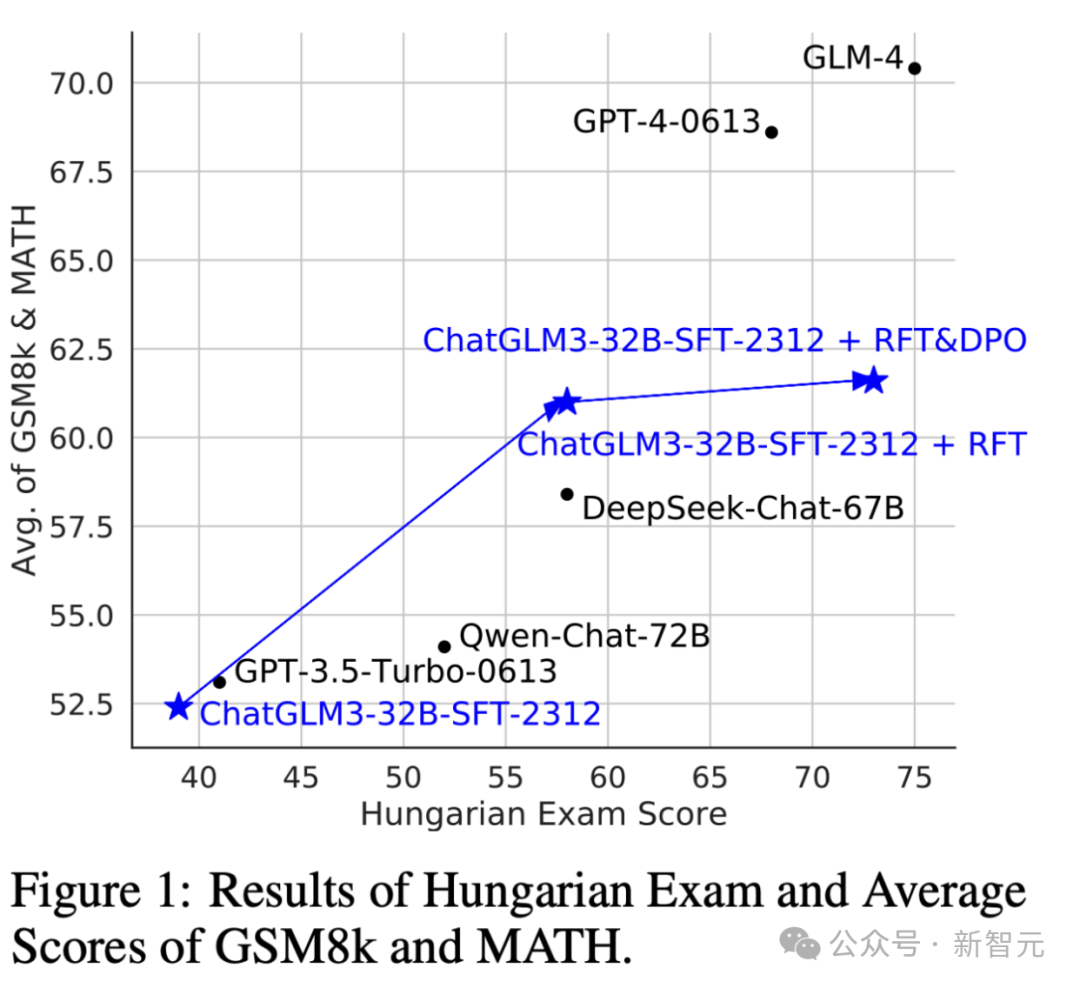

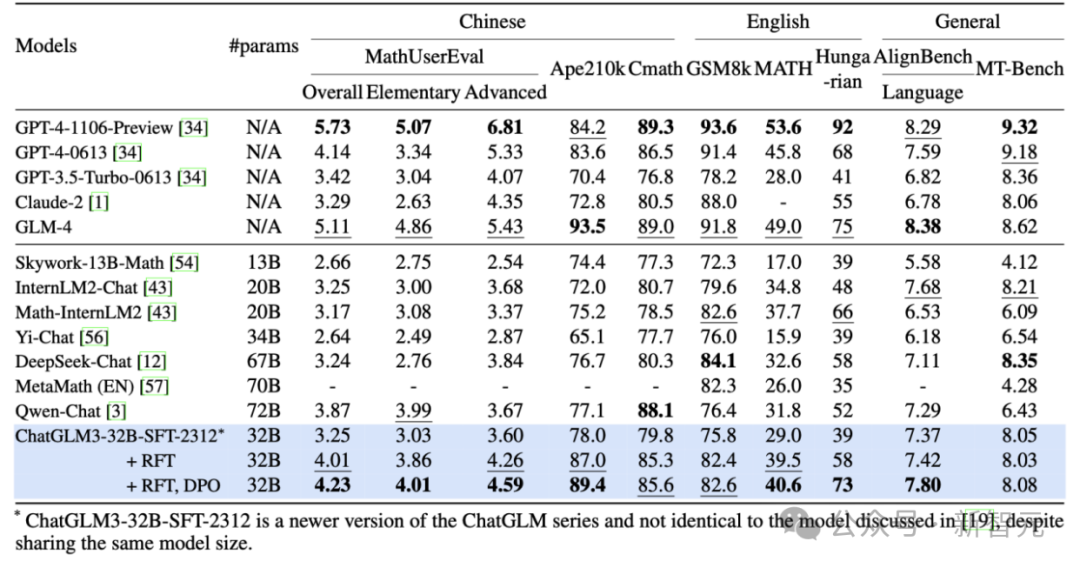

2020年底,GLM大模型技术团队研发了GLM预训练架构。 2021年训练完成百亿参数模型GLM-10B,同年利用MoE架构成功训练出收敛的万亿稀疏模型。 2022年还合作研发了中英双语千亿级超大规模预训练模型GLM-130B并开源。 而过去一年里,团队几乎每3-4个月,就完成一次基座大模型的升级,目前已经更新到了GLM-4版本。 不仅如此,作为国内最早入局LLM公司,智谱AI曾在2023年就设立了一个雄心勃勃的目标——全线对标OpenAI。 GLM大模型技术团队构建了基于AGI愿景的完整大模型产品矩阵。 在GLM系列之外,还有CogView文生图模型、CodeGeeX代码模型,多模态理解模型CogVLM,再到GLM-4V多模态大模型和All-Tools功能以及AI助手智谱清言。

与此同时,GLM大模型技术团队的研究人员,在业界有着极高的影响力。 比如,圈里爆火的李飞飞主讲斯坦福大学CS25课程,每次都会邀请Transformer研究前沿的专家,分享自己的最新突破。 而目前已经确定,CS25课程的嘉宾中,就有来自智谱AI的研究员。

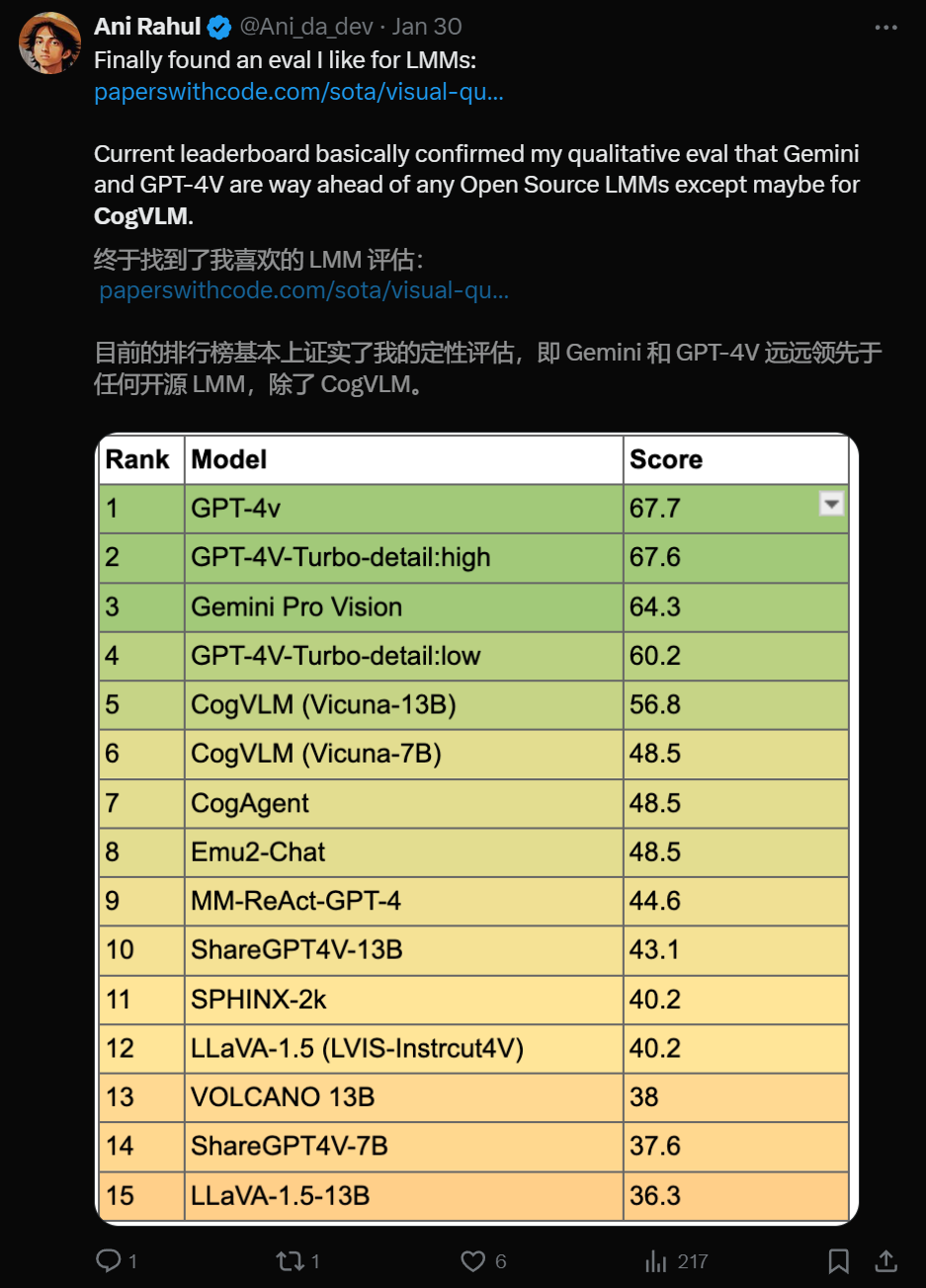

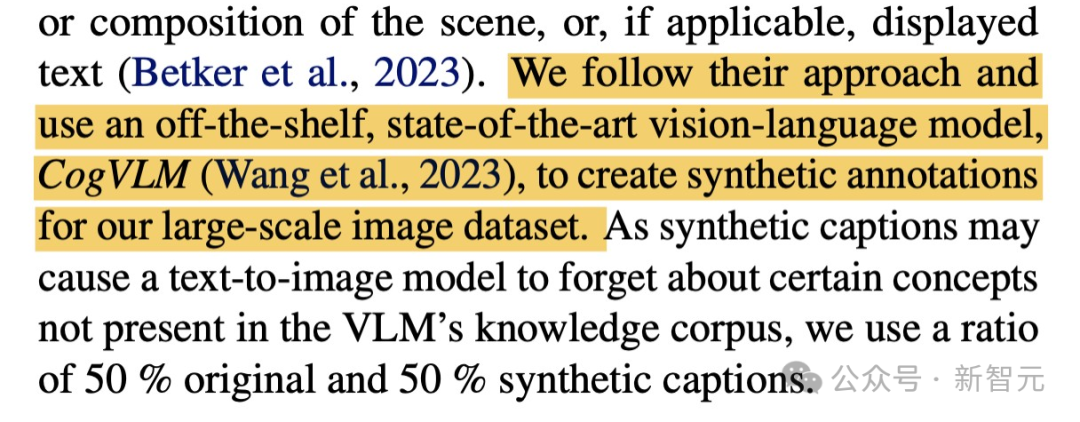

CogVLM 团队开发的开源视觉语言模型CogVLM,一经发布就引发了业界关注。 3月Stability AI公布的一篇论文就显示,因性能太出色,CogVLM直接被Stable Diffufion 3拿来做图像标注了。

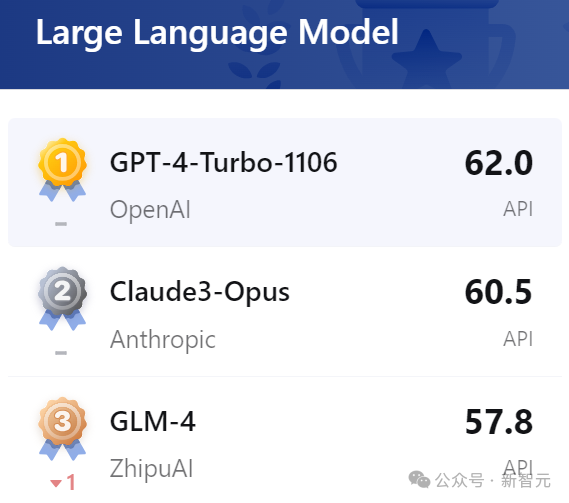

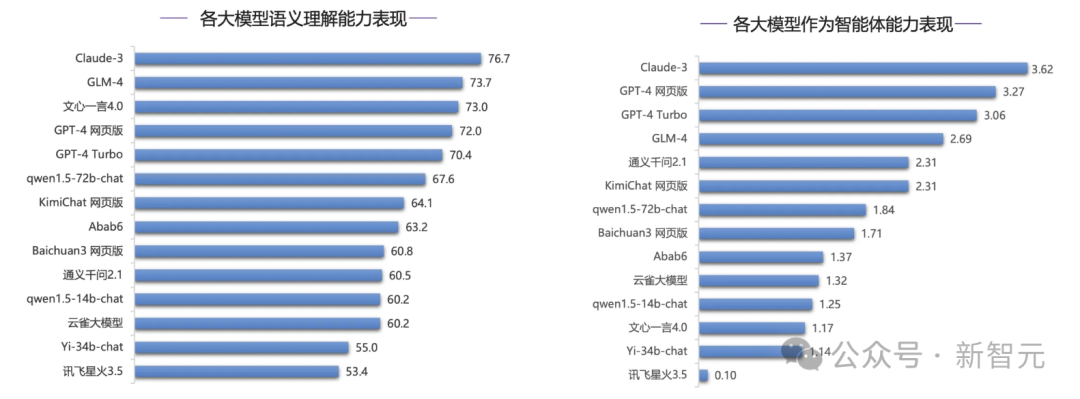

GLM-4跻身全球第一梯队

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢