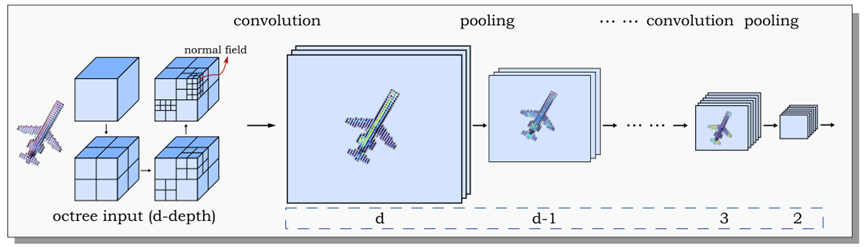

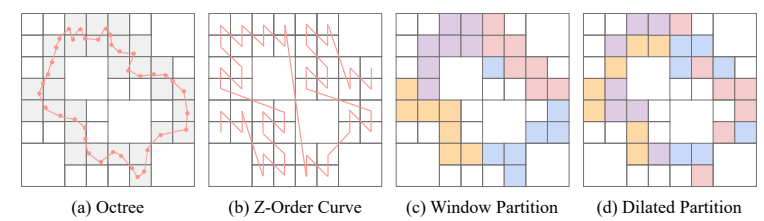

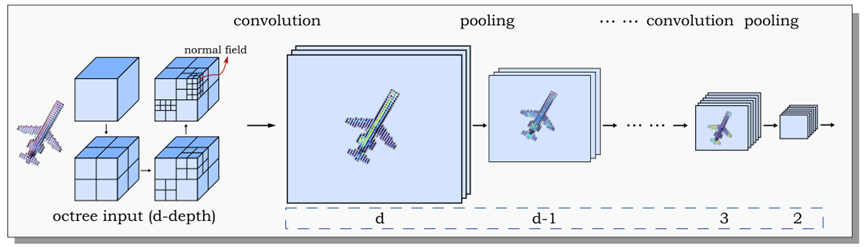

从清华到微软再到北大,他完成了从学生到研究员再到博导的蜕变;从发文顶刊到期刊审稿再到顶会获奖,他一路“升级打怪”,在计算机图形学领域不断深耕,他的人生信条是——持之以恒做高质量研究。在 AMiner 团队推出的 AI 2000 学者中,他多次入选计算机图形学领域最具影响力学者。他就是王鹏帅,现为北京大学王选计算机研究所助理教授。日前,AMiner 与他进行了一次深入对话。https://www.aminer.cn/profile/542db030dabfae489b98945fhttps://wang-ps.github.io/王鹏帅 2013 年本科毕业于清华,并凭借优异的成绩直博进入清华高等研究院,自此开启了他与计算机图形学研究的不解之缘。2015 年,他的首篇论文顺利发表在计算机图形学顶级期刊 ACM Transactions on Graphics 上。博士毕业后,王鹏帅基于博士期间就在微软亚洲研究院开展取得的一系列成果,选择在这里担任研究员,继续“揭秘”三维数据的理解与构建。2022 年 9 月,手握几十篇顶刊论文的他,选择加入北京大学王选计算机研究所。离开工作近十年的环境,为什么选择从工业界回归学术界呢?王鹏帅提到,进入一所顶尖学府从事科研工作,是他最初的愿望,也是他的初心使然。“可以说从本科开始,我就常常想,要成为一个有用的人才,为国家、为社会做贡献。”当然,看似水到渠成的“升级”,来源于王鹏帅在科研上的努力和对自己的极高要求。博士毕业时,他虽然已经有不少顶会论文,但他也清晰地认识到自己的科研成果与科研能力还有不少可以精进的空间。于是接下来的几年里,他以代码为戈,以做出高质量研究为战场,一篇篇论文、一项项获奖,成为了他迎接新机会的敲门砖。进入北大任教后,新的挑战也在前方等待:要以一己之力完成实验室建设,担起教书育人之责,同时还要保证科研产出。就是在这一次次的挑战中,他收获了一项巨大的肯定——王鹏帅被授予 2023 年亚洲图形学学会青年学者奖,要知道,该奖项每年在亚太地区仅颁发给一名获奖者。提到科研道路上自己最引以为豪的成果,王鹏帅列举了两篇论文。一篇是在 2017 年读博期间,他与刘洋、童欣等研究员所组团队完成的论文,题为“O-CNN: octree-based convolutional neural networks for 3D shape analysis”(SIGGRAPH 2017)。为了解决三维神经网络效率低下的问题,他们创造性地提出基于八叉树的三维卷积神经网络(O-CNN),该方法利用三维数据的稀疏性,结合高效的八叉树数据结构,把神经网络的运算和存储限制在非零的三维稀疏信号上。在输入信号分辨率比较高时,相对于基于体素的三维卷积神经网络,该方法在内存、时间效率上都达到了上百倍的提升。这篇论文目前已获得超过 1000 次引用量,可以说在计算机图形学领域轰动一时。图 | 王鹏帅团队提出的基于八叉树的稀疏卷积神经网络(O-CNN)图示:用八叉树表示输入形状,并将三维 CNN 的运算和存储限制到八叉树节点上,即非零信号上。

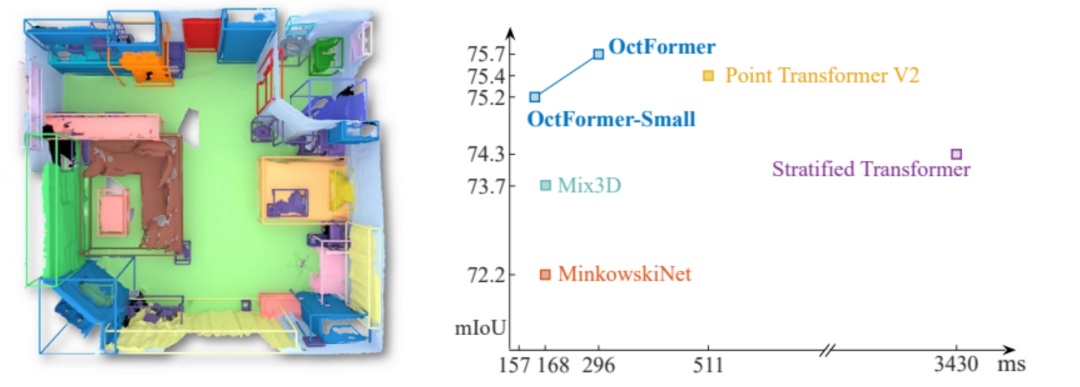

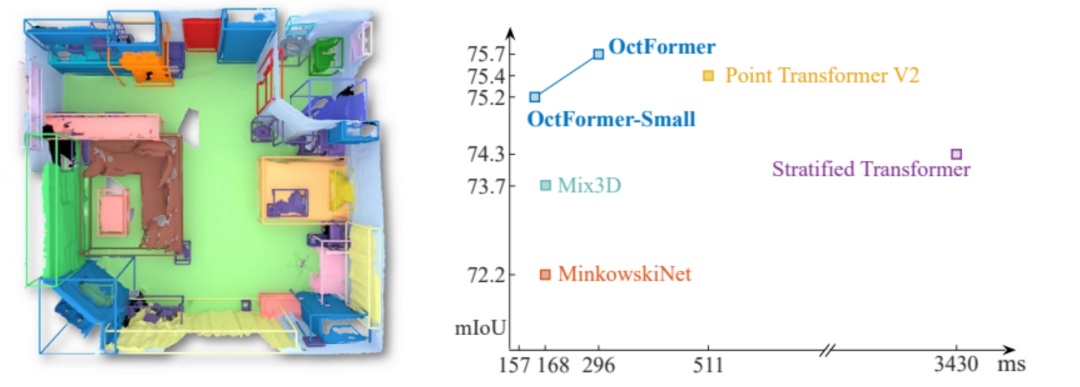

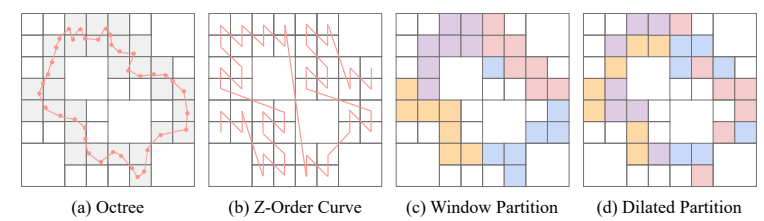

取得这一阶段性的成功后,王鹏帅立刻将目光聚焦到更宏大的目标上:“三维数据的表达非常丰富,导致现在还没有一个通用的神经网络框架或方法,能够非常便捷高效地应用于各类数据及任务,比如 3D 生成、渲染甚至仿真任务。”“所以我想要做出这样一种通用的三维深度学习框架。”在这一想法的驱动下,他几乎是怀着迫切的心情,反复琢磨试验,于 2023 年独立完成了第二篇得意之作“OctFormer: Octree-based Transformers for 3D Point Clouds”(SIGGRAPH 2023)。在这篇论文中,他巧妙地发掘了八叉树数据结构在提升 Transformer 速度上的出色性能,提出的点云注意力机制可以通过开源库在 10 行代码中实现,并且当点数超过 200k 时,运行速度比其他已有注意力机制快 17 倍。图 | 王鹏帅提出的OctFormer框架与其他典型框架在ScanNet场景分割任务上的速度与性能对比(来源:OctFormer: Octree-based Transformers for 3D Point Clouds)用王鹏帅的话来说,这一关键的发现来源于他某天的“灵感乍现”。OctFormer 利用了八叉树极强的空间局部性,将看似无序的 3D 点云排序为一个个包含点数相同的窗口,这样一来,各窗口并行执行注意力机制时将不再出现阻塞现象,极大地提升了运算效率。图 | 使用 OctFormer 对点云的划分排序始终是均匀的。(a)八叉树将包含点云区域划分为一个个正方形窗口;(b)对窗口进行 Z 形排序;(c)窗口划分,保证相同颜色区域所包含的窗口数量均为 7;(d)扩张加倍时 OctFormer 对点云的划分,仍保证所包含数量为 7。但实际上,科研道路上的这种“灵感乍现”,从来不可能是幸运女神的眷顾,而是来自于王鹏帅对于自己研究的坚定与坚持。“我们于 2017 年提出的八叉树卷积神经网络 O-CNN 在图形学领域非常出名,但在计算机视觉领域却相对应用较少。在我们的 O-CNN 发表之后,计算机视觉领域的研究人员于 2018 年研发了基于哈希表的稀疏卷积,并做了很好的开源代码实现。基于哈希表的稀疏卷积和我们的 O-CNN 的执行方式其实是完全一样的,唯一的区别是他们使用了哈希表来组织稀疏数据,而我们使用了八叉树。在深入对比二者之后,我发现八叉树的卷积在 GPU 上更好实现。构建八叉树等效于对点云进行 Z 形状的排序,数据的空间局部性也更强,因而在 GPU 执行效率也会更高。当大家都被基于哈希表的稀疏卷积吸引时,我坚信八叉树的神经网络会有更强的性能并长期地使用它,可以说我对八叉树的各种性质特点已经烂熟于心,因此才会激发我做出 OctFormer。”当王鹏帅想到这个 idea 后,他独自编码、做实验、写论文,仅用 5 个多月的时间,就顺利做出了这项成果,并发表于著名的计算机图形学顶会 SIGGRAPH 2023 上。这给了王鹏帅极大的信心,“我觉得此前的坚持全都值了!所以还是要坚持去做自己认为有道理的事情。”接下来,王鹏帅希望继续在 Transformer 这种自由建模基础上,抓住三维数据的自适应性与稀疏性,不断尝试将这一神经网络迭代,未来进一步实现一个统一的三维神经网络。目前,他已经招收两名直博生,作为青年一代的博士导师,他倾向于为学生创造自由宽松的学习环境,喜欢与学生开展平等的交流。他说:“我从来不认为作为老师,我就非常权威。相反,给与年轻人发挥自主性的空间,他们才能在自我驱动下,不断探索学术前沿。”也因此,学生们很愿意向这位“师哥”倾吐做科研时而袭来的焦虑之感。论文被拒稿?科研进展较为缓慢?看着日新月异的学术更迭,王鹏帅给出了自己的答案——正因为走到了强者如云的环境中,才能印证和鞭策自我不断进步。他相信,克服焦虑的秘诀是“持之以恒做高质量的研究”。作为走遍清华、微软和北大的前辈,王鹏帅还分享了工业界和学术界的一些特点:“在工业界中,科研硬件条件非常充足,攻克难关主要依靠自己的头脑;而在学术界中,不断地交流与集体的智慧是非常好的助益,但需要主持实验室建设、处理项目申报等学术副线。”那么究竟是进入工业界还是学术界呢?他建议首先确定优先级,想清楚自己想做什么,保有一份对科研的“初心”,其次才是决定去往哪里。也正是因为这一份做科研的初心,王鹏帅才能在这条无止境的道路上不断前行,绽放光芒。

王鹏帅教授是 AI 2000 百强青年华人学者之一,想要深入了解其他相关学者,请查看:https://www.aminer.cn/open/scholar/6641c5b9a05b27f854d0f363 AI 2000学者排名由AMiner科技情报分析与挖掘平台发布,旨在通过AMiner学术数据在全球范围内遴选过去十年人工智能学科最有影响力、最具活力的AI顶级学者。2024年AI 2000学者排名评选基于2014-2023十年间人工智能领域46家顶级期刊会议收录的共计212,944篇论文、274,682位作者的大数据,采用智能算法自动化生成排名,得到200位“AI 2000最具影响力学者奖”以及1800位“AI 2000最具影响力学者提名奖”。点击【阅读原文】了解更多关于AI 2000排名的完整内容

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢