前言:主权人工智能及其作用与潜在影响对于全球发展意义重大

在2024年世界政府峰会上,英伟达创始人兼CEO黄仁勋提出了“主权人工智能”(Sovereign AI)的概念。他表示,每个国家都需要拥有自己的AI基础设施,以便保护自己的文化和经济安全。以新加坡启动一项耗资7000万美元的发展主权人工智能计划为例,这个概念引起了一波全球投资的热潮。各国开始努力保持对其人工智能技术的控制和独立发展能力,以保护其经济、文化和地缘政治利益。随着主权人工智能的概念成为了时下全球政治局势的一大热点,信息安全、数据主权等成为了核心议题。一方面,随着人工智能技术成为国家认同和连续性的一部分,主权人工智能也成为了新时代下国家主权的延伸。因此,黄仁勋提出的构建“主权AI”基础设施不仅是技术发展的某种必然选择,更是国家安全和未来发展的战略需要。另一方面,在主权人工智能的实践层面,这一目标也会面临诸多挑战:技术壁垒、资源分配、国际合作等。各国的主权人工智能技术发展和应用可能形成割据局面,缺乏统一的标准和监管机制。此外,过于强调国家主权可能忽略社会公平和包容的重要性,进一步显化主权人工智能技术背后的伦理问题。主权人工智能及其作用与潜在影响对于全球发展意义重大,值得我们深入了解并辩证地去思考这一概念。

Part3

主权人工智能现阶段/潜在的影响是什么?

1.发展主权人工智能技术可能面临的问题

2.发展主权人工智能需要的标准与道德原则

简单来说,主权人工智能代表着国家对人工智能技术和相关数据的独立控制,其中包括部署和运营人工智能技术,构建硬件和软件基础设施,以及掌握运营和保护数据的政策和人员。这种对于独立性的强调确保了主权人工智能与特定文化、监管和社会经济背景的一致性,成为了一个国家创新、安全和经济增长的重要战略资产。在主权人工智能的发展中,有以下几大核心原则:-人工智能发展中的自决和自主:人工智能系统的开发、部署和运营不依赖于外国实体或技术,即确保各国不依赖外部资源获得关键的人工智能能力。-数据主权:开发主权人工智能的国家坚持要控制其数据。这需要在国家边界内存储和处理数据,并遵守当地法律法规,以保护数据免受外国访问。-经济和社会政治战略:主权人工智能与国家经济增长战略和地缘政治杠杆有关。它旨在利用人工智能促进社会经济发展,同时维护国家安全利益。-强大的基础设施:包括物理基础设施和数据基础设施,而后者包括主权基础模型,比如大语言模型。强大的基础设施是构建主权人工智能和实现新质智能生产力的重要手段。-劳动力发展:构建主权人工智能还需要熟练的国内劳动力,包括人工智能工程师、数据科学家和研究人员。-伦理发展与规范:人工智能的伦理方面对于主权人工智能计划至关重要。这包括确保人工智能系统的透明度、公平性、安全性和问责制。各国的目标是开发符合道德规范并解决社会和环境问题的人工智能技术。这些核心原则分别形成了构建主权人工智能的必要组件,即共同确保一个国家能够独立开发、部署和利用人工智能技术并保持对其进步的控制的条件:-对于实现人工智能的自决和自主:国家需要达成技术自主,独立开发和控制人工智能技术,以适应当地需求。其中,投资研发与创新对于推动主权人工智能的发展至关重要。政府应提供资金分配和激励措施以支持基础研究、应用研究和创新的商业化。各国也应当在企业与学术研究机构之间建立一个共生的创新生态系统,促进伙伴关系和进一步合作。-对于实现数据主权:国家需要拥有独立控制数据以确保其在国界内保持安全的能力。-对于顺应经济和社会政治战略:国家需要确保其人工智能技术的经济和安全影响,即通过战略人工智能能力提升国家安全和经济竞争力。-对于构建强大的基础设施:国家需要具有先进计算能力可以高效处理和分析海量数据的一流数据中心和可以确保在国内生成的数据能够安全在本地存储和处理的数据本地化政策。-对于促进劳动力发展:国家需要以STEM教育和培训为重点,形成人工智能技术领域的熟练国内劳动力和专业知识。-对于确立伦理发展与规范:国家需要实现完善的监管框架,即管理人工智能开发和使用的国家政策、法律和法规。需要重点关注隐私、透明度、数据保护、网络安全和人工智能的道德使用等问题,并完善的问责机制。

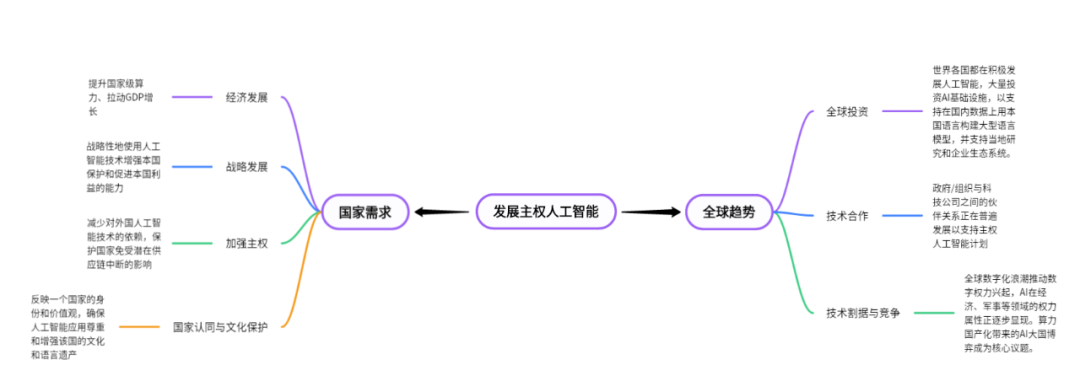

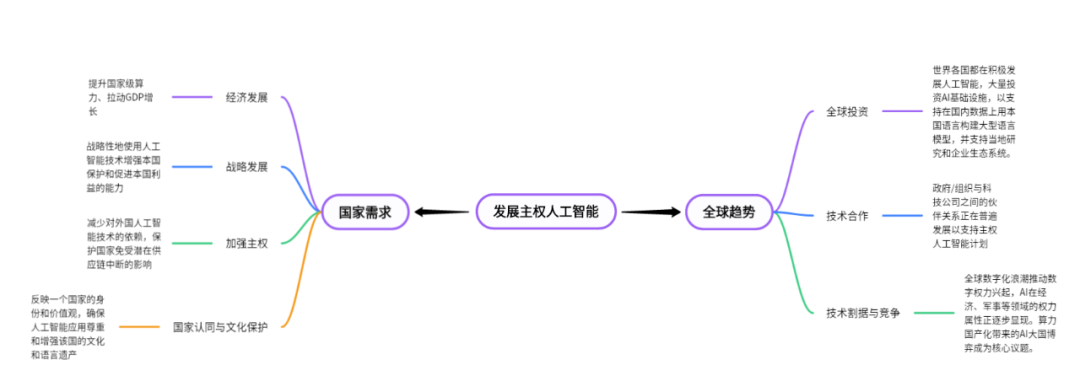

首先,主权人工智能可以满足国家的经济发展需求。根本上,主权人工智能技术的发展逻辑在于强化智算中心,一个以 GPU、AI 加速卡等智能算力为核心、集约化建设的新型数据中心。作为主权AI的基础和新质生产力的引擎,智算中心的强化会催生国家级算力需求。据IDC的《2021-2022全球计算力指数评估报告》,计算力指数平均每提高1点,国家的数字经济和GDP或将分别增长3.5‰和1.8‰,可见算力提升对于拉动GDP增长有显著效果。咨询机构麦肯锡预计,到2030年之前,如果生成式AI应用于各行业,每年总经济效益高达6.1万亿美元至7.9万亿美元。因此,主权人工智能带来的经济发展前景是促使许多国家巨资投入人工智能研发的一大重要因素。此外,发展主权人工智能的关键目的在于通过战略性地使用人工智能技术来增强一个国家保护和促进本国利益的能力,因此满足了一个国家的战略需求。目前来讲,AI技术在军事领域的应用正在不断增长,人工智能与网络安全之间的交叉研究成为了全球热点。而随着人工智能和加速计算日益成为应对气候变化、提高能源效率的关键工具,主权人工智能也在装备每个国家以加强其可持续发展方面发挥着重大作用。最后,随着各国越来越认同人工智能对于在数字时代维护主权的关键作用,发展主权人工筑能有助于加强国家主权和文化发展与保护。一方面,主权人工智能旨在发展国内人工智能能力,确保在国内能够获得关键数据、技术、专业知识和基础设施,从而减少对外国人工智能技术的依赖。目前,美国、中国和欧盟成员国等国家都正在带头发展本土人工智能能力以保护国家免受潜在供应链中断的影响。另一方面,主权人工智能旨在反映一个国家的身份和价值观,确保人工智能应用尊重和增强该国的文化和语言遗产。英伟达首席财务官此前也曾表示,世界各国都在投资AI基础设施,以支持在国内数据上用本国语言构建大型语言模型,并支持当地研究和企业生态系统。在这样的世界背景下,几个发展趋势开始涌现。首先是全球投资:世界各国都在积极发展人工智能,并进行大量投资。在欧洲,总部位于法国的Scalewa公司正在建造欧洲最强大的云原生人工智能超级计算机。在亚洲,中国有趋势集中全国AI芯片研制力量进行“主权级大模型”的研发,希望尽快研制出能够满足国产主权基础大模型训练的十万卡、百万卡甚至千万卡并行算力需求的AI芯片和系统;印度政府也宣布了促进劳动力发展、可持续计算和私营部门投资国内计算能力的主权人工智能倡议。其次是技术合作:政府/组织与科技公司之间的伙伴关系正在普遍发展以支持主权人工智能计划。就在今年五月,硅谷公司Cerebras Systems表示,它将向德国科技初创公司Aleph Alpha提供一套超级计算系统,共同为德国武装部队开发人工智能。同年,新加坡领先的通信服务提供商Singtel 与英伟达合作,计划支持新加坡的国家 AI 战略,大幅扩展新加坡的计算基础设施以及机器学习专家人才库。同样,日本也与英伟达合作提高劳动力技能,支持日语模型开发,并扩大人工智能在日本自然灾害响应和气候适应能力方面的应用。不难发现,芯片制造商大部分聚集在美国,因此发展主权人工智能不可避免会面临技术割据与竞争。在其中,AI大国博弈是最核心的议题。4月16日,美国微软公司宣布与阿联酋科技公司G42达成合作协议。G42被视为阿联酋推进AI战略的核心,此次合作可能意在AI领域将阿联酋拉入美国阵营。G42从中国撤资并与美方达成新合作正是数字权力博弈的一个信号。本质上,主权人工智能领域的竞争源于它的基础设施的构建要立足于算力国产化。算力作为AI的基石,其自主可控是国家信息安全和技术独立的重要保障。国家级算力的需求发展主权AI中至关重要,这就要求国家在芯片设计、制造和数据中心建设等关键环节实现自主创新和突破。目前,在美国封锁之下,中国能够用于大模型训练的国产智能算力芯片的创新和供应显著落后,国产多模态大模型的训练受到美国制裁的影响,生态建设严重落后。因此,大模型落地所需要的配套软件、服务生态及市场需要进一步投资、引导与建设。总体来看,全球数字化浪潮推动数字权力兴起,AI在经济、军事等领域的权力属性正逐步显现,成为数字时代权力的主要呈现形式。当下,美国、中国、欧盟、日本、新加坡纷纷入局,投身AI全球竞争,各国围绕数字权力展开激烈博弈与竞争,旨在争夺未来AI领域的监管主导权与话语权。

Part3 主权人工智能现阶段/潜在的影响是什么?

目前,在主权人工智能的研发和应用中可能会触及公民隐私保护问题。首先是数据本地化,尽管在国内范围内本地化数据受国内法律保护,但依然集中了大量个人数据。而人工智能对数据海的需求进一步放大了数据聚合后的泄露和滥用风险。除此之外,公民对人工智能系统的数据收集和使用可能具有有限的控制权,也会引发人民和政府/组织之间的道德和信任问题。最后,国家数据保护法可能构成国际法律障碍,因此也面临着法律和监管的挑战。而在公民隐私保护之外,主权人工智能还存在潜在的伦理影响。其中,一个突出的问题是人工智能决策过程缺乏透明度和问责制,因为人工智能系统通常以“黑匣子”的形式运行,使用户难以理解最终决策是如何做出的。人工智能系统还可能延续并放大国家数据集中的现有偏见,从而产出歧视性结果。而主权人工智能使用的数据仅限于国界,顺应国家特有国情、文化、价值观工作,更加放大了排除不同的观点并强化局部偏见的可能性。此外,根据前文提到的大国竞争和数字权力博弈的大趋势,主权人工智能的发展可能会加剧全球不平等并激化权利动态。与贫穷国家相比,富裕国家更有能力开发先进的人工智能技术,随之而来的便是现有全球权力失衡的加剧和技术鸿沟的产生。因此,主权人工智能的进步和全球协作之间的关系是一个潜在的国际问题。那么,为了克服和规避这些问题,主权人工智能的研发与应用必须遵守哪些道德标准?总体而言,有以下几大关键原则:1.尊重人权:人工智能发展应确保保护人的尊严、权利和自由,必须完全遵守相关法律法规。2.透明度和可解释性:尽管主权人工智能建立有效的伦理治理和监管框架具有挑战性,但必不可少。人工智能系统做出的决策应该是透明和可解释的,这些框架也需要确保强有力的监督和遵守国际人权标准。3.问责制和责任:应建立明确的问责机制,以应对人工智能决策的后果。部署人工智能系统的人必须对其结果负责。4.公平和不歧视:人工智能系统应公正运作,避免可能导致歧视的偏见。必须仔细管理 AI 模型中使用的数据以防止偏差。5.安全和保障:确保人工智能技术不会伤害个人并免受网络威胁至关重要,包括技术稳健性和防止恶意使用的措施。6.隐私和数据保护:人工智能系统必须保护个人隐私并负责任地处理个人数据。这包括遵守数据保护法和确保数据机密性。7.道德使用和开发:必须强调开发行善(仁慈)和避免造成伤害(非恶意)的人工智能系统,将人工智能发展与人类的最大利益保持一致。清华大学人工智能国际治理研究院(Institute for AI International Governance, Tsinghua University,THU I-AIIG)是2020年4月由清华大学成立的校级科研机构。依托清华大学在人工智能与国际治理方面的已有积累和跨学科优势,研究院面向人工智能国际治理重大理论问题及政策需求开展研究,致力于提升清华在该领域的全球学术影响力和政策引领作用,为中国积极参与人工智能国际治理提供智力支撑。

新浪微博:@清华大学人工智能国际治理研究院

微信视频号:THU-AIIG

Bilibili:清华大学AIIG

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢