关键词:衣服操作,表征学习,通用策略

导 读

本文是对发表于计算机视觉领域顶级会议 CVPR 2024 的论文 UniGarmentManip: A Unified Framework for Category-Level Garment Manipulation via Dense Visual Correspondence 的解读。该论文由北京大学董豪课题组完成,共同第一作者为计算机学院博士生吴睿海和拔尖计划本科生鲁浩然。

本文针对多类衣服(如上衣、裤子和裙子)的不同操作任务(如叠衣服、摊平衣服和挂衣服),首次提出了一种通用的视觉表征和操作策略。前人的工作大多需要在每个任务上采集大量的专家数据进行训练,而我们提出的表征是任务无关的。基于学到的表征,对于不同任务,仅需要在少量甚至一件衣服上的操作示范,就可以在同类别的不同衣服、不同折叠形态上进行操作的泛化。

↑ 扫码跳转论文

论文链接:

https://arxiv.org/abs/2405.06903

项目主页:

https://warshallrho/unigarmentmanip/

开源代码:

https://github.com/luhr/UniGarmentManip

图1. 我们的通用策略可以针对不同衣服,完成叠、摊开、挂等不同任务。

01

研究背景

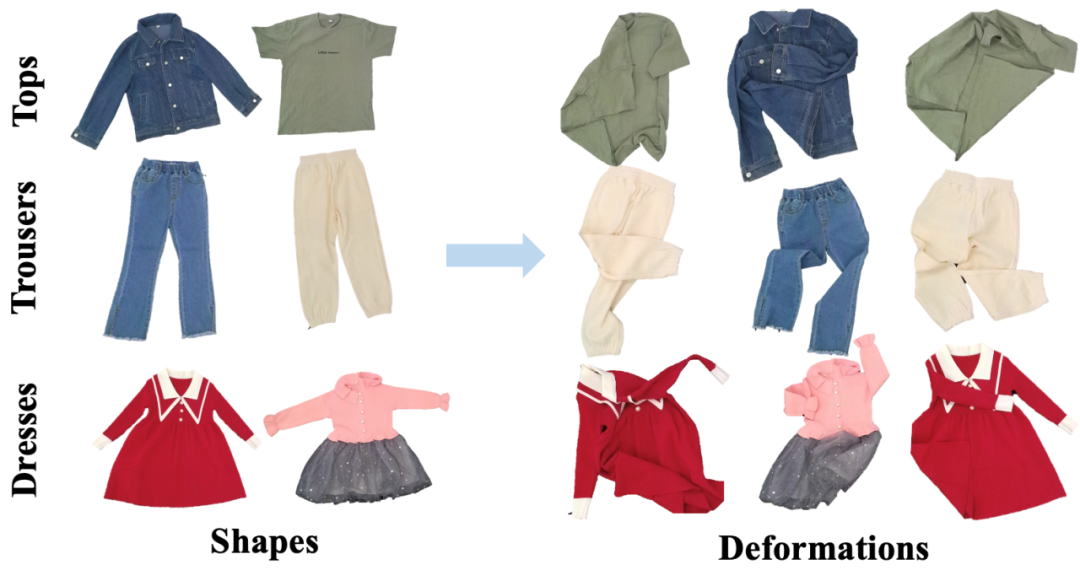

图2. 多样的衣服种类、样式、折叠形状。

真实世界中有着多种多样的衣物,包括衣服、裤子、裙子等,这些衣物有不同的种类、样式和折叠形状。对这些多样衣服的可泛化通用操作是未来机器人不可或缺的能力。过往的机器人研究主要专注于操作刚性物体(如抓取日常物体)、铰接物体(如操作门和抽屉),以及简单的布料和绳子(如摊开一块布)。

相比于这些物体,衣服的操作不仅同样拥有非常高的实用价值,而且对操作策略有着更高的要求:衣服的类别繁多,同一类衣服有着不同的样式,同一件衣服有着不同的形态。因此,一个统一的可泛化的衣服表征和对应操作策略,对未来的机器人有着极强的意义。

针对大量的衣服操作数据难以采集的特点,我们通过自监督和对比学习的方式,首先学习了同类别不同衣服之间逐点的对应关系表征,基于这种表征,我们仅需要通过少量甚至一个样例操作示范,就可以在同类别的新衣服上进行操作策略的泛化。

02

方 法

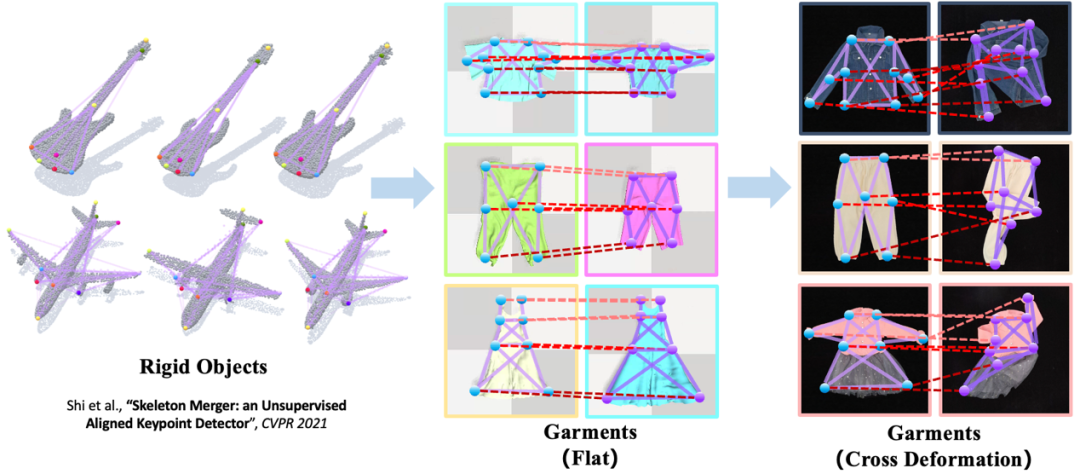

图3. 受到刚性物体中同类物体间可泛化的结构点(左图)的启发,我们学习了同一类衣服间可泛化的结构点。因为同一件衣服有着繁多的折叠形态,我们先学习同一类衣服在摊平状态下的结构点(中图),再把它映射到不同形态的衣服上(右图)。

为了实现不同衣服之间的泛化可泛化操作,我们需要学习不同衣服间可泛化的视觉表征。如图3所示,对于刚性物体,已经有大量的先前工作研究了同类别刚性物体间可泛化的结构点表征的无监督学习方法。这样的结构点对应关系的表征,同样有利于在衣服的操作中提供同类别不同衣服间的泛化性。相比于刚性物体,衣服拥有不同的折叠形态,因此,我们先学习了平整状态下不同衣服的可泛化结构点,再把这样的结构点映射到衣服的不同折叠形态上。

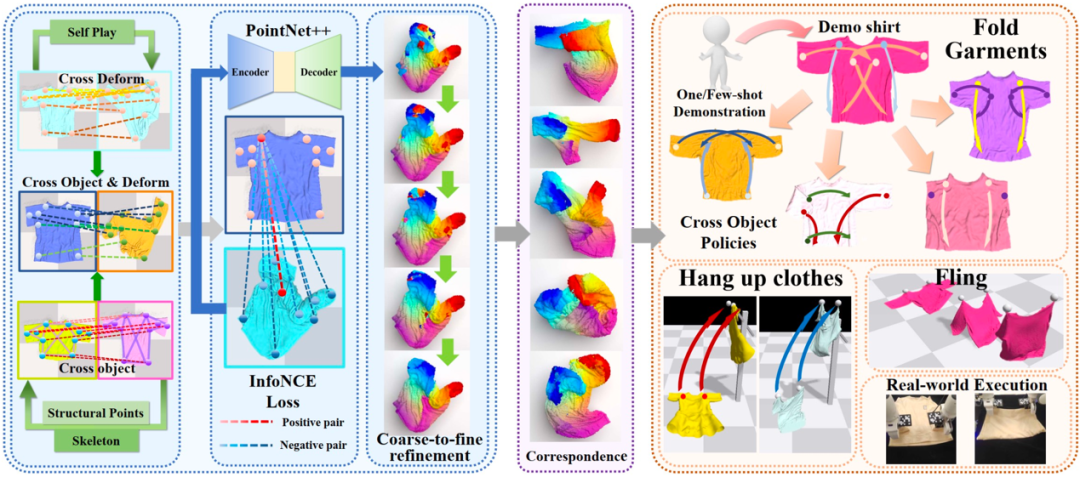

图4. 我们的整套方法。(左图)我们分别采集了在不同衣服、相同衣服不同折叠形态下的结构点对应关系,并通过对比学习学得不同衣服间逐点对应的表征。(右图)基于这种不同衣服间统一的表征,以及一个或少量示范,我们就可以将操作策略泛化到不同衣服上。

具体而言,如图4所示,我们分别采集了不同衣服在摊平状态下、相同衣服不同折叠形态下的结构点对应关系,通过对比学习(InfoNCE)学习逐点级别的对应和不对应关系。如 Correspondence 一列所示,对于不同形态的不同衣服,两点之间颜色越相近,代表两点拥有更相似的结构关系。这样逐点级别的结构对应关系可以实现基于单样例操作示范的可泛化操作(图5)。

图5. 基于单样例操作示范的可泛化操作策略。

如图5所示,基于一件样例衣服在一个任务上(比如左边的双臂摊开衣服、右边的折叠衣服)的一个样例操作,对于一件同类别不同形状的新衣服,我们先通过逐点对应的视觉表征学到新衣服上的操作点,再执行对应操作以完成任务。

03

实 验

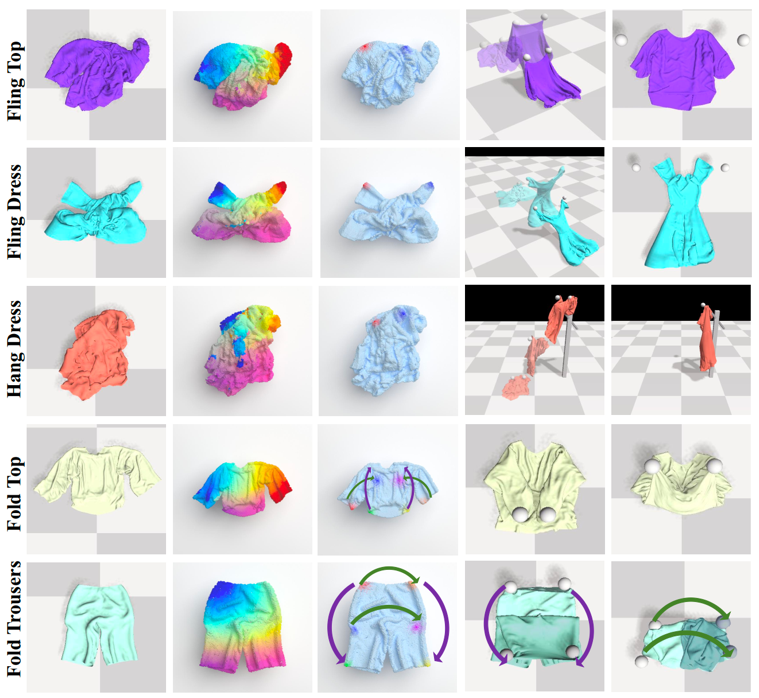

图6. 不同任务下,(从左到右)衣服、可泛化结构性通用视觉表征、通过视觉表征选择的操作点和操作策略示意。

我们选择了上衣、裤子和裙子作为实验的衣服类别,选择摊开、折叠和挂衣架三类任务以验证我们提出的衣服通用操作策略。图6展示了不同衣服和不同任务里,可通用视觉表征指导的操作策略。

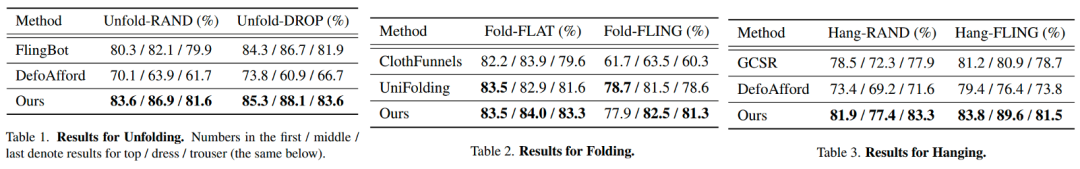

图7. 在摊开、折叠和挂衣架三个任务上,我们提出的通用策略,和之前工作的效果对比。

图7展示的三张图表,进一步展现了我们提出的通用策略不仅可以完成不同的衣服操作任务,并且在不同任务上都拥有最好的效果。

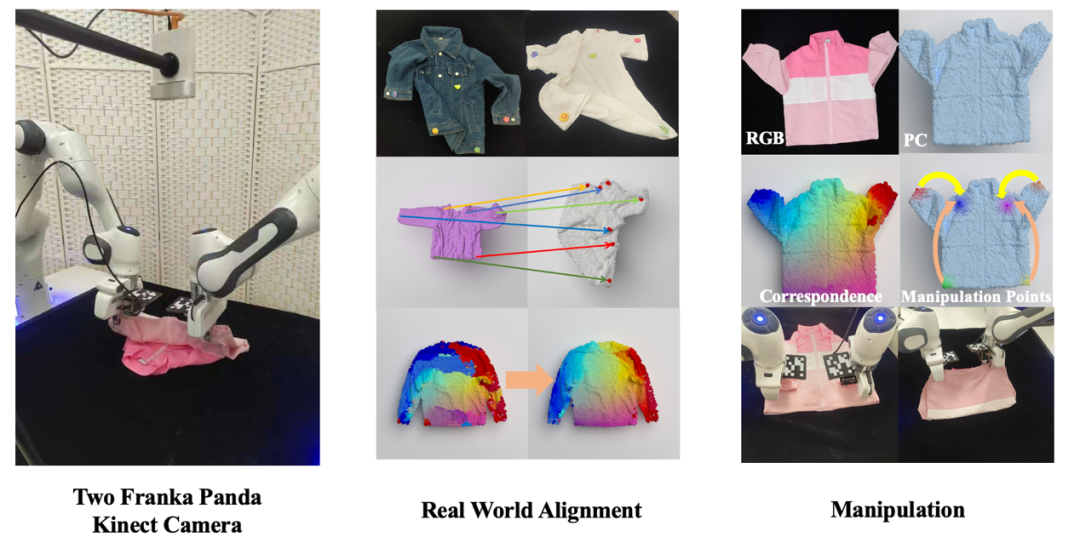

图8. 真机环境和真机操作。

进一步地,如图8所示,我们搭建了由双 Franka Panda 机械臂和 Kinect 相机组成的真机实验环境,通过无监督的视觉进行了仿真-真实点云观测的对齐,并且进行了真实机器人的操作。

04

总 结

在这篇论文中,我们首次提出了不同任务上通用的衣服操作表征和策略。基于自监督学习的同类别不同衣服之间逐点对应的视觉表征,我们实现了在不同任务和不同类别衣服上通用的操作策略。仅需要通过少量甚至一个样例操作示范,就可以在同类别的新衣服上进行泛化。

PKU-Agibot Lab

PKU-Agibot Lab 由北京大学前沿计算研究中心董豪助理教授领导,该科研团队专注于机器人视觉,物体操作,语义导航和具身自主决策等领域的前沿技术,致力于为工业应用和家用场景创建具有成本效益的人形机器人。

实验室 PI 简介:董豪 助理教授

实验室相关新闻:#PKU-Agibot Lab

扫码浏览实验室主页

https://zsdonghao.github.io/

图文 | 吴睿海、鲁浩然

PKU-Agibot Lab

PKU-Agibot Lab 近期科研动态

— 版权声明 —

本微信公众号所有内容,由北京大学前沿计算研究中心微信自身创作、收集的文字、图片和音视频资料,版权属北京大学前沿计算研究中心微信所有;从公开渠道收集、整理及授权转载的文字、图片和音视频资料,版权属原作者。本公众号内容原作者如不愿意在本号刊登内容,请及时通知本号,予以删除。

点击“阅读原文”转论文地址

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢