2024

想象一下,如果有一个家庭机器人,能够为人们做各种家务活,那将是多么令人期待!

在家用机器人所必备的技能当中,柔性物体操纵是一个非常重要的技能,其中包括:整理衣服,打包袋子,打结和解结等等。

galbot,来源:银河通用机器人视频号

但是对于柔性物体的操纵却存在着很多的困难。相比于刚体,柔性物体有着近乎无穷多的运动自由度(Degree of Freedom,DoF)。换而言之,被操纵的物体状态是无限的。如何针对不同的状态,执行不同的策略,是一件非常困难的事情。

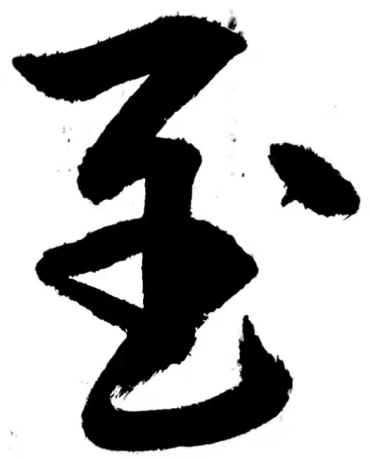

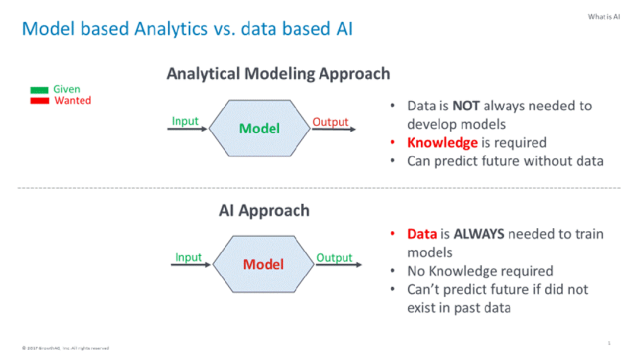

从原理上讲,对柔性物体的操纵策略可以分成两种方式:模型驱动的(model driven),和数据驱动的(data driven)。模型驱动是指通过使用一些传统的计算机视觉算法或者控制算法,对目前的状态(state)和观察(observation)进行特征的提取和分析,并用一些设计好的动作去执行。早年的工作大多使用这种方法,例如在工作[1]中设计了如何基于边缘检测将衣架插入衣服的策略。

上图:Model Driven

下图:Data Driven

目前人们越来越关注于数据驱动的方法。数据驱动是指让智能体在训练数据中发现并总结规律,从而执行一些更优更好的操作。这本质上是一种统计学的原理:如果在一个情况下执行一个动作总能获得成功,那么智能体将会学习到这种规律,并在未来碰到同样的情况下执行相同的动作。在数据驱动的原理之下,关于如何采集训练数据,目前学术界有两种主流范式:1)直接在真实世界中采集数据;2)从模拟环境中采集数据并迁移到现实。这两种方式各有优劣,在不同的任务上人们有不同的选择。

首先是在真实世界中采集数据。这种采集数据的方式十分直接,且数据是真实的。但是这种方法采集数据的效率和安全程度都不高,且更换真实环境时(例如在一个屋子里训练,换到另一个装饰完全不一样的屋子进行测试),常常会遇到泛化难的挑战。而操纵柔性物体时,由于柔性物体极高的运动自由度,很多情况很难被并不多的真实数据覆盖到。

一些已有的在真实世界中采集数据的柔性物体操纵的研究包括:PaperBot 在真实世界中进行强化学习,让纸飞机飞的更远,或者让纸做的夹爪能够夹起更重的物品;SLIP 采集了真实世界中的视频,能够精准控制平行夹爪夹起塑料袋的一层;等等……

PaperBot[2]

SLIP[3]

另一种方式是在仿真环境中训练,并迁移到真实世界。这种方式易于高效进行大规模数据采集,并且可以在模拟器中进行大量“危险”的尝试。然而这种方法在从模拟迁移到现实时(sim2real),由于模拟世界和真实世界的不一致性,使得这种方法会面临额外的挑战。

一些经典的从模拟迁移到现实的工作包括:FlingBot 利用“抛”的动作,在模拟器中进行大量的尝试,总结出了怎么“抛”能够将衣服高效地摊平;OnePolicyToDressThemAll 使用了一个统一的策略,使机器人能够辅助人类穿衣;等等……

FlingBot[4]

OnePolicyToDressThemAll[5]

从动作的参数化(action parametrization)角度来说,对于柔性物体操作,目前主流的方法是使用动作原语(action primitive)。这种方式将一段很长的动作序列参数化到低维空间中,从而使得学习过程更容易。例如 FlingBot[4]仅仅使用两对 xy 坐标(一共4个数)表示左右夹爪把衣服夹起的位置,随后所有的动作例如 lift 和 fling,都是人为预定义好的。

未来的通用机器人的最终形态应当是端到端的(End-to-End),即抛弃 action primitive,直接输出机器人关节角(joint angle)或者末端执行器(end effector)的 6D 位姿(平移和旋转)。例如 ALOHA[6]系列的工作,使用人类遥操得到的数据,可以对机器人进行端到端的训练。

Mobile ALOHA[6]

但目前制约柔性物体使用这种端到端网络的原因,主要来自于数据的稀缺。对柔性物体的物理模拟和真实世界中的物理有着较大的差距,而在真实世界中采集用于端到端训练的数据又极其耗时。如何实现更精确、更泛化、更多样的柔性物体操纵,研究人员还有很多值得探索的方向。

参考文献

[1] Y. Koishihara, S. Arnold, K. Yamazaki and T. Matsubara, "Hanging work of T-shirt in consideration of deformability and stretchability," ICIA 2017.

[2] Ruoshi Liu, Junbang Liang, Sruthi Sudhakar, Huy Ha, Cheng Chi, Shuran Song and Carl Vondrick, "PaperBot: Learning to Design Real-World Tools Using Paper". arXiv preprint arXiv:2403.09566.

[3] Lawrence Yunliang Chen, Baiyu Shi, Roy Lin, Daniel Seita, Ayah Ahmad, Richard Cheng, Thomas Kollar, David Held and Ken Goldberg, "Bagging by Learning to Singulate Layers Using Interactive Perception". arXiv preprint arXiv:2303.16898.

[4] Huy Ha and Shuran Song, "FlingBot: The Unreasonable Effectiveness of Dynamic Manipulation for Cloth Unfolding". arXiv preprint arXiv:2105.03655.

[5] Yufei Wang, Zhanyi Sun, Zackory Erickson and David Held, "One Policy to Dress Them All: Learning to Dress People with Diverse Poses and Garments". arXiv preprint arXiv:2306.12372.

[6] Zipeng Fu, Tony Z. Zhao and Chelsea Finn, "Mobile ALOHA: Learning Bimanual Mobile Manipulation with Low-Cost Whole-Body Teleoperation". arXiv preprint arXiv:2401.02117.

文 | 陈煜星

图 | 吴双

— 版权声明 —

本微信公众号所有内容,由北京大学前沿计算研究中心微信自身创作、收集的文字、图片和音视频资料,版权属北京大学前沿计算研究中心微信所有;从公开渠道收集、整理及授权转载的文字、图片和音视频资料,版权属原作者。本公众号内容原作者如不愿意在本号刊登内容,请及时通知本号,予以删除。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢