关键词:机器人位姿预测 单目深度预测 实时应用

导 读

在计算机视觉和机器人学的领域,从单张 RGB 图像中预测机器人的位姿(monocular robot pose estimation)是一个基础而关键的任务。传统机器人位姿预测方法通常假设机器人内在状态已知,但这一假设在人机交互、多机器人协作等场景中往往不成立。现有的不依赖于内在状态的位姿预测方法存在计算量大、耗时较长等问题,难以支持实时应用。我们是否可以在未知内在状态下,以实时速度预测出机器人位姿呢?

这篇发表于计算机视觉顶级会议 ECCV 2024 的研究论文 Real-time Holistic Robot Pose Estimation With Unknown States 针对这个问题提出了一种新颖且高效的方法,可以从单张 RGB 图像中实时预测出机器人位姿及机器人内部状态(例如关节旋转角等),并验证了其模型在多个虚拟和现实数据集上的性能,相比此前的方法更精确且有超10倍的速度提升,展示了在实际工业场景中的应用潜力。该研究由北京大学王亦洲教授研究团队与上海交通大学乔宇课题组合作完成,学生作者包括本科实习生班世锟、范居令。

https://arxiv.org/abs/2402.05655

项目主页:

https://oliverbansk.github.io/Holistic-Robot-Pose/

开源代码:

https://github.com/Oliverbansk/Holistic-Robot-Pose-Estimation

01

研究背景

从单张 RGB 图像中预测机器人位姿,在计算机视觉和机器人领域中是一项基础且关键的任务。它为多个下游任务奠定了基础,如视觉引导的机械臂控制、多机器人协作等任务。传统的机器人位姿预测方法[2,4,5]依赖于已知机器人关节状态,仅专注于预测相机到机器人基座的旋转和平移。这些方法需要真实的机器人关节状态作为位姿预测的额外输入。然而,在低成本、缺乏复杂传感器的机械臂的位姿预测场景下,或在人机交互、多机器人协作等实际场景中,真实的机器人关节状态信息可能因环境限制无法被准确获取[1]。这突显了在未知机器人内在状态情况下有效地进行位姿预测的需求。另外,独立地预测机器人的关节状态也成为了一个重要的需求。对此,我们明确了未知内在状态下机器人位姿整体预测(holistic robot pose estimation)的任务定义,即同时预测相机到机器人基座的位姿与机器人关节状态(joint state)。

这项任务比已知内在状态的机器人位姿预测更具挑战性。一方面,未知的关节状态导致不确定的机器人形态,增加了机器人位姿预测的模糊性与不确定性;另一方面,机器人关节状态的预测需要建立 2D 图像中关节位置到 3D 空间中关节位置的对应关系,这也因为机器人位姿的未知而更加棘手。为了解决这两个相互交织的挑战,提升预测的稳健性,我们需要设计一种能够将位姿预测与关节状态预测相互解耦的创新框架。

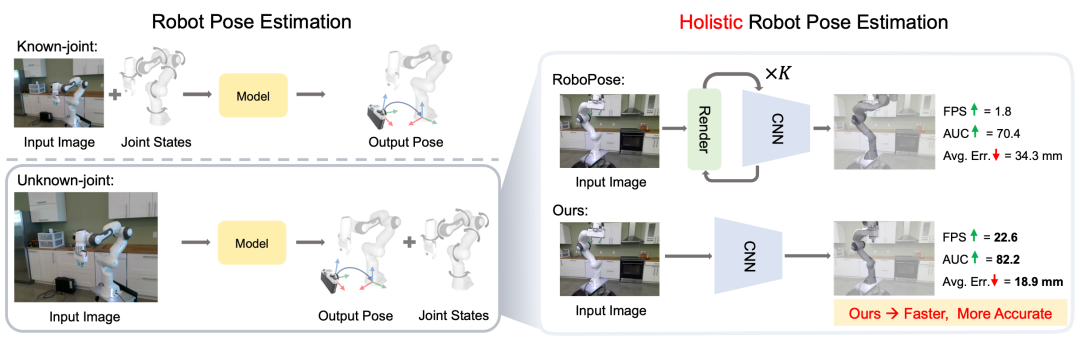

图1. 机器人位姿预测任务范式对比:(Known-joint)已知关节状态下的机器人位姿预测,(Unknown-joint)未知关节状态下的机器人位姿与关节状态整体预测。后者更为复杂,是我们研究处理的核心任务。

尽管先前的一些工作已经研究了机器人位姿与关节状态整体预测[1,3],并部分解决了上述挑战。但它们的方法在实际预测时需进行迭代优化,因而计算量过大,耗时过长,难以支持工业级别的实时应用。针对这一问题,我们提出了一个模块化的端到端框架,无需迭代优化便可直接同时预测出机器人位姿即关节状态信息,刷新位姿预测精度的同时,以12倍的增幅显著提升了预测速度,首次实现了未知内在状态下机器人位姿与关节状态的实时整体预测。

02

方法概览

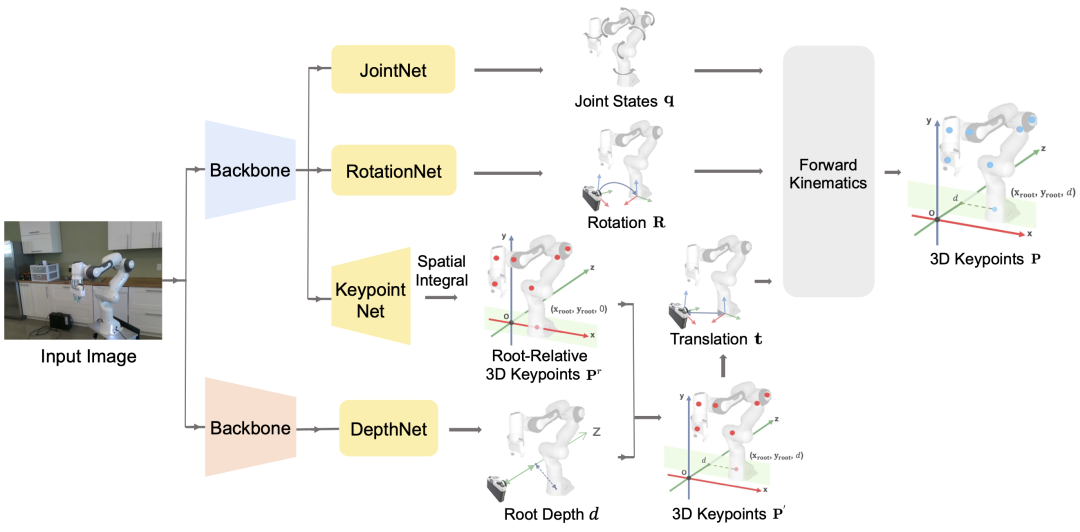

图2. 我们的模型框架。我们将任务分解为多个子任务,并设计不同子模块以分别解决不同子任务。

我们将机器人位姿与关节状态的整体预测任务分解为多个子任务,并为每个子任务设计了专用的神经网络模块,包括机器人参考基准点深度预测模块(DepthNet)、机器人关节状态预测模块(JointNet)、相机到机器人的旋转矩阵预测模块(RotationNet),以及机器人3D关键点位置预测模块(KeypointNet)。

独立的 DepthNet 模块负责预测机器人参考基准点的绝对深度。我们通过将相机的内参和机器人在图像中的尺度信息结合,获得初步的深度预测值。DepthNet 通过学习图像特征校正这一初步预测,提供更加准确的绝对深度值,有效降低单目深度预测的模糊性,为其他预测模块的工作奠定基础。

JointNet 模块基于提取到的全局图像特征,使用多层感知器(MLP)回归关节状态参数(每个关节的旋转角度或平移距离),为整体位姿预测提供必要的内在状态信息。RotationNet 模块同样通过 MLP 从全局图像特征中回归相机到机器人的旋转矩阵。KeypointNet 模块通过卷积层生成 3D 热图,并使用空间积分技术[6]计算每个机器人多个关键点位置的 3D 坐标。通过预测这些关键点的位置,我们可以在图像特征空间内进一步细化对机器人的姿态预测,提升 JointNet 模块与 RotationNet 模块在机器人参数空间下的预测精度。

预测得到的机器人关节状态参数、相机到机器人的旋转矩阵与平移(取自机器人 3D 关键点坐标)作为正向运动学(forward-kinematics)过程的输入,用于计算输出最终的机器人 3D 关键点坐标。

我们的方法包含真实值监督和自监督两个训练阶段。在真实值监督阶段,我们使用合成数据集的真实标签来监督模型训练。在自监督阶段,我们通过多种一致性正则化机制在真实数据集上进行模型微调。这种多阶段训练策略有效地提高了模型的准确度和稳健性,大幅提升了模型在真实数据上的泛化能力。关于更多的方法细节,请参阅论文原文。

03

实验结论

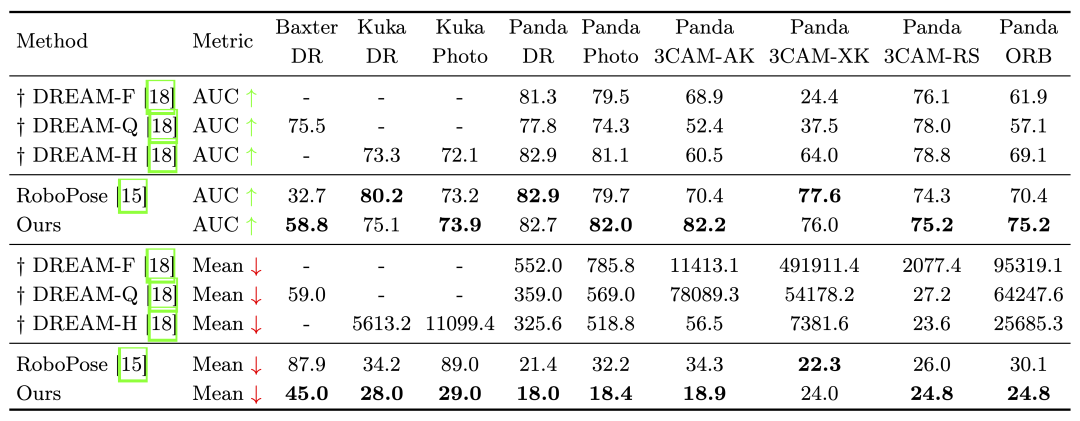

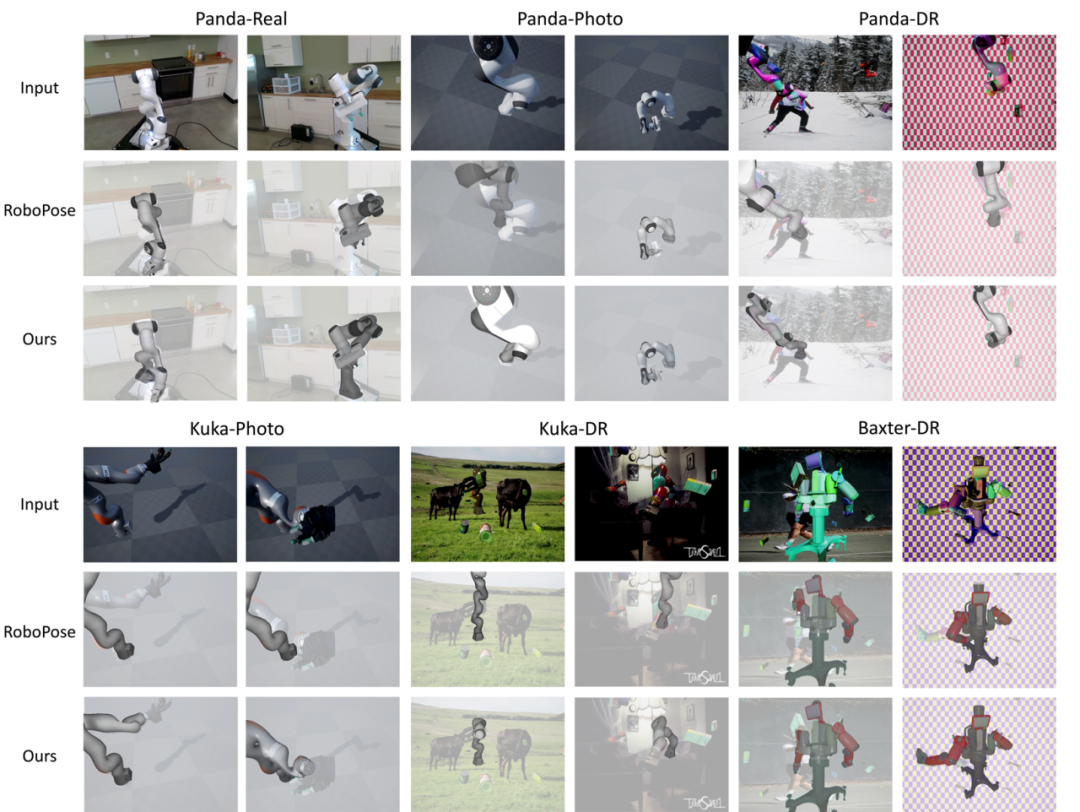

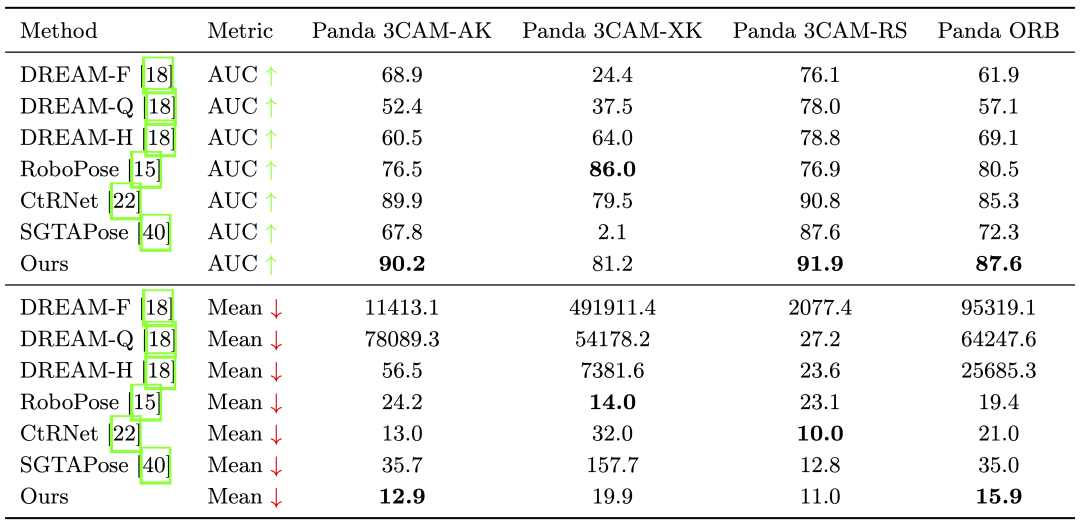

我们在涵盖了 Baxter、Kuka 和 Panda 三种机器人的图像数据集 DREAM[2]上开展了我们的实验。我们首先对比我们的方法与先前最好方法在未知内在状态下机器人位姿预测任务上的性能。图3展示了在 DREAM 的不同子数据集上,我们的预测方法整体优于先前最好方法 RoboPose[3]。

图3. 未知内在状态下机器人位姿预测任务性能对比。我们的方法在 AUC 和 Mean 两个指标上均整体优于先前最好方法 RoboPose[3]。标记†的行表示作为参考的已知内在状态的机器人位姿预测方法。

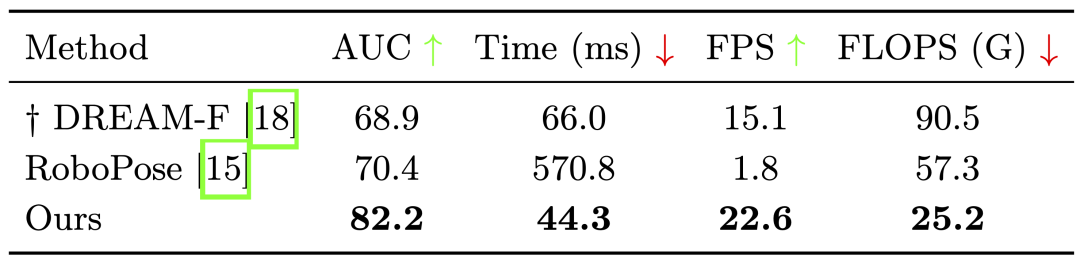

此外,我们测试了模型的计算效率,并与先前的方法进行对比。我们测量了平均推理时间、每秒帧数(FPS)和浮点运算数(FLOPs)。图4的表格显示了我们的方法在推理速度和计算负载方面具有显著优势,能够实现实时预测。这一优势源于我们的方法能够在单次前馈传递中完成所有推理过程,无需进行耗时的迭代优化。

图4. 在 Panda 3CAM-AK 数据集上的计算效率比较。标记†的行表示作为参考的已知内在状态的机器人位姿预测方法。

通过上述对比实验,我们证明了我们的方法是未知内在状态下机器人位姿预测任务的高性能且高效的解决方案。我们也将机器人位姿预测结果在图片和视频上进行了可视化。在多个 DREAM 子数据集的图片以及真实世界机器人视频上的结果显示,我们的方法在预测准确性与稳健性上显著优于先前最好方法 RoboPose[3]。

图5. 我们的方法与 RoboPose[3]在真实数据集和合成数据集上的预测可视化对比。

值得说明的是,我们的方法也可以轻松适应先前已经被充分解决过的已知内在状态下的位姿预测任务。图6中的表格显示,在已知机器人关节状态的设定下,我们的方法在四个真实数据集上也达到了与之前最先进方法[2,3,4,5]相当的性能。

图6. 已知内在状态下机器人位姿预测任务性能对比。

04

总 结

在这项研究中,我们提出了一个创新的、模块化的端到端框架,用于以实时速度预测机器人的位姿,无需依赖真实关节状态作为位姿预测的额外输入。这一框架对于机器人关节状态信息不可用或不可靠的现实场景尤为有益。我们的方法将复杂的任务细分为多个子任务,并为每个子任务设计了专用模块,通过多模块的协同工作,有效降低了预测复杂度。

我们通过定性、定量对比实验,证明了我们的方法不仅刷新了位姿预测精度,还大幅提升了预测效率。我们也通过多种消融实验证明了我们的模块化框架设计的有效性。在宏观层面,我们的研究首次实现了机器人位姿与关节状态的实时整体估计,为更灵活的工业级别的实时机器人位姿预测及更多实时应用奠定了基础。

参考文献

[1] Zuo, Y., Qiu, W., Xie, L., Zhong, F., Wang, Y., Yuille, A.L.: Craves: Controlling robotic arm with a vision-based economic system. In CVPR 2019.

[2] Lee, T.E., Tremblay, J., To, T., Cheng, J., Mosier, T., Kroemer, O., Fox, D., Birch- field, S.: Camera-to-robot pose estimation from a single image. In ICRA2020.

[3] Labbé, Y., Carpentier, J., Aubry, M., Sivic, J.: Single-view robot pose and joint angle estimation via render & compare. In CVPR 2021.

[4] Lu, J., Richter, F., Yip, M.C.: Markerless camera-to-robot pose estimation via self- supervised sim-to-real transfer. In CVPR 2023.

[5] Tian, Y., Zhang, J., Yin, Z., Dong, H.: Robot structure prior guided temporal attention for camera-to-robot pose estimation from image sequence. In CVPR 2023.

[6] Sun, X., Xiao, B., Wei, F., Liang, S., Wei, Y.: Integral human pose regression. In ECCV 2018.

图文 | 班世锟 范居令

Computer Vision and Digital Art (CVDA)

About CVDA

The Computer Vision and Digital Art (CVDA) research group was founded in 2007 within the National Engineering Laboratory for Video Technology at Peking University led be Prof. Yizhou Wang. The group focuses on developing computational theories and models to solve challenging computer vision problems in light of biologically plausible evidences of visual perception and cognition. The primary goal of CVDA is to establish a mathematical foundation of understanding the computational aspect of the robust and efficient mechanisms of human visual perception, cognition, learning and even more. We also believe that the marriage of science and art will stimulate exciting inspirations on producing creative expressions of visual patterns.

CVDA近期科研动态

— 版权声明 —

本微信公众号所有内容,由北京大学前沿计算研究中心微信自身创作、收集的文字、图片和音视频资料,版权属北京大学前沿计算研究中心微信所有;从公开渠道收集、整理及授权转载的文字、图片和音视频资料,版权属原作者。本公众号内容原作者如不愿意在本号刊登内容,请及时通知本号,予以删除。

点击“阅读原文”转论文地址

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢