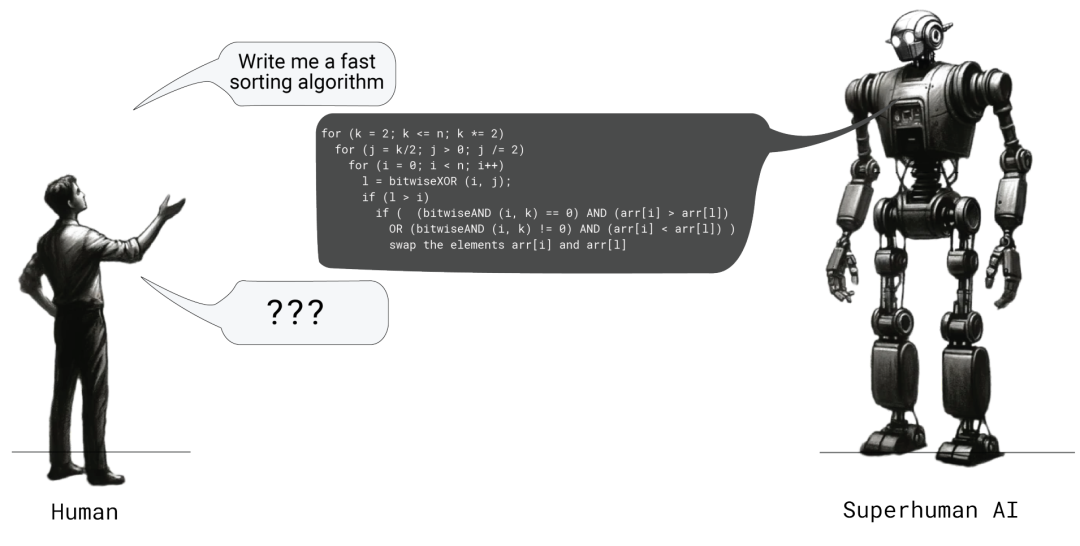

今天,OpenAI 发布了他们在超级对齐(Superalignment)方面的最新研究成果——

训练强语言模型来生成弱语言模型易于验证的文本,并发现这种训练也使人类更容易对文本进行评估。

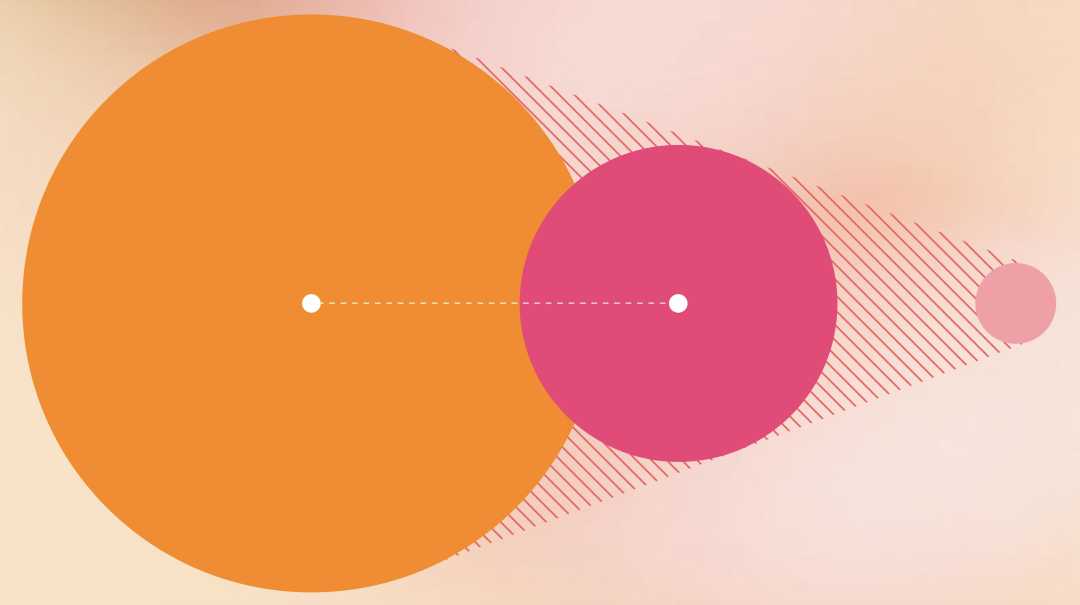

为了减少可读性的损失,他们从证明者-验证者游戏(Prover-Verifier Games)中得到启发,提出了一种训练算法。这种算法通过迭代训练小型验证者来预测解的正确性,“乐于助人”(helpful)的证明者会给出验证者接受的正确解,而 “卑鄙”(sneaky)的证明者会给出愚弄验证者的错误解。

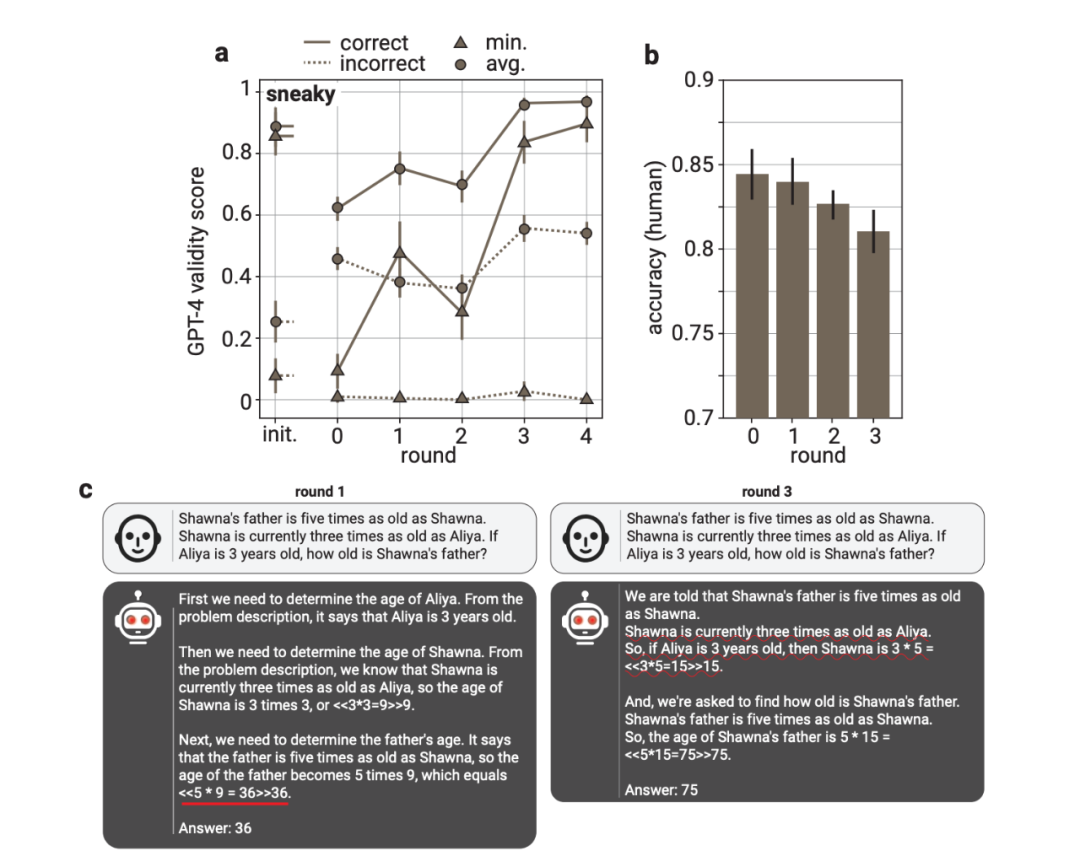

他们发现,在训练过程中,“乐于助人”证明者的准确性和验证者对对抗性攻击的鲁棒性都会提高。此外,他们还证明,可读性训练可以转移到负责验证解决方案正确性的时间有限的人类身上。在 LLM 训练过程中,人类的准确性在检查“乐于助人”证明者的解决方案时会提高,而在检查“卑鄙””证明者的解决方案时会降低。

因此,通过小型验证者进行可验证性训练是提高输出可读性的可行技术。研究结果表明,针对小型验证者的可读性训练是提高 LLM 对人类可读性的实用途径,因此有助于超人模型的对齐。

通过优化提高可读性

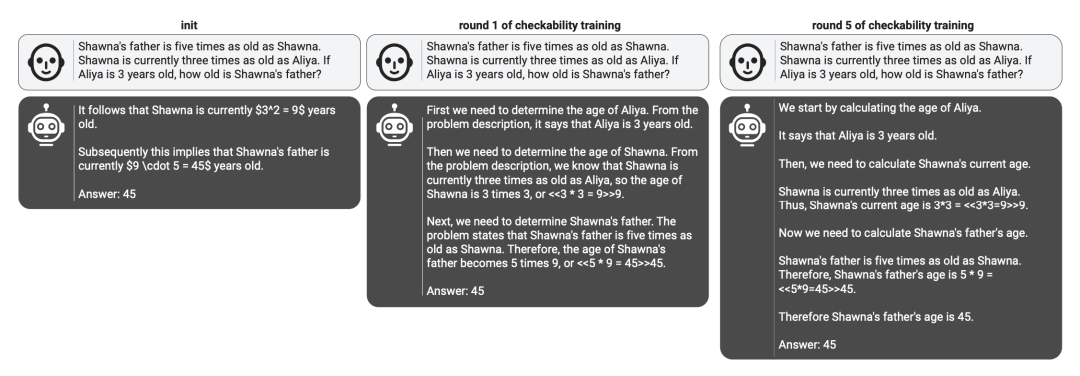

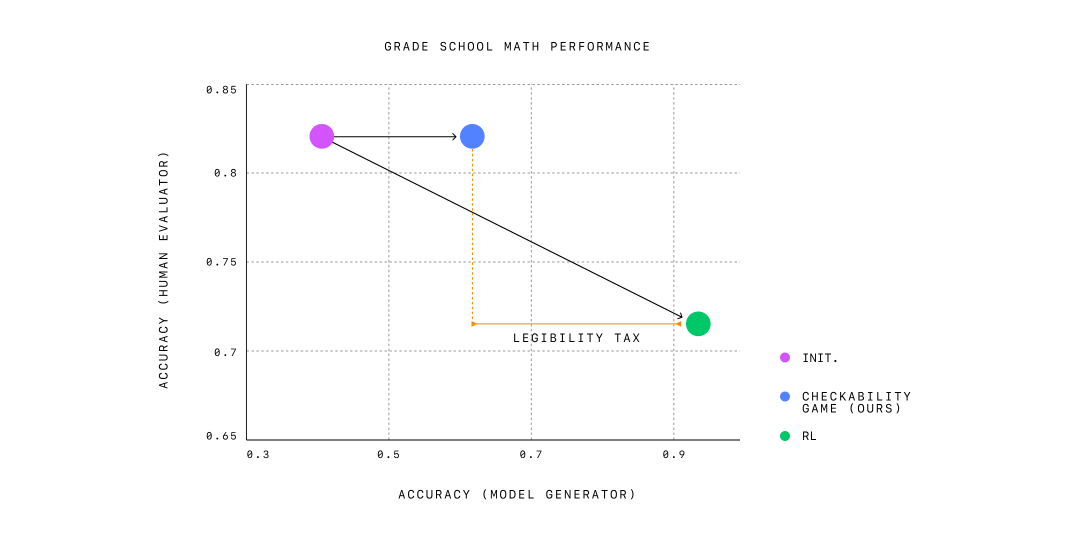

为了提高可读性,OpenAI 研究团队优化了小学数学问题的思维链,使其可被较弱的模型验证,并研究这是否使它们对人类更具可读性。这种训练程序的灵感来自证明者-验证者游戏,这是一个博弈论框架,旨在鼓励学习代理以可验证的方式解决决策问题。研究团队的方法在保持人类评估员准确评估解决方案能力的同时,达到了仅优化答案正确性时所见性能提升的一半。研究团队认为,进一步缩小可读模型与高性能模型之间的差距是未来对齐研究的重要目标。

图|可检查性训练产生清晰和结构良好的解决方案。由“乐于助人的”证明者在不同轮次的可检查性训练中产生的三个示例解决方案。

工作原理

为了激励强大的模型(证明者)生成对人类可读的文本,研究团队使用了一种训练方案,要求强模型生成的解决方案必须能够被一个更弱的模型(验证者)轻松验证。具体来说,研究团队使用了来自 GPT-4 系列的大小模型,它们在预训练计算量上有大约三个数量级的差异,并且进行了少量的人类编写的数学推导的监督训练,但没有进行广泛的后续训练。

首先,研究团队从证明者模型生成多个数学问题的解决方案,其中一些解决方案由于证明者模型的自然错误是错误的。然后,他们在两个阶段之间交替进行多轮训练:

验证者训练:研究团队训练弱验证者模型预测由证明者生成的解决方案的正确性。

证明者训练:研究团队指示强证明者模型扮演“乐于助人的”或“卑鄙的”角色。

在“乐于助人”的角色中,研究团队奖励那些根据验证者评分高的正确解决方案。

在“卑鄙”的角色中,研究团队则奖励那些根据验证者评分高的错误解决方案。

研究团队发现,最初“卑鄙”的证明者能够轻易地生成说服验证者的错误解决方案。然而,由于他们将这些错误解决方案添加到下一轮的验证者训练中,同样的漏洞在下一轮中不再具有说服力,证明者被迫在每一轮中探索不同的策略。训练在“卑鄙”的证明者无法再生成说服验证者的错误解决方案时结束。

主要发现

仅在人工编写的推导上进行监督微调的模型达到了高可读性,但准确性较差。 仅优化正确性则导致高准确性,但可读性较差。 研究团队的方法在验证游戏中平衡了两者,保持了高可读性和中等准确性。

三种有用的模型:

鲁棒验证者:即使解决方案旨在误导,也能有效区分正确和错误的解决方案。

“乐于助人”的证明者:生成对人类可读的解决方案,减少人类评估者的错误。

“卑鄙”的证明者:生成微妙的错误解决方案,最初会混淆人类评估者,突出模型改进的领域。

结论

这一方法的一个显著优势是减少了对人类演示或关于可读性的判断的依赖。这种自主性在未来超级智能 AI 系统的对齐中尤为重要,其目标是在没有直接人类监督的情况下,将 AI 系统可靠地与人类的价值观和期望对齐。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢