新智元报道

新智元报道

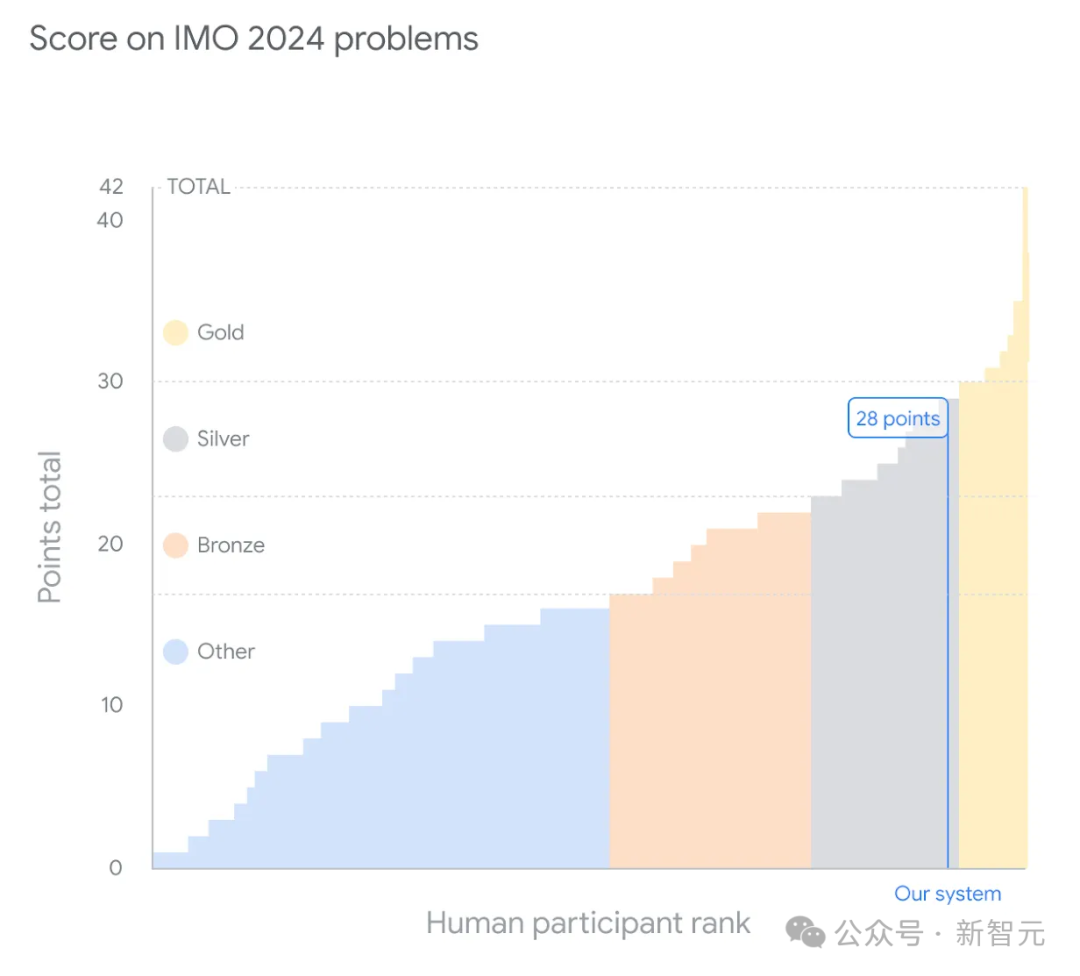

【新智元导读】就在刚刚,谷歌DeepMind最新的数学模型捧得了IMO奥数银牌!它不仅以满分成绩做出了6道题中的4道,距离金牌只有1分之差,而且在第4题上只用了19秒,解题质量和速度惊呆了评分的人类评委。

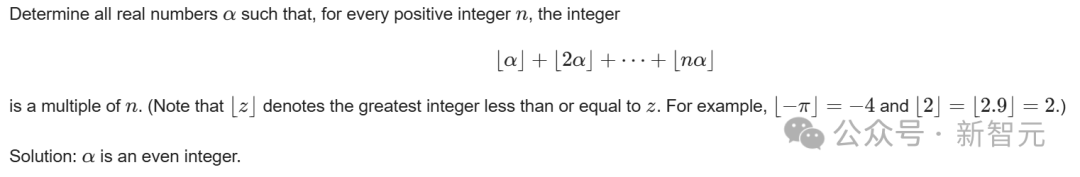

AI的数学推理能力,震惊评分教授

我们都知道,以前的AI在解决数学问题上一直捉襟见肘,原因在于推理能力和训练数据的限制。 而今天携手登场的两位AI选手,则打破了这种限制。它们分别是—— - AlphaProof,基于强化学习的形式数学推理新系统 - AlphaGeometry 2,第二代几何解题系统 两位AI给出的答案,由著名数学家Timothy Gowers教授(IMO金牌得主和菲尔兹奖得主)和Joseph Myers博士(两次IMO金牌得主、IMO 2024问题选择委员会主席),根据规则进行评分。 最终,AlphaProof正确做出两个代数题和一个数论题,其中一个最难的问题,在今年IMO中只有5名人类参赛者做了出来;AlphaGeometry 2则做出了一道几何题。 没有被攻克的,只有两道组合数学题。 Timothy Gowers教授在评分的过程中,也被深深地震撼了—— 程序能够提出这样一个非显而易见的解法,实在令人印象深刻,远超出我对当前技术水平的预期。

AlphaProof

AlphaProof

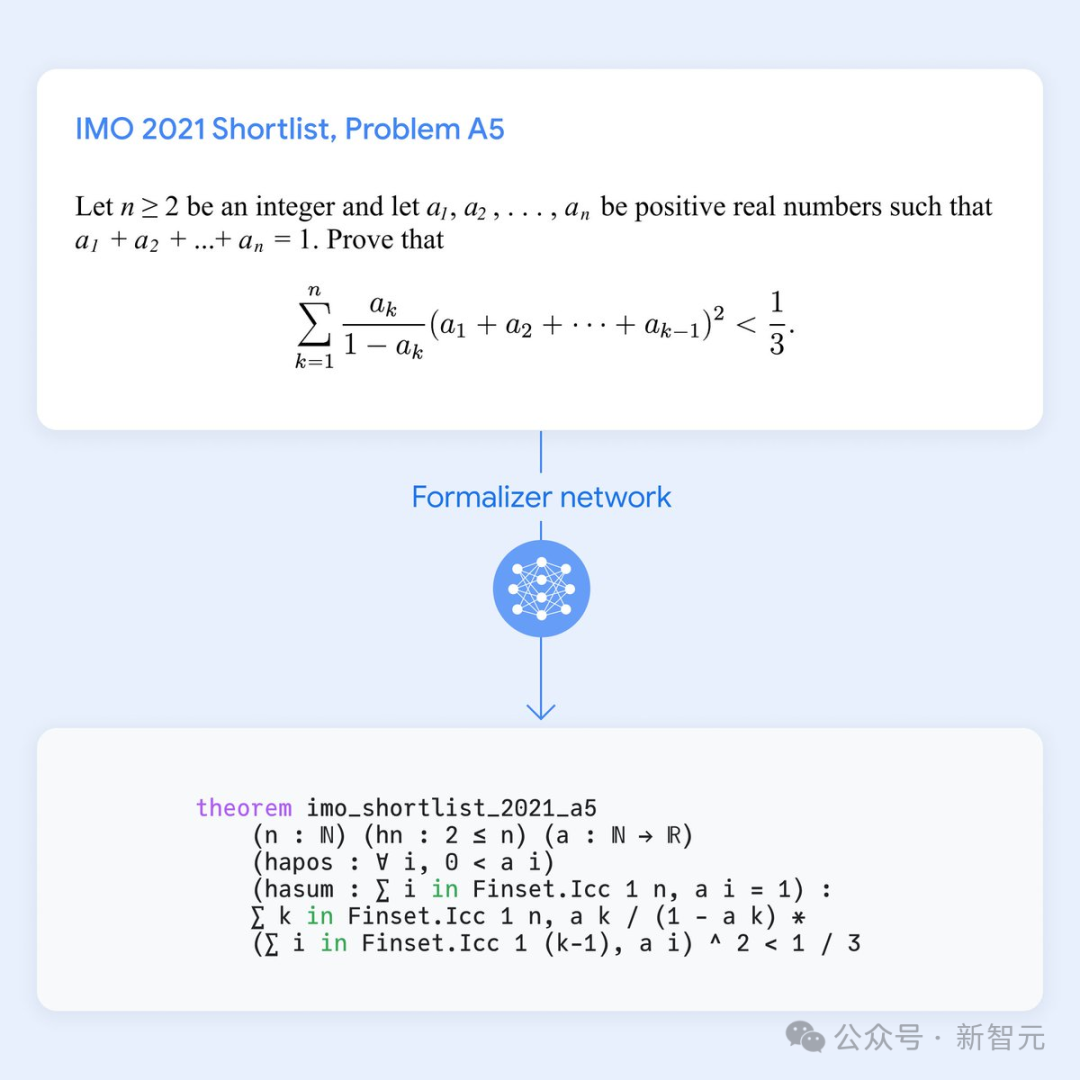

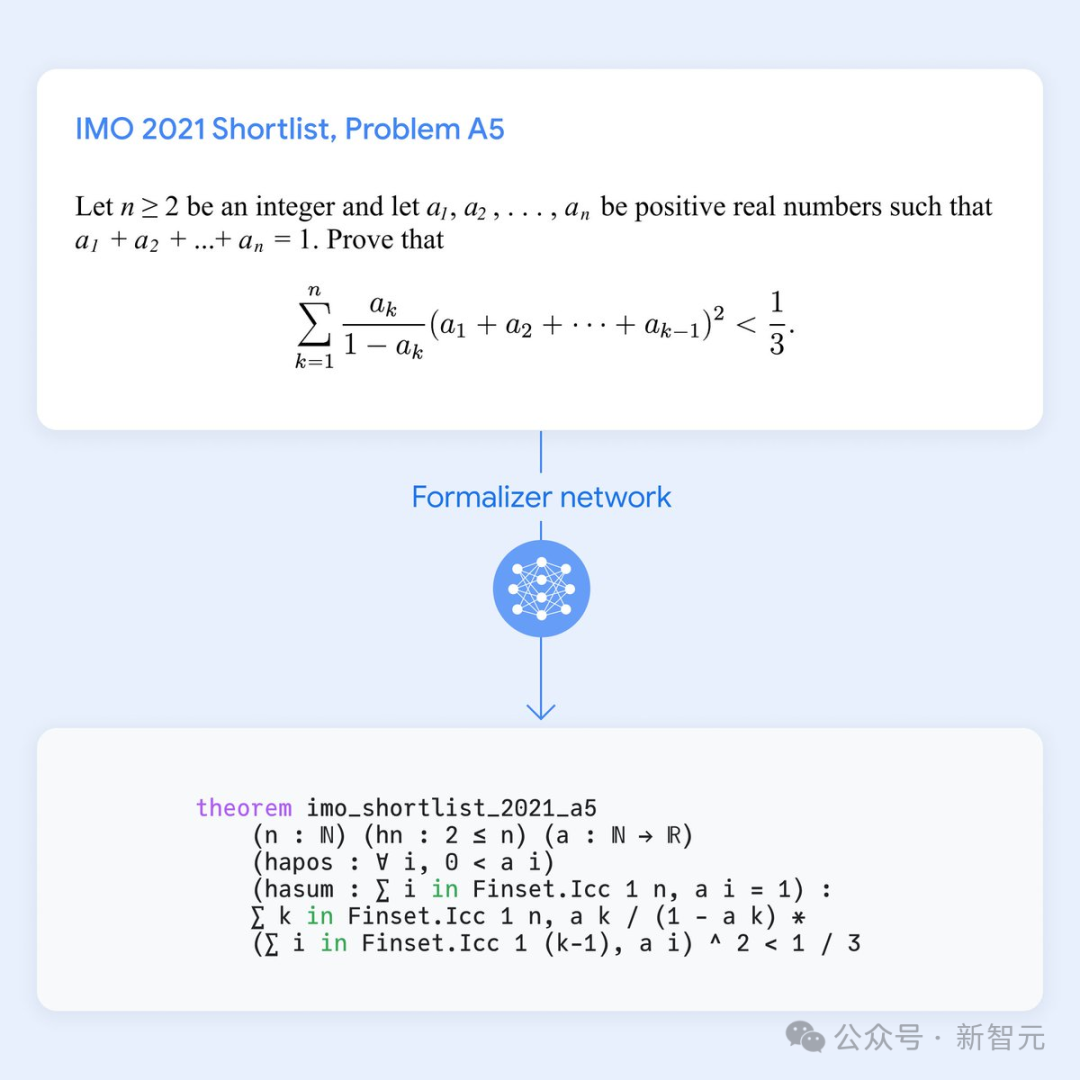

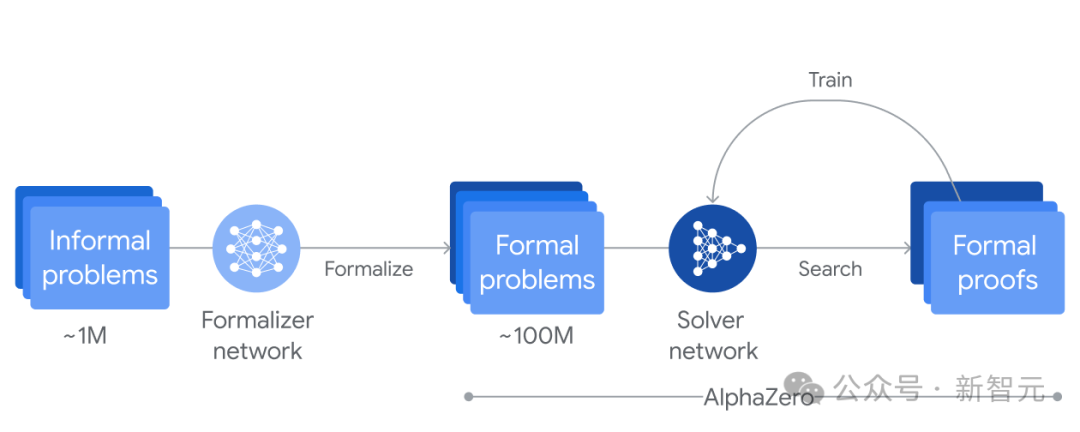

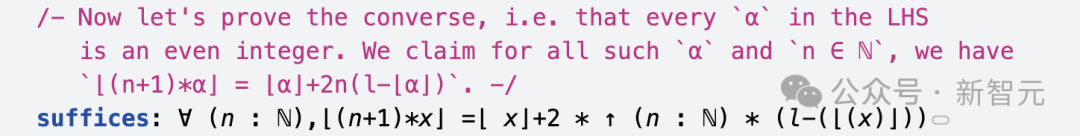

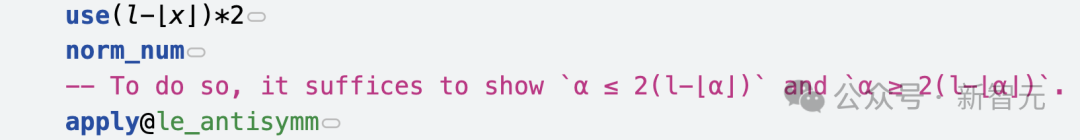

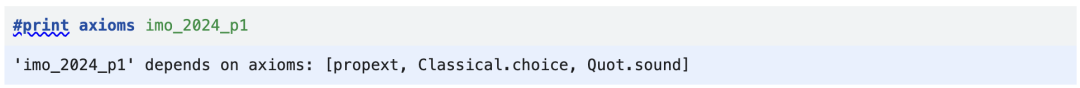

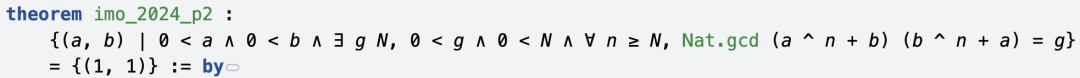

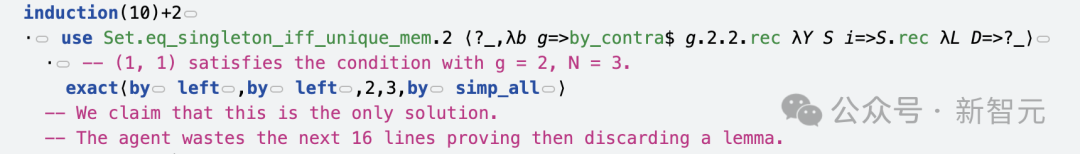

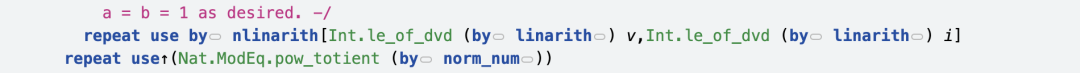

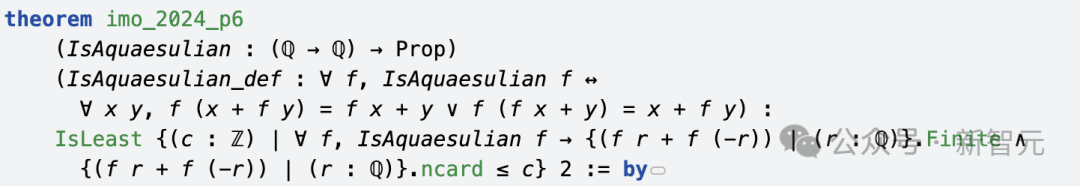

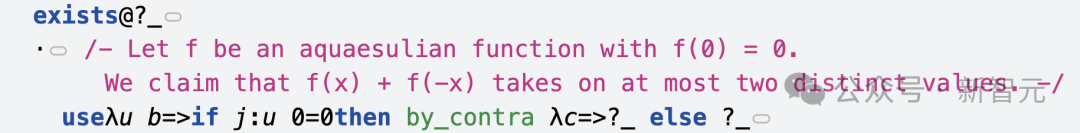

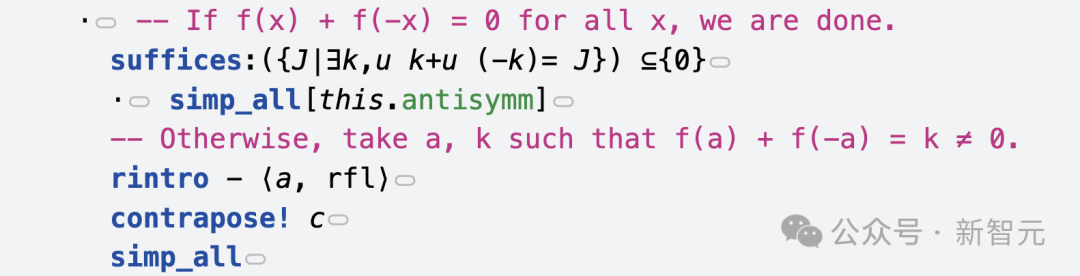

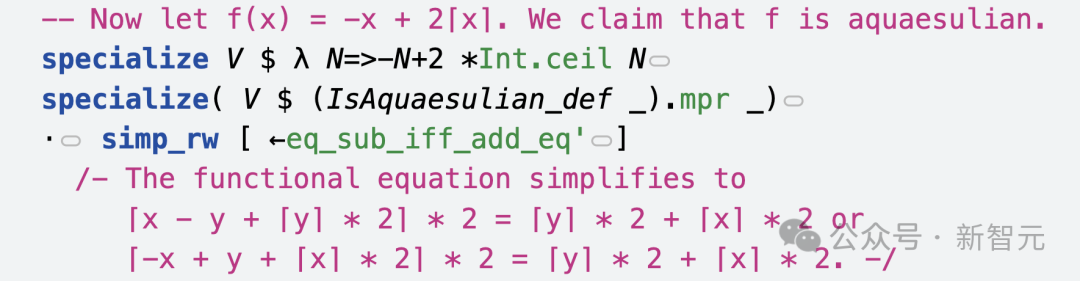

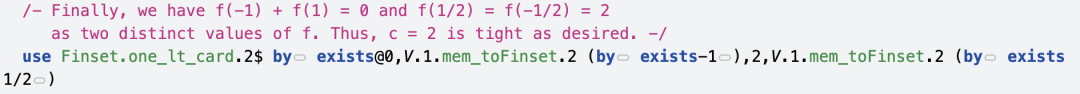

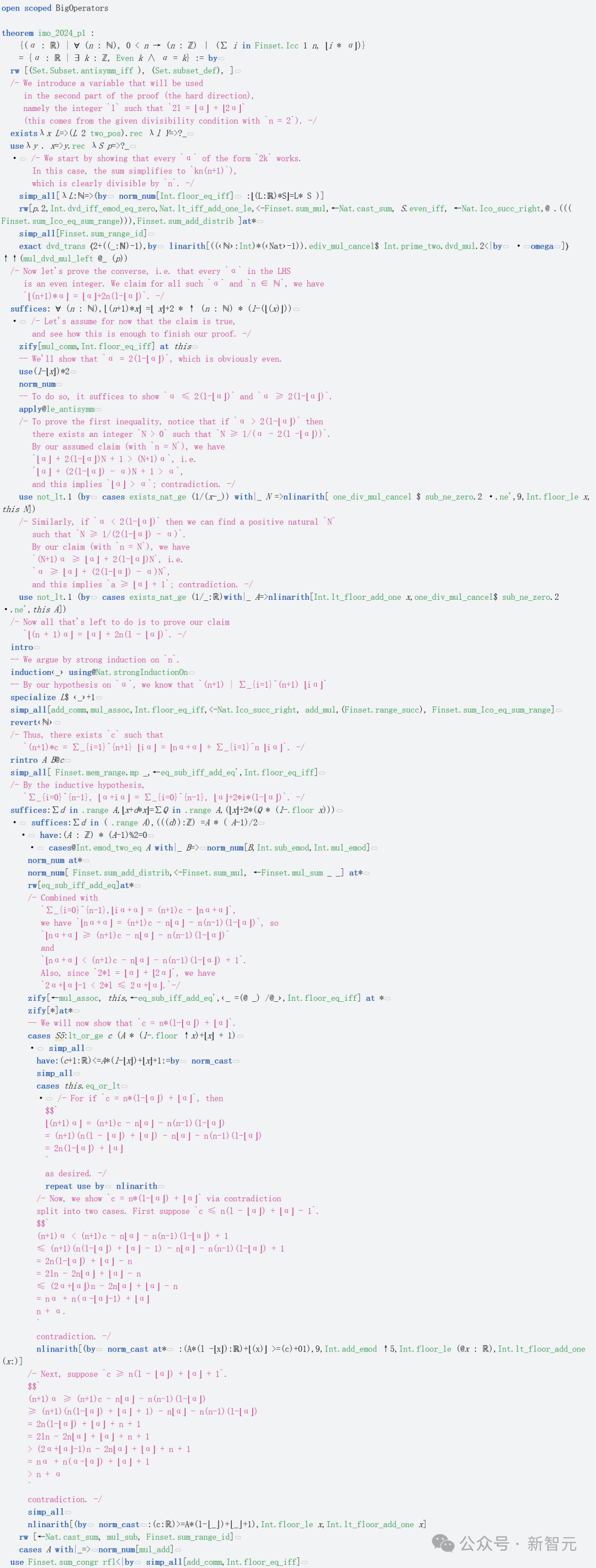

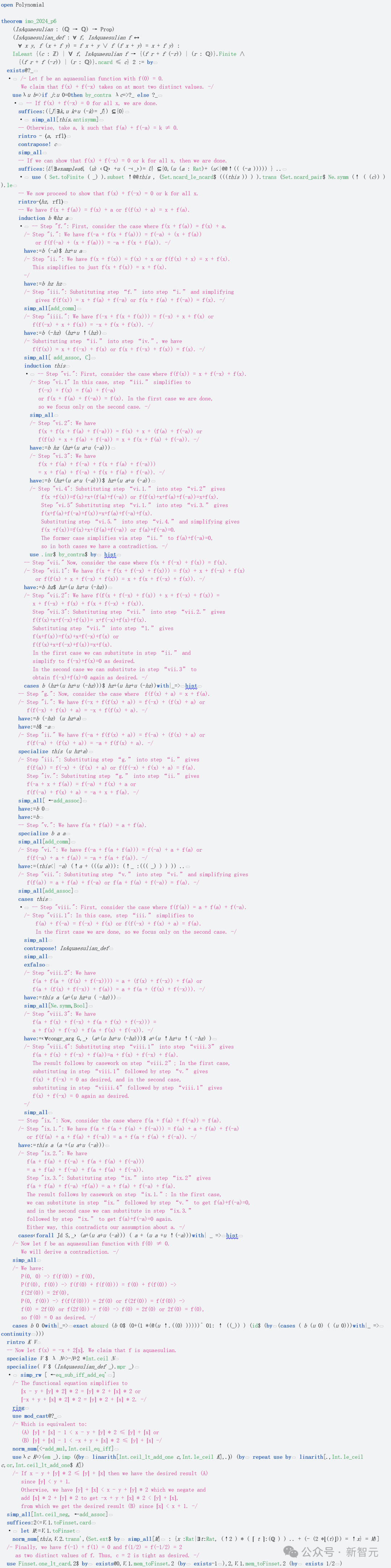

AlphaProof是一个能够在形式化语言Lean中证明数学命题的系统。 它结合了预训练的大语言模型和AlphaZero强化学习算法,后者曾自学掌握了国际象棋、将棋和围棋。 形式化语言的一个关键优势,就是可以对涉及数学推理的证明进行形式化验证。然而,由于人类编写的相关数据量非常有限,它们在机器学习中的应用一直受到限制。 相比之下,基于自然语言的方法尽管可以访问大量数据,但却可能产生似是而非、但不正确的中间推理步骤和解决方案。 为了克服这一点,谷歌DeepMind研究者通过微调Gemini模型,将自然语言问题陈述自动翻译成形式化陈述,建立了一个包含不同难度的形式化问题的大型库,从而在两个互补领域之间架起桥梁。 解题时,AlphaProof会生成候选的解决方案,并通过在Lean中搜索可能的证明步骤,来证明或反驳它们。

每个被找到并验证的证明,都被用于强化AlphaProof的语言模型,让它可以在后续解决更难的问题。 为了训练AlphaProof,研究者证明或反驳了几百万个问题,涵盖了从比赛前几周到比赛期间广泛的难度和数学主题领域。 在比赛期间,他们还应用了训练循环,通过强化自生成的比赛问题变体的证明,直到找到完整的解决方案。

AlphaGeometry 2

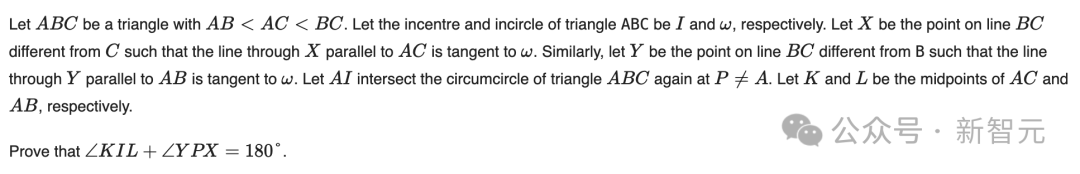

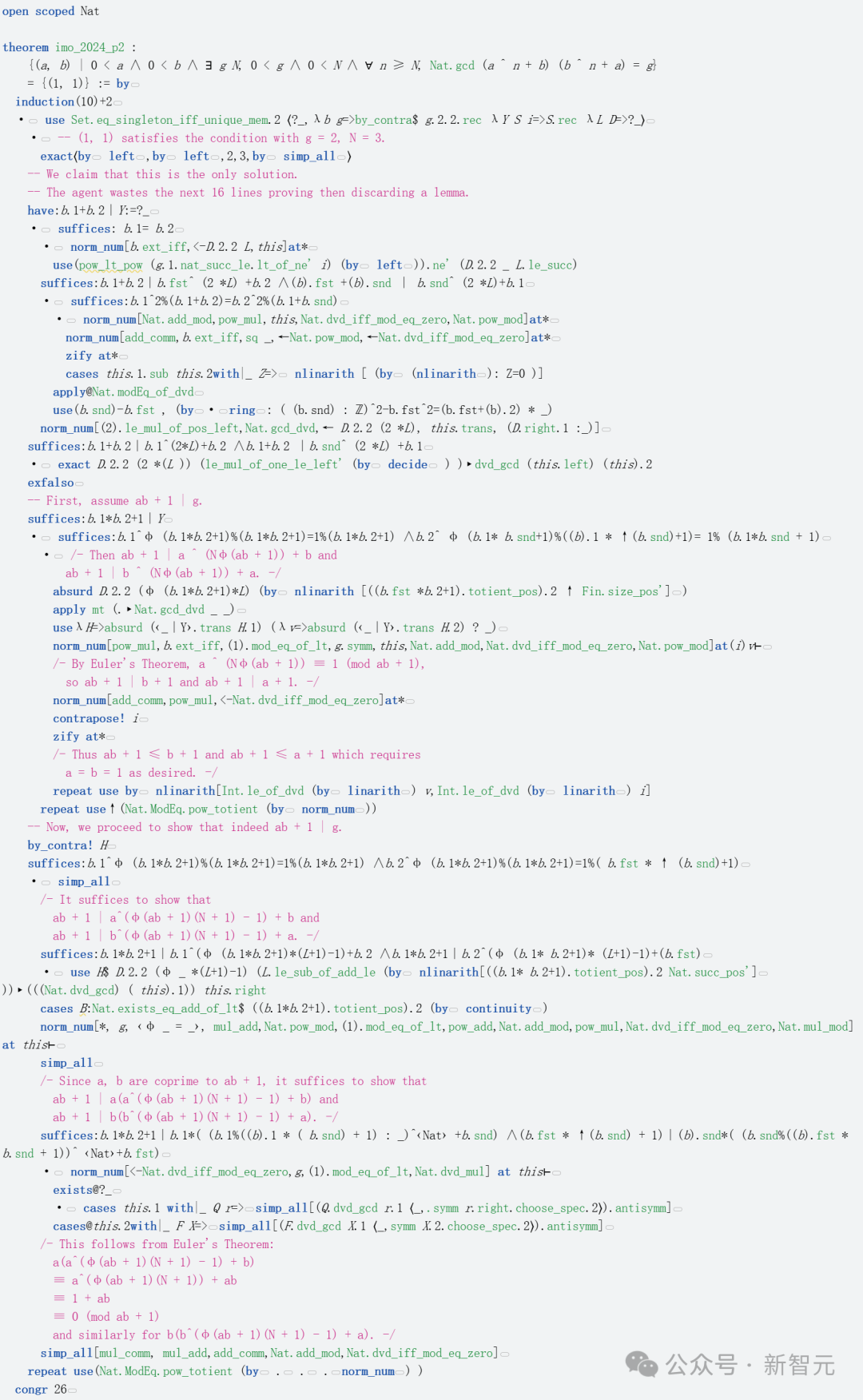

AlphaGeometry的升级版AlphaGeometry 2,是一个神经符号混合系统,基于Gemini的语言模型从头开始训练。 基于比上一代多了一个数量级的合成数据,它能够做出难度更高的几何问题,包括涉及物体运动、角度、比例和距离方程等等。 此外,它还采用了比前一代快两个数量级的符号引擎。当遇到新问题时,它会用一种新颖的知识共享机制,使不同搜索树的高级组合能够解决更复杂的问题。 在今年参赛IMO之前,AlphaGeometry 2已经战绩累累:它能做出过去25年IMO几何赛题中的83%,而第一代只能做出53%。 在这届IMO中,AlphaGeometry 2的神勇速度更是震惊了众人——在接收到形式化问题的19秒内,它就把问题4做出来了!

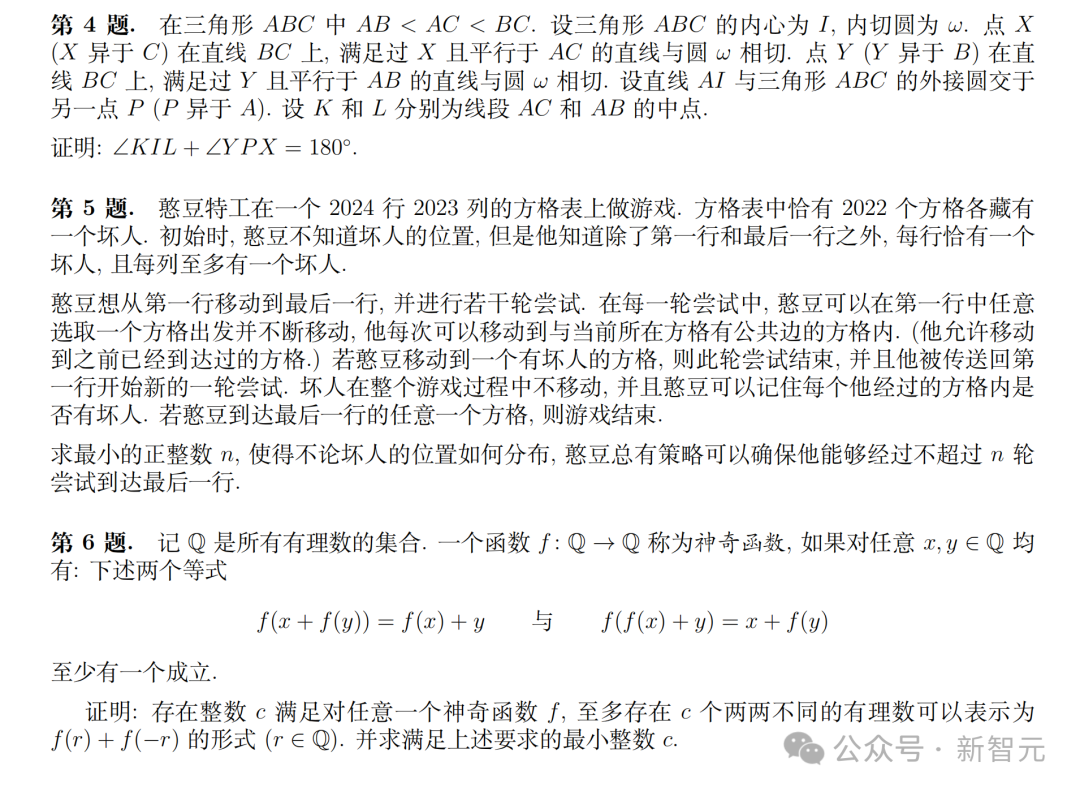

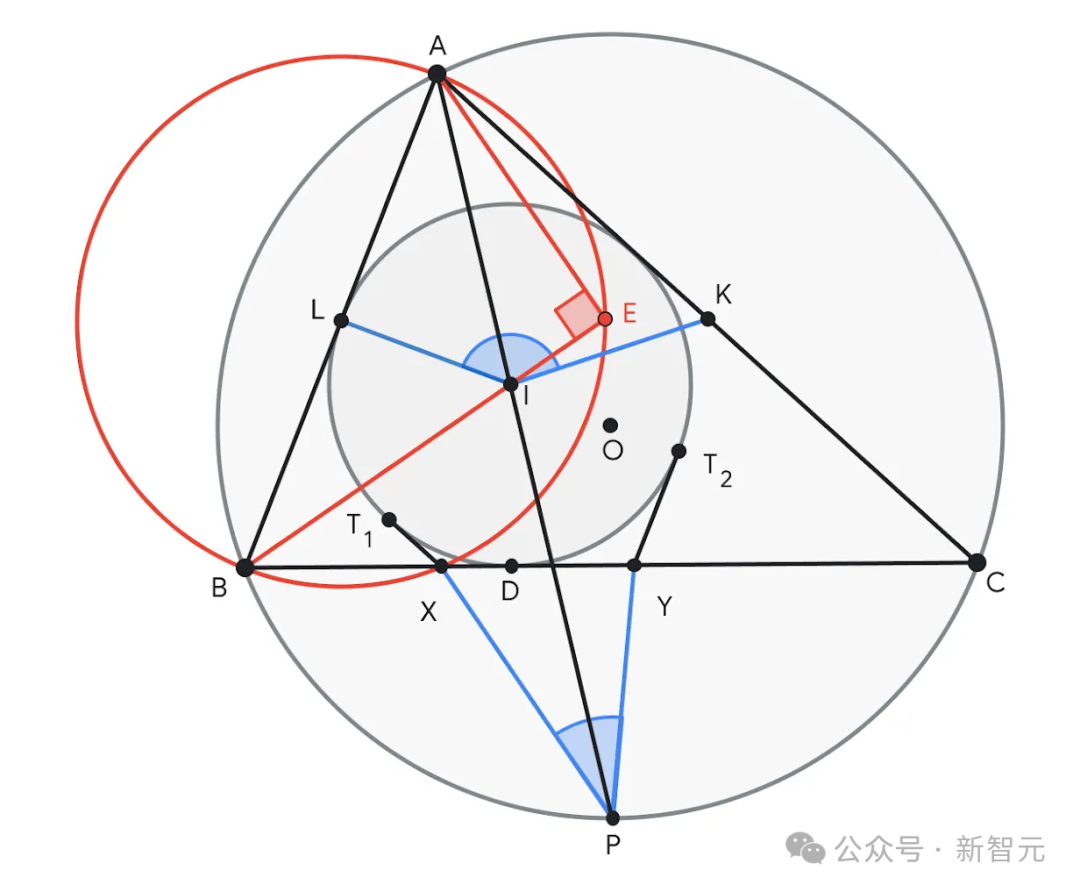

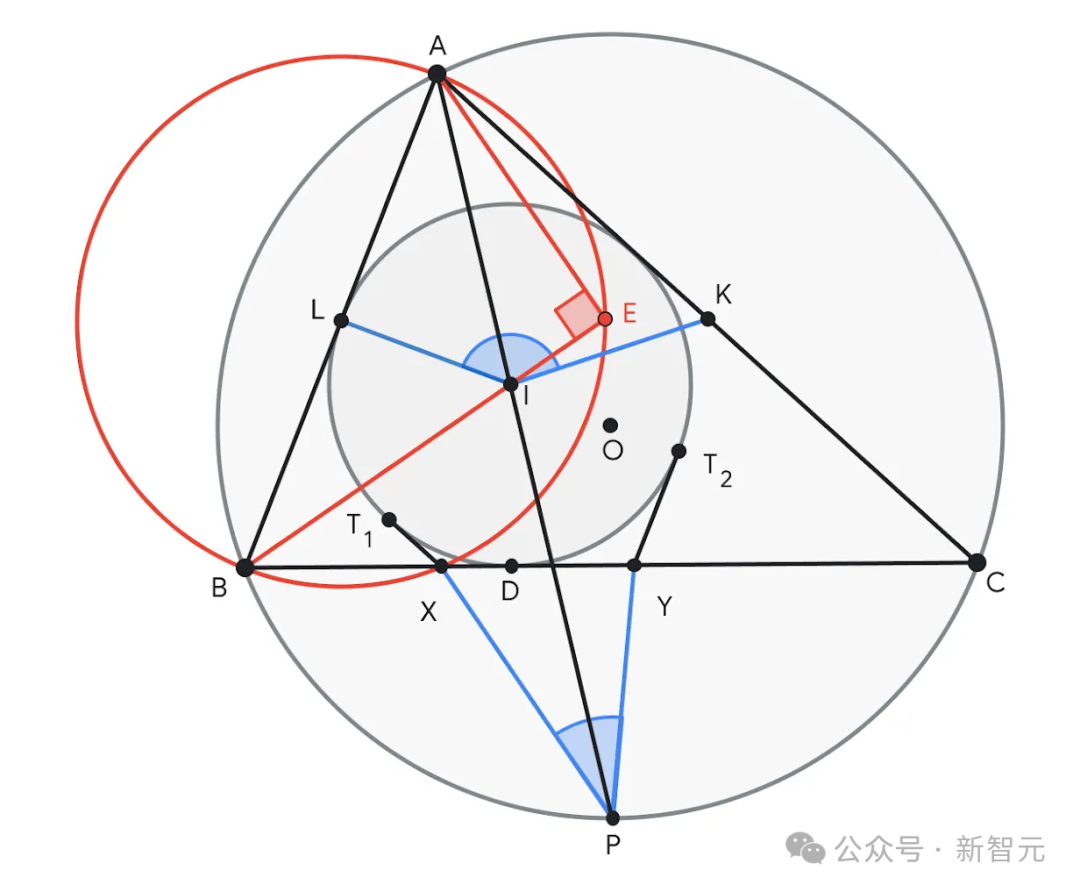

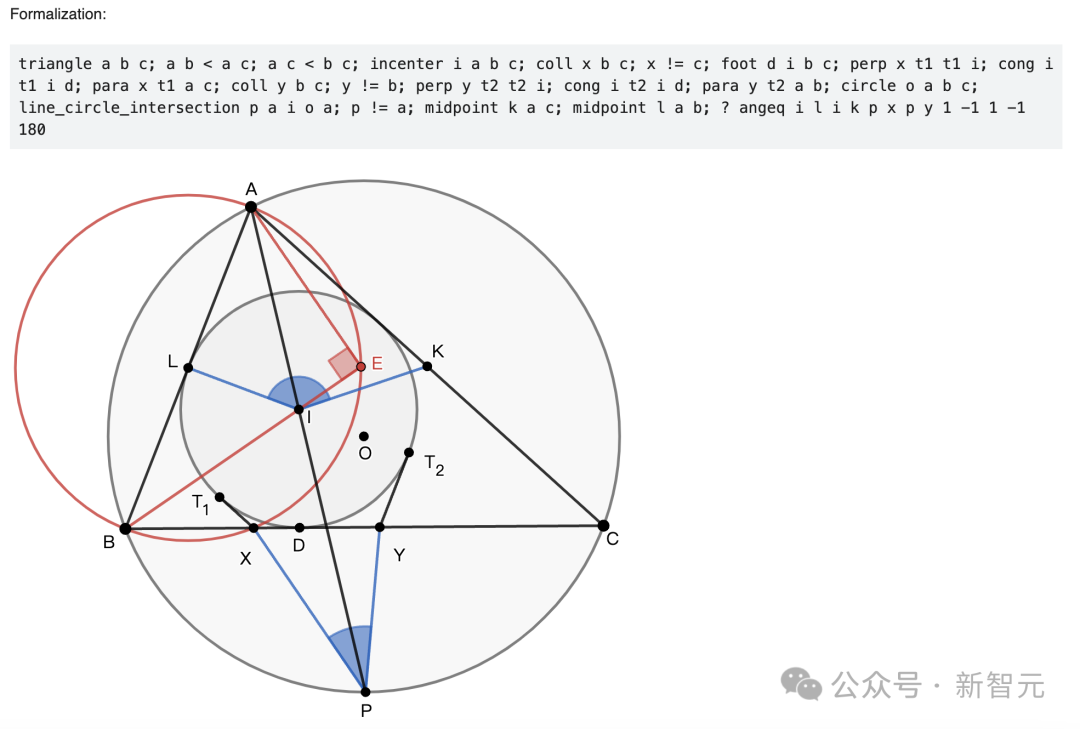

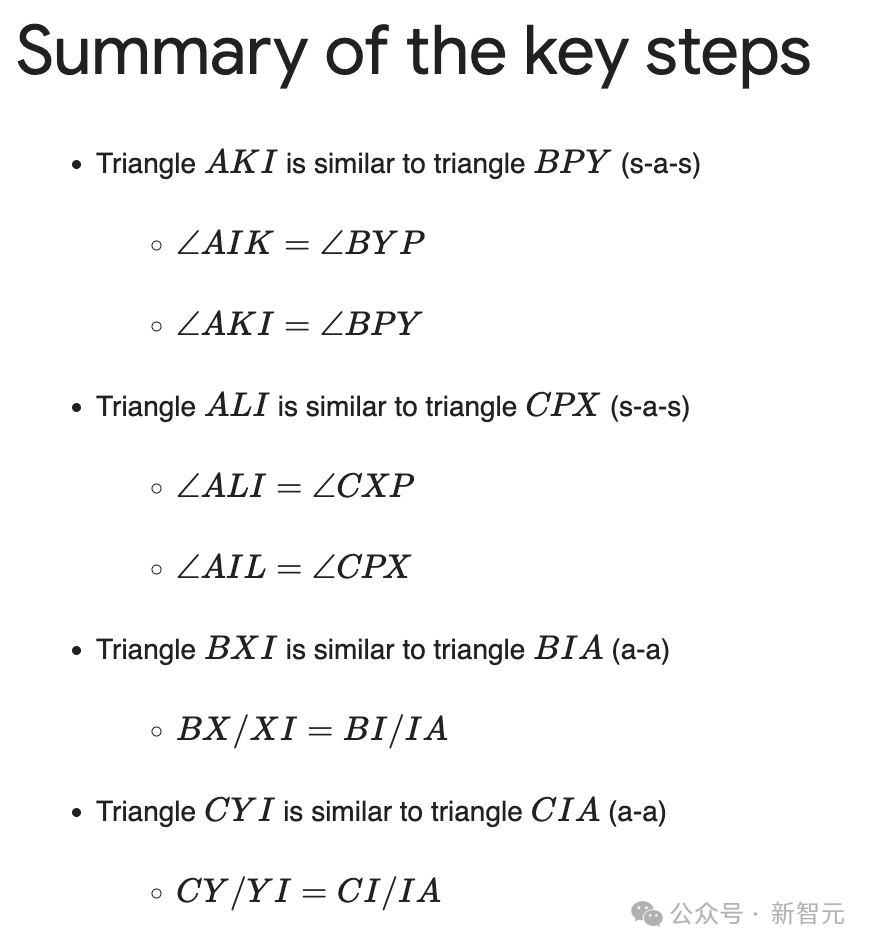

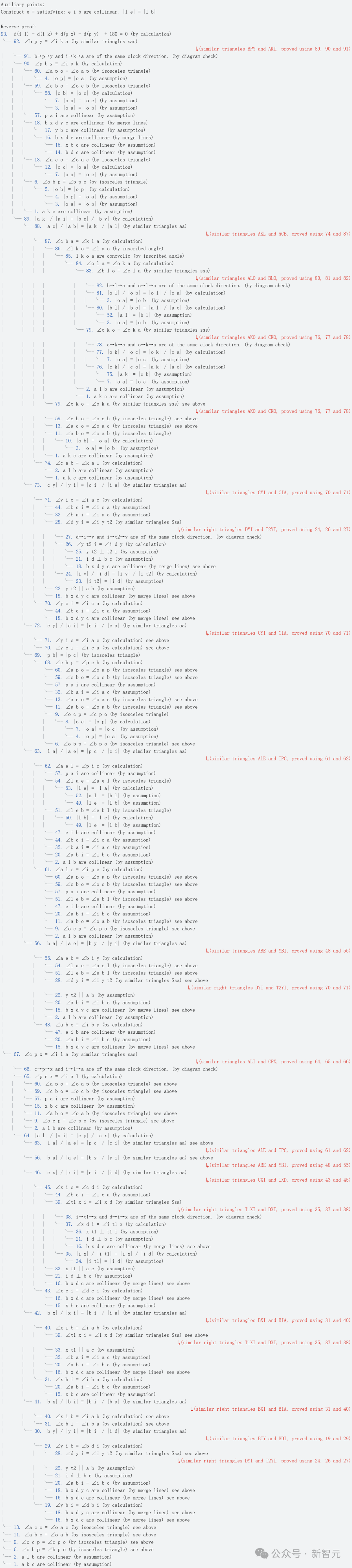

问题4要求证明∠KIL和∠XPY之和等于180°。AlphaGeometry 2建议在BI线上构造一个点E,使得∠AEB=90°。点E有助于确定AB的中点L,形成了许多类似的三角形对,如ABE ~ YBI和ALE ~ IPC,从而证明结论 AI的解题过程

AI的解题过程

值得一提的是,这些问题首先会被人工翻译成正式的数学语言,然后才会投给AI。

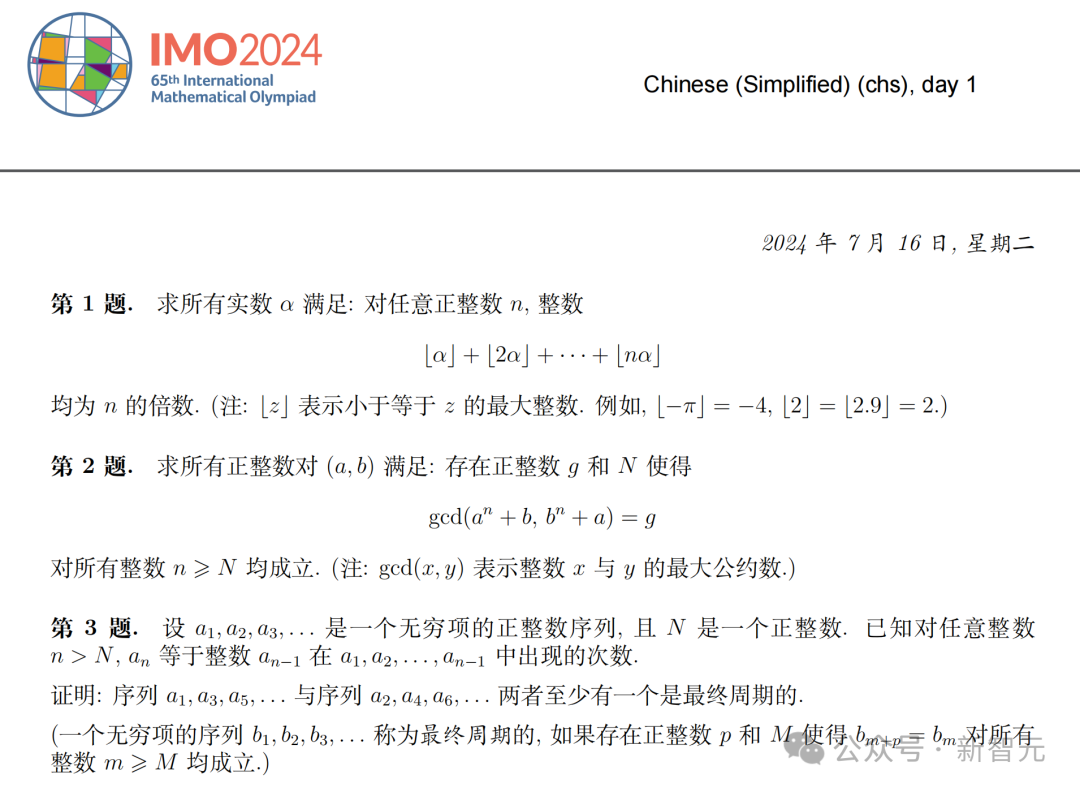

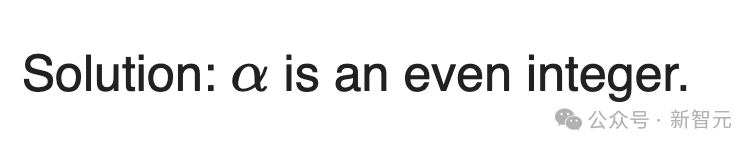

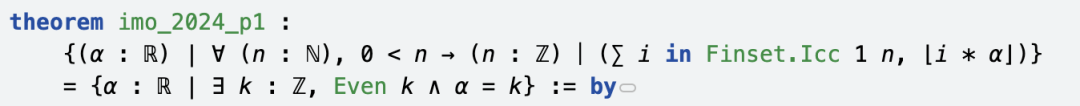

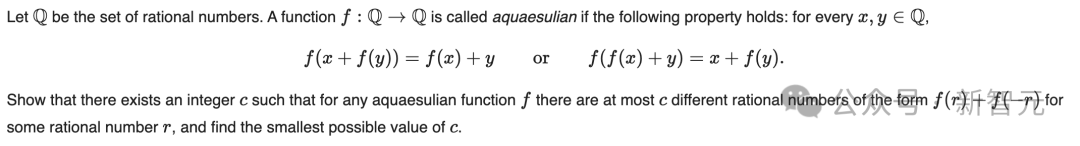

P1

P2

P4

P6

能做奥数题,但能分清9.11和9.9谁大吗?

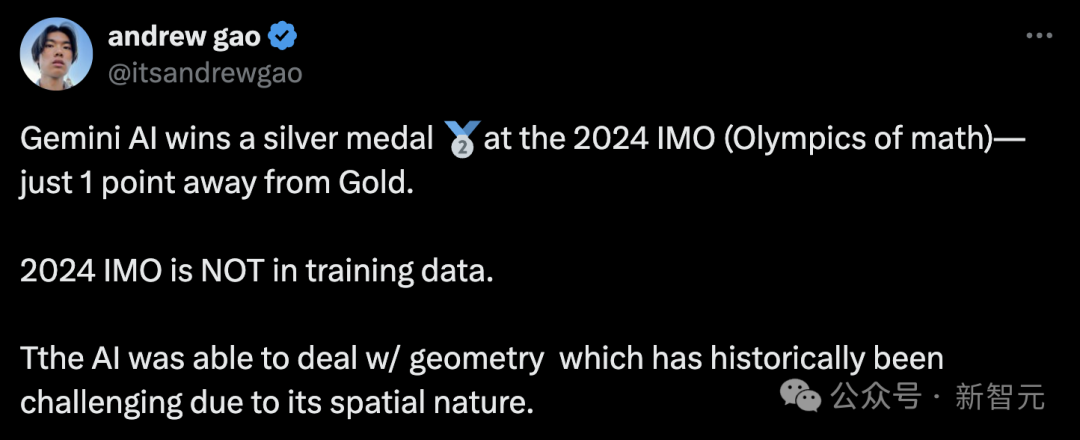

斯坦福大学和红杉的研究员Andrew Gao肯定了这次AI突破的意义—— 关键的是,最新IMO试题不包含训练集中。这一点很重要,说明AI能够处理全新的、未见过的问题。 而且,被AI成功解出的几何问题,由于涉及空间性质(需要直观思维和空间想象力),历来都被认为是极具挑战性的。

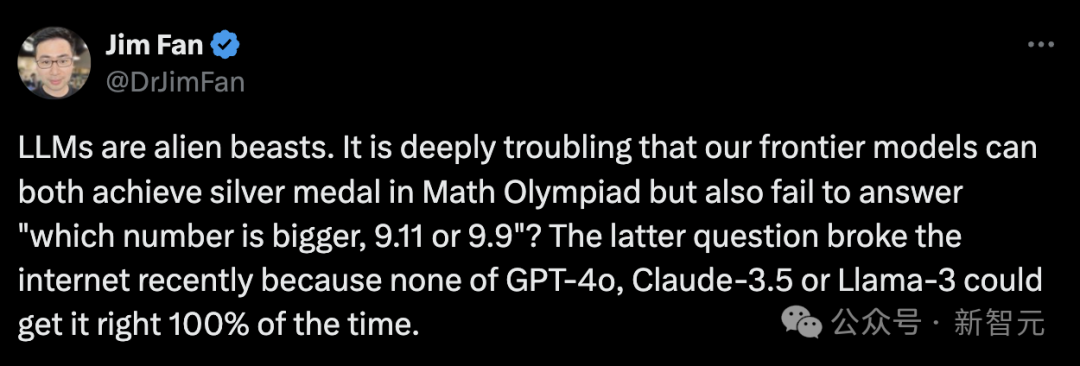

英伟达高级科学家Jim Fan则发长文表示,大模型是神秘的存在—— 它们既能在数学奥林匹克竞赛中获得银牌,又会在「9.11和9.9哪个数字更大」这样的问题上频频出错。 不仅是Gemini,就连GPT-4o、Claude-3.5、Llama-3都无法100%正确回答。

AlphaProof和AlphaGeometry 2,是在形式化证明和特定领域的符号引擎上完成训练。在某种程度上,它们在解决专业的奥林匹克竞赛问题更出色,即使它们基于通用LLM构建的。 而GPT-4o的训练集中,混杂了大量的GitHub代码数据,可能远远超过数学数据。在软件版本中,「v9.11 > v9.9」,可能严重扭曲了数据分布。因此,这个错误在某种程度上是可以理解的。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢