点击蓝字

关注我们

目 录

(一)早期策略

(二)关键案例

(一)节点事件

(二)山姆·奥特曼(Sam Altman)与OpenAI

(一)早期策略

(二)关键案例

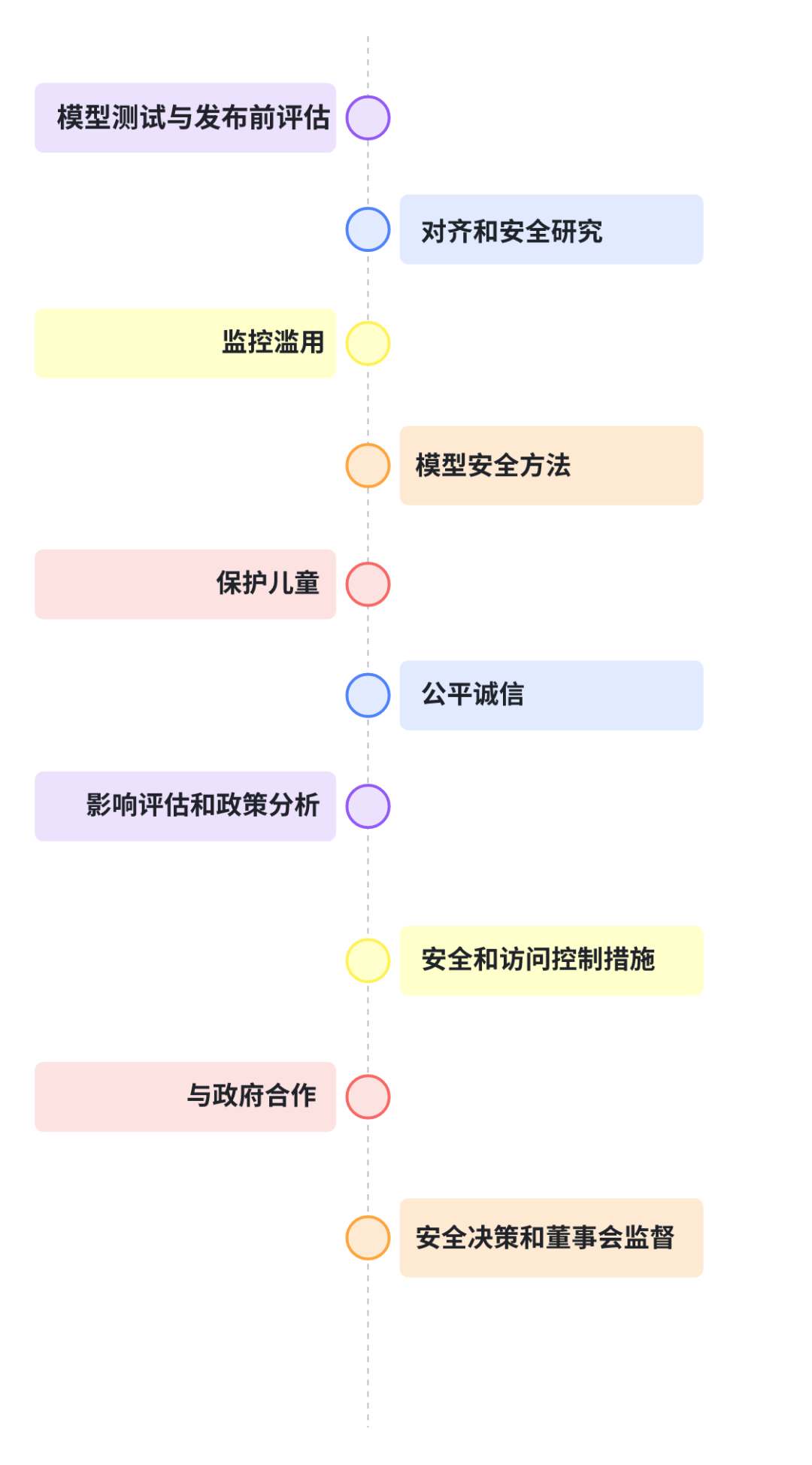

在发布前,OpenAI会准备框架和自愿承诺,对模型安全性进行内部和外部的

实证评估。如果新模型的风险等级达到准备框架中的“中等”风险阈值,将不会

发布该模型,直到实施足够的安全干预措施,将风险等级降低回“中等”。

例如,在发布GPT-4o时,超过70位外部专家帮助OpenAI通过外部努力评估

相关的风险。这种评估不仅包括公司内部的审核,还包括外部专家的参与,以获得更全面的风险评估。

OpenAI的模型随着时间的推移变得更加安全。这可以归因于构建更智能的模型,这些模型通常犯的事实错误更少,即使在越狱等对抗条件下也不太可能产生有害内容。未来,OpenAI的模型将被训练遵循的指令,旨在大幅提高AI模型对越狱等攻击的鲁棒性。

随着通过API和ChatGPT部署越来越强大的语言模型,利用了包括专用内容审核模型和使用自己的模型监控安全风险和滥用在内的广泛工具。

OpenAI已经分享了一些关键发现,包括与微软联合披露的滥用技术案例,以

便其他人能更好地防范类似风险。还使用GPT-4进行内容政策开发和内容审核决策,实现政策细化的快速反馈循环,减少人类审核员暴露于滥用材料。

在模型生命周期的每个阶段实施一系列安全措施,从预训练到部署。随着在开发更安全、更一致的模型行为方面取得进展,也投资于预训练数据安全、系统级模型行为引导、数据飞轮为持续安全改进和强大的监控基础设施。

OpenAI在ChatGPT和DALL·E中构建了强大的默认防护措施和安全措施,以减轻对儿童的潜在伤害。2023年,还与Thorn的Safer合作,检测、审查并向国家失踪和受剥削儿童中心报告儿童性虐待材料。

OpenAI与政府和利益相关者合作,防止滥用确保AI生成内容的透明度,并提高获取准确投票信息的途径。为此,还引入了一个工具,用于识别DALL·E 3创建的图像,加入了内容真实性倡议(C2PA)的指导委员会,并在DALL·E 3中加入了C2PA元数据,帮助人们了解在网上找到的媒体的来源。

OpenAI的影响评估工作在研究、行业规范和政策方面具有广泛影响力,包括早期关于测量AI系统与化学、生物、放射性和核(CBRN())风险相关的工作,以及研究估计不同职业和行业可能受语言模型影响的程度。还发表开创性的工作,探讨社会如何最好地管理相关风险。

优先保护OpenAI的客户、知识产权和数据。通过API将AI模型部署到世界各地,再通过API控制访问实现政策执行。OpenAI的网络安全工作包括限制对训练环境和高价值算法秘密的访问,基于需要知道的原则,进行内部和外部渗透测试,漏洞赏金计划等。

OpenAI认为,保护先进的AI系统将从基础设施安全的演变中受益,并正在探索像GPU的保密计算和AI在网络防御中的应用等新颖控制措施。为了加强网络防御,通过网络安全资助计划资助第三方安全研究人员。

OpenAI与世界各地的政府合作,为有效和适应性强的AI安全政策的发展提供信息。这包括展示工作和分享OpenAI的学习成果,合作试点政府和其他第三方保证,以及为新的标准和法律的公共辩论提供信息。

作为OpenAI准备框架的一部分,建立一个安全决策的操作结构。OpenAI的跨职能安全咨询小组在部署前审查模型能力报告并提出建议。公司领导层会做出最终决定,董事会对这些决定行使监督权。

(一)节点事件

(二)山姆·奥特曼(Sam Altman)与OpenAI

AI的安全性需要多方努力 AI 不会取代人类。 随着AI技术的发展,网络安全等问题也随之而来,这需要社会各界共同关注和解决。 他还呼吁全球合作应对人工智能风险,强调未来十年内我们很可能会拥有非常强大的人工智能系统,任何潜在影响都会成倍增加,因此需要国际间的协作来确保其安全性。 奥特曼多次提到监管人工智能的必要性,敦促国会对大型科技公司实施新规则以确保AI系统的安全性和可靠性。 他认为目前AI安全研究者过于关注某些具体的技术进步,而忽视了其他一些重要的问题,需要更全面的研究视角。

关于我们

清华大学人工智能国际治理研究院(Institute for AI International Governance, Tsinghua University,THU I-AIIG)是2020年4月由清华大学成立的校级科研机构。依托清华大学在人工智能与国际治理方面的已有积累和跨学科优势,研究院面向人工智能国际治理重大理论问题及政策需求开展研究,致力于提升清华在该领域的全球学术影响力和政策引领作用,为中国积极参与人工智能国际治理提供智力支撑。

新浪微博:@清华大学人工智能国际治理研究院

微信视频号:THU-AIIG

Bilibili:清华大学AIIG

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢