关键词:通用指令导航,具身智能,大模型

导 读

本文是对发表于 CoRL 2024 的论文 InstructNav: Zero-shot System for Generic Instruction Navigation in Unexplored Environment 的解读。该论文由北京大学前沿计算研究中心董豪课题组主导完成。

本文提出一种零样本的通用指令导航大模型系统 InstructNav,通过设计动态导航链路统一不同类型导航指令的规划,在每一步导航决策前根据环境语义信息更新导航链路,并基于该链路生成动作、语义、轨迹和直觉价值地图联合完成导航决策。

InstructNav 首次实现一个导航框架完成多种截然不同的导航指令,首次实现零样本视觉语言导航,并在零样本的物体目标导航和需求驱动导航上成功率远超现有方法。

论文链接:

https://arxiv.org/pdf/2406.04882

项目主页:

https://sites.google.com/view/instructnav

代码链接:

https://github.com/LYX0501/InstructNav

项目视频:

相关报道:

by 量子位

01

概 览

不同类型的指令导航任务要求具备截然不同的能力。经典的物体导向任务,如“Find a bed”,需要理解房间的结构以及物体之间的关系;而视觉语言导航任务,例如“往前走到海报附近然后右拐进办公室”,则侧重于严格遵循指令。此外,新兴的需求驱动导航任务,如“帮我找个地方休息一下”,则要求根据人类的抽象需求进行语义推理。

以往的研究主要围绕特定类型的指令设计相应的导航方法。然而,在实际应用中,人类可能会向机器人下达多种形式的指令,甚至是混合类型的指令,例如“转身走进厨房寻找一个水池”,这同时包含了视觉语言导航和物体目标导航。目前的具身导航模型无法满足这样的实际需求,因此,实现通用指令导航对于机器人在现实世界中的应用具有重要价值。

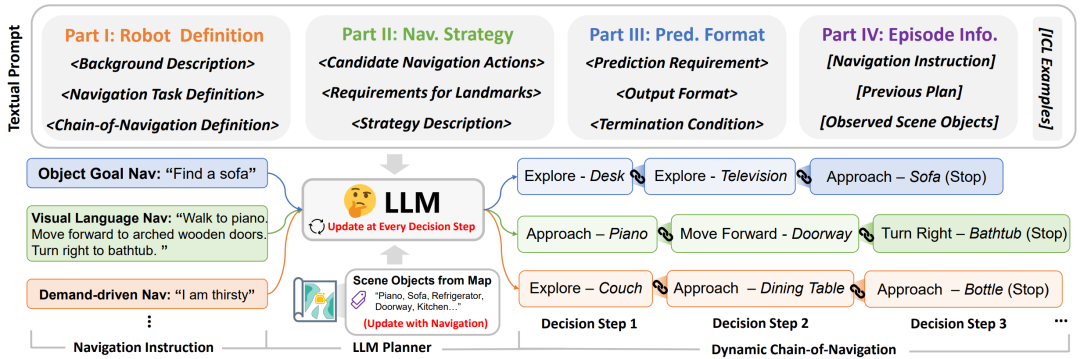

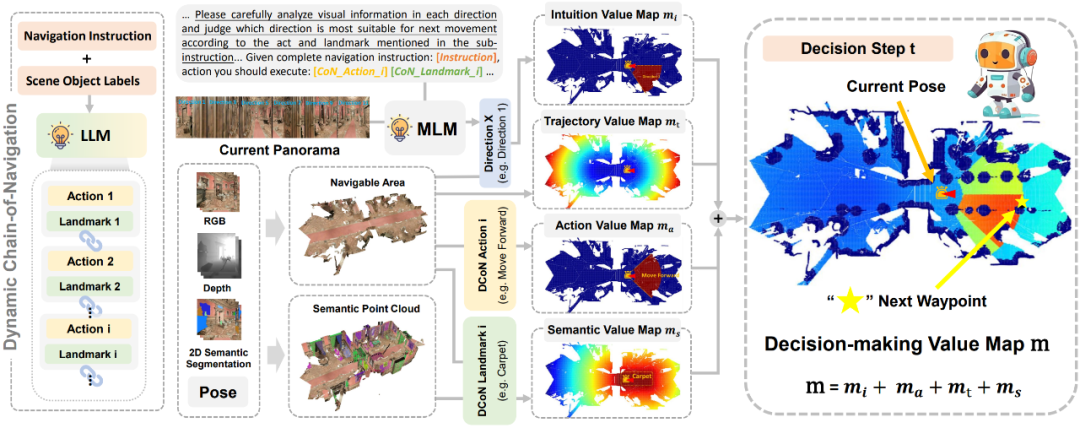

为了这一目标,本文提出一个零样本的通用指令导航大模型系统 InstructNav。本方法中,多种不同类型的导航指令被统一为动态导航链路,该链路有效刻画了指令导航中最关键的动作和地标,并会根据导航过程中实时观测到的环境语义信息动态更新。基于动态导航链路中的信息进一步生成动作、语义、轨迹和直觉价值地图,这些地图联合完成导航高层决策,配合底层路径规划算法即可实现通用指令导航。

仿真实验和真机评测证明,InstructNav 是首个实现一个导航框架完成多种类型导航指令的方法,首次实现零样本视觉语言导航,并在零样本的物体目标导航和需求驱动导航上成功率远超现有方法。

02

动态导航链路

为了统一不同导航指令,本文首先提出动态导航链路(Dynamic Chain-of-Navigation)这一全新的导航规划范式,将不同类型的导航指令统一为“导航动作 1 - 标志物1 -> 导航动作 2 - 标志物 2 … ”的标准形式。

InstructNav 利用大语言模型在任务规划和常识推理上的卓越能力,根据原始指令规划导航链路。在导航过程中,InstructNav 会根据最新观测到的场景物体不断更新导航链路,引导机器人对于环境进行有效探索。例如,当指令要求“Find a sofa”时,如果视野中检测到“Sofa”,动态导航链路会被更新为“Explore - Television”附近区域,因为电视旁边最可能存在沙发。

03

多源价值地图

为了引导机器人根据动态导航链路中的信息完成导航高层决策,本文提出将大模型的规划结果映射到多源价值地图(Multi-sourced Value Maps)上,这些价值地图包括:

动作价值地图(Action Value Map):赋予待执行动作对应的区域更高可导航价值。如动作为“Move Forward”,则前方被赋予更高价值。

语义价值地图(Semantic Value Map):赋予标志物附近区域更高可导航价值。如地标为“Carpet”,则地毯附近被赋予更高价值。

直觉价值地图(Intuition Value Map):利用多模态大模型判断全景图中最适合移动的方向,并赋予对应区域更高可导航价值。

轨迹价值地图(Trajectory Value Map):赋予远离现有轨迹的区域更高的可导航价值。

通过对多源价值地图相加求和即可得到决策价值地图(Decision-making Value Map):

04

实验结果

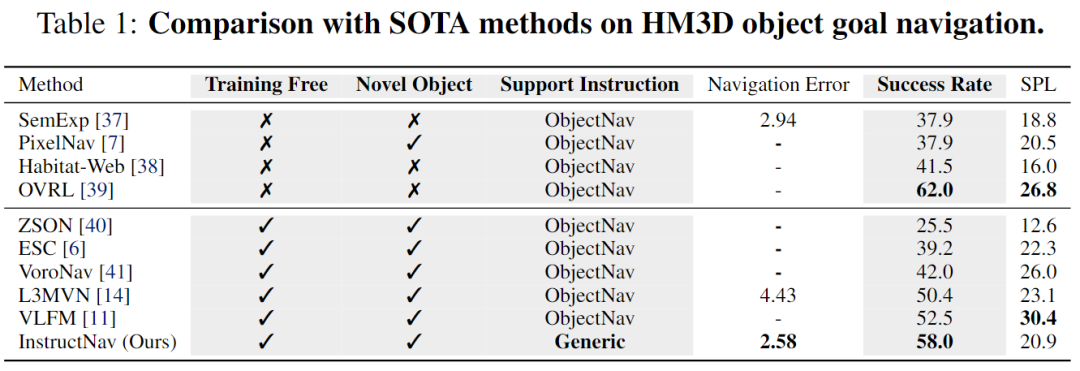

本文在物体目标导航,视觉语言导航和需求驱动导航三个不同类型的指令导航任务上进行评测。物体目标导航任务评测基于 Habitat 仿真器中的 HM3D 场景进行,如 Table 1所示,InstructNav 成功率超过所有零样本的物体目标导航方法,甚至接近训练方法 OVRL。

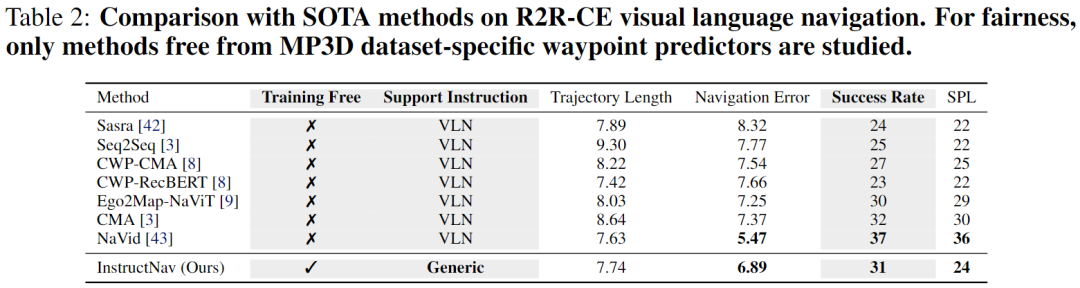

视觉语言导航任务评测基于 Habitat 仿真器中的 MP3D 场景和 VLN-CE 指令进行,如 Table 2所示,InstructNav 首次实现零样本视觉语言导航,且成功率与相同设定的训练方法接近。

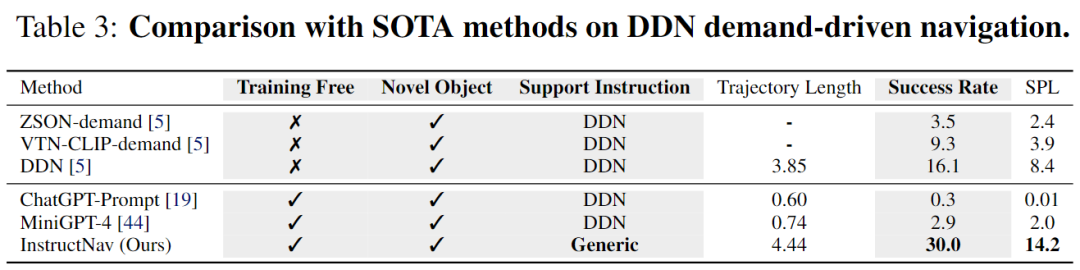

需求驱动的导航任务评测基于 AI2Thor 仿真器的 ProcThor 场景和 DDN 指令进行,如 Table 3所示,InstructNav 成功率大幅度超过现有的训练方法和零样本方法。

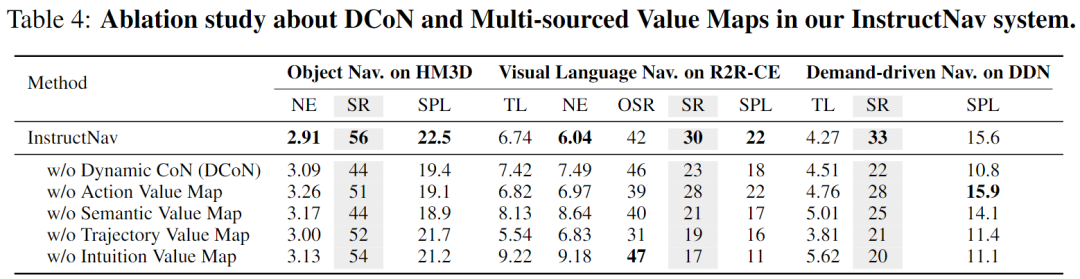

为验证动态导航链路和不同价值地图对于 InstructNav 方法的决策影响,本文在以上三种指令导航任务上各随机选取100条数据进行消融实验。如 Table 4所示,动态导航链路对于不同类型的指令导航任务规划都有不可或缺的重要作用,不同种类的价值地图对于提升通用指令导航的性能都有贡献,由此证明本文设计的动态导航链路和多源价值地图为实现通用指令导航提供了有效的解决方案。

此外,本文还完成关于全景图方向数量的消融实验以及基于多种开源大模型实现 InstructNav 的效果比较实验以供参考。

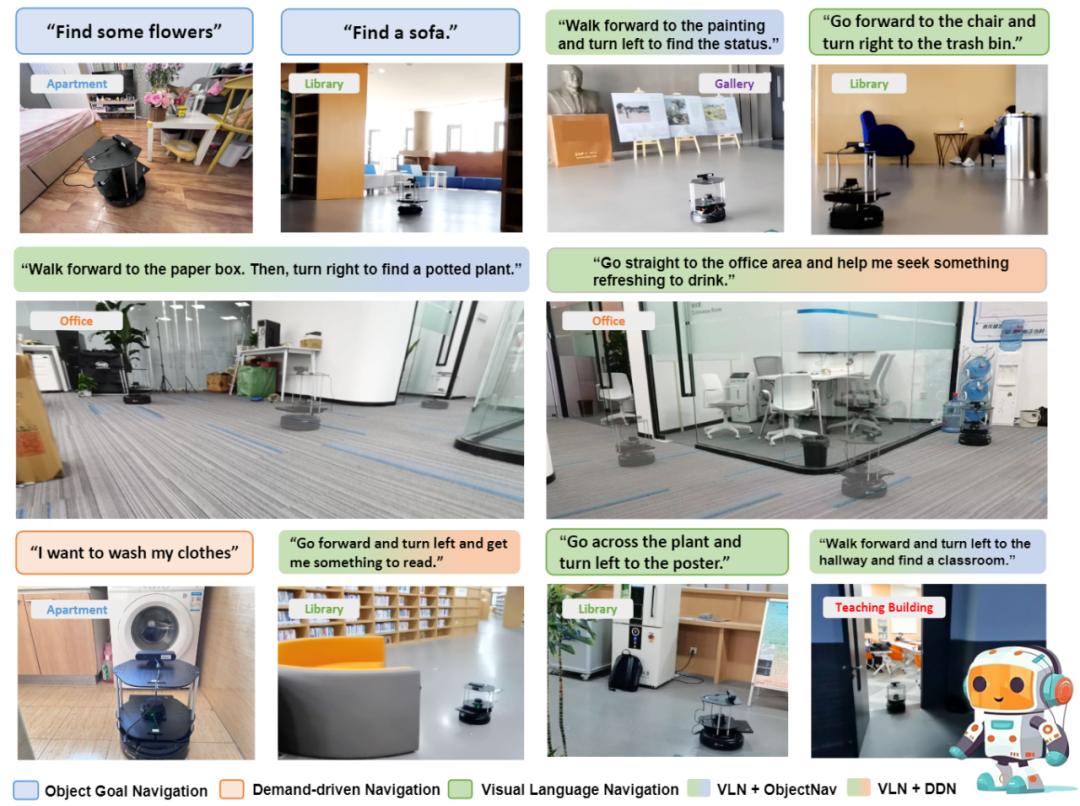

得益于大模型零样本推理的鲁棒优势,在多个真实环境中(公寓,图书馆,教学楼,办公室,画廊),InstructNav 成功驱动 Turtlebot 4机器人执行多种类型的导航指令,甚至混合类型的导航,展现出真实应用的强大潜力。

PKU-Agibot Lab

PKU-Agibot Lab 由北京大学前沿计算研究中心董豪助理教授领导,该科研团队专注于机器人视觉,物体操作,语义导航和具身自主决策等领域的前沿技术,致力于为工业应用和家用场景创建具有成本效益的人形机器人。

实验室 PI 简介:董豪 助理教授

扫码浏览实验室主页

https://zsdonghao.github.io/

图文 | 龙宇星

PKU-Agibot Lab

PKU-Agibot Lab 近期科研动态

— 版权声明 —

本微信公众号所有内容,由北京大学前沿计算研究中心微信自身创作、收集的文字、图片和音视频资料,版权属北京大学前沿计算研究中心微信所有;从公开渠道收集、整理及授权转载的文字、图片和音视频资料,版权属原作者。本公众号内容原作者如不愿意在本号刊登内容,请及时通知本号,予以删除。

点击“阅读原文”转论文地址

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢