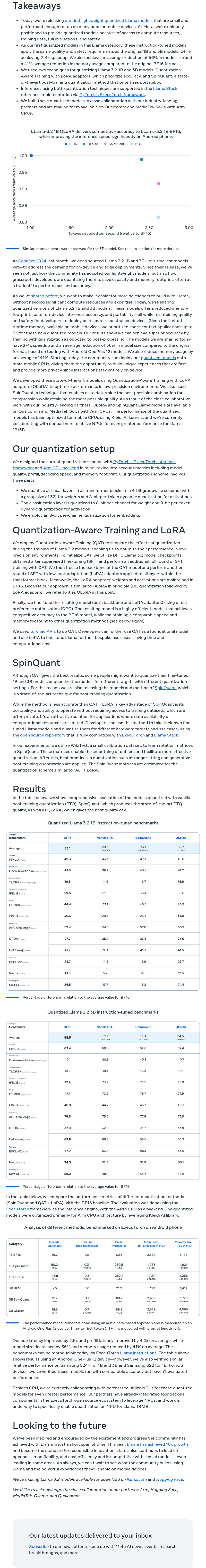

Meta发布了其首个轻量级量化Llama模型,这些模型体积小且性能高,能够在多种流行的移动设备上运行。凭借计算资源、训练数据、全面评估和安全性方面的优势,Meta能够提供这些量化模型。这些经过指令调优的模型在保持与原1B和3B模型相同质量和安全标准的同时,实现了2-4倍的速度提升,并平均减少了56%的模型大小和41%的内存使用。Meta采用了两种量化技术:Quantization-Aware Training with LoRA适配器,侧重于精度;SpinQuant,一种最先进的后训练量化方法,侧重于可移植性。这两种量化技术的推理均通过PyTorch的Ex在Llama Stack参考实现中得到支持。

本专栏通过快照技术转载,仅保留核心内容

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢