图(Graph)是现实世界中普遍存在的数据类型,因为它可以作为实体及其互连的简洁而强大的抽象。因此,生成编码图信息的高质量图表示非常重要,因为这些表示将有助于图相关任务。在这种背景下,图神经网络 (GNN) 已成为一项重大进步,并因其学习强大图表示的能力而备受瞩目,这些能力可在各种基于图的应用程序中实现最先进的性能。

然而,尽管 GNN 具有非凡的能力,但其设计和训练过程仍然充满挑战。鉴于此,我的研究目标是从有效性和效率的角度识别和解决这些障碍,旨在开发强大且可扩展的 GNN 模型,从而增强 GNN 在实践中生成卓越图表示的能力。本论文系统地研究了两个基本问题:(1)是什么阻碍了 GNN 的有效性?(2)如何有效地训练 GNN?尽管对每个问题都进行了全面的讨论,但它提出了缓解各个方面问题的实用解决方案,并且涵盖了同质图(homogeneous graphs)和异构图(heterogeneous graphs )。

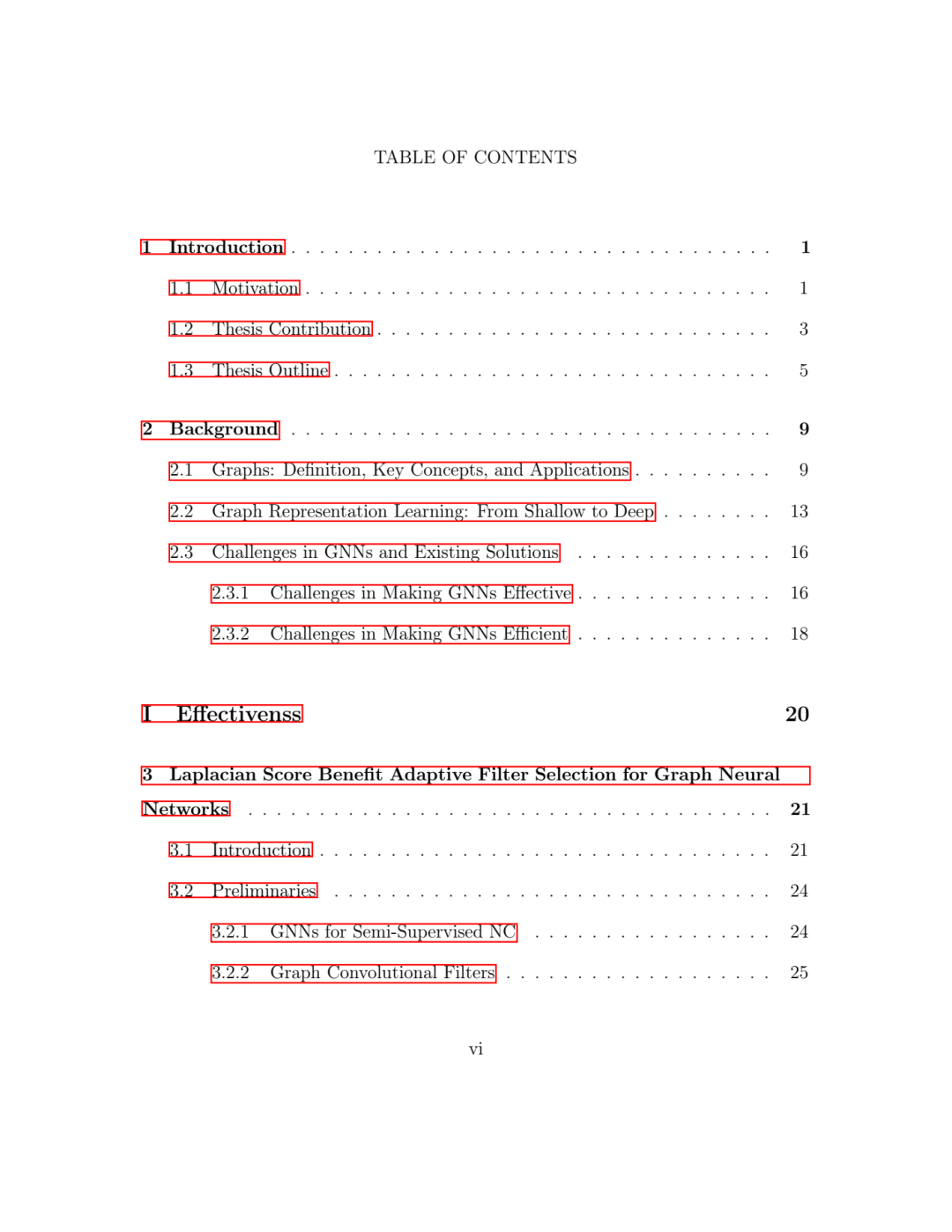

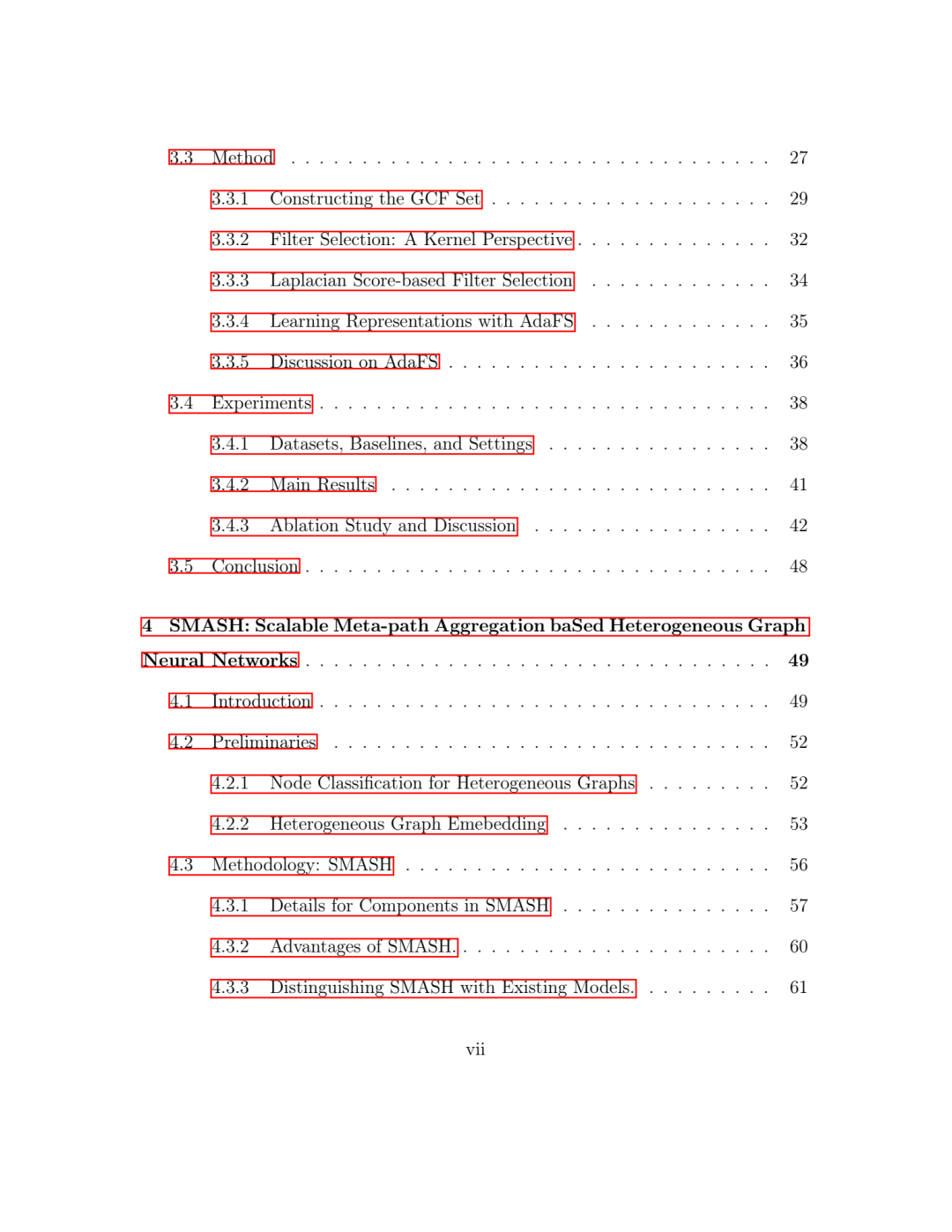

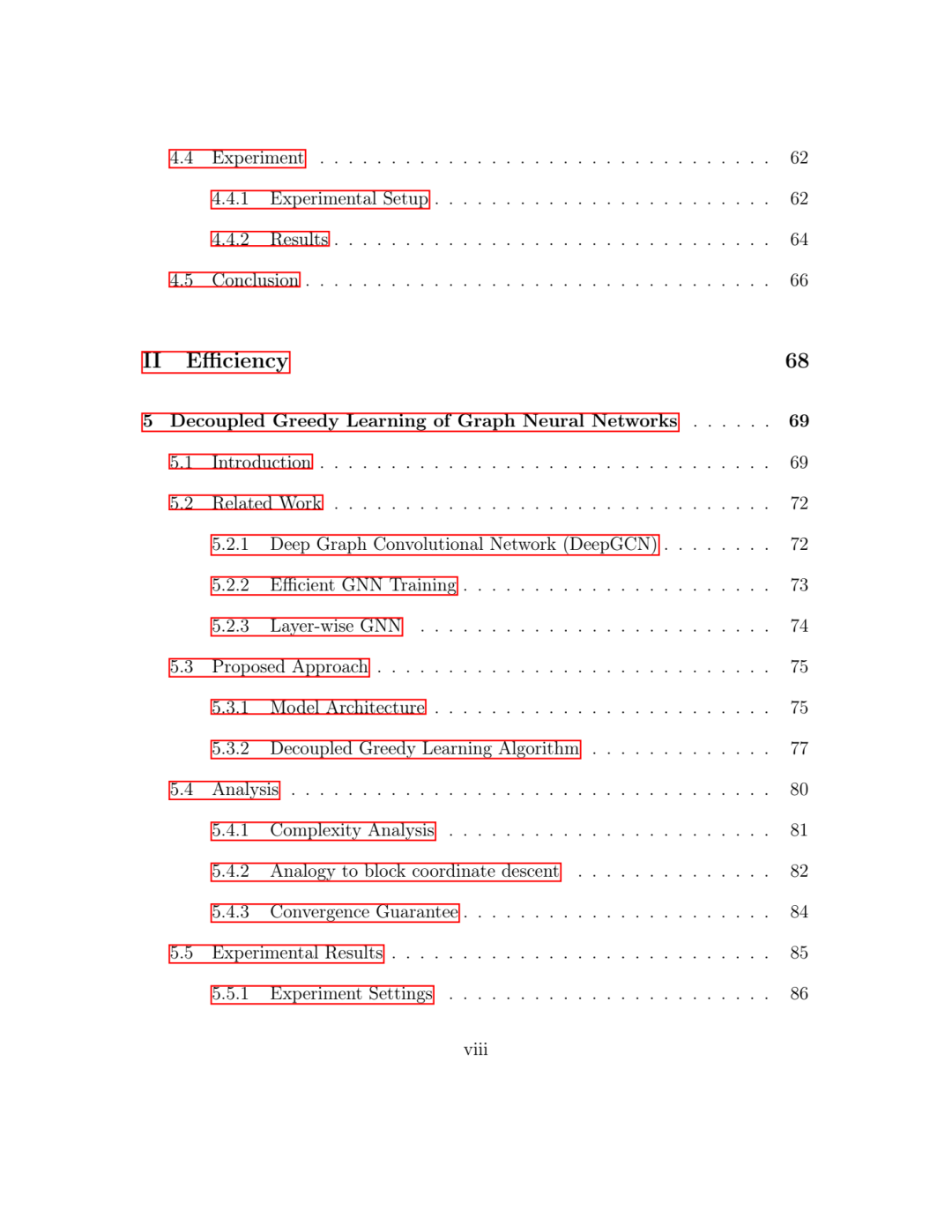

论文题目:Towards Effective And Efficient Graph Neural Networks

作者:Yewen Wang

类型:2024年博士论文

学校:University of California, Los Angeles(美国加州大学洛杉矶分校))

下载链接:

链接:https://pan.baidu.com/s/1GBmocIs2ynktwes8hYUAug?pwd=230b

硕博论文汇总:

链接: https://pan.baidu.com/s/1Gv3R58pgUfHPu4PYFhCSJw?pwd=svp5

图神经网络 (GNN) 是一类用于学习普遍存在的图数据的高质量表示的著名模型,由于其在各种图相关任务中的最新 (SOTA) 性能而受到越来越多的关注 [14, 109, 139, 10]。然而,实现有效且高效的 GNN 模型面临着重大挑战。在有效性方面,诸如过度平滑[64]之类的问题(当网络变得更深时,节点特征变得不可区分)阻碍了深度 GNN 架构的有效性,而异质性 1 [143](通过边连接的节点不一定具有相似性)背叛了大多数 GNN 模型中潜在的同质性假设)构成了相当大的障碍。在效率方面,诸如更新锁定 [49] 之类的挑战阻碍了并行计算,而图卷积运算 [144] 固有的高成本特性使大规模深度 GNN 应用变得困难。

人们投入了大量研究来使 GNN 模型更强大 [53, 141, 100] 和更高效 [132, 68]。在有效方面,开发了各种著名的 GNN 架构,例如 GCN [55]、GAT [95]、deepGCN [64, 61]、SIGN [31]、GIANT [22],以增强 GNN 的表示学习能力,而另一分支工作,例如 RGCN [82]、NARS [123]、MAGNN [129]、CLGNN [105],旨在定制用于异构图学习的架构。还有许多工作关注识别和解决 GNN 的挑战性案例,例如 H2GCN [143]、EGP [24] GFNN [73]。在效率方面,人们开发了更有效地训练 GNN 的算法,例如 GraphSAGE [38]、GraphSAINT [128]、GOREN [12] 和 GCond [52]。人们还从推理 [131, 91]、系统 [97, 136]、硬件 [126, 35] 的角度进行了努力,以提高 GNN 的效率。尽管进行了广泛的研究工作以提高 GNN 的有效性和效率,但现有的解决方案还不够,在该领域还有很大的探索空间。

为此,我的目标是开发强大的 GNN 模型,即使在苛刻的情况下也能实现高质量的图形表示,并使 GNN 能够在时间和内存受限的情况下高效地训练以用于大规模应用。我的研究主要围绕以下研究问题展开:

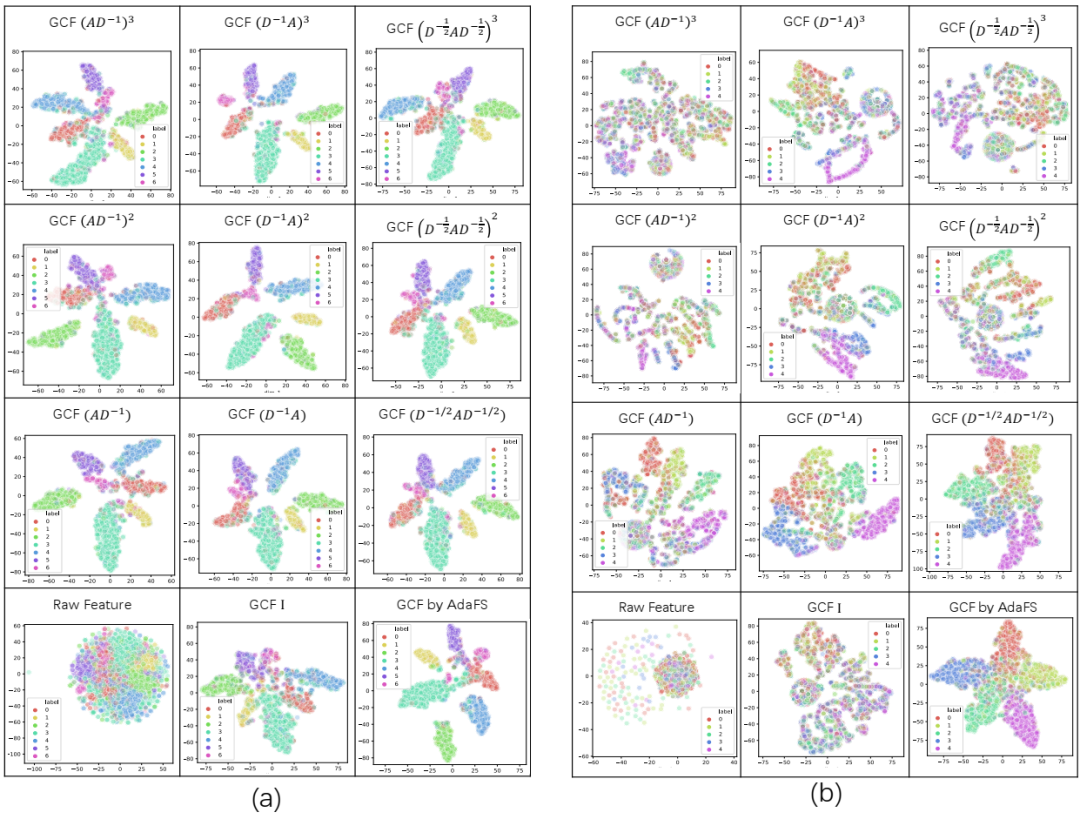

1. 关于有效性,鉴于图卷积运算对于增强 GNN 的能力至关重要,并且考虑到可用的图卷积运算符的多样性,我们应该了解:每个运算符有哪些特定的适用性和限制场景?此外,我们如何在各种图形表示任务中自适应地使用这些运算符来优化它们的效用和性能,特别是在面对上述异嗜性挑战和过度平滑挑战时?

2. 关于效率,由于图卷积运算在对大规模图进行批量训练时带来了指数邻域增长问题,我们应该思考:我们如何减轻这种指数邻域扩展以减轻计算负担?更进一步,我们能否解决更新解锁这一固有挑战,它阻碍了神经网络的效率提高?

3. 有效性和效率之间通常存在权衡,很多工作可能会在关注另一方面时牺牲另一方面(尤其是当重点放在有效性方面时)。因此,我们思考,我们能否开发 GNN 模型来确保一个方面的改进不会破坏另一个方面?

4. 当将重点转移到异构图时,我们如何管理其内在的异构性并为它们定制有效且高效的消息传递策略?

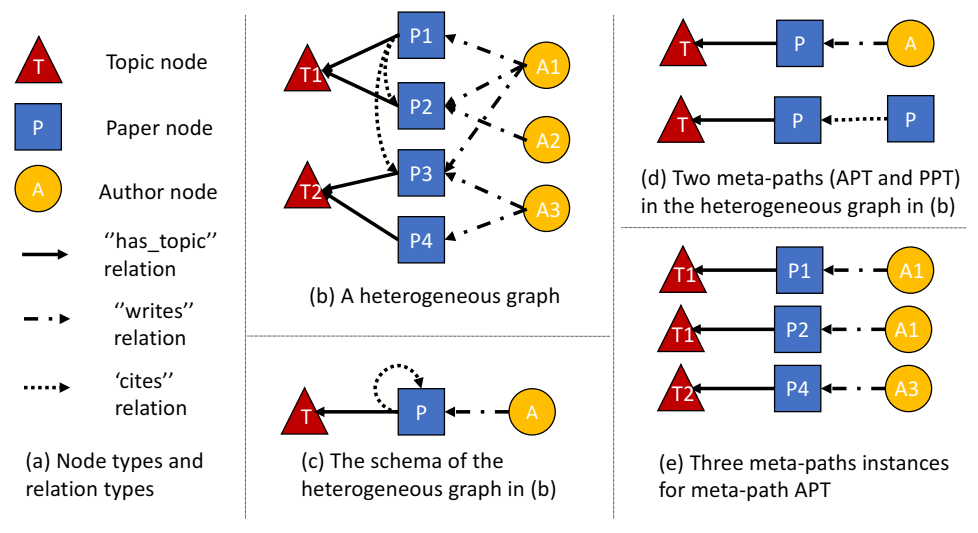

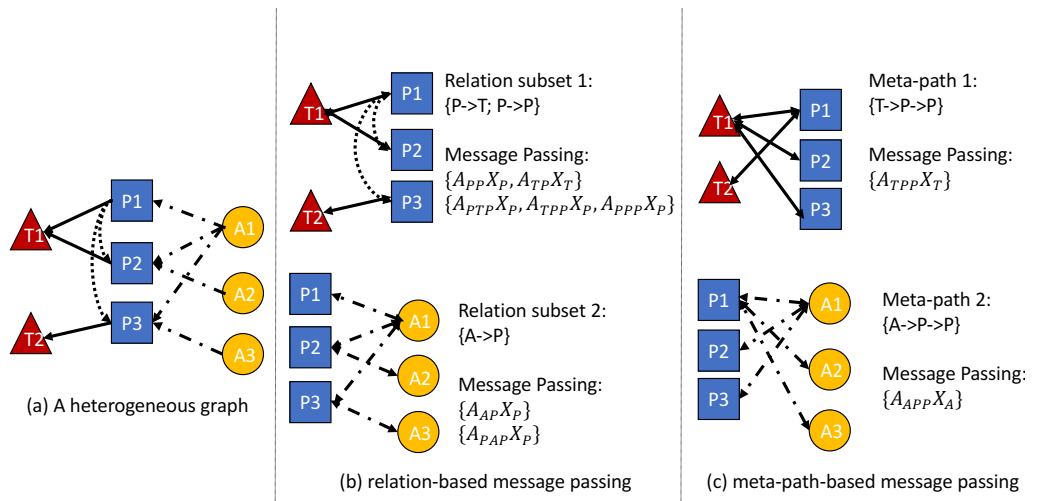

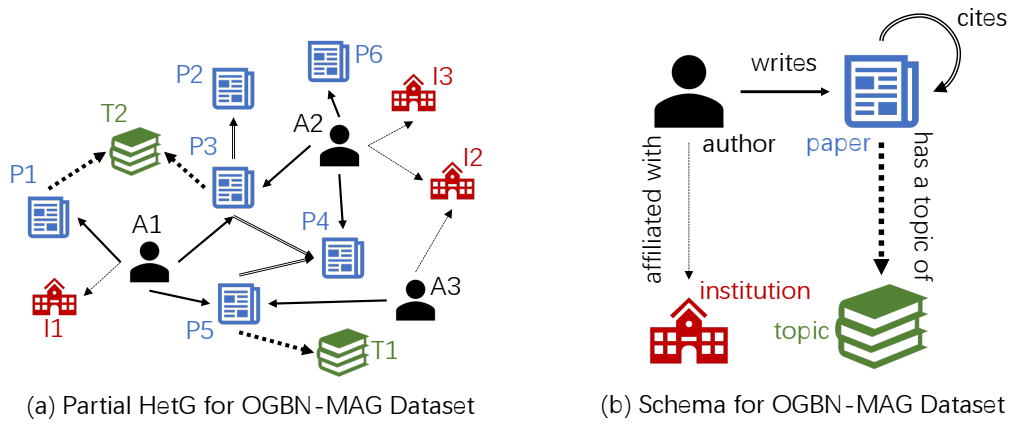

学术异构图和相关概念的示例。示例解释图 2.1 中异构图的定义和关键概念,以帮助理解。

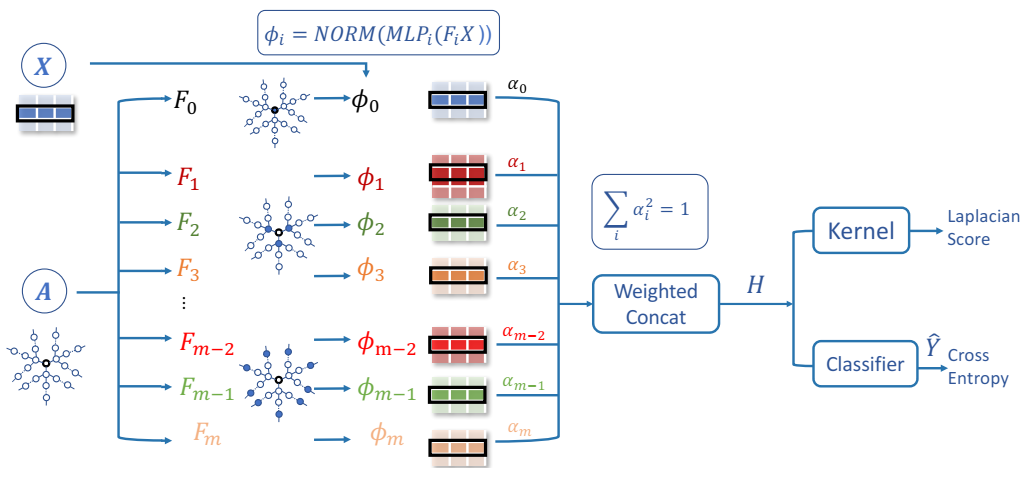

AdaFS 框架概述。

AdaFS 框架概述。

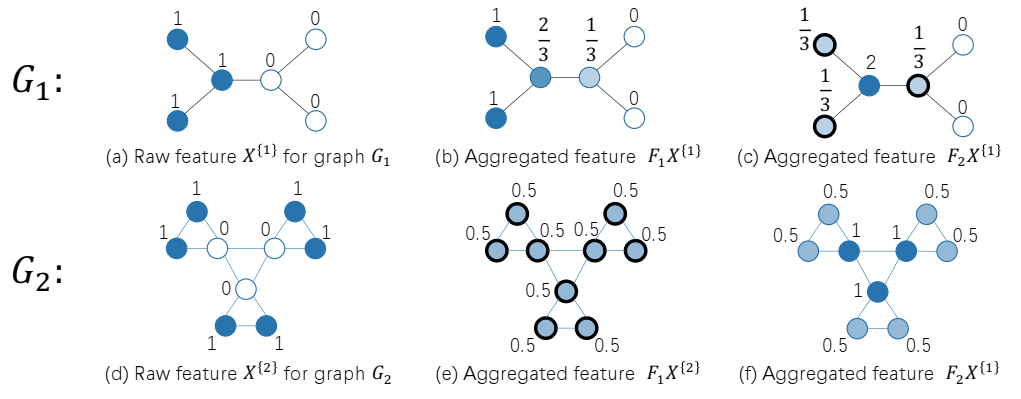

玩具示例来说明不同的图表偏好不同的 GCF。

玩具示例来说明不同的图表偏好不同的 GCF。

基于关系的消息传递和基于元路径的消息传递之间的差异的说明示例。

基于关系的消息传递和基于元路径的消息传递之间的差异的说明示例。

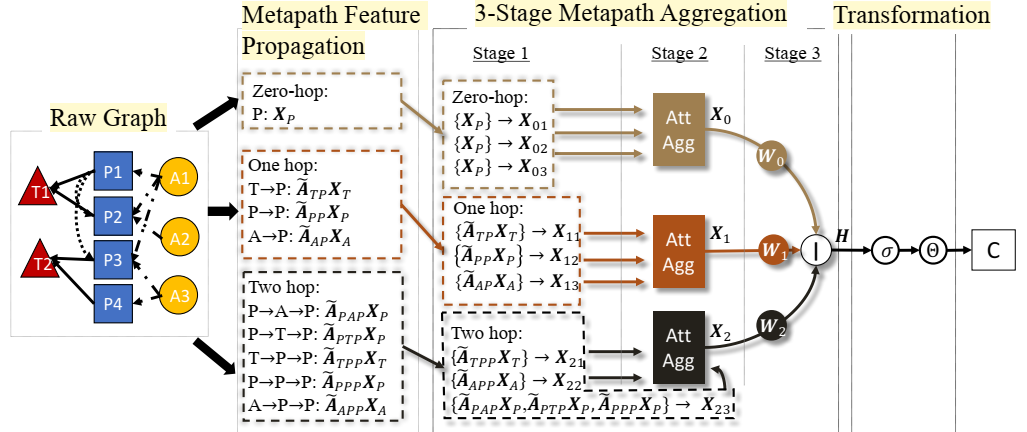

SMASH 概述。

SMASH 概述。

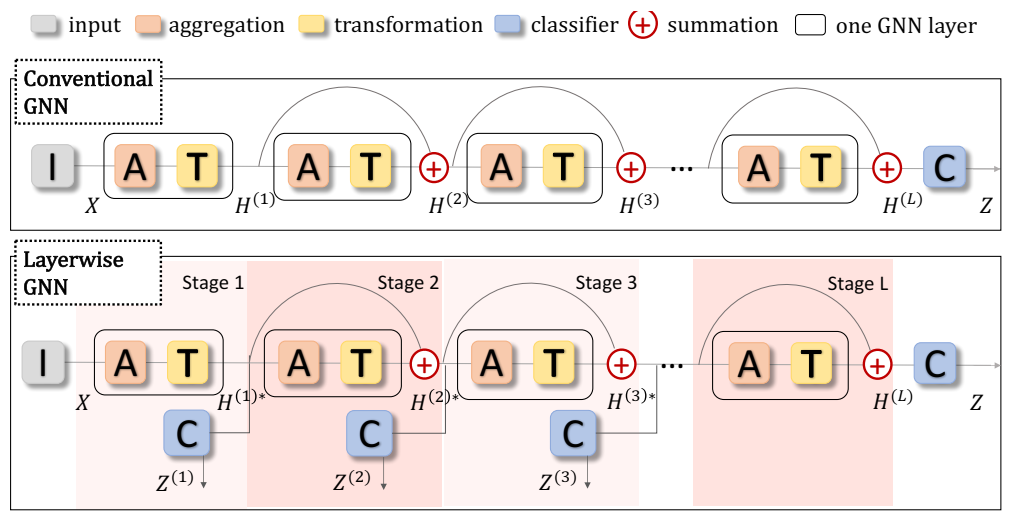

传统 DeepGCN(上)和 Layerwise DeepGCN(下)的高级框架。

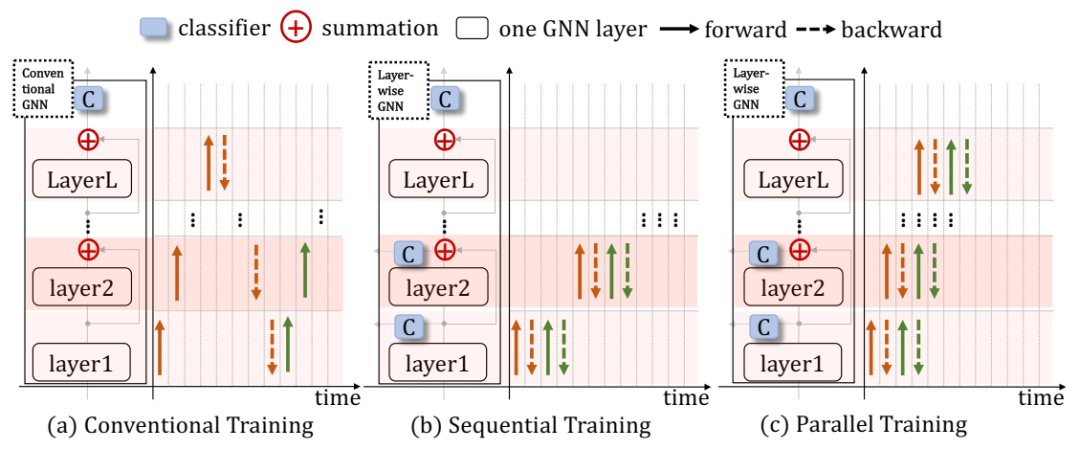

常规训练的 GNN、顺序训练的分层 GNN 和并行训练的 GNN 的信号传播过程。

常规训练的 GNN、顺序训练的分层 GNN 和并行训练的 GNN 的信号传播过程。

部分 OGBN-MAG 的说明示例。

部分 OGBN-MAG 的说明示例。

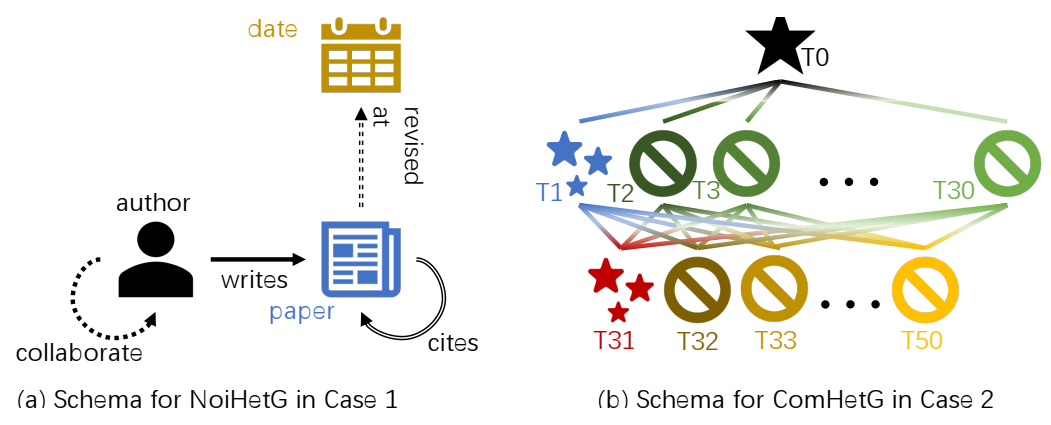

挑战案例中的合成 HetG 的架构。

挑战案例中的合成 HetG 的架构。

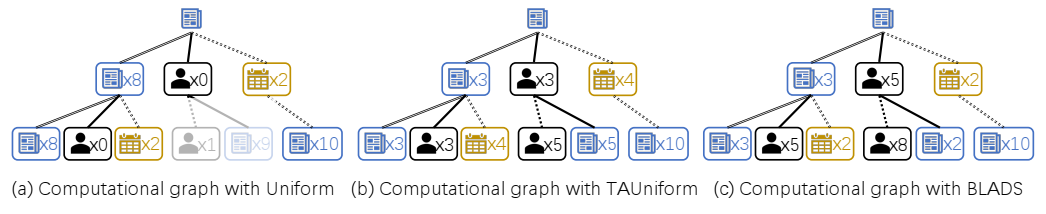

使用NoiHetG上不同的采样器生成的计算图。

使用NoiHetG上不同的采样器生成的计算图。

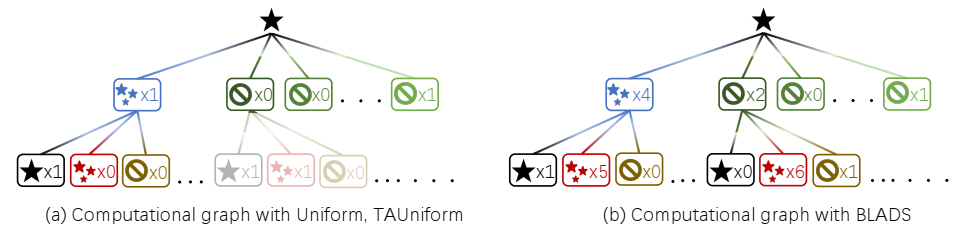

使用 ComHetG 上的不同采样器生成的计算图。

使用 ComHetG 上的不同采样器生成的计算图。

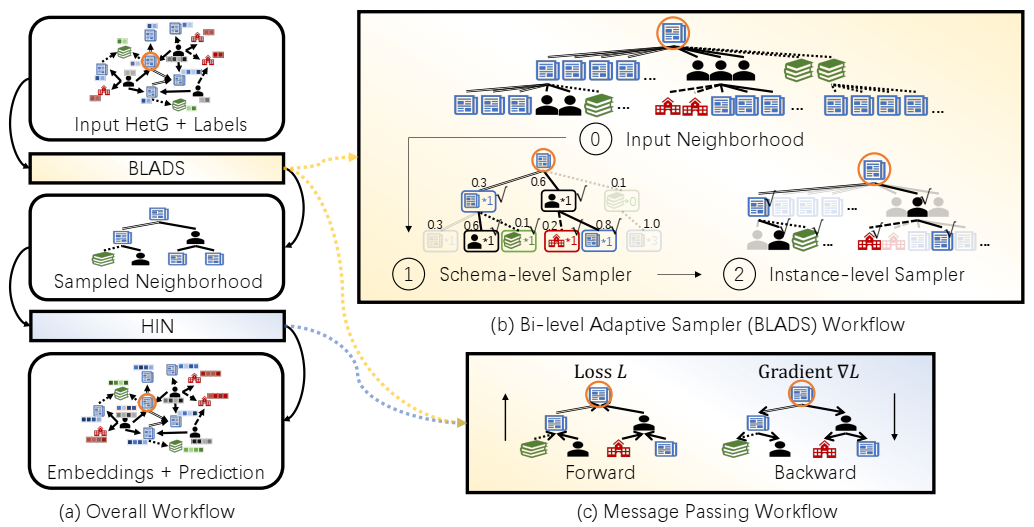

将 BLADS 与异构 GNN 结合使用的示意图。模式取自图 6.1 中的 OGBN-MAG。

将 BLADS 与异构 GNN 结合使用的示意图。模式取自图 6.1 中的 OGBN-MAG。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢