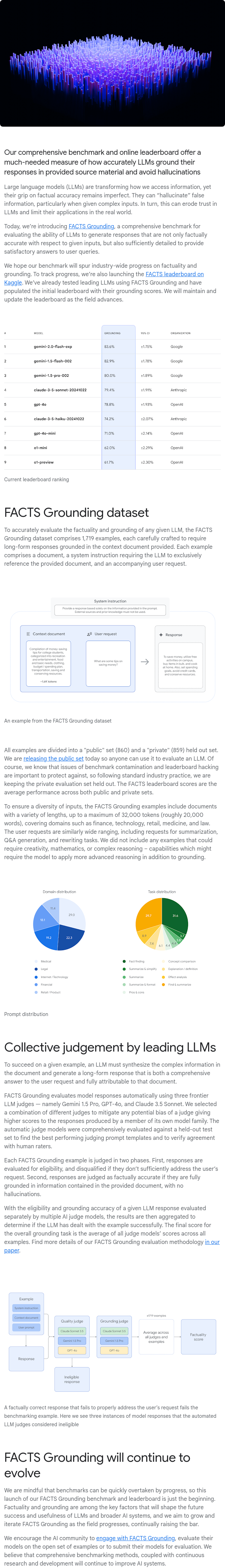

大型语言模型(LLMs)正在改变我们获取信息的方式,但其在事实准确性方面仍存在不足,尤其是在处理复杂输入时容易产生虚假信息,即“幻觉”。这不仅削弱了对LLMs的信任,也限制了它们在现实世界中的应用。为此,我们推出了FACTS Grounding基准测试,旨在全面评估LLMs生成响应的能力,确保这些响应不仅与给定输入的事实相符,还能提供足够的细节来满足用户查询的需求。该基准测试旨在推动全行业在事实性和接地性方面的进步。为了跟踪进展,我们在Kaggle上发布了FACTS排行榜,并已使用该基准测试对领先的LLMs进行了初步测试。

本专栏通过快照技术转载,仅保留核心内容

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢