导语

分享内容简介

分享内容简介

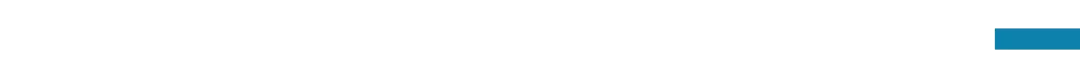

本次分享将深入地对 o1 的技术原理和可能实现机制进行剖析。首先会阐述o1的重大价值及意义,包括从预训练到Post-Training及Inference阶段的Scaling Law的迁移及对小模型研发的影响等方面;其次会逐步推导o1的可能训练过程及模型构成;另外,会重点探讨如何结合LLM以及AlphaZero的强化学习来构造类o1的系统,以此让大模型具备复杂逻辑思考能力。最后展开圆桌讨论。

分享内容大纲

分享内容大纲

大模型2.0:OpenAI o1技术原理探析(张俊林,45min)

o1模型的价值和意义

inference time Scaling Law 对小模型的意义 新型的安全模式

o1的可能训练过程推导

o1的可能训练过程 o1可能的模型结构

如何结合LLM和强化学习构造o1

强化学习基础介绍 LLM与RL融合构造类o1系统

圆桌论坛(张俊林、张江、岳玉涛、王维埙,30min)

llya在NIPS2024中提出“预训练即将结束,接下来是超级智能”,如何看待这个观点? Post-Training和Inference Time Scaling Law是否具有发展的可持续性? COT是否引导大模型进行“慢思考”的最佳方式?是否有其它更好的方法? LLM真的能做Reasoning吗?LLM的reasoning会不会和人不一样? 强行约束llm按照人的方式进行reasoning,可解释提升,但会不会约束性能? .......

主讲人介绍

主讲人介绍

研究兴趣为大模型及推荐系统

圆桌嘉宾

圆桌嘉宾

主持人介绍

主持人介绍

主要涉及到的参考文献

主要涉及到的参考文献

1.o1官网信息:https://openai.com/o1/

2.openai o1 system card:https://cdn.openai.com/o1-system-card-20241205.pdf

3.Alphazero paper:Mastering Chess and Shogi by Self-Play with a General Reinforcement Learning Algorithm

直播信息

直播信息

时间:

2024年12月21日(本周六)晚上19:00-21:00

参与方式:

大模型2.0读书会启动

o1模型代表大语言模型融合学习与推理的新范式。集智俱乐部联合北京师范大学系统科学学院教授张江、Google DeepMind研究科学家冯熙栋、阿里巴巴强化学习研究员王维埙和中科院信工所张杰共同发起「大模型II:融合学习与推理的大模型新范式 」读书会,本次读书会将关注大模型推理范式的演进、基于搜索与蒙特卡洛树的推理优化、基于强化学习的大模型优化、思维链方法与内化机制、自我改进与推理验证。希望通过读书会探索o1具体实现的技术路径,帮助我们更好的理解机器推理和人工智能的本质。

从2024年12月7日开始,预计每周六进行一次,持续时间预计 6-8 周左右。欢迎感兴趣的朋友报名参加,激发更多的思维火花!

详情请见:大模型2.0读书会:融合学习与推理的大模型新范式!

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢