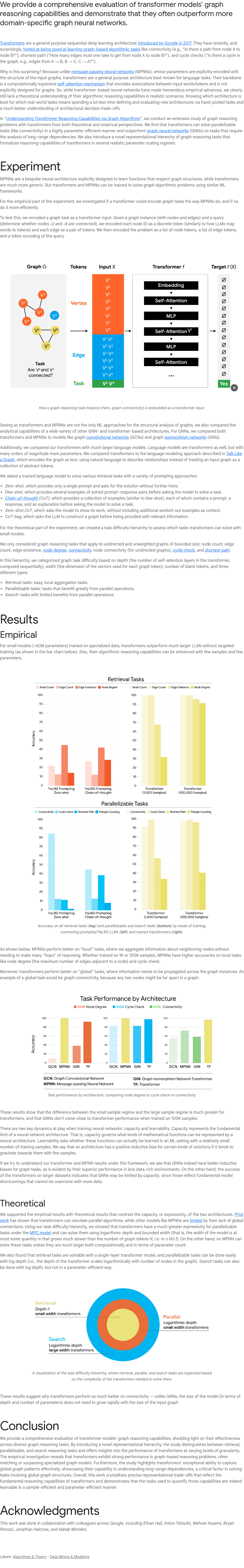

本文全面评估了Transformer模型在图推理任务上的表现,发现其经常超越领域特定的图神经网络(GNN)。Transformer最初由谷歌于2017年提出,主要用于序列化的深度学习任务,尤其擅长自然语言处理。然而,最近的研究表明,Transformer在图算法任务中也表现出色,例如连通性、最短路径和环检测等任务。这一发现令人惊讶,因为与消息传递神经网络(MPNNs)不同,Transformer并未针对图结构进行优化,其核心机制是自注意力机制,主要用于捕捉输入序列中的关联,而非显式编码图结构。尽管如此,Transformer仍能在多种图任务上取得优异成绩,显示出其作为通用架构的强大适应性。

本专栏通过快照技术转载,仅保留核心内容

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢