导语

分享内容简介

分享内容简介

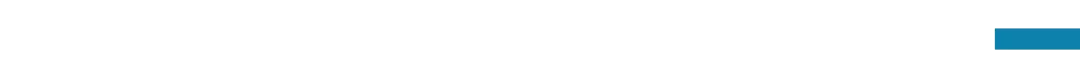

本次分享将围绕大语言模型(LLMs)的自我改进与推理验证展开,首先从微软最新发布的Phi-4预训练模型出发,了解高质量标注数据短缺的情况下使用大语言模型辅助生成和改进训练数据的细节,其次深入关注模型在推理时的自我验证技术,这包括根据模型内部状态解码,使用模型输出一致性检查以及使用外部验证工具验证的方式提高模型推理能力并缓解幻觉。然后我们将简要讨论如何将强化学习方法引入到推理过程中以应对复杂问题。最后就一些前沿开放问题一起探讨。

分享内容大纲

分享内容大纲

训练时:LLM生成数据 微软Phi-4 自生成数据 自改进数据 推理时:LLM自我验证 内部状态解码缓解幻觉 模型输出一致性检查 外部数据RAG验证 内部验证与外部验证对比 强化学习优化难题推理 强化学习基础概念 蒙特卡洛树搜索和过程奖励模型 ReST-MCTS∗方法简介 前沿研究进展和讨论 自我改进消除推理错误的能力上界在哪? 数据不足时,如何保证推理的可靠性? 自我改进是否会带来新的安全风险?

主讲人介绍

主讲人介绍

吴杰民,香港科技大学(广州)博士生,曾任加州大学戴维斯分校研发工程师。

研究兴趣为概率图模型,神经信号处理,强化学习与控制系统,大语言模型推理优化。

主要涉及到的参考文献

主要涉及到的参考文献

Tao Z, Lin T E, Chen X, et al. A survey on self-evolution of large language models[J]. arXiv preprint arXiv:2404.14387, 2024.

Zelikman E, Wu Y, Mu J, et al. Star: Bootstrapping reasoning with reasoning[J]. Advances in Neural Information Processing Systems, 2022, 35: 15476-15488.

Madaan A, Tandon N, Gupta P, et al. Self-refine: Iterative refinement with self-feedback[J]. Advances in Neural Information Processing Systems, 2024, 36.

Lightman H, Kosaraju V, Burda Y, et al. Let's verify step by step[J]. arXiv preprint arXiv:2305.20050, 2023.

Zheng R, Dou S, Gao S, et al. Secrets of rlhf in large language models part i: Ppo[J]. arXiv preprint arXiv:2307.04964, 2023.

Wang B, Zheng R, Chen L, et al. Secrets of rlhf in large language models part ii: Reward modeling[J]. arXiv preprint arXiv:2401.06080, 2024.

Yuan W, Pang R Y, Cho K, et al. Self-rewarding language models[J]. arXiv preprint arXiv:2401.10020, 2024.

Lu J, Zhong W, Huang W, et al. Self: Language-driven self-evolution for large language model[J]. arXiv preprint arXiv:2310.00533, 2023.

Zhao Z, Lee W S, Hsu D. Large language models as commonsense knowledge for large-scale task planning[J]. Advances in Neural Information Processing Systems, 2024, 36.

Stechly K, Valmeekam K, Kambhampati S. On the self-verification limitations of large language models on reasoning and planning tasks[J]. arXiv preprint arXiv:2402.08115, 2024.

Tian Y, Peng B, Song L, et al. Toward Self-Improvement of LLMs via Imagination, Searching, and Criticizing[J]. arXiv preprint arXiv:2404.12253, 2024.

Zhang D, Huang X, Zhou D, et al. Accessing gpt-4 level mathematical olympiad solutions via monte carlo tree self-refine with llama-3 8b[J]. arXiv preprint arXiv:2406.07394, 2024.

Zhang D, Zhoubian S, Hu Z, et al. Rest-mcts*: Llm self-training via process reward guided tree search[J]. arXiv preprint arXiv:2406.03816, 2024.

Snell C, Lee J, Xu K, et al. Scaling llm test-time compute optimally can be more effective than scaling model parameters[J]. arXiv preprint arXiv:2408.03314, 2024.

Qi Z, Ma M, Xu J, et al. Mutual reasoning makes smaller llms stronger problem-solvers[J]. arXiv preprint arXiv:2408.06195, 2024.

Kumar A, Zhuang V, Agarwal R, et al. Training language models to self-correct via reinforcement learning[J]. arXiv preprint arXiv:2409.12917, 2024.

Setlur A, Nagpal C, Fisch A, et al. Rewarding progress: Scaling automated process verifiers for llm reasoning[J]. arXiv preprint arXiv:2410.08146, 2024.

Zhang D, Wu J, Lei J, et al. Llama-berry: Pairwise optimization for o1-like olympiad-level mathematical reasoning[J]. arXiv preprint arXiv:2410.02884, 2024.

LLM Reasonable 知乎专栏 https://zhuanlan.zhihu.com/column/c_1852087980463886337

分享信息

分享信息

分享时间:

2024年12月28日(本周六)晚上19:00-21:00

参与方式:

扫码报名

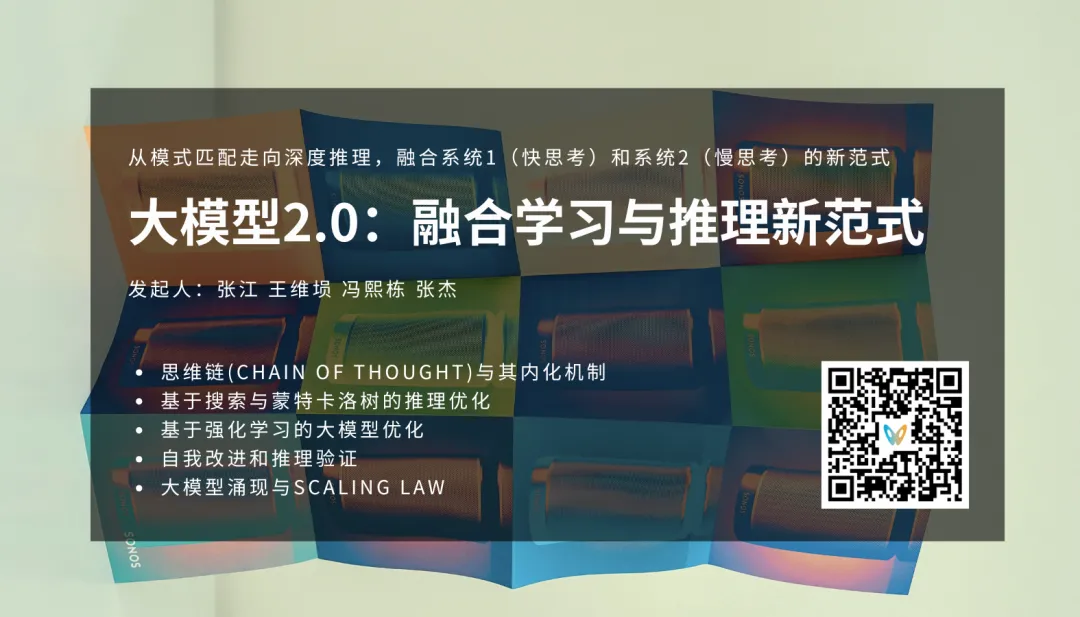

大模型2.0读书会启动

o1模型代表大语言模型融合学习与推理的新范式。集智俱乐部联合北京师范大学系统科学学院教授张江、Google DeepMind研究科学家冯熙栋、阿里巴巴强化学习研究员王维埙和中科院信工所张杰共同发起「大模型II:融合学习与推理的大模型新范式 」读书会,本次读书会将关注大模型推理范式的演进、基于搜索与蒙特卡洛树的推理优化、基于强化学习的大模型优化、思维链方法与内化机制、自我改进与推理验证。希望通过读书会探索o1具体实现的技术路径,帮助我们更好的理解机器推理和人工智能的本质。

从2024年12月7日开始,预计每周六进行一次,持续时间预计 6-8 周左右。欢迎感兴趣的朋友报名参加,激发更多的思维火花!

详情请见:大模型2.0读书会:融合学习与推理的大模型新范式!

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢